作者:任新勃

理论到实际应用是需要过程的。

比如5G从理论论文到应用有十年之长。任正非多次谈到,华为5G技术来自十多年前的土耳其教授的一篇论文。2008年,土耳其Erdal Arikan教授提出极化码(Polar code)理论之后,一个月后,华为从期刊上了解并评估了阿勒坎的论文,意识到这篇论文的重要性,之后十年,基于该理论,华为5G编码技术实现突破并开始全球应用。

同样目前火热的AI大模型也不是横空出世,在ChatGPT 火热之后,我们看到的ChatGPT 是2018基于OpenAI实验室研发的GPT模型(Generative Pre-trained Transformer)开发的。但其原理也是Google公司在2017年开源的Transformer神经网络架构而来的。

ChatGPT的火热,也让国内AI企业积极推出自己的AI大模型,有代表性的是百度、阿里各自推出自己的对话大模型,一个是一言,一个是千问,还有一个受到大家关注的是华为盘古大模型。

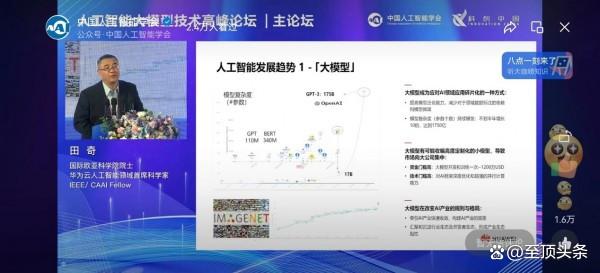

前两天,我们看到在中国人工智能学会主办的人工智能大模型技术高峰论坛上,华为云AI领域首席科学家、国际欧亚科学院院士田奇出席现场,对华为盘古系列大模型的研发与应用落地情况进行了分享。

我们从田奇的分享可以看到,华为盘古大模型的当下的服务方式还是更实际一些,AI好不好用,包括算力、算法和数据三部分。这三个部分面临的挑战,田琦奇给点了出来,那就是AI大模型有两个高门槛:

一个是资金门槛高,开发和训练一次花费约1200万美元,一个是技术门槛高,需要对AI框架深度优化和超强的并行计算能力。

那么这两个门槛就让绝大部分的企业和用户挡在在AI大模型研发之外,华为的思路是就是解决传统AI开发面临作坊式开发、样本标注代价大、模型维护困难、模型泛化不足、行业人短缺等难题。这也是盘古大模型的价值和意义。

比如华为开放了盘古大模型开发的全流程大模型使能套件,包括TransFormers大模型套件MindSpore TransFormers、以文生图大模型套件MindSpore Diffusion、人类反馈强化学习套件MindSpore RLHF、大模型低参微调套件MindSpore PET,支撑大模型从预训练、微调、压缩、推理及服务化部署。

当然在“大模型时代”,到底如何实现价值,我们看到华为盘古大模型的思路是首先在强化大模型能力,实现在各垂直领域落地,通过参数微调,适配多个场景。所以华为盘古大模型所提供的服务更广,不仅提供像chatGPT一样的NLP大模型底座,还可以提供CV大模型、科学计算大模型等基础大模型。

同时华为盘古大模型还有一个特点是更灵活,据田奇介绍,在CV大模型和科学计算大模型的多个应用场景。矿山大模型、铁路巡检方案等,面向科学领域的盘古气象大模型、药物分子大模型、海浪预测大模型等。

当然个人建议,包括chatGPT在内的预训练大数据模型的原理是通过预测说话过程中的每个词和每个词的结合概率来生成语句。比如“我喜欢喝啤”,那下一个字的概率是什么,相信大家都知道。当然实际上现在模型已经实现了更复杂的的语音预测。包括词和词的概率,每一个句子的意思和下一个句子的意思,段落和段落的逻辑等。这么看来,有一些场景,预训练模型并不合适,包括气象、股市、经济等混沌事件就不适合预训练模型,因为这些场景,数据越多,越不确定,预测难度就越大。形成了一个死循环。

总之,当前大模型效果如何,还是让子弹飞一会,时间会检验的。同时我期待各个大模型企业可以形成直接的技术壁垒,技术护城河,但是不用形成技术傲慢,也就是你提供的AI产品应该是越来越简单,而不是越来越复杂,让人们望而生畏,那就不是AI护城河了,那就是AI霸权了。

举报/反馈

原文链接:https://baijiahao.baidu.com/s?id=1762779976712954964&wfr=spider&for=pc

评论 ( 0 )