人工智能简介

【人工智能业务概述】—人工智能的基础概念_人工智能_麦道先生-CSDN学习社区

1. 人工智能的定义

人工智能(Artificial Intelligence,简称AI)是计算机科学的一个分支,旨在研究和模拟人类的智能行为,使机器能够执行传统上需要人类智能才能完成的任务。人工智能的目标是让机器具备感知、理解、推理、决策、学习和自我优化的能力。具体来说,人工智能试图让机器能够完成以下任务:

- 感知:从环境中获取数据(例如通过摄像头、麦克风等传感器)。

- 理解:对感知的数据进行分析、解读、推理,产生理解。

- 决策:根据理解和目标进行合理的决策。

- 学习:通过经验改进自己的行为和策略。

- 互动:与人类或其他机器进行有效的沟通和合作。

人工智能包括多个子领域,涵盖了机器学习、深度学习、自然语言处理、计算机视觉等技术。

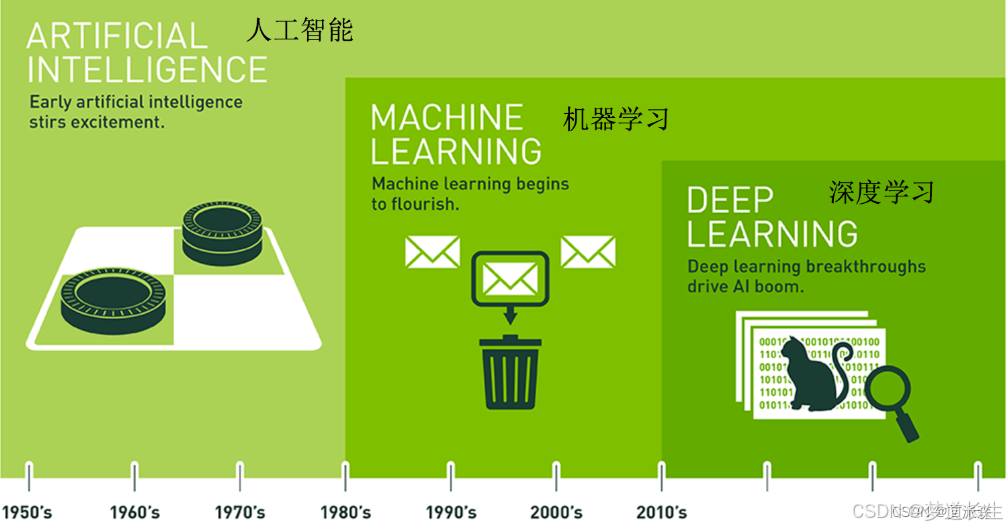

2. 人工智能的历史背景

人工智能的发展可以追溯到20世纪中期。虽然早期的AI研究已经为今天的技术奠定了基础,但人工智能的实际应用开始快速增长是在最近几十年。以下是人工智能发展中的一些关键节点:

-

1956年:人工智能的诞生

在达特茅斯会议(Dartmouth Conference)上,约翰·麦卡锡等人首次提出了“人工智能”这一术语,并确定了AI作为一个学科的基础。 -

1960s-1970s:早期的AI研究

这一时期主要集中在知识表示和推理系统上。专家系统、符号主义AI等成为研究热点,但由于硬件能力的限制,进展相对较慢。 -

1980s-1990s:机器学习的兴起

随着计算能力的提高,机器学习逐渐成为AI领域的主流。神经网络、支持向量机(SVM)等技术在此期间得到了广泛应用。 -

2000s-现在:深度学习与大数据

深度学习(Deep Learning)技术在2006年开始复兴,随着大数据和更强计算能力的结合,深度学习在图像识别、自然语言处理等领域取得了显著突破。2010年以来,人工智能进入了商业化应用的快速发展阶段。

3. 人工智能的分类

人工智能的研究领域非常广泛,通常按照不同的标准进行分类。以下是最常见的几种分类方式:

3.1 按照智能层次分类

-

弱人工智能(Narrow AI):专注于解决特定任务的人工智能,如语音识别、图像识别、推荐系统等。它通常只能在限定的环境下执行特定任务,并不具备通用推理能力。

-

强人工智能(General AI):也称为通用人工智能,是指能够执行任何人类智能任务的AI。强人工智能能够像人类一样理解、学习、推理,并具备常识推理能力,目前仍处于理论阶段。

3.2 按照应用领域分类

- 计算机视觉:让机器能够“看懂”图片和视频,并进行分析和理解。

- 自然语言处理(NLP):使计算机能够理解和生成自然语言,从而实现与人类的对话和交流。

- 语音识别与合成:让机器能够听懂人的语音并作出反应,如语音助手(Siri、Alexa等)。

- 机器人学:将AI应用于机器人控制和导航,使机器人能够自主执行任务。

- 专家系统:模仿专家的决策过程,提供专业的建议和指导。

- 机器学习与深度学习:机器学习是一种使计算机从数据中学习的技术,而深度学习是其子领域,依赖神经网络结构来从大量数据中提取特征。

3.3 按照工作方式分类

- 符号主义AI(Symbolic AI):基于规则和逻辑进行推理,强调使用明确的符号来表示世界及其关系。例如专家系统就是符号主义AI的一种应用。

- 连接主义AI(Connectionist AI):通过神经网络模拟人类大脑的神经元连接模式。深度学习技术属于连接主义AI。

- 行为主义AI(Behavioral AI):通过模仿人类行为来进行智能化的任务执行,通常不依赖于明确的推理规则,而是通过经验积累进行自我学习。

4. 人工智能的主要研究方向

人工智能包含多个研究领域,每个领域有不同的研究方法和应用。以下是当前人工智能领域的主要研究方向:

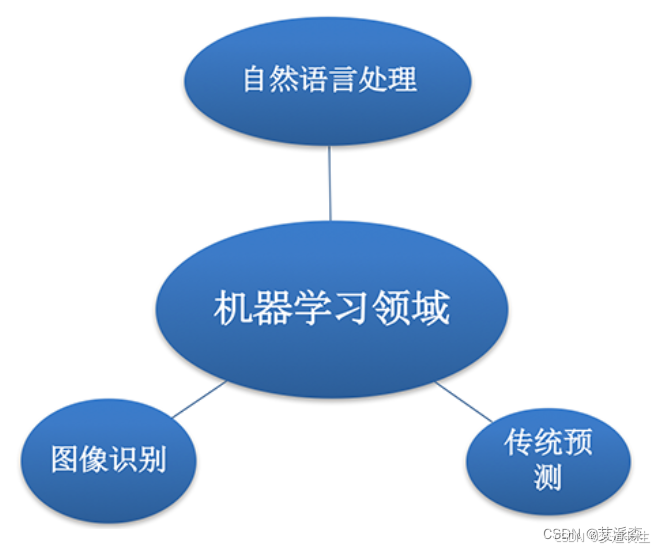

4.1 机器学习(Machine Learning)

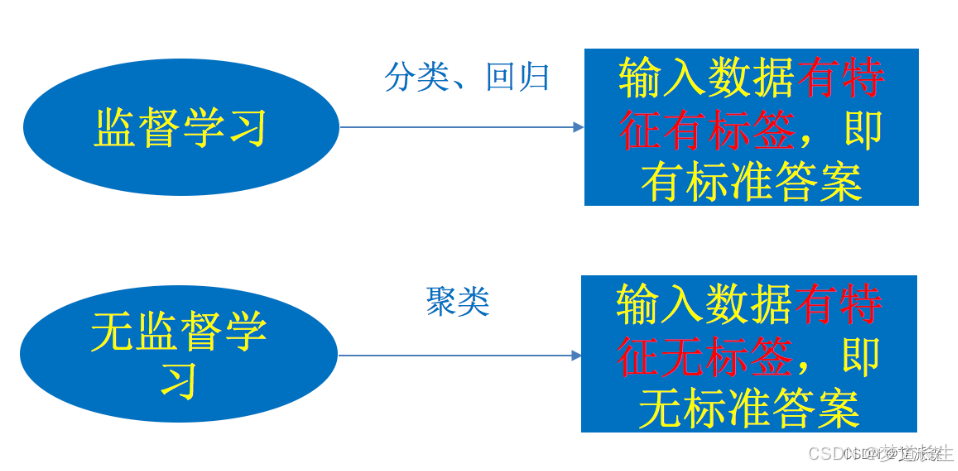

机器学习是人工智能的核心技术之一,它通过让计算机从数据中学习并改进自己的行为,而无需明确编程。机器学习主要分为以下几类:

- 监督学习(Supervised Learning):算法通过标注数据学习映射关系,常用于分类和回归问题。

- 无监督学习(Unsupervised Learning):算法从未标记的数据中寻找规律,常用于聚类和降维等任务。

- 强化学习(Reinforcement Learning):算法通过与环境的交互,学习如何最大化某个奖励函数,广泛应用于游戏和机器人控制。

4.2 深度学习(Deep Learning)

深度学习是机器学习的一种,主要利用多层神经网络进行特征学习。深度学习可以自动从数据中提取有用的特征,避免了人工特征设计的过程。深度学习在计算机视觉、语音识别、自然语言处理等领域取得了革命性进展。

4.3 自然语言处理(NLP)

自然语言处理是使计算机能够理解、生成和与人类进行语言交互的技术。它包括语言理解(如句法分析、情感分析)、语言生成(如自动摘要、对话生成)、语音识别等多个方向。

4.4 计算机视觉(Computer Vision)

计算机视觉使得计算机能够“理解”图像和视频,提取其中的有用信息。计算机视觉技术广泛应用于面部识别、自动驾驶、医疗影像分析等领域。

4.5 强化学习(Reinforcement Learning)

强化学习是让智能体通过与环境互动,学习到如何采取最优行动。它被广泛应用于游戏、机器人控制、自动驾驶等领域。著名的AlphaGo和AlphaZero就是基于强化学习的例子。

5. 人工智能的挑战与未来

尽管人工智能已经取得了显著的进展,但仍然面临许多挑战:

- 通用人工智能(AGI):目前的AI系统仍然处于弱人工智能阶段,无法具备真正的通用推理能力。实现强人工智能(AGI)是未来的一个重要研究方向。

- 数据隐私与安全:随着AI技术的广泛应用,如何保护用户数据隐私和确保AI系统的安全性成为一个重要问题。

- 伦理与社会影响:AI技术可能带来的伦理和社会问题也引发了广泛讨论,如何避免偏见、确保公平性和透明性成为亟待解决的课题。

尽管如此,随着计算能力的提升、数据量的增长以及算法的进步,人工智能的未来充满了无限可能。我们期待AI在各个领域发挥越来越重要的作用,创造更加智能化的未来。

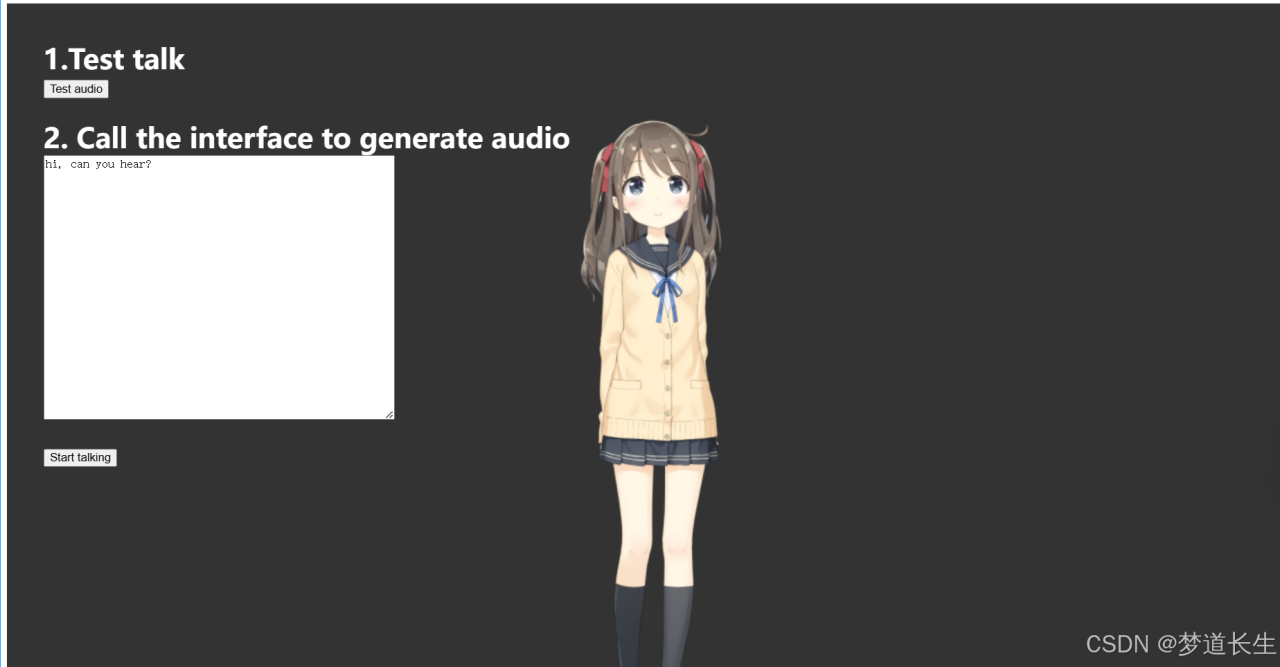

在之前的文章中,我分享了如何通过语音输入、语言生成(LLM)和语音输出构建一个简易的AI Agent。随着项目的进展,我将其扩展为一个完整的Web应用,增加了更多的功能和可用性,允许用户通过浏览器与AI进行交互。

今天,我将介绍这个改进后的系统,包括后端API、前端页面的实现,以及如何通过Flask和一些额外功能来提升整体交互体验。

1. 项目背景与目标

最初的项目是一个基础的语音交互AI,能够根据用户的语音输入生成文本,并通过语音播放返回的响应。随着需求的不断增加,我决定将这个AI Agent转换成一个具有前后端交互的Web应用,支持用户通过浏览器进行更直观的操作,同时确保AI可以处理更复杂的请求。

项目已经开源至Github:GitHub – toke648/AI-Interactive-LLM-VTuber

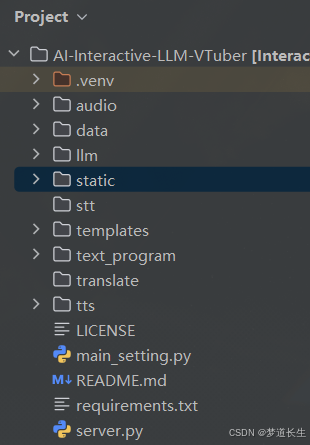

2. 项目架构

项目的架构如下所示:

- 后端(Flask API):使用Flask框架提供API接口,处理语音输入、文本生成和语音输出,并返回音频文件供前端播放。

- 前端:前端页面使用HTML、CSS和JavaScript编写,能够展示交互界面并与后端API进行通信。

- 模块化:整个系统进行了模块化处理,前后端通过RESTful API进行数据交互,后端处理核心的业务逻辑和AI调用,前端则提供用户友好的界面。

3. 后端实现

后端使用Flask框架,提供了多个API接口来处理用户的请求。以下是主要的后端代码:

3.1 server.py:Flask后端API

from flask import Flask, jsonify, request, redirect, url_for, send_from_directory from llm import generate_content from tts import generate_audio from main_setting import MainSetting from flask_cors import CORS import asyncio import os # 主要接口程序 settings = MainSetting() speech_generator = generate_audio.SpeechGenerator() content_generator = generate_content.ContentGenerate() app = Flask(__name__) CORS(app, resources={r"/*": {"origins": "*"}}) # 首页路由 @app.route('/') def index(): return redirect(url_for('static', filename='index.html')) # favicon 路由 @app.route('/favicon.ico') def favicon(): return send_from_directory(os.path.join(app.root_path, 'static'), 'favicon.ico', mimetype='image/x-icon') # 处理音频请求 @app.route('/dealAudio', methods=['POST']) def deal_audio(): text = request.json.get('text', '') if not text: return jsonify({'error': 'No text provided'}), 400 print("Thinking...") content = content_generator.generate_content(text) print(content) try: asyncio.run(speech_generator.generate_audio(content)) audio_url = f"http://127.0.0.1:5000/{settings.audio_directory}/{settings.audio_file}" return jsonify({'audio_file': audio_url}) except Exception as e: return jsonify({'error': str(e)}), 500 # 提供音频文件 @app.route('/audio/<path:filename>', methods=['GET']) def get_audio(filename): return send_from_directory('audio', filename) if __name__ == '__main__': app.run(host='0.0.0.0', port=5000) - 首页路由:重定向到前端的

index.html页面。 - 音频处理接口:通过

/dealAudio接口接收用户输入的文本,生成相应的内容并转换为音频。 - 音频文件路由:

/audio/<filename>接口用于提供生成的音频文件。

3.2 main_setting.py:配置文件

class MainSetting(): def __init__(self): self.audio_directory = "audio" self.audio_file = "output.mp3" self.default_voice = 'zh-CN-XiaoxiaoNeural' self.default_rate = "-5%" self.default_volume = "+50%" self.system_prompt = open('templates/ai_setting_失忆少女.txt', 'r').read() self.api_key = "your-api-key" self.base_url = "https://dashscope.aliyuncs.com/compatible-mode/v1" self.models = "qwen-plus" def get_audio_path(self): import os return os.path.join(self.audio_directory, self.audio_file) - 配置了音频生成和LLM调用所需的基本设置,如声音、音量、语速和API密钥。

4. 前端实现

前端部分负责与用户的交互,接收用户的文本输入,并通过按钮或语音输入触发后端接口。以下是前端的index.html文件:

4.1 index.html:基本交互页面

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8"> <meta name="viewport" content="width=device-width, initial-scale=1.0"> <title>AI Assistant</title> <link rel="stylesheet" href="css/styles.css"> </head> <body> <h1>AI Voice Assistant</h1> <input type="text" id="user_input" placeholder="Type something..."> <button id="send_btn">Send</button> <audio id="audio_player" controls></audio> <script src="js/script.js"></script> </body> </html> 4.2 script.js:前端交互逻辑

document.getElementById('send_btn').addEventListener('click', async function() { let text = document.getElementById('user_input').value; if (!text) return; try { const response = await fetch('http://127.0.0.1:5000/dealAudio', { method: 'POST', headers: { 'Content-Type': 'application/json' }, body: JSON.stringify({ text: text }) }); const data = await response.json(); if (data.audio_file) { const audioPlayer = document.getElementById('audio_player'); audioPlayer.src = data.audio_file; audioPlayer.play(); } } catch (error) { console.error('Error:', error); } }); - 用户输入文本后,前端通过AJAX请求将文本发送到后端,后端返回生成的音频文件链接,并自动播放音频。

5. 未来计划

- 优化语音输入:目前仅支持文本输入,未来可以添加语音输入功能,使得用户能够通过语音直接与AI进行交互。

- 增强情感分析:可以引入情感分析模块,根据用户的情绪调整语音和回答的内容。

- 个性化设置:根据用户的历史对话和偏好,生成个性化的语音和响应内容。

6. 总结

这个项目从一个简易的AI Agent发展为一个功能完善的Web应用,支持文本和语音输入,并能通过Flask API与前端进行交互。通过这种方式,我不仅学到了如何实现基本的AI模型,还掌握了如何将后端AI与前端交互结合起来,打造一个完整的应用。

原文链接:https://blog.csdn.net/qq_63036514/article/details/144458397?ops_request_misc=%257B%2522request%255Fid%2522%253A%25220251ff955bfe2b3ce8e23e5ac1af9288%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=0251ff955bfe2b3ce8e23e5ac1af9288&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-14-144458397-null-null.nonecase&utm_term=AI+AIAgent

评论 ( 0 )