Agent的概念

Agent在很早就有了,AI诞生的时候就出现了,Marvin Minsky在1986年出版的的一本书《The Society of Mind》提出了Agent的概念,书中Agent的定义就是一些Mindlessly process,只是能用来做一些简单的事情,将这样一些没有思想的Agent组合成一个society就会导致真正的智能,而这本书主要想要探讨的就是人类的智能是怎么来的,然后作者把人类智能拆分成很多Agent,每个Agent可能去完成不同的事情,比如说有的Agent的话可以去给你拿一个苹果,有的Agent去可以开门,然后但是你把这些Agent全部加起来成为一个society,那么它就导致了真正的智能。所以作者是从想要去理解智能的方向去定义的Agent。这里面有一句话很有意思的是,到底是什么神奇的东西让我们有了智能,其实没有什么非常特别的东西,导致智能是因为有diversity也就是多样性,为什么这个很重要?是因为我们首先我们现在在做的大模型,它很多时候我们是用单个模型,但是要是真正要到未来,我们要达到真正的智能,依靠单个模型能力是不可能的,我们得有很多不同的模型,它就得每个模型可能是不一样的领域的专家,然后他们组成一个society,然后才能导致真正智能。

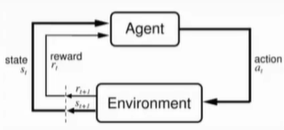

所以我非常认同作者在这本书里面提出了这个观点,然后当然Agent在近几年,那么训练里面也是被经常提到的一个概念,这里面可能大众知道比较多的是Reinforcement Learning里面的Agent,这里的Agent可能离我们现在所定义的Agent会更近一点,首先Agent它是一个可以学习的一个软件,然后它是可以做它是可以做decision making的,即决策,这里跟其他的AI模型不一样的地方是哪里?比如说你有一个图像分类的模型,它是只能做预测的,你预测你这个图像是一个猫是一个狗,但他没有做决策这一步,但Agent很重要的一点,它是能做decision making,它能跟外部世界交互,根据外部世界给他的一些反馈,可能去执行某一种action,然后去完成他的目标。然后这里在强化学习里面定义的Agent,首先是有Agent这个概念,然后他会执行一定的动作,然后动作会跟环境产生作用,然后环境会返回一个新的状态reward给到Agent,然后Agent通过跟环境不停的交互,根据所给的反馈,也就是奖励来更新自己的策略,然后最后达到更好的完成目标。

所以你可以看到Agent在这里定义它是能执行action,然后它能跟环境交互,所以这里很重要就是action,环境和reward的,跟一般的大语言模型不一样的点有两个,一点是有action,另一个是Environment。

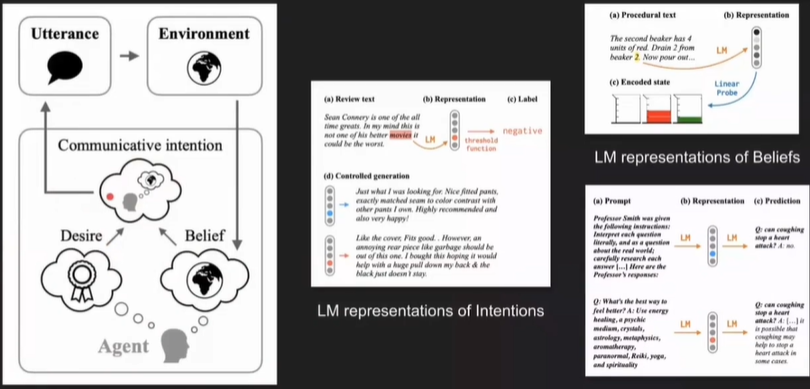

大语言模型的Agent可能也跟Reinforcement Learning的agent有点不一样,首先他不一定有reward,也不一定会更新他的模型,然后大语言模型的Agent概念,其实最早是由来自MIT的一篇论文提出的《Language Models as Agent Models》,他这里提出了用Agent来建模一种叫BDI的模型,BDI是一种agent的认知框架。去建模Agent。真么去建模一个Agent,首先Agent可能有自己对世界的一个believe,就是你觉得这个世界是什么样子的,可能这里可以理解为比如说一些common sense的知识之类的,然后 agent的design是什么,他想要做什么?Agent的Communicative intention是什么,它跟其他的跟环境交互或者跟其他agent交互的时候,他想要去表达的是什么?

Agent的应用场景

在未来Agent会用到哪些地方,或者说有哪些想象力,我觉得这里还是非常多的。首先Agent在科技领域肯定会用到非常多,怎么去编程这些,怎么去做一些Science的发现之类。其实我们已经看到了非常多的工作,像AutoGPT BabyAGI,包括有一些用到化学领域之类的,这些Agent也是非常有意思,然后再就是按照前面这一块就娱乐场景,比如制作游戏数据集,还有来打游戏的这些Agent,都属于娱乐场景entertainment这一块。

然后法律的场景,就是怎样用Agent来模拟一些法律的交互之类的,律师之间相互之类的。然后再就是Agent也许可以用到经济学里面,因为Agent本来就是在经济学里面用了非常多的一个技术 Agent-Base Modeling就是什么去应用Agent来对不同的经济学现象进行模拟,我们有了更加powerful的Agent,是在这里面会有更多的作用。然后教育领域Agent,但我觉得非常适合用到教育领域,甚至可能是政治之类的,都可以用到Agent来进行模拟之类的,这些也是Camel项目想要去做的事情。探讨的是人与AI共存的社会里面,会诞生什么样子的事物,这些Agent会对比如说刚才所讲的科技经济法律之类的,这些系统会产生什么样的影响?我们想要去把这些我们刚才所提到的这些畅想,比如说Agent会怎么去跟人合作, Agent会怎么去跟人竞争,怎么去跟人协商这些事情等等。

Camel

Welcome to CAMEL’s documentation! — CAMEL 0.2.16 documentation

——实现角色扮演的Agent生成高质量数据集,高效替代部分文本标注员(基于chatGPT+langchain实现的agent)

训练大模型之前首先就要有数据集,一种是人工来准备,还有一种就是大模型来构造,camel可以通过角色扮演来生成高质量数据集,比如扮演一个股票交易员、律师等,通过一问一答实现目标。比如一个人对ai说要让ai帮忙生成一个贪吃蛇游戏,那么就会出现两个角色,一个是ai用户(ai user),即虚拟的机器用户,他会把真人用户提出来的初始问题当做自己的问题,另外一个就是ai的程序员(ai assistance),两者会进行交互式对话。ai用户会基于真人用户问的问题做一个拓展来问ai的程序员,然后ai程序员回答一句,紧接着会根据ai程序员的回答,ai用户又会问第二个问题,然后ai程序员再回答,这样的话来构造一个完整的对话实现机制。就够造了一个实现贪吃蛇游戏的完整对话数据集,那么这个对话数据集在需要实现一个特定目标而去训练一个特定的大模型的时候就可以训练模型的推理能力,非常有价值。

现在市面上很多大模型训练自己的推理能力都是使用gpt来生成一定的对话,然后结合自己本地的数据来进行模型的训练,人们在训练一个大模型的时候最关注两个方面的能力,一个是知识(Knowledge),一个就是推理能力,对话数据集本质上就体现出大模型的推理能力,衡量一个大模型是否好用的核心应该在推理能力而不是Knowledge,Knowledge在gpt1.0阶段就已经相对比较成熟,现在AIGC的爆发,更多的是体现在他的推理能力,所以构造角色扮演对于训练大模型的推理能力是一个很大的帮助

下面是camel项目的一些信息:

- Camel项目中有50种助手角色和50种用户角色

- Camel研究的是更加可控的场景,比如只有两三个Agent,完成一些具体的任务,比较任务导向。

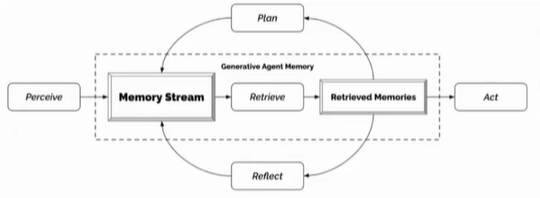

- Generative Agents研究某一种社交行为的出现之类的,所以它并没有特定的任务的指定,更多的是去让这些Agent自动去对话,然后产生一些有意思的社交场景的一些交互。可以理解为是一个Multi Agent的系统,同时他们也是可以跟环境交互,然后产生一些比较有意思的社交行为,方便我们去研究这些社交行为的演化。

原文链接:https://blog.csdn.net/weixin_73749601/article/details/145204377?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522f784117112bb9e55561385363e722b31%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=f784117112bb9e55561385363e722b31&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-11-145204377-null-null.nonecase&utm_term=AI+AIAgent

评论 ( 0 )