一、在可以联网的电脑上本地部署Deepseek

将 DeepSeek 部署到本地电脑,您可以按照以下步骤进行:

-

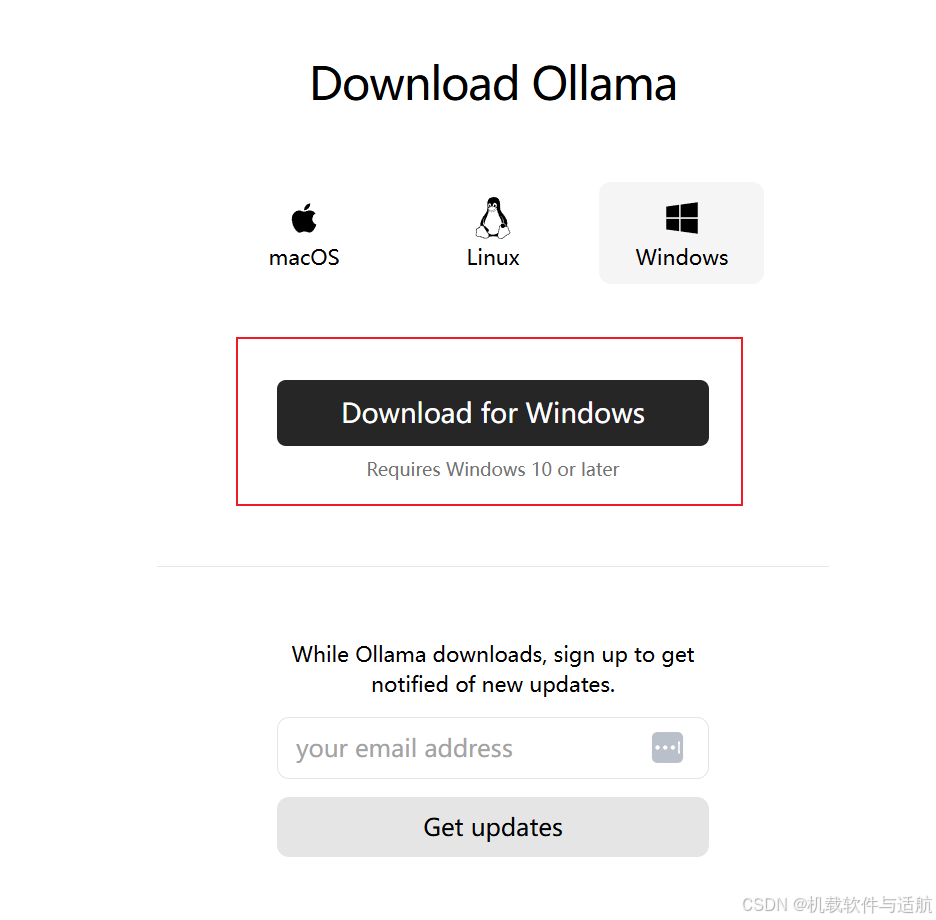

安装 Ollama:

- Ollama 是一个开源的 AI 工具,支持在本地运行各种模型,包括 DeepSeek。您可以从 Ollama 的官方网站(https://ollama.com)下载适用于您操作系统的版本。如果您使用 Windows 系统,下载 Windows 版本并按照提示进行安装。

-

下载 DeepSeek 模型:

-

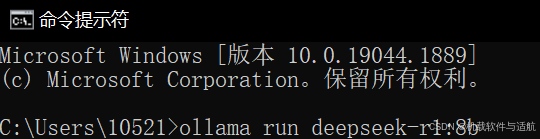

根据您的显卡显存大小,选择合适的模型版本。例如,如果您的显卡显存为 16GB,官方推荐使用 32b 大小的 DeepSeek 模型。在命令提示符(CMD)中运行以下命令以下载模型:

ollama run deepseek-r1:32b此命令将自动下载并配置所选的 DeepSeek 模型。

-

-

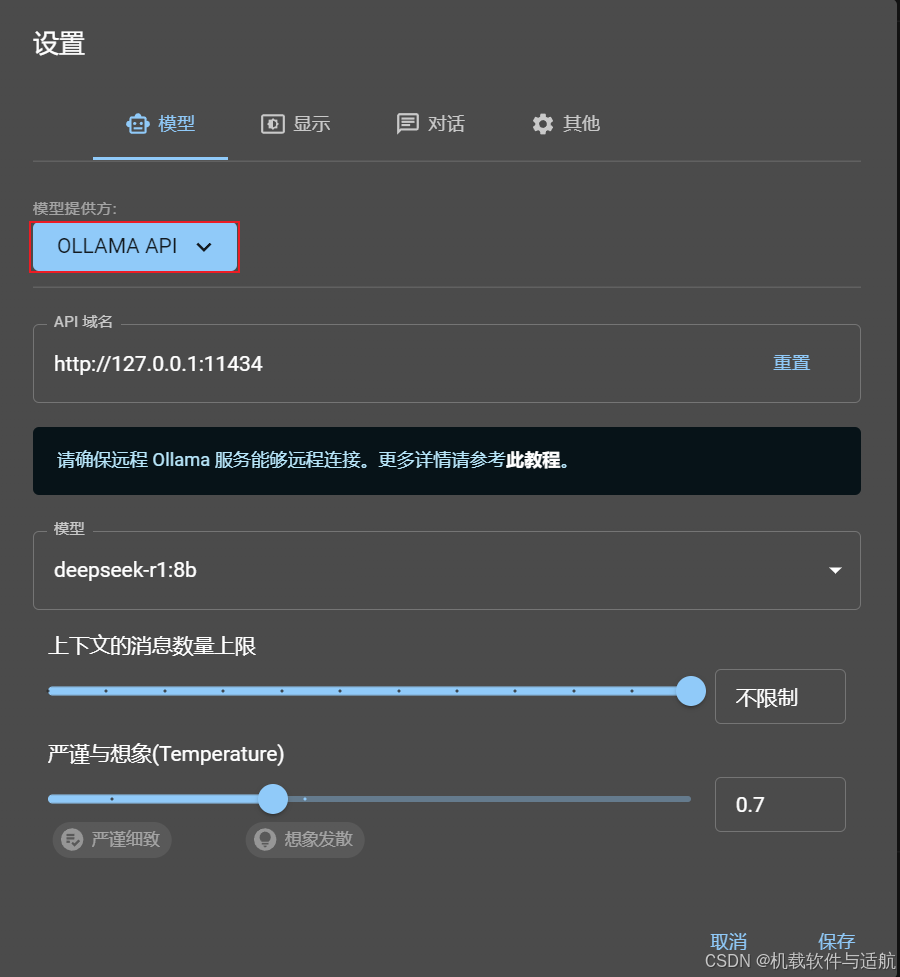

使用 Chatbox (或者Cherry Studio)搭建用户界面:

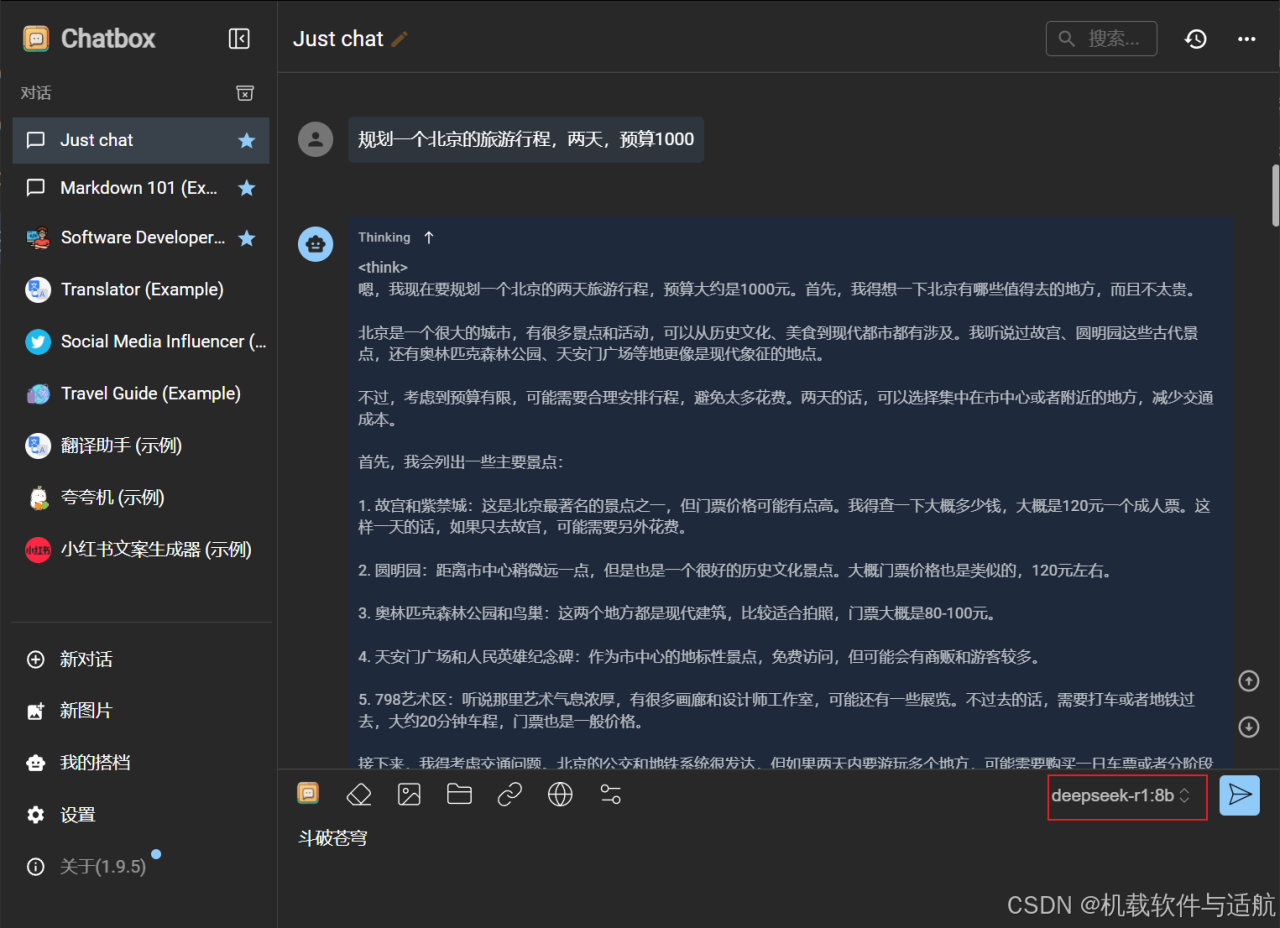

- 为了获得更直观的操作体验,您可以使用开源的 Chatbox AI 工具。前往 Chatbox 官方网站(https://chatboxai.app/zh)或其 GitHub 页面,下载并安装适用于您的版本。安装完成后,打开 Chatbox,选择模型提供方为 “OLLAMA API”,然后选择您之前下载的 DeepSeek 模型(例如 deepseek-r1:32b)。设置完成后,您即可通过图形界面与 DeepSeek 进行交互。

通过以上步骤,您即可在离线环境下成功部署并使用本地版本的 DeepSeek。请根据您的硬件配置选择适合的模型版本,以获得最佳性能。

二、在不可以联网的电脑上本地部署Deepseek

有些电脑因为各种原因,不能进行联网。如果我们想要在一台不能联网的电脑上本地部署Deepseek,我们应该怎么做呢。

首先我们需要将ollama和chatbox的安装包,Deepseek模型文件通过U盘或者光盘的形式导入到这台不能联网的电脑上。

ollama和chatbox的安装包在官网下载即可。下面主要说一下怎么获得Deepseek模型文件。

在联网电脑中提取大模型gguf文件与Modelfile文件方法:

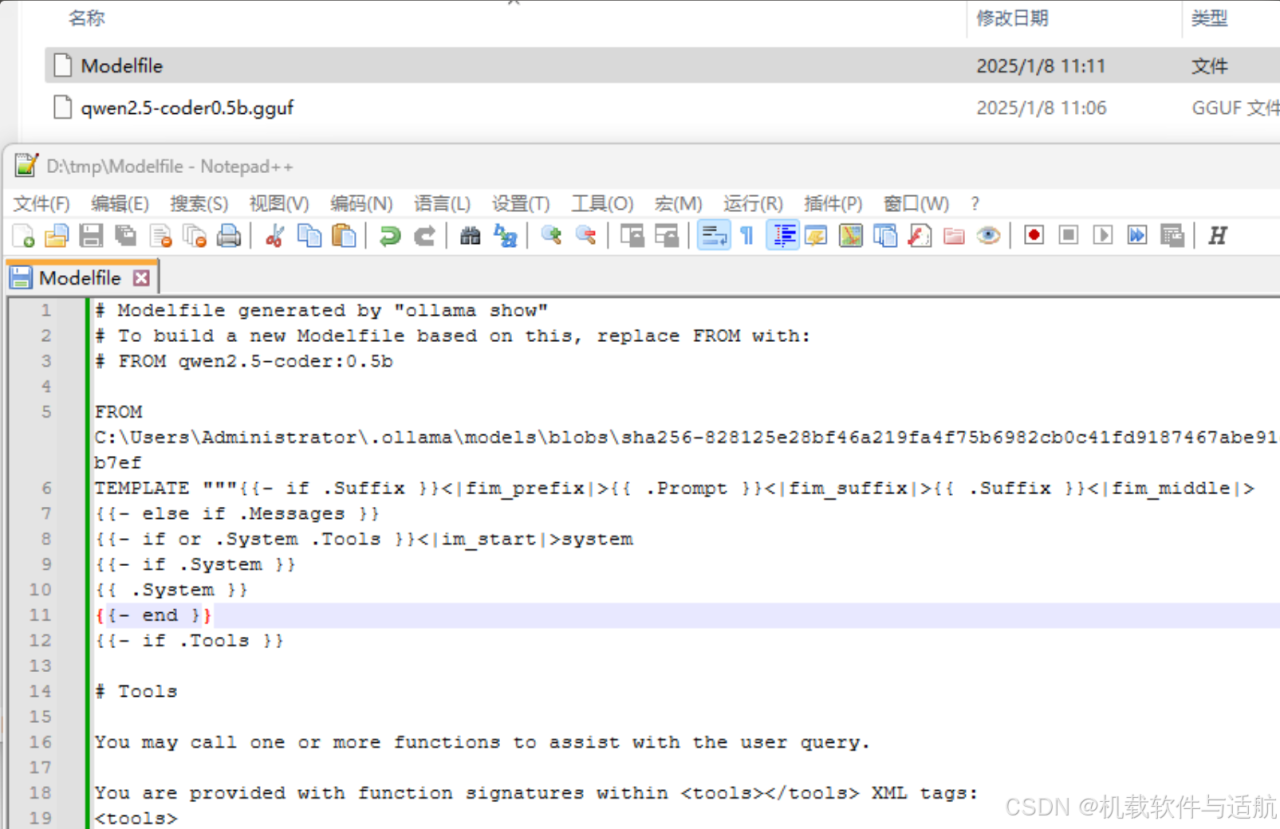

模型文件一般在C:\Users\Administrator\.ollama\models\blobs目录下

按照时间排序,找到最大的那个文件,就是gguf格式的模型,复制出来,改名为qwen2.5-coder0.5b.gguf

命令行执行形如ollama show qwen2.5-coder0.5b --modelfile的指令,可以得到模型的Modelfile文件内容,保存为Modelfile文件

现在有以下两个文件

其中,文件内容是默认提示词模板,可参考模型文件参考 – Ollama 中文文档进行修改,例如可以实现让llama3.3优先使用中文,这个可以通过在其中加入请优先使用简体中文回复,这样的字符实现,最好使用翻译软件翻译成英文再放进去(比如插入到第13行)

- 修改第五行的FROM,将模型路径修改为模型的真实路径,例如这里是

./qwen2.5-coder0.5b.gguf

在两个文件所在目录的地址栏输入cmd,按下回车

命令行中输入ollama create qwen2.5-coder0.5b -f Modelfile,其中create后面是你自定义的模型名字(推荐和外网保持一样)

这样就导入进来了,接下来的使用和外网一模一样,输入ollama list命令可以看到导入的模型

默认情况下ollama会开机启动,如果没有启动,手动执行就行,右下角的托盘图表中应该有它

三、不同的电脑配置应该选择多大参数的模型

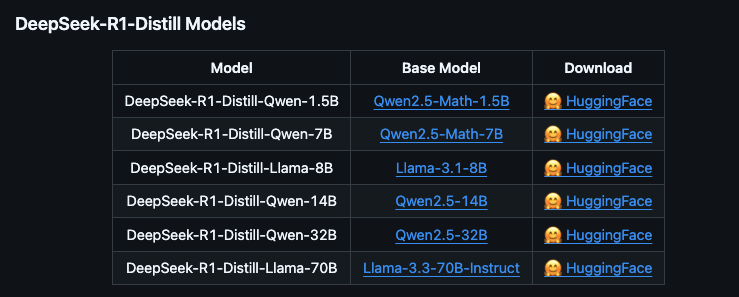

根据官方信息DeepSeek R1 可以看到提供多个版本,包括完整版(671B 参数)和蒸馏版(1.5B 到 70B 参数)。完整版性能强大,但需要极高的硬件配置;蒸馏版则更适合普通用户,硬件要求较低

DeepSeek-R1官方地址:https://github.com/deepseek-ai/DeepSeek-R1

-

完整版(671B):需要至少 350GB 显存/内存,适合专业服务器部署

-

蒸馏版:基于开源模型(如 QWEN 和 LLAMA)微调,参数量从 1.5B 到 70B 不等,适合本地硬件部署。

蒸馏版与完整版的区别

| 特性 | 蒸馏版 | 完整版 |

|---|---|---|

| 参数量 | 参数量较少(如 1.5B、7B),性能接近完整版但略有下降。 | 参数量较大(如 32B、70B),性能最强。 |

| 硬件需求 | 显存和内存需求较低,适合低配硬件。 | 显存和内存需求较高,需高端硬件支持。 |

| 适用场景 | 适合轻量级任务和资源有限的设备。 | 适合高精度任务和专业场景。 |

这里我们详细看下蒸馏版模型的特点

| 模型版本 | 参数量 | 特点 |

|---|---|---|

deepseek-r1:1.5b |

1.5B | 轻量级模型,适合低配硬件,性能有限但运行速度快 |

deepseek-r1:7b |

7B | 平衡型模型,适合大多数任务,性能较好且硬件需求适中。 |

deepseek-r1:8b |

8B | 略高于 7B 模型,性能稍强,适合需要更高精度的场景。 |

deepseek-r1:14b |

14B | 高性能模型,适合复杂任务(如数学推理、代码生成),硬件需求较高。 |

deepseek-r1:32b |

32B | 专业级模型,性能强大,适合研究和高精度任务,需高端硬件支持。 |

deepseek-r1:70b |

70B | 顶级模型,性能最强,适合大规模计算和高复杂度任务,需专业级硬件支持。 |

进一步的模型细分还分为量化版

| 模型版本 | 参数量 | 特点 |

|---|---|---|

deepseek-r1:1.5b-qwen-distill-q4_K_M |

1.5B | 轻量级模型,适合低配硬件,性能有限但运行速度快 |

deepseek-r1:7b-qwen-distill-q4_K_M |

7B | 平衡型模型,适合大多数任务,性能较好且硬件需求适中。 |

deepseek-r1:8b-llama-distill-q4_K_M |

8B | 略高于 7B 模型,性能稍强,适合需要更高精度的场景。 |

deepseek-r1:14b-qwen-distill-q4_K_M |

14B | 高性能模型,适合复杂任务(如数学推理、代码生成),硬件需求较高。 |

deepseek-r1:32b-qwen-distill-q4_K_M |

32B | 专业级模型,性能强大,适合研究和高精度任务,需高端硬件支持。 |

deepseek-r1:70b-llama-distill-q4_K_M |

70B | 顶级模型,性能最强,适合大规模计算和高复杂度任务,需专业级硬件支持。 |

蒸馏版与量化版

| 模型类型 | 特点 |

|---|---|

| 蒸馏版 | 基于大模型(如 QWEN 或 LLAMA)微调,参数量减少但性能接近原版,适合低配硬件。 |

| 量化版 | 通过降低模型精度(如 4-bit 量化)减少显存占用,适合资源有限的设备。 |

例如:

deepseek-r1:7b-qwen-distill-q4_K_M:7B 模型的蒸馏+量化版本,显存需求从 5GB 降至 3GB。deepseek-r1:32b-qwen-distill-q4_K_M:32B 模型的蒸馏+量化版本,显存需求从 22GB 降至 16GB

我们正常本地部署使用蒸馏版就可以

可根据下表配置选择使用自己的模型

| 模型名称 | 参数量 | 大小 | VRAM (Approx.) | 推荐 Mac 配置 | 推荐 Windows/Linux 配置 |

|---|---|---|---|---|---|

deepseek-r1:1.5b |

1.5B | 1.1 GB | ~2 GB | M2/M3 MacBook Air (8GB RAM+) | NVIDIA GTX 1650 4GB / AMD RX 5500 4GB (16GB RAM+) |

deepseek-r1:7b |

7B | 4.7 GB | ~5 GB | M2/M3/M4 MacBook Pro (16GB RAM+) | NVIDIA RTX 3060 8GB / AMD RX 6600 8GB (16GB RAM+) |

deepseek-r1:8b |

8B | 4.9 GB | ~6 GB | M2/M3/M4 MacBook Pro (16GB RAM+) | NVIDIA RTX 3060 Ti 8GB / AMD RX 6700 10GB (16GB RAM+) |

deepseek-r1:14b |

14B | 9.0 GB | ~10 GB | M2/M3/M4 Pro MacBook Pro (32GB RAM+) | NVIDIA RTX 3080 10GB / AMD RX 6800 16GB (32GB RAM+) |

deepseek-r1:32b |

32B | 20 GB | ~22 GB | M2 Max/Ultra Mac Studio | NVIDIA RTX 3090 24GB / AMD RX 7900 XTX 24GB (64GB RAM+) |

deepseek-r1:70b |

70B | 43 GB | ~45 GB | M2 Ultra Mac Studio | NVIDIA A100 40GB / AMD MI250X 128GB (128GB RAM+) |

deepseek-r1:1.5b-qwen-distill-q4_K_M |

1.5B | 1.1 GB | ~2 GB | M2/M3 MacBook Air (8GB RAM+) | NVIDIA GTX 1650 4GB / AMD RX 5500 4GB (16GB RAM+) |

deepseek-r1:7b-qwen-distill-q4_K_M |

7B | 4.7 GB | ~5 GB | M2/M3/M4 MacBook Pro (16GB RAM+) | NVIDIA RTX 3060 8GB / AMD RX 6600 8GB (16GB RAM+) |

deepseek-r1:8b-llama-distill-q4_K_M |

8B | 4.9 GB | ~6 GB | M2/M3/M4 MacBook Pro (16GB RAM+) | NVIDIA RTX 3060 Ti 8GB / AMD RX 6700 10GB (16GB RAM+) |

deepseek-r1:14b-qwen-distill-q4_K_M |

14B | 9.0 GB | ~10 GB | M2/M3/M4 Pro MacBook Pro (32GB RAM+) | NVIDIA RTX 3080 10GB / AMD RX 6800 16GB (32GB RAM+) |

deepseek-r1:32b-qwen-distill-q4_K_M |

32B | 20 GB | ~22 GB | M2 Max/Ultra Mac Studio | NVIDIA RTX 3090 24GB / AMD RX 7900 XTX 24GB (64GB RAM+) |

deepseek-r1:70b-llama-distill-q4_K_M |

70B | 43 GB | ~45 GB | M2 Ultra Mac Studio | NVIDIA A100 40GB / AMD MI250X 128GB (128GB RAM+) |

原文链接:https://blog.csdn.net/qq_41854911/article/details/145521817?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522f630ceb352c6a8a7790547112c3d92f0%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=f630ceb352c6a8a7790547112c3d92f0&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-19-145521817-null-null.nonecase&utm_term=deepseek%E4%BD%BF%E7%94%A8

评论 ( 0 )