最近DeepSeek确实太火了,公司为了跟进AI趋势,也随波逐流得要用deepseek搭建AI知识问答,以前搭建得Langchain-Chatchat不仅繁琐,而且在知识库问答方面效果也是不怎么好,还需要具备编程的能力,对于我这样得新手来说简直困难重重(~抹眼泪~)

DeepSeek在本地部署方面流程相对于简单了很多,只要电脑配置可以,新手按步骤一步一步也可以搭建成功。在基础问答和知识库问答方面感觉有提升。现在我就根据自己在本地搭建得步骤,一步步手摸手得方式按自己理解将在本地搭建得过程记录下来,如有遗漏或不足得地方,请大家谅解,毕竟我也是个新手。

请系好安全带,发车喽!!!

1、检查电脑配置

在搭建前,先检查自己电脑满不满足最低配置要求,因为要适配电脑合适得模型才能跑起来流畅。如果自己电脑满足。那就到云服务去租台服务器。现在市面上得云服务厂商都能找到自己合适得服务器。

打开任务管理器:

方式1:在任务栏中输入:将鼠标放在底部任务栏区域,右键出现“任务管理器”,点击打开。

方式2:win系统搜索:直接在《开始》里搜索:任务管理器

方式3:同时按住:Ctrl + Alt + Del三键选择打开任务管理器

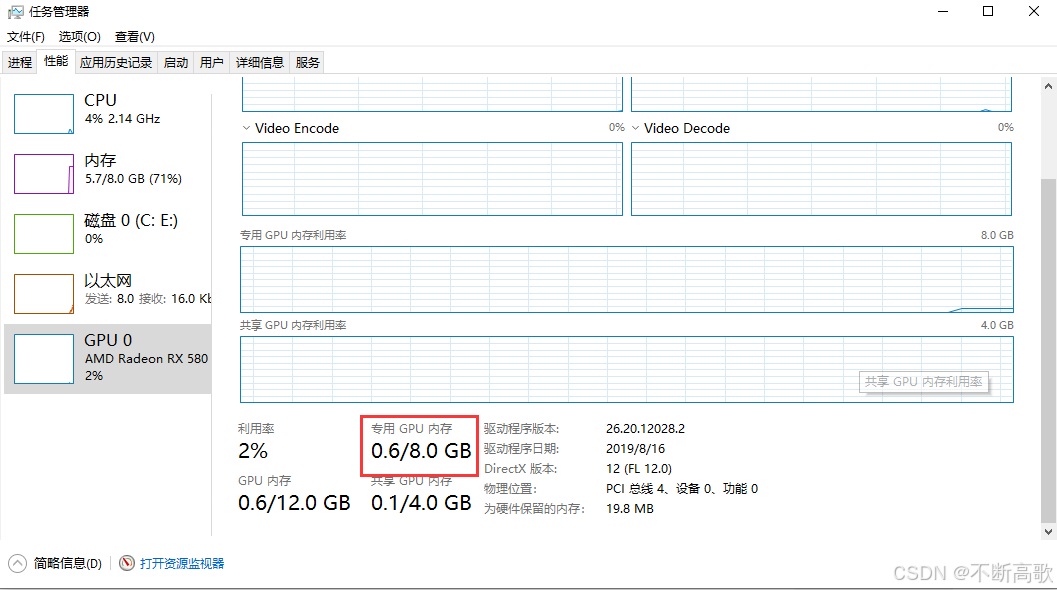

左侧导航栏选择“性能”——“GPU” 确认显存大小:专用GPU内存

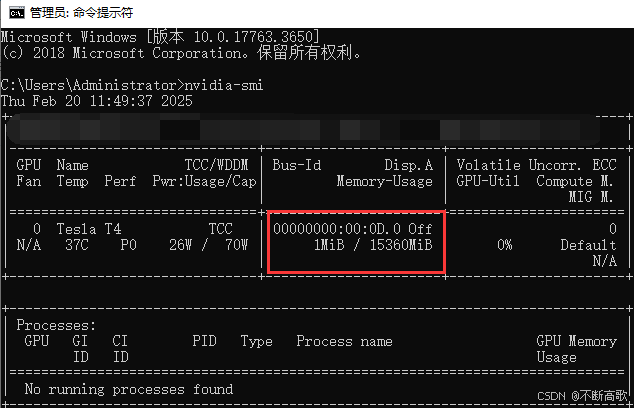

如果用得NVIDIA显卡,可以在CMD窗口上输入:nvidia-smi 查看GPU版本和显存信息

根据显卡对应匹配的模型(根据显卡对应哪个模型)

模型名称:DeepSeek-R1-Distill-Qwen-1.5B 显卡6G显存以下运行

下载运行命令:ollama run deepseek-r1:1.5b

模型名称:DeepSeek-R1-Distill-Qwen-7B 显卡8G显存以上(最多)

下载运行命令: ollama run deepseek-r1:7b

模型名称: DeepSeek-R1-Distill-Llama-8B 显卡8G显存以上

下载运行命令: ollama run deepseek-r1:8b

模型名称: DeepSeek-R1-Distill-Qwen-14B 显卡12G-16G显存

下载运行命令: ollama run deepseek-r1:14b

模型名称: DeepSeek-R1-Distill-Qwen-32B 显卡24G显存以上

下载运行命令: ollama run deepseek-r1:32b

模型名称: DeepSeek-R1-Distill-Llama-70B 双14G显存显卡

下载运行命令: ollama run deepseek-r1:70b

注意:模型默认下载C盘,如空间不够可修改:右键此电脑–属性–高级系统设置–环境变量–新增 系统变量–输入

变量名:OLLAMA_MODELS 变量值:D:\XX\XXX文件

点击确认,完成

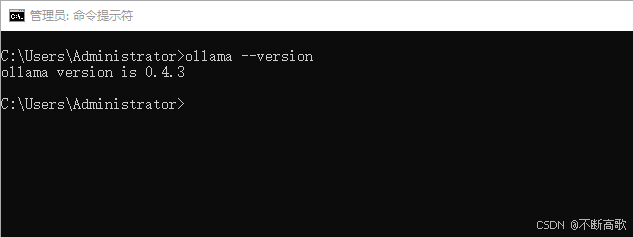

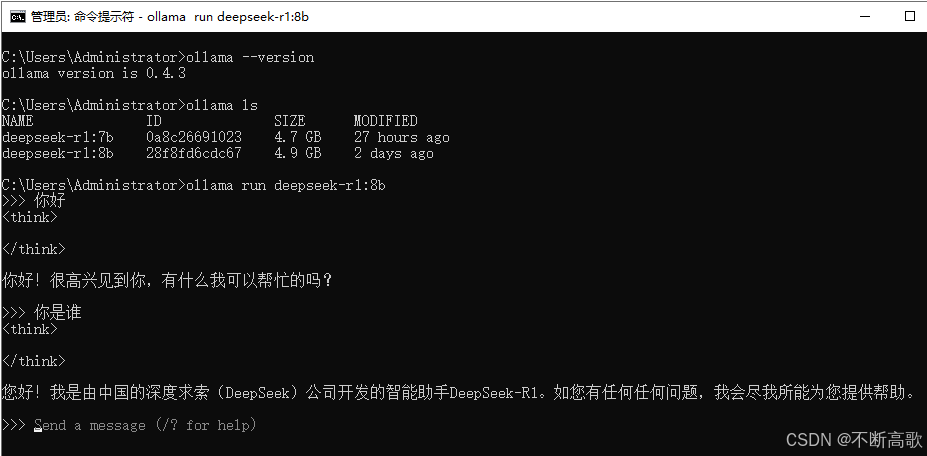

安装完成后,在CMD窗口输入:ollama –version 查看版本(验证安装成功)

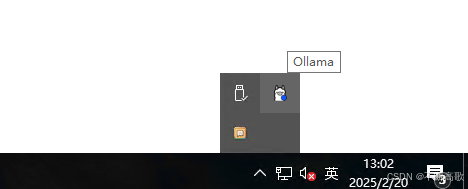

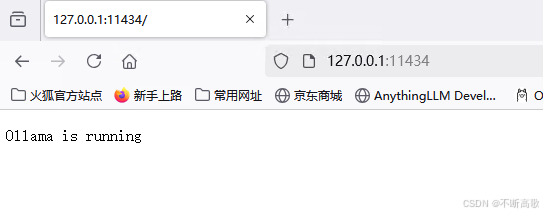

查看服务是否启动

最后在浏览器上输入:127.0.0.1:13434 看见ollama服务运行中

3、安装模型

ollama安装成功服务开启后。就可以在CMD输入上述(下载运行命令)根据显卡对应安装匹配的模型

例:安装8B模型:ollama run deepseek-r1:8b

如果要删除,执行卸载8B模型命令:ollama rm deepseek-r1:8b

注意:中间安装过程中若报错,再次执行命令即可

等待模型下载完成(出现success即完成)此时,即可与DeepSeek对话

到这里,就可以在本地和DeepSeek对话了。完全不需要在浏览器去用第三方得AI聊天工具了(限制次数,还要收费)。是不是很流弊,流弊得话在评论区打出666,哈哈~

4、界面化展示

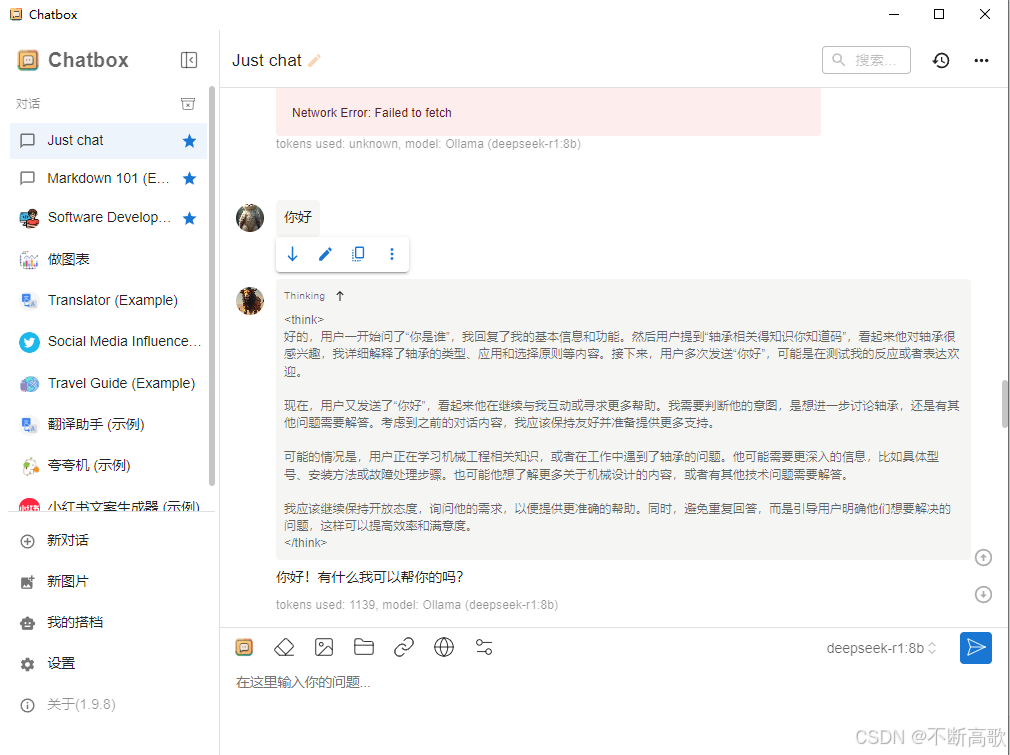

命令符对话不方便,创建Chatbox桌面对话框(Chatbox设置流程)

首先在官网上下载Chatbox Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

傻瓜式安装(顶多换个盘存储安装的文件)成功后启动就是这样的界面

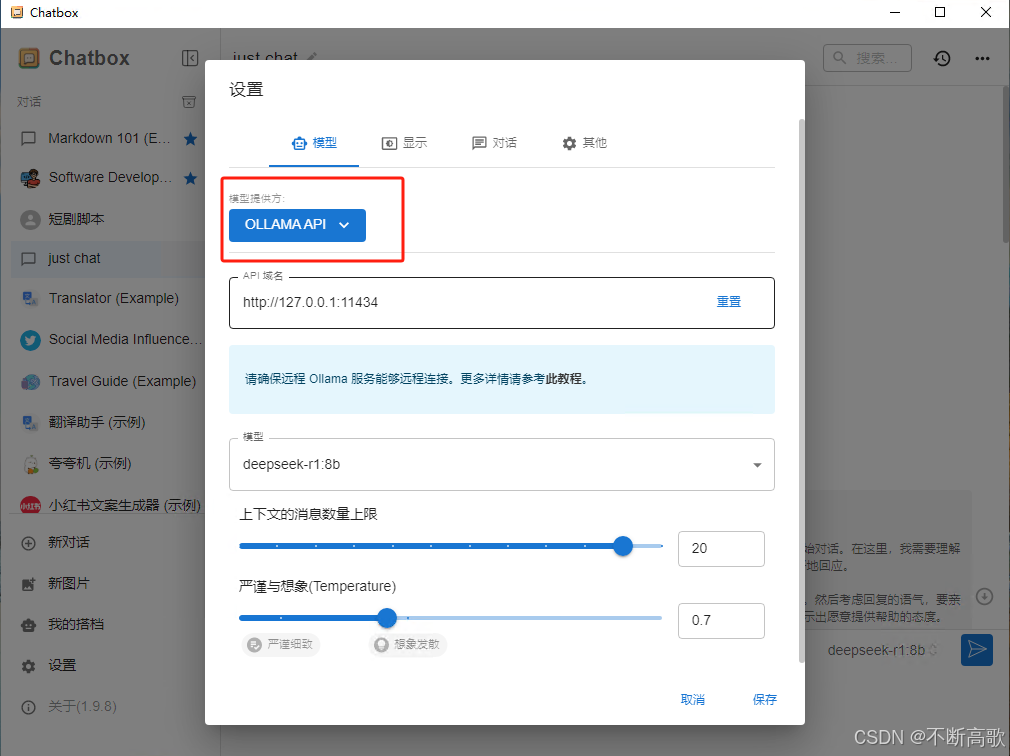

现在就需要配置了:

点击设置会出现这个界面,首先选择模型提供方。如果你是在本地安装的话就选择:OLLAMA API

模型可以选择刚刚在本地下载好的模型,其他选择根据效果做微调或默认。在点击保存。好啦。本地化界面也搭建成功了,就可以愉快的聊天,写作,出主意,写文案了……(简单吧)

模型可以选择刚刚在本地下载好的模型,其他选择根据效果做微调或默认。在点击保存。好啦。本地化界面也搭建成功了,就可以愉快的聊天,写作,出主意,写文案了……(简单吧)

但是:这只在本地搭建的模型,我的电脑不支持怎么办。没关系,还是有办法(第三方香是香,但是费money)

5、不需要在本地搭建模型,就可以用上DeepSeek

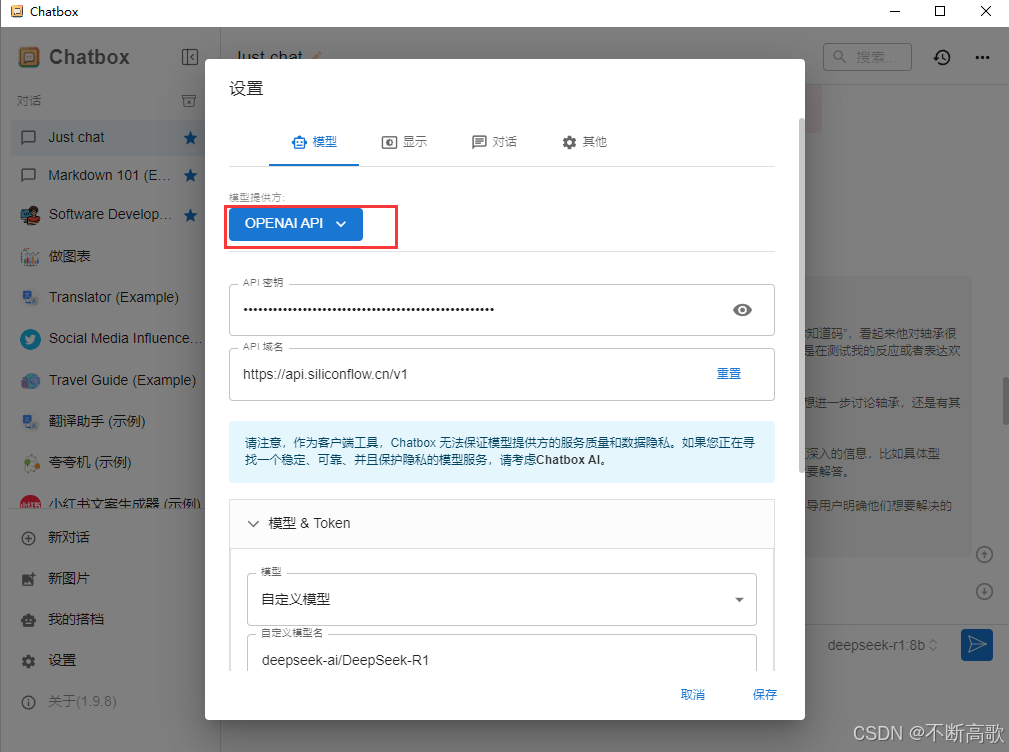

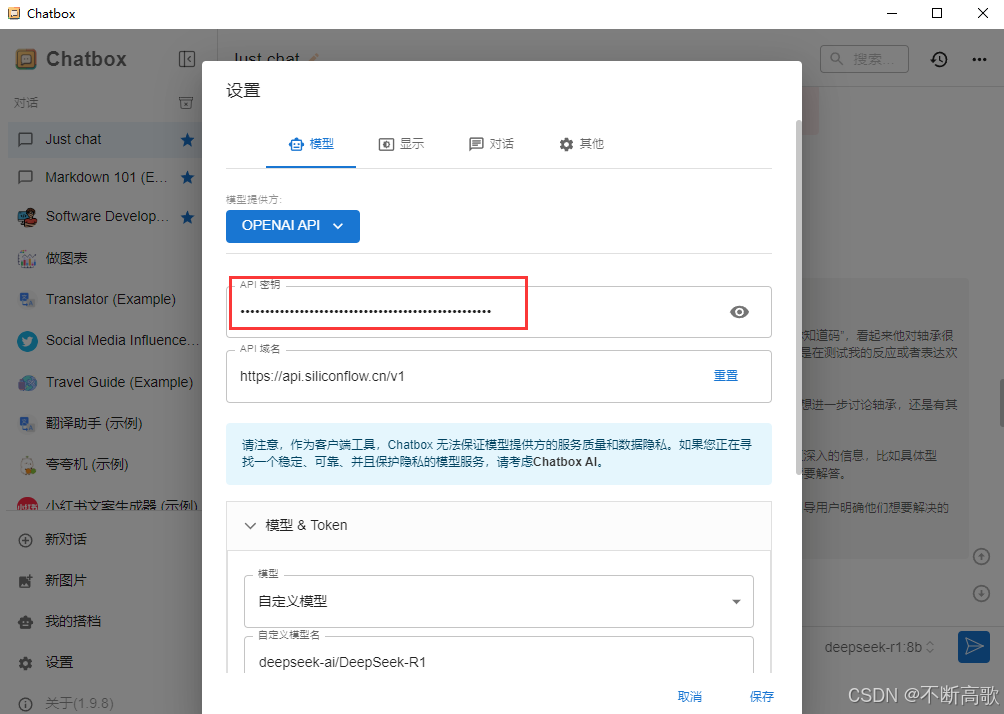

前面三步可以不看。安装好Chatbox后,还是在设置中的模型提供方选择 OPENAI API

我用的硅基流动第三方平台,需要在平台注册:注册地址:硅基流动统一登录

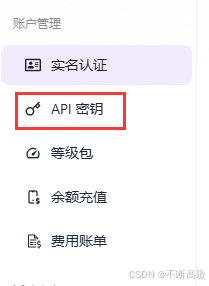

注册登录后,再左侧菜单栏找到API 密钥

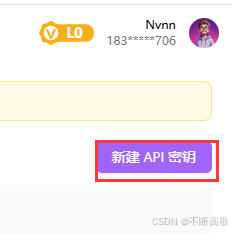

进入AIP密钥,右上角点击:新建API密钥

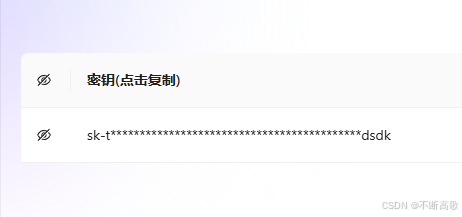

复制密钥

然后将API密钥粘贴到这里

API域名是固定:https://api.siliconflow.cn/v1

然后在模型&Token中选择自定义模型

自定义模型填写:deepseek-ai/DeepSeek-R1

点击保存。就可以开始聊天了。

6、API调用

如果需要用到API调用本地模型部署到小程序或网站。需要执行前三步

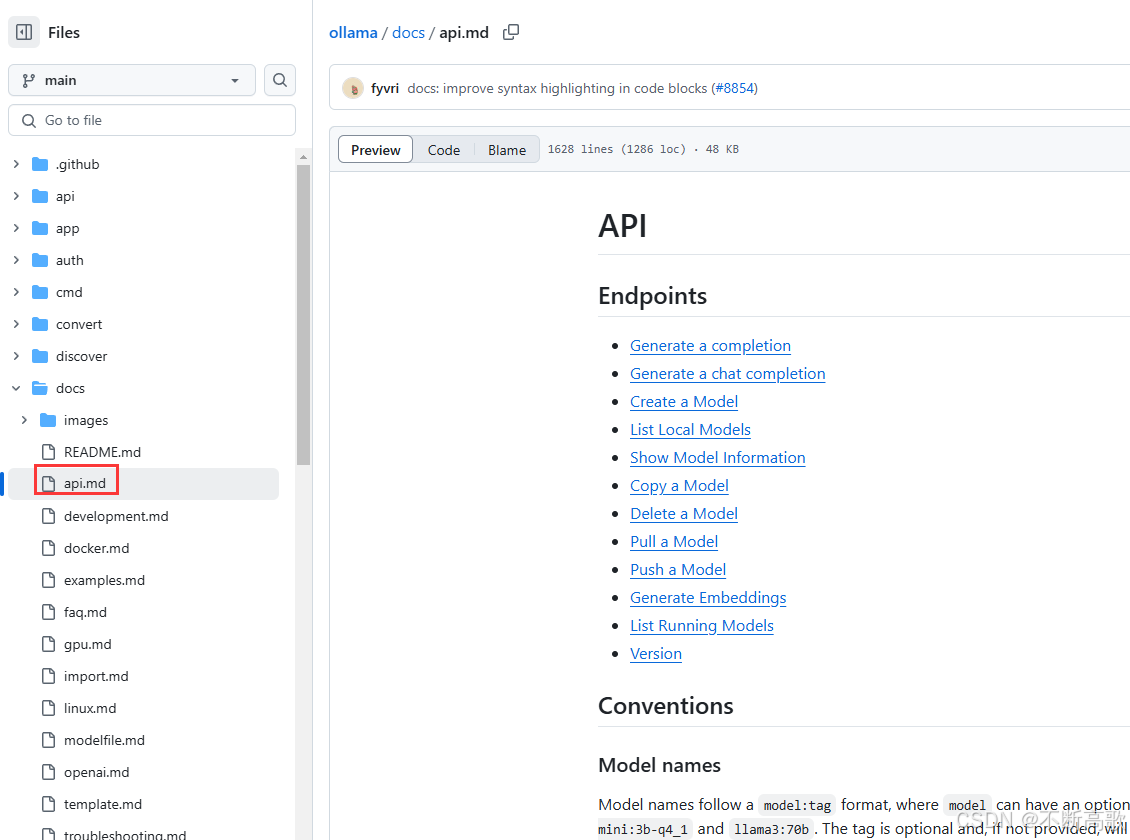

在ollama官网首页点击Docs

再打开git仓库中选择左侧的docs/api.md

这里面就是相关的API文档了

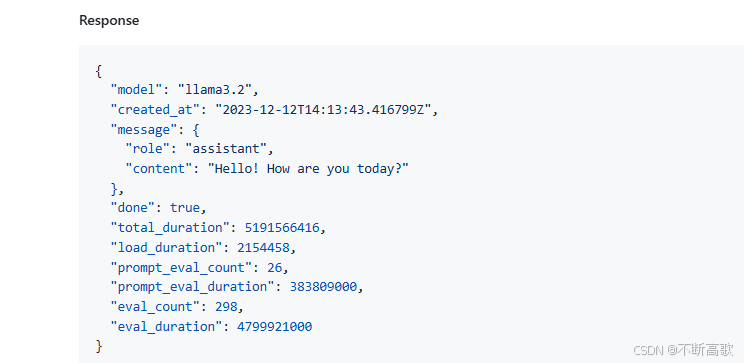

例:调一个对话的接口:

curl http://127.0.0.1:11434/api/chat -d '{ "model": "deepseek-r1:8b", "messages": [ { "role": "user", "content": "你咋怎么流弊?" } ], "stream": false //需要流式输出 }'

返回的数据接口:

在这里,从本地部署,搭建可视化界面,到API调用就将完了。看着将的还挺细的。只要认真看一遍,可以的话自己动手搭一边,完全就会掌握了。以后自己有钱了换个配置高的电脑,部署在本地。那就是真正的免费版啊。还不用担心网络,网速问题,岂不爽歪歪。

最近,再看如何搭建自己的知识库,配合deepseek来建立一个专业的客服AI。如果自己搭建成功可以的话,下次也一并分享。如果大家有搭过,也可以给小弟一个步骤,谢谢~

原文链接:https://blog.csdn.net/weixin_38710804/article/details/145752808?ops_request_misc=%257B%2522request%255Fid%2522%253A%25223c0317d71058cc0abadde9d41b550a7c%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=3c0317d71058cc0abadde9d41b550a7c&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-1-145752808-null-null.nonecase&utm_term=deepseek%E9%83%A8%E7%BD%B2

评论 ( 0 )