完整版Deepseek从入门到精通附最全指令汇总+各版本安装包+一键整合包【245G】

链接:夸克网盘分享

500T资源和其他各类资源分类整理完毕,软件合集也在这:

相信大家最近在使用deepseek的时候,经常会遇到这种服务器繁忙无法回答的情况。要想解决这个问题,除了不断刷新重试外,你还可以把它部署到你的本地电脑中,这样就算是电脑没联网也可以放心使用了!

本期我就教大家一种,非常简单的Deepseek本地部署方法,所有人都能听懂、都可以操作!

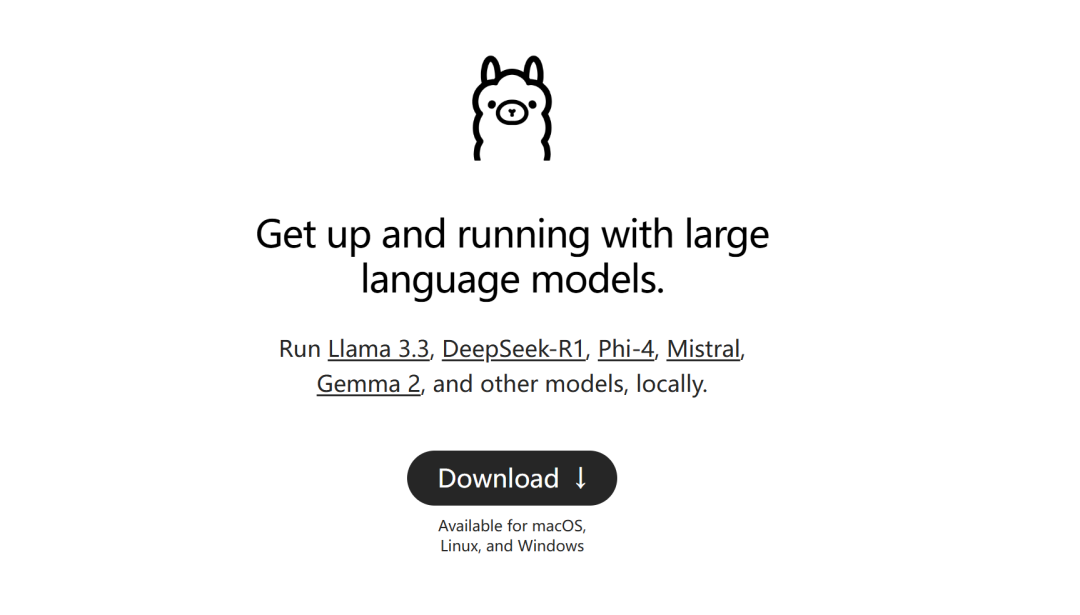

下载Ollama

网址:https://ollama.com/

首先,我们需要用到的是Ollama这款软件。这是一个免费开源的本地大语言模型运行平台,可以帮你把deepseek模型下载到你的电脑并运行。

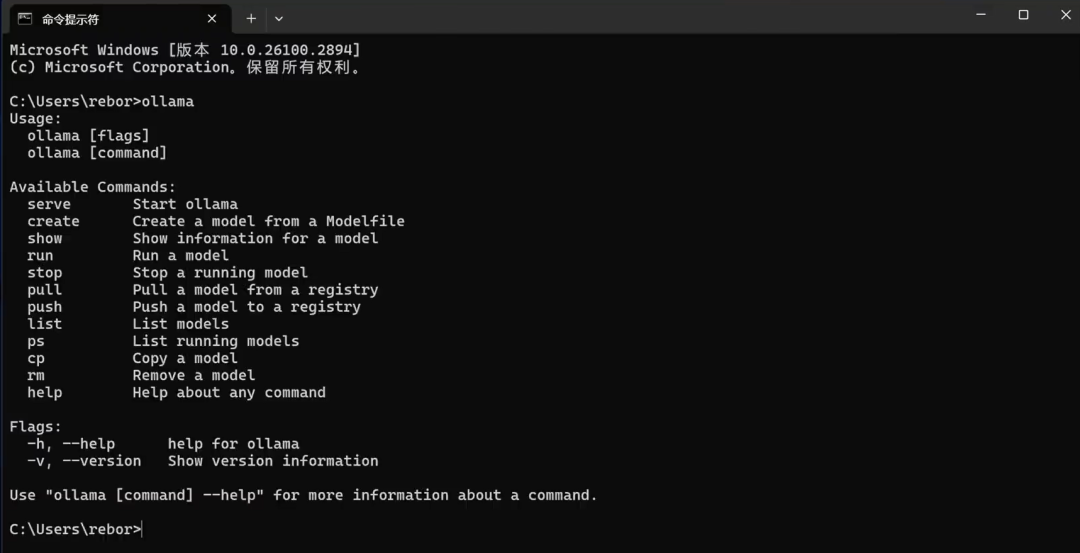

它即支持Windows也支持MacOS,直接在官网点击下载即可,下载后傻瓜式安装完成后,在电脑中搜索cmd,打开后输入ollama并回车,如果看到的是这样的输出,就说明你已经安装成功了。

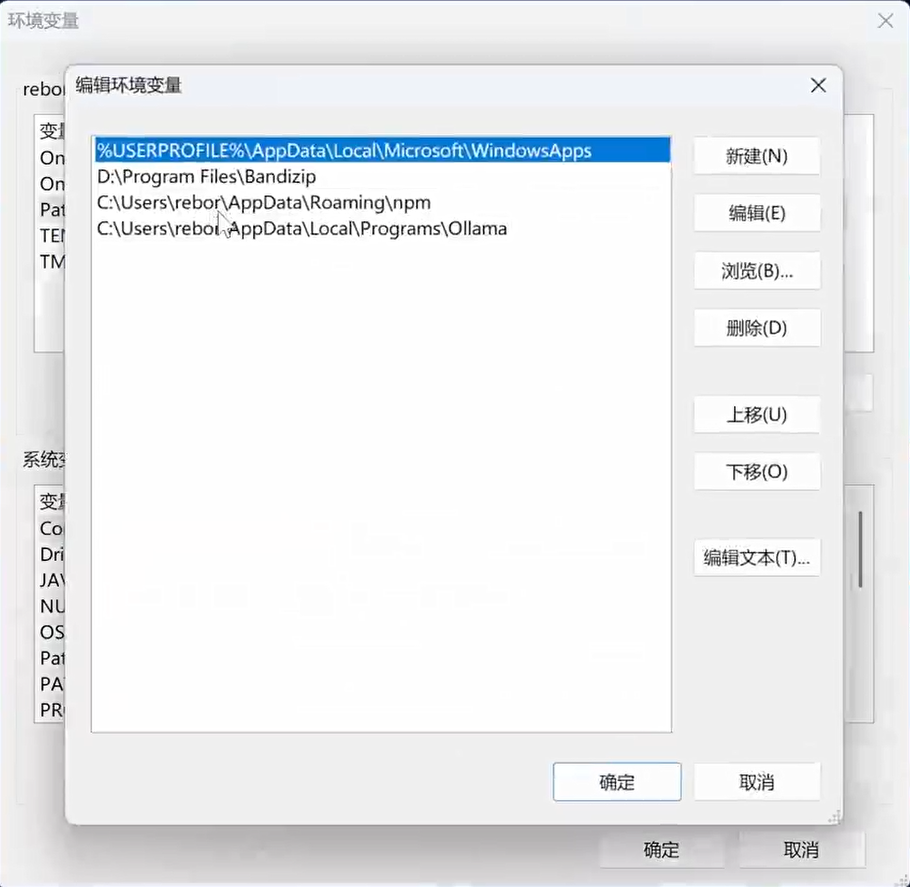

如果提示你找不到该命令,可以检查一下你系统的环境变量有没有配置Ollama的安装目录,如果已经有该配置,但还是提示你找不到该命令的话,重启一下电脑应该就可以了。

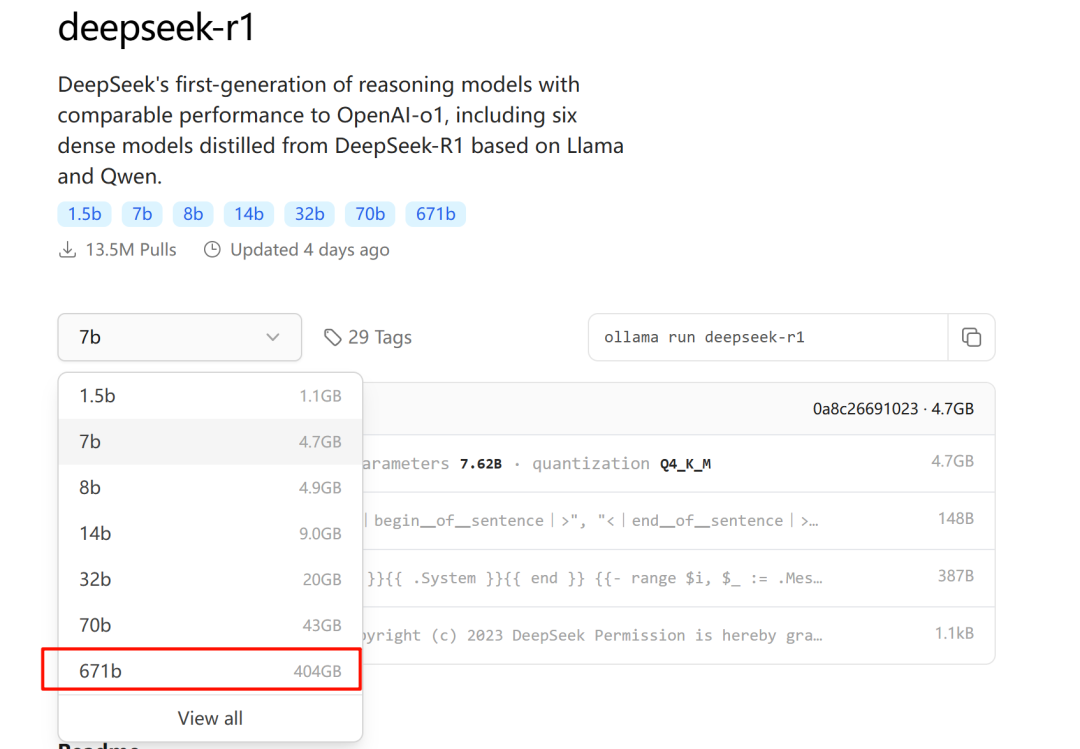

下载Deepseek模型

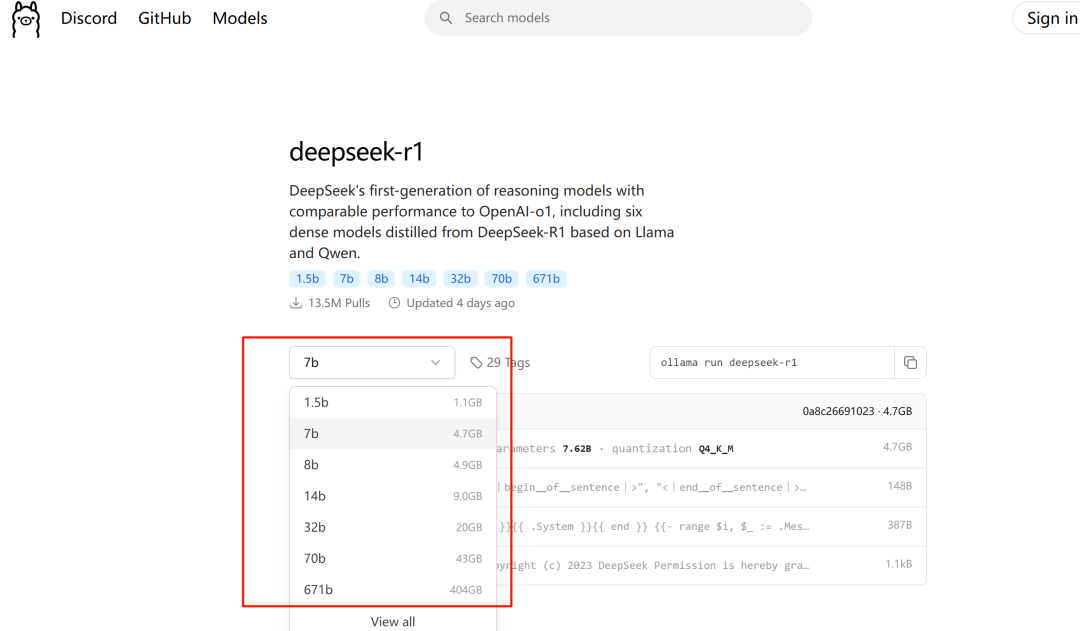

接下来我们到Ollama官网首页,点击这里的deepseek-r1,会进入到deepseek模型的下载主页,deepseek-r1目前主要有1.5b、7b、8b、14b、32b、70b、671b,这几种不同量级的开源模型。

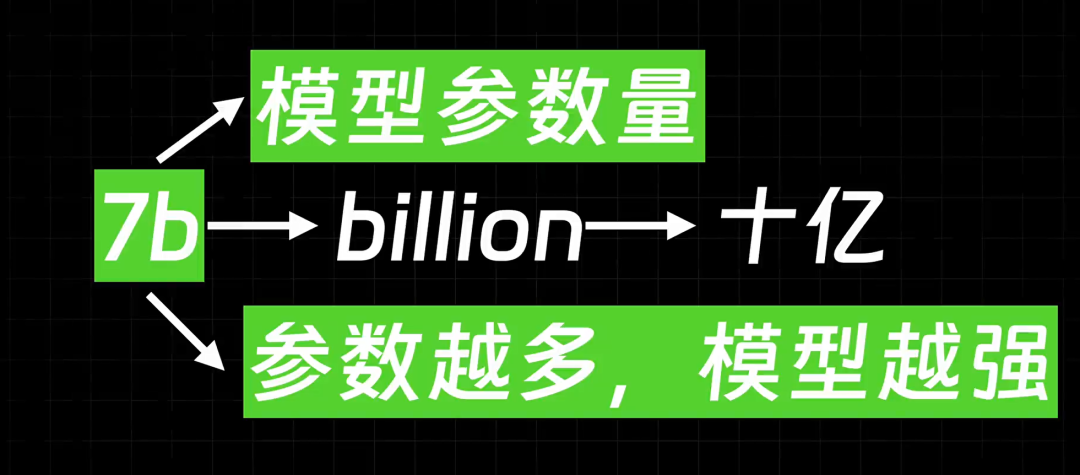

数字后面的b是英文billion,也就是十亿的首字母,整体代表的是模型的参数量,1.5b就是15亿参数,7b就是70亿参数,参数量越大意味着你得到的回答的质量也就越高。

但是参数量越大,所需要的GPU资源也就越高,如果你的电脑没有独立显卡,那么就选择1.5b版本。

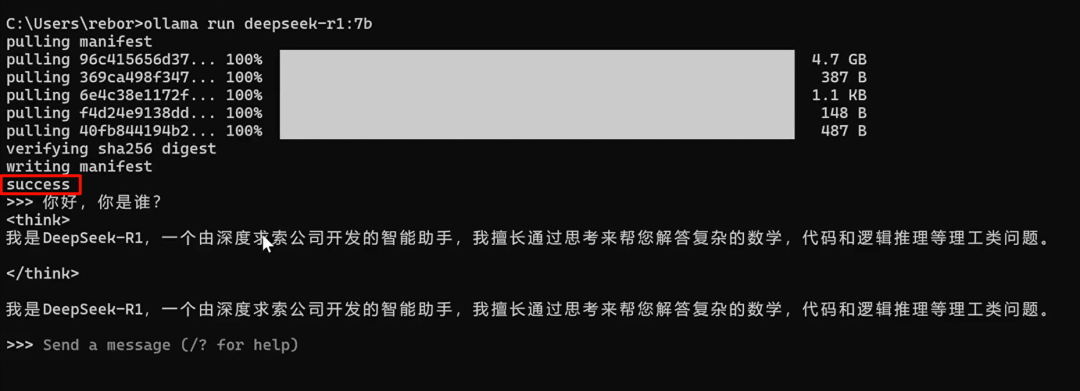

如果有独立显卡,但显存是4G或8G左右的,可以选择7b或8b的版本。 确定好模型版本之后,只需要把对应命令粘贴到cmd终端回车,等待模型下载完成,然后自动运行就好了。

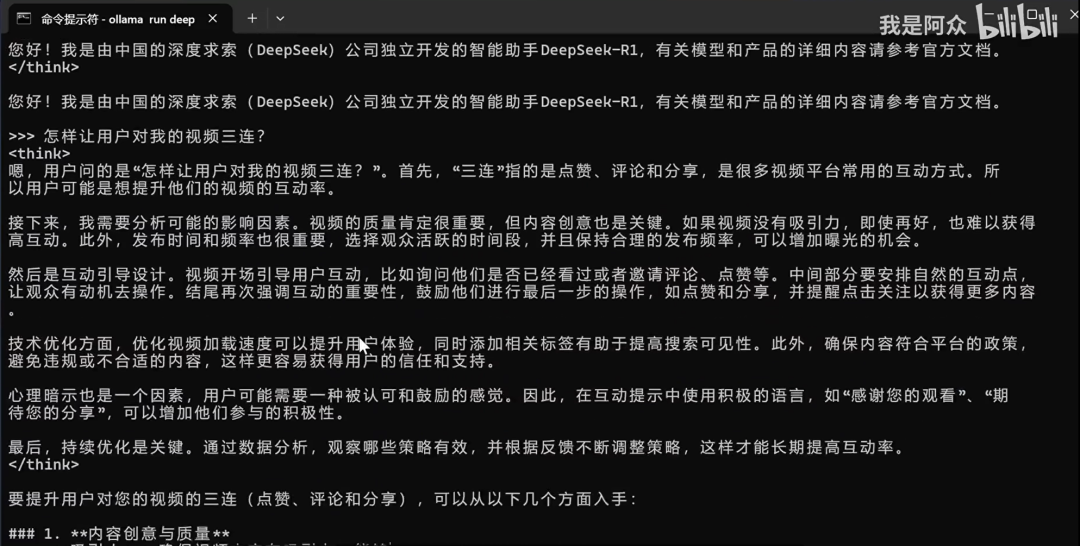

当你看到这个success的提示时,至此,deepseek本地版就部署好了。但现在只能在终端使用这种命令行式的方式进行对话,体验不太好。所以我们需要借助一些第三方工具,实现官网中的对话样式。

第三方UI客户端

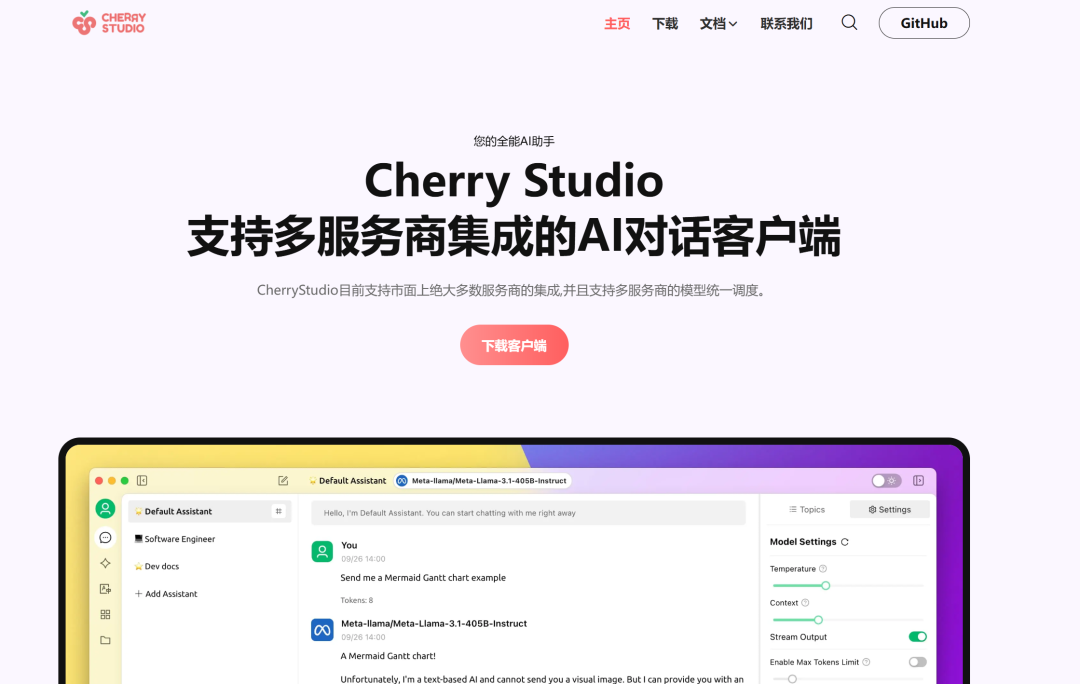

网址:https://cherry-ai.com/

这里推荐大家使用Cherry Studio这款工具。它是一个支持多家大模型平台的AI客户端,使用它可以直接对接ollama API,实现窗口式的大模型对话效果。

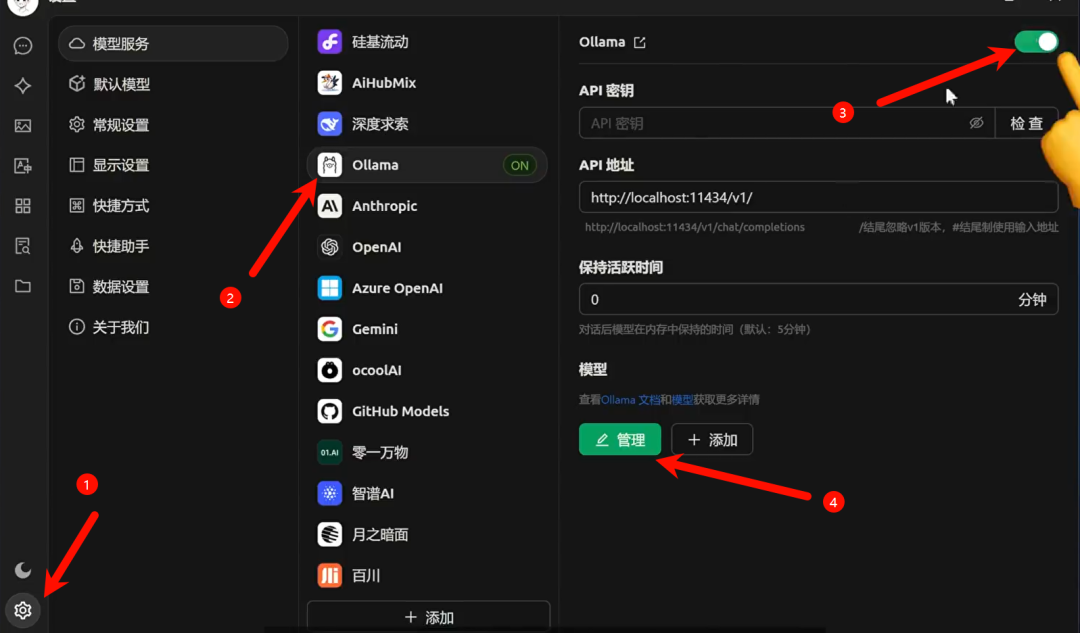

首先,到官网下载软件,安装完成后,点击左下角的设置。在模型服务中选择ollama。首先把顶部的开关打开,然后点击底部的管理按钮。

在弹出的界面中添加你刚才下载的deepseek模型。然后回到首页的对话界面,这时就可以和deepseek进行对话了。

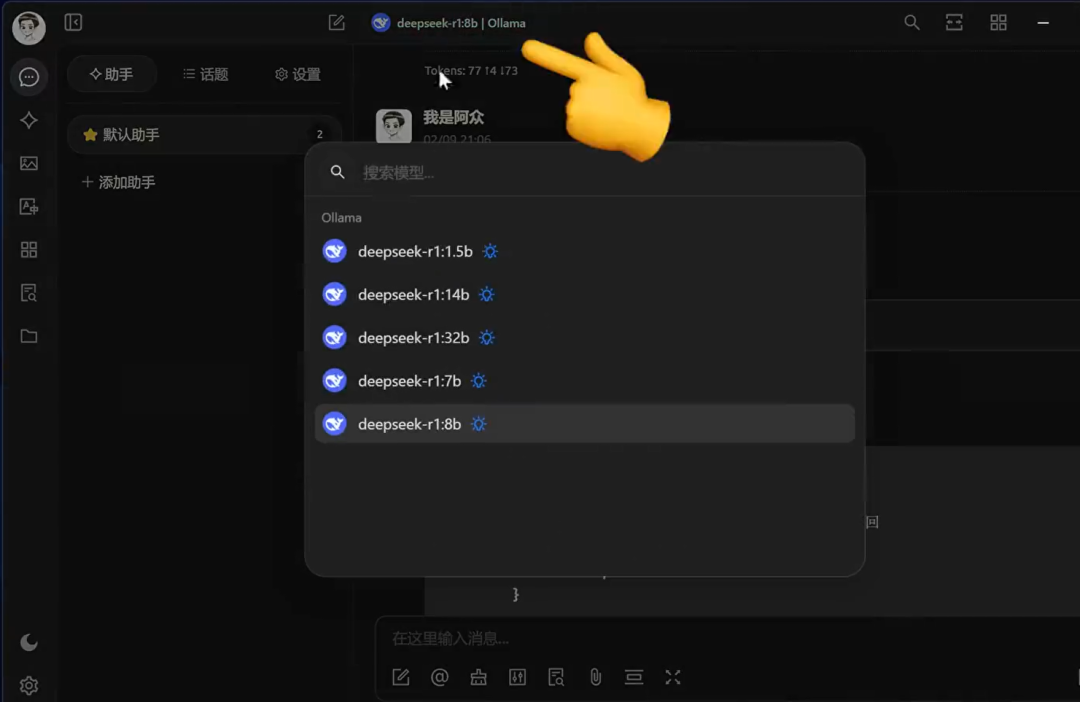

如果你安装了多个deepseek模型,也可以点击顶部进行切换。

模型测试

接下来,我们通过一个题目来测试一下模型回答的质量。题目很简单:一个挂钟敲六下要30秒,敲12下要几秒?正确答案是66秒。

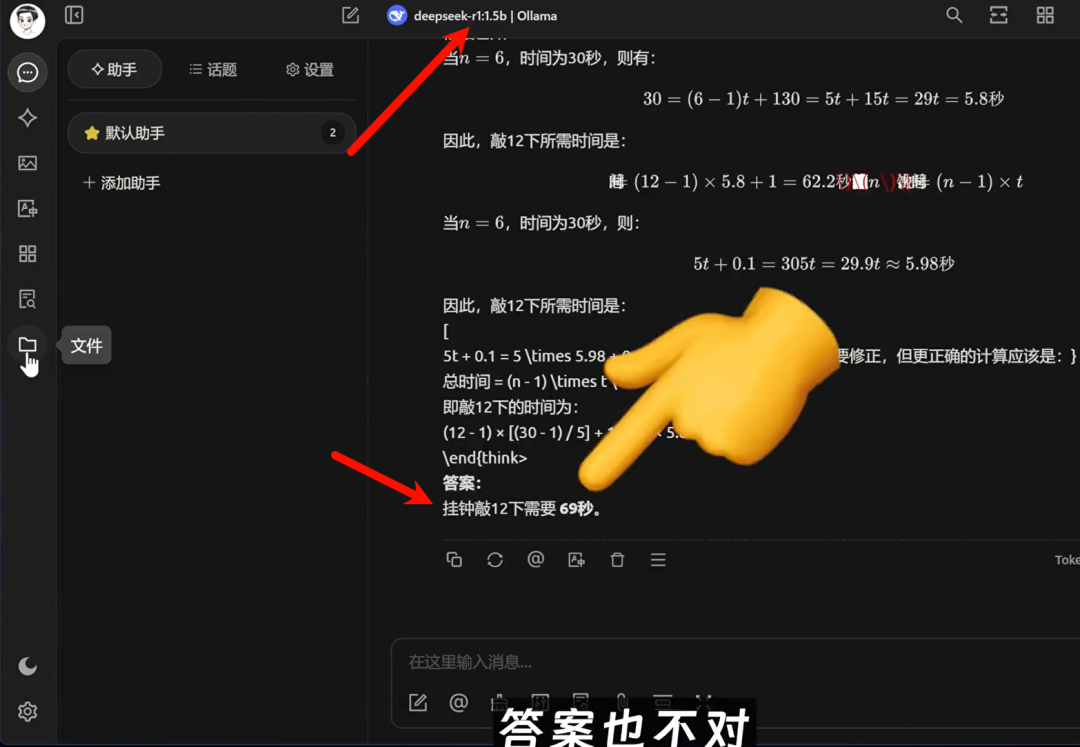

我们首先来看一下1.5b这个模型的回答。可以看到回答速度非常快,但输出的答案很啰嗦,答案也不对。

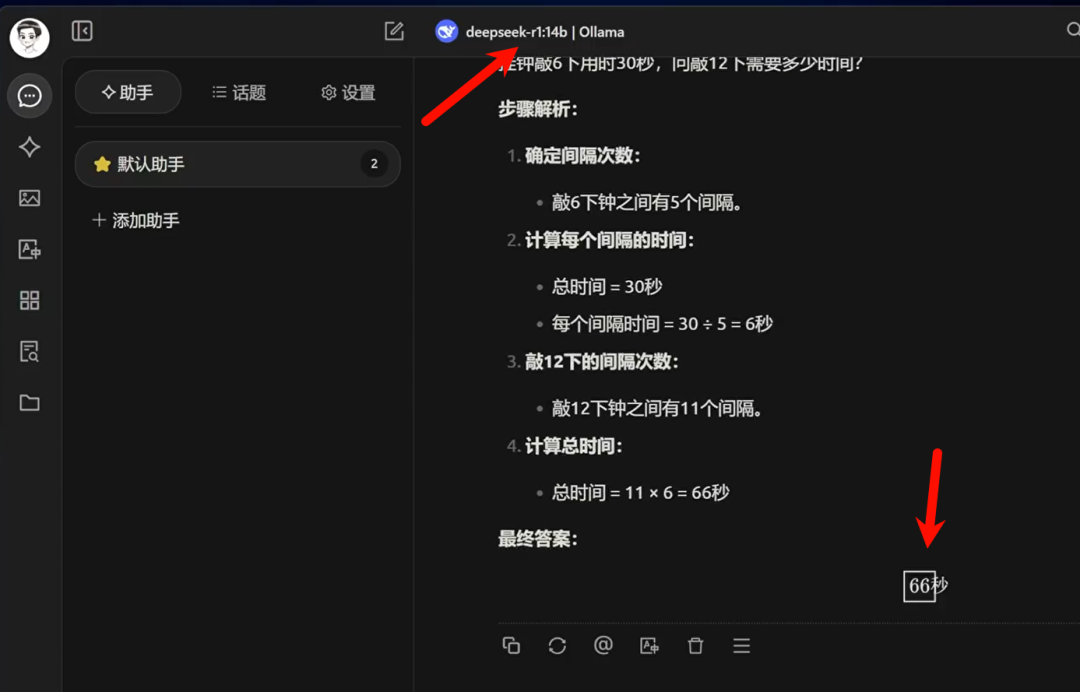

接下来再看一下14b模型的结果,回答得很简洁,且结果也是正确的。首先确定了每敲一次的时间间隔,然后计算了敲击12次总共消耗的时间。

总结

从此我们也可以得出,参数量越多的模型,回答的质量也就越高、越准确。不过,即使你使用了700亿参数的版本,它也不是官网使用的deepseek r1,因为官网使用的是671b的纯血版deepseek。

你别看他的模型大小只有400GB,要想在本地运行该模型,你至少需要4块80G显存的A100显卡。这个成本对于个人来说基本是不可能实现的。所以,我们在本地运行这些缩小版模型的意义,更多的是折腾和体验。

不过对于个人使用来说,8b或32b的版本其实已经完全够用了,特别是在断网的情况下,它依然可以正常工作,而且不会出现服务器繁忙的情况。这一点是在线版本无法比拟的。

好了,今天的分享就到这里。如果你觉得这个教程对你有帮助,记得点赞、收藏,分享给更多的朋友。我们下期再见!

原文链接:https://blog.csdn.net/simayijia/article/details/145577577?ops_request_misc=%257B%2522request%255Fid%2522%253A%252292cdf893db0455a8db40cdc64431da5e%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=92cdf893db0455a8db40cdc64431da5e&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-18-145577577-null-null.nonecase&utm_term=deepseek%E9%83%A8%E7%BD%B2

评论 ( 0 )