预训练大模型为生成式AI带来里程碑式飞跃。

2017年Transformer架构的出现改善了循环神经网络(RNN)的局限性,标志性特征是采用了self-attention机制,可为输入数据的各部分分配不同权重,支持GPT-3和LaMDA等大型语言模型(LLM)。

Transformer模型可并行训练,使GPU性能改善所带来的模型训练效果显著提升,同时可以通过不断增加模型参数量以及预训练使用的数据量来提升模型性能。

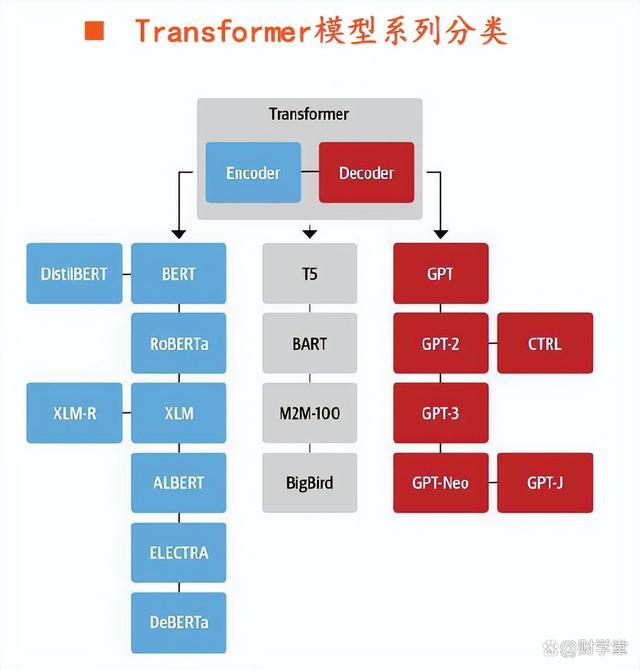

以Transformer架构为基础衍生出的典型预训练语言模型大致可以分为三类:

1)Encoder模型(以BERT为代表):又称自编码模型,适用于内容理解任务,例如需要理解输入语义的任务,例如情感分析;

2)Decoder模型(以GPT为代表):又称自回归模型,适用于生成式任务,例如文本生成;

3)Encoder-Decoder模型(以T5为代表):又称Seq2Seq模型,通常用于需要内容理解和生成的任务,例如翻译。

Transformer三条路线中,GPT模型进展较快。

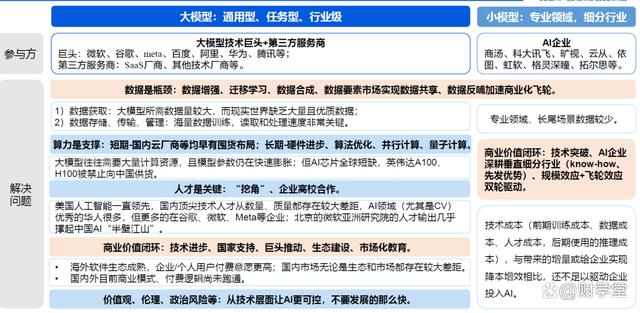

AI大模型化是过去两年内兴起的新潮流,自监督学习+预训练模型微调适配方案逐渐成为主流,AI 模型走向大数据支撑下的泛化成为可能。

以OpenAI、谷歌、微软、Facebook、NVIDIA 等机构为代表,布局大规模智能模型已成为全球引领性趋势,并形成了GPT-3、Switch Transformer 等大参数量的基础模型。

在大模型领域,以百度、腾讯、阿里、华为为代表的国内科技巨头均已布局多年。=

其中百度早在2019年3月发布预训练模型ERNIE 1.0,2023年3月推出了文心一言(ERNIE Bot)。

2021年4月,华为发布盘古大模型。

2022年4月,腾讯对外披露混元大模型。

2022年9月,阿里发布通义大模型系列。

百度文心大模型

百度率先在2019年3月发布预训练模型ERNIE 1.0,持续投入大模型的技术创新与产业应用,布局了NLP、CV、跨模态等大模型,率先提出行业大模型,构建大模型工具与平台,探索产品与社区,在企业端和用户端均有不同程度的突破。

阿里通义大模型

2022年9月2日,阿里巴巴资深副总裁、达摩院副院长周靖人发布阿里巴巴最新「通义」大模型系列,其打造了国内首个 AI 统一底座,并构建了通用与专业模型协同的层次化人工智能体系,将为 AI 从感知智能迈向知识驱动的认知智能提供先进基础设施。

腾讯混元大模型

2022年4月,腾讯对外正式宣布,腾讯“混元”AI大模型在MSR-VTT,MSVD,LSMDC,DiDeMo和ActivityNet五大跨模态视频检索数据集榜单中先后取得第一名的成绩,实现了该领域的大满贯。

华为盘古大模型

华为云盘古大模型于2021年4月正式发布,到2022年聚焦行业应用落地,已经发展出包括基础大模型(L0)、行业大模型(L1)、行业细分场景模型(L2)三大阶段的成熟体系。

某机构认为,各大巨头目前在大模型技术上基本同源,且都具有资金、算力、人才、数据等发展条件,未来有望成为我国大模型的第一梯队。

各家在应用场景上各有所长:百度具有搜索、小度智能音箱等应用场景;

腾讯具有W信、游戏等应用场景

阿里具有电商、钉钉等应用场景;

华为在2B应用方面独具优势。

未来各家将结合自身优势,发力大模型研发及应用落地,我国的大模型产业将迎来快速发展阶段。

除此以外,大模型带来了大算力的需求,其主要包括:AI芯片、AI服务器,交换器、光通信中CPO、光纤、光芯片以及IDC和冷液等。

(汇总相关企业,非推荐,有些企业还出现了穿插)

百度大模型相关:汉得信息、东软集团、宇信科技、致远互联、软通动力、银之杰、风语筑、掌阅科技、蓝色光标等。

阿里大模型相关:恒生电子、千方科技、石基信息、众信旅游、卫宁健康、金桥信息等。

腾讯大模型相关:博思软件、世纪华通、掌趣科技、常山北明、四维图新、泛微网络、长亮科技等。

华为大模型相关:常山北明、拓维信息、特发信息、润和软件、神州数码、宝兰德、创意信息、科蓝软件、软通动力、赛意信息等。

重要提示:股市有风险,入市需谨慎!以上内容仅供投资者参考,仅出于传播财学资讯的目的,不作为投资决策的依据。

举报/反馈

原文链接:https://baijiahao.baidu.com/s?id=1761520918007709481&wfr=spider&for=pc

评论 ( 0 )