AI GC text to pic 图像生成模型

目前随着AIGC模型的火爆,AI内容创作远超人类创造水平和能力,极大了提升了创作空间。

为此我们要接触新鲜事物,用于尝试新技术。

那针对目前火爆的AImodel我们开始进行学习,尝试本地化部署,生成自己的模型。

先感性的认识下模型的基础知识。

一、AI模型的基本介绍

什么时大模型/底模型,VAE模型和微调模型/fune tuning

大模型/底模型:Stable diffusion:V1.4/v1.5/v2.0/v2.1都是大模型,泛化性通用性好,大模型自带VAE模型,不额外挂在

VAE模型:图形生产的最后为我们解码成可是图形的必备模型,有些大模型会内嵌

微调模型:在大模型基础山的微调模型,可选的,可以特定生产图像

LoRA/Embedding/Hypernetwork:是特定领域图形的微调模型

Dreambooth:是训练后的大模型

Checkpoint: 模型是某一特定训练后保存参数的模型,某一阶段的模型版本

即checkpoint = 大模型= dreambooth

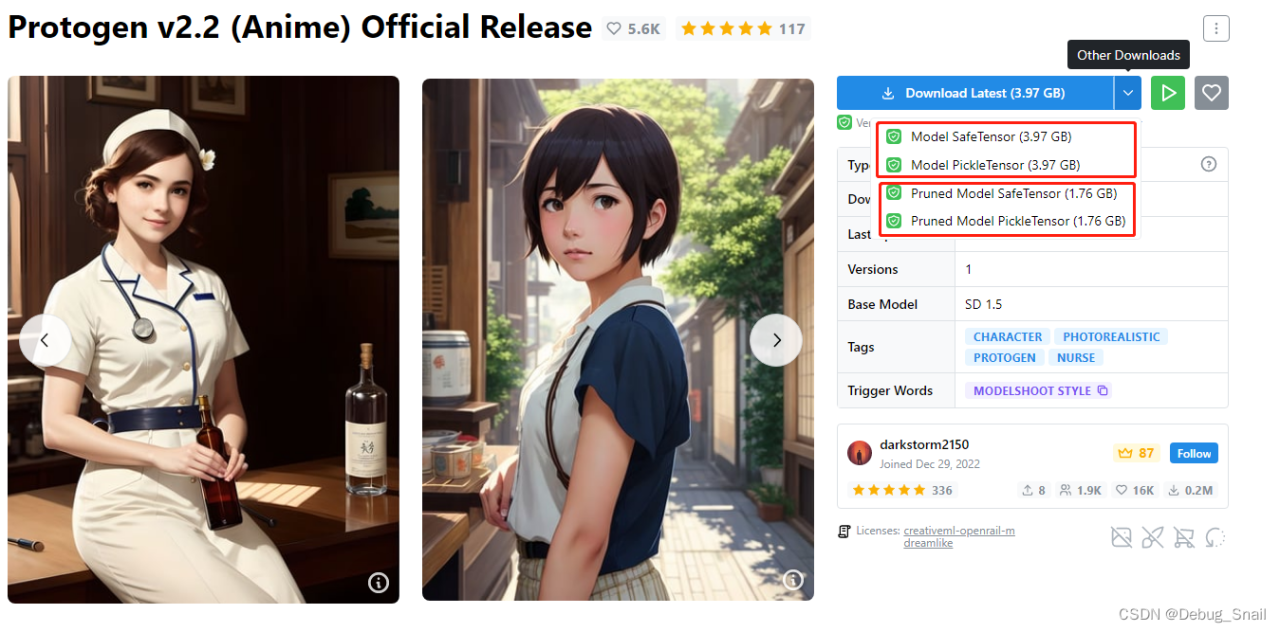

二、模型后缀

safetensor.以.safetensors为后缀,加载速度快,更加安全

pickletensor以.ckpt为后缀,开源,但可能存在恶意代码,加载速度相对较慢

pruned:剪枝模型,存储小,效率搞,优化后的神经网络

ema:泛化能力强,优化后的神经网络模型

ft/fp: ft16/ft32标识模型精度,推荐ft32

三、stable difussion webui

ComfyUI:https://github.com/comfyanonymous/ComfyUI

原文链接:https://blog.csdn.net/Debug_Snail/article/details/129925035

评论 ( 0 )