最近Ai闹得沸沸扬扬,吵着Ai未来取代设计师的趋势不绝于耳。那么事情真的是这样吗?最近我们尝试使用了市面上最火的两款Ai绘图软件,Stable Diffusion和Midjourney。

他们确实解决了设计师的部分问题,但是要取代设计师还有很长的路要走。接下来我就给大家说一下这两个软件哪个更适合专业的设计师吧。

Midjourney

优势:上手简单、生成图像容易

缺点:科学上网、付费、图像可调性比较低

Stable Diffusion

优势:开源、图像可定制、可操作性高、无需科学上网、无需付费

缺点:上手难度相对高、需要不停地训练

用网友的话来说,Midjourney是苹果,一切都是傻瓜化的操作,下限高。而Stable Diffusion是安卓,需要自己配备环境,开源用起来更自由,但是上限高。

| 区别 | Stable Diffusion | Midjourney |

| 费用 | 免费 | 每月10-60刀 |

| 擅长 | 擅长指令创作,优化细节 | 图片构图丰富 |

| 上手速度 | 中高 | 低 |

| 生成优质图片难易程度 | 难 | 易 |

| 填充修复 | 是 | 否 |

| 负面提示 | 是 | 是 |

| 控制构图和姿态 | 是 | 否 |

| 版权 | 自有版权 | 取决于充了多少钱 |

| 制作自己的模型 | 是 | 否 |

| 模型类型 | 开源且配合大模型、lora模型、VAE模型、嵌入式模型、超网格模型搭配使用 | 专有模型 |

| 风格 | 可自定义 | 艺术风格多 |

| 参考制图 | 可通过controlnet插件进行相对精确化制作 | 根据专有模型和描述词制作 |

| 图片作为提示 | 否 | 是 |

| 图片生成图片 | 是 | 是 |

| 图片生成视频 | 是 | 否 |

| 插件多样性 | 多 | 少 |

该如何选择?

目前来说小白更适合Midjourney,开发人员负责模型开发、训练、调整、和用户界面。让用户的操作门槛极低,比较适用于一些简单作图的需求。不需要深度学习,只需要几个单词就可以生成丰富多彩的图像。

而如果你是设计师,需要专业可编辑的图像,推荐使用Stable Diffusion。它是一个开源可本地部署的软件,模型的代码和训练数据可供所有人访问。可以构建和微调,达到你想要的效果,自由性更佳。

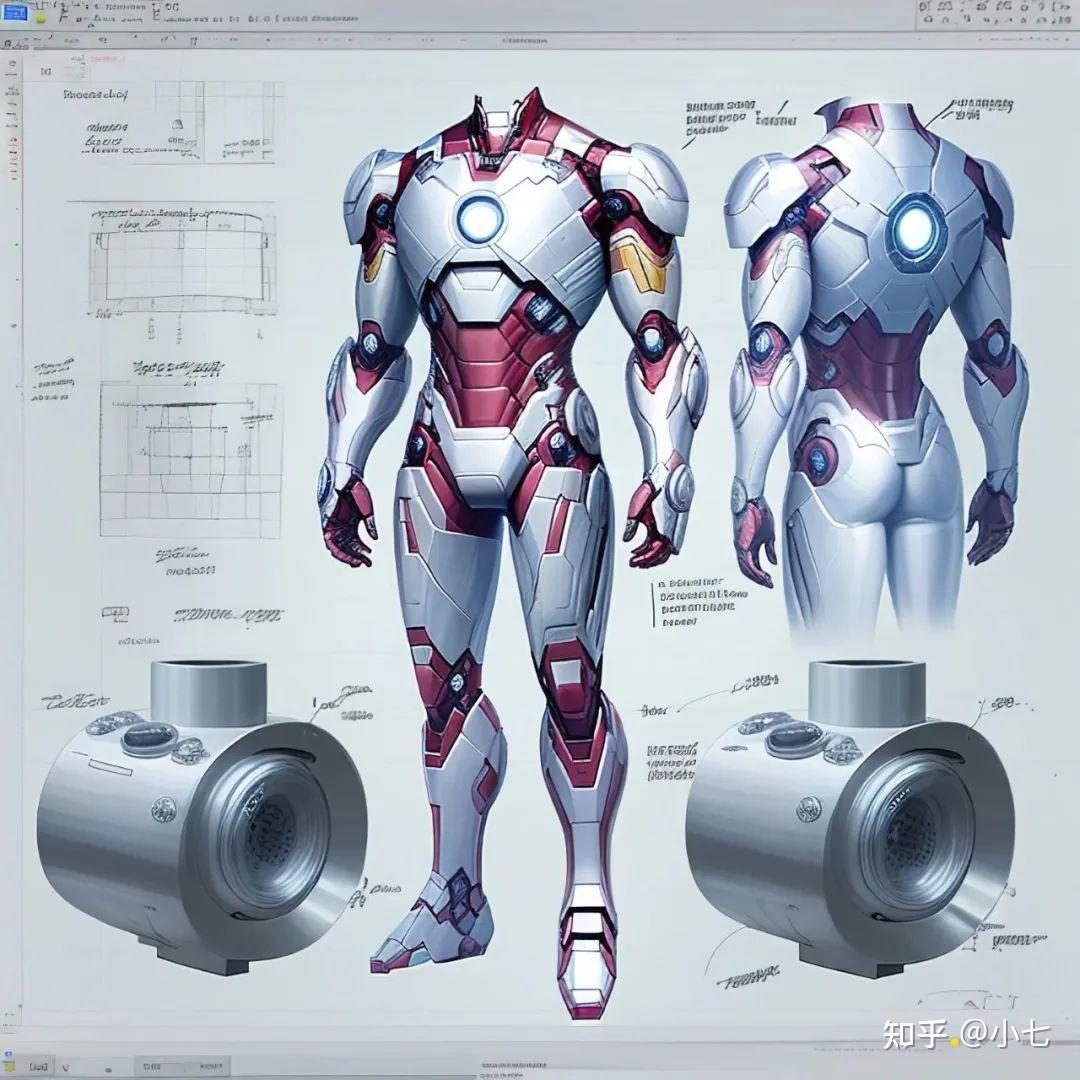

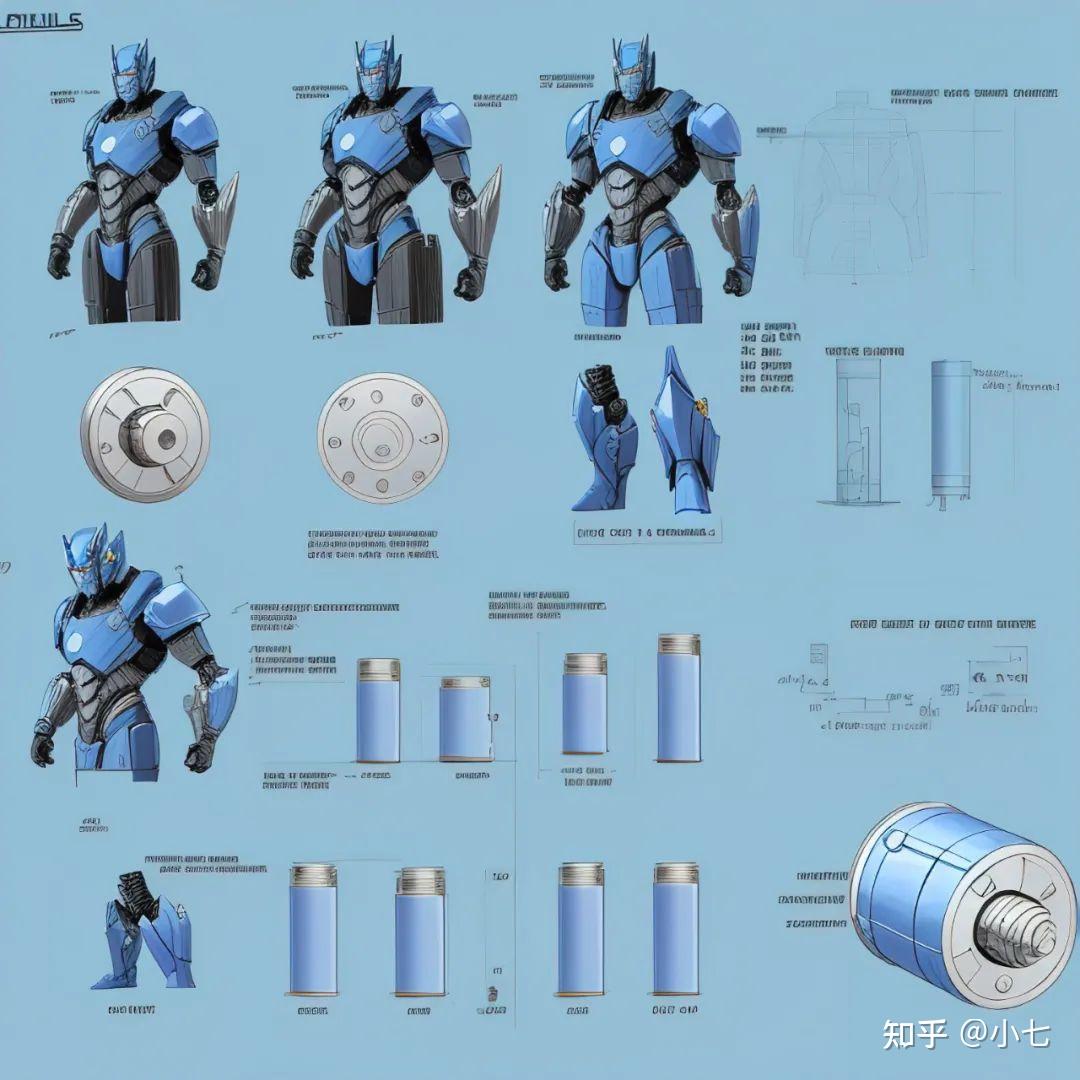

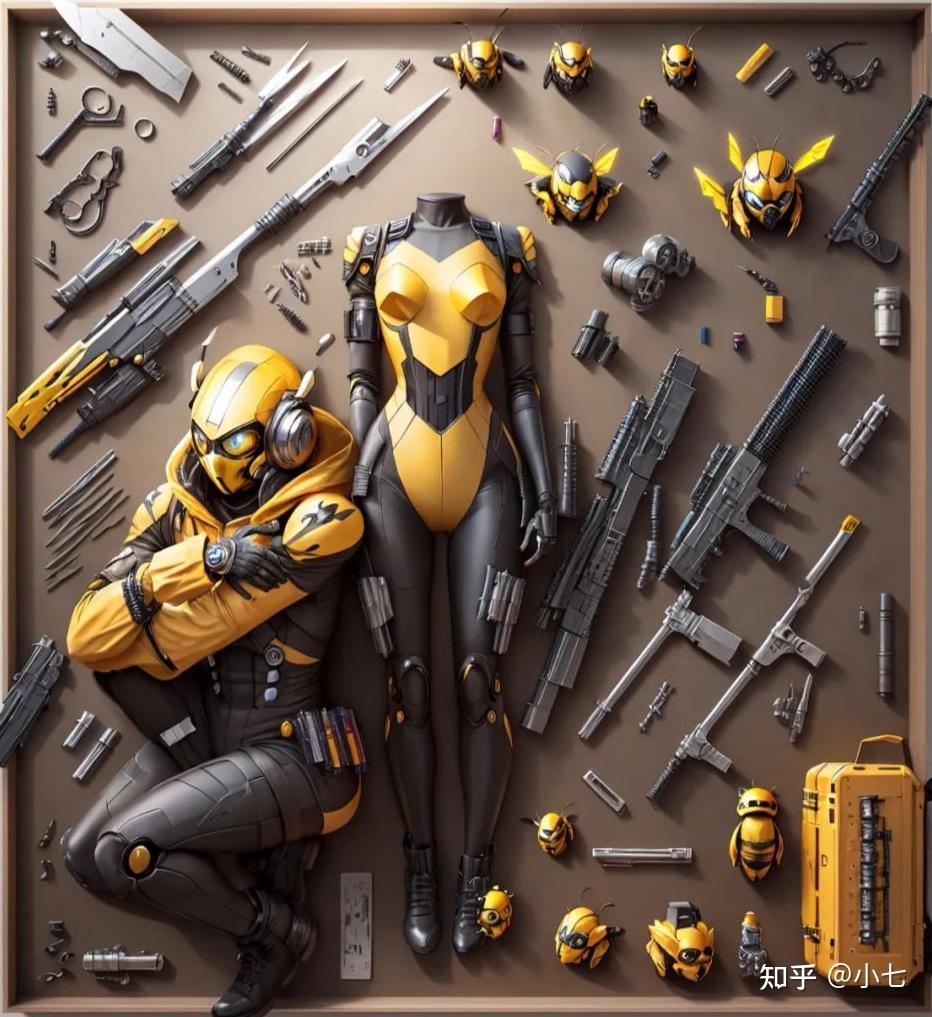

下面是我用Stable Diffusion制作的一些图,大家可以电脑操作一下。

大模型:机器人、人等

关键词:

Optimus Prime suit,costumes and mechanical parts,knolling,knolling layout,highly detailed,depth,many parts,lumen render,Various parts,Many weapons,Hand operated components

Negative prompt: lowres, bad anatomy, bad hands, text, missing fngers,extra digt ,fewer digits, wort quality ,low quality,normal quality, jpeg artifacts,watermark, blurry, bad feet

Steps: 30, Sampler: DPM++ 2M Karras, CFG scale: 9.5, Seed: 2392698361, Size: 1024×1024, Model hash: d725be5d18, Model: revAnimated_v11, Clip skip: 2

原文链接:https://zhuanlan.zhihu.com/p/620741988

评论 ( 0 )