今天来说一个扎心的话题,ChatGPT 对 NLP 产业、以及 NLPer 们的影响

希望 NLP 从业者和还在院校读 NLP 方向,或者泛 AI 方向的相关从业人员,都认真考虑今后的发展。

先说结论:

从某种程度上讲,ChatGPT 会颠覆以往的 NLP 行业的生态。它不会带来 NLP 产业的繁荣。

今后,以 NLP 子任务领域独立研究和开发的项目都将逐渐消亡,仅仅留下极个别具有超大规模的数据和算力的公司。

它就像三体一样,像水滴一样,对整个NLP 行业进行了降维打击。

这虽悲观,但并非绝路,先别急,容我慢慢展开讲。

2022年以前的 NLPer 都在干什么?

NLP 工程师们

在2022年11月30日之前,市面上有大大小小的互联网或IT企业需要进行文本处理,相应地,也就需要雇佣大量的 NLP 工程师们来解决相关的问题。

绝大多数的 NLP 工程师们所做的工程项目,主要是针对某些特定任务提出一个具体的模型,进行有针对性的数据标注,然后再制作模型。简而言之,就是以 NLP 子任务独立进行研究开发。比如分词、实体识别、文本分类、相似度判别、机器翻译、文摘系统、事件抽取,等等,不一而足。

比如,一个公司需要做一套舆情监控系统,那么 NLP 工程师需要做的工作包括文本分类、关键词(短语)抽取、实体识别、事件抽取、文本聚类、相似度判别等等模型或模块。

这些任务,要么以小模型如 fasttext 完成;要么以 预训练+finetune 模式完成;而对于一些数据过于稀疏,本身过于小众的任务,就直接采用规则和解析的方式来做。

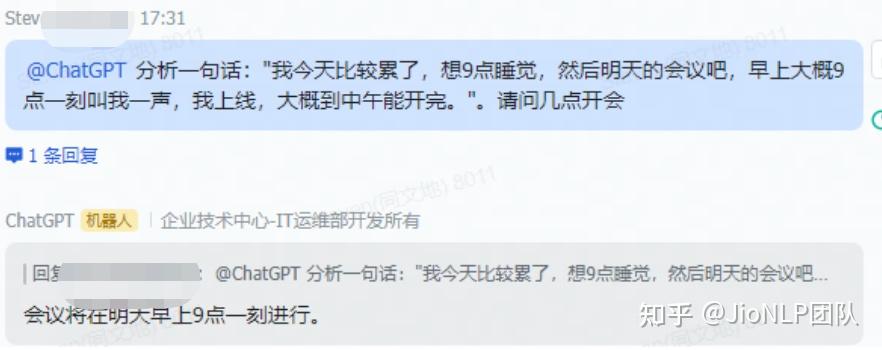

需要指出的是,NLP 的任务,除了前述的若干传统研究方向以外,还包括大量的十分小众的任务,比如,根据下面的一段话,模型需要返回应当几点通知用户参会:

我今天比较累了,想9点睡觉,然后明天的会议吧,早上大概9点一刻叫我一声,我上线,大概到中午能开完。

针对这种小众任务,传统 NLP 手段处理这种问题是比较困难的。

另一方面,NLP 的工作还以数据领域进行了区分,比如,针对医疗文本领域需要定制一套实体识别系统,用于识别药物、疾病、诊疗日期等实体类型;而针对法律领域,则需要定制另一套实体识别系统,用于识别所犯罪行、量刑年限、罪犯名称、原告、被告等信息。两个模型完成的功能相似,但却并不能互通使用。

也就是说,NLP 产业界实际上处于一种手工业模式,你干你的,我干我的,针对不同的企业、不同的需求,需要不断地定制模型、定制数据来完成工作。每一个定制需求都需要人力,从而涌现出大量的 NLP 公司和从业者。

另外,NLP 中,还有一部分内容:知识图谱。知识图谱这个概念专门用来记录现实世界中的客观存在的事务的关联关系,对于 NLP 任务也极为重要。更准确地讲,应当叫做领域知识图谱,几乎没有哪个机构可以做出一个通泛的图谱来供应用。

但知识谱图属于有多少人工,就有多少智能的最典型代表,据我所了解,在各个互联网大中小厂的一些落地应用中,几乎找不到正面典型,反而各种失败的尝试不可计数。

接下来再说说科研界。

NLP 科研人员们

不客气地讲,早在两年之前,谷歌和 OpenAI 开启了大模型军备竞赛之后,除了百度等少数大厂,还能跟上发展的脚步,科研院校很大程度上已经跟不上 NLP 领域最先进的技术了。

AI 的发展就像资本主义,从过去自由、粗放、百花齐放的竞争,谁进来都能插一脚,逐渐在向高度垄断发展。

过去很多国内外的头部、非头部科研机构发表了大量的论文,也有数据统计,在过去几年 AI 行业暴发式增长的前提下,相关的论文发表数量呈现出井喷式增长:

注意:图中标识的是顶级会议期刊论文,那么数量庞大的一般性论文,则不计其数。

之所以国内外涌现出数量庞大的 NLP 或 AI 科研机构,关键原因是因为,以往的模型不需要消耗太多的 GPU,不需要花费太多的钱,科研经费还能养活的起。

相信不少研究生也都了解,为了毕业、找工作,导师为了业绩、评职称,被迫写出了许多水平参差不齐的论文。

绝大多数论文,还停留在针对 NLP 特定任务,优化改进策略上。但已经被头部的科研机构甩开了好远。

ChatGPT 带来了什么?

ChatGPT 的功能强大,大家应该有目共睹。它几乎洗刷了原先 NLP 产业界手工作坊式的生态。

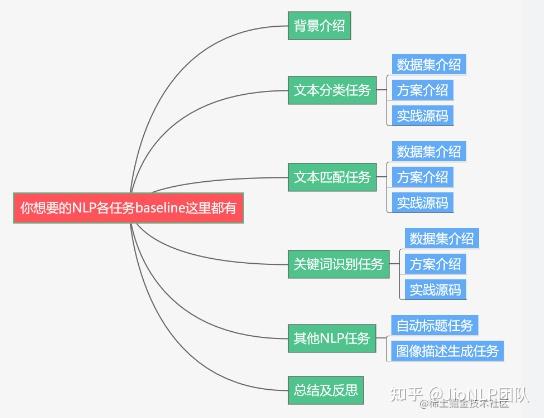

原先分不同的 NLP 子任务方向,我们统称传统 NLP 任务,现在 ChatGPT 完全可以全方位 cover,我们来看几个例子:

ChatGPT 在传统 NLP 任务上的表现

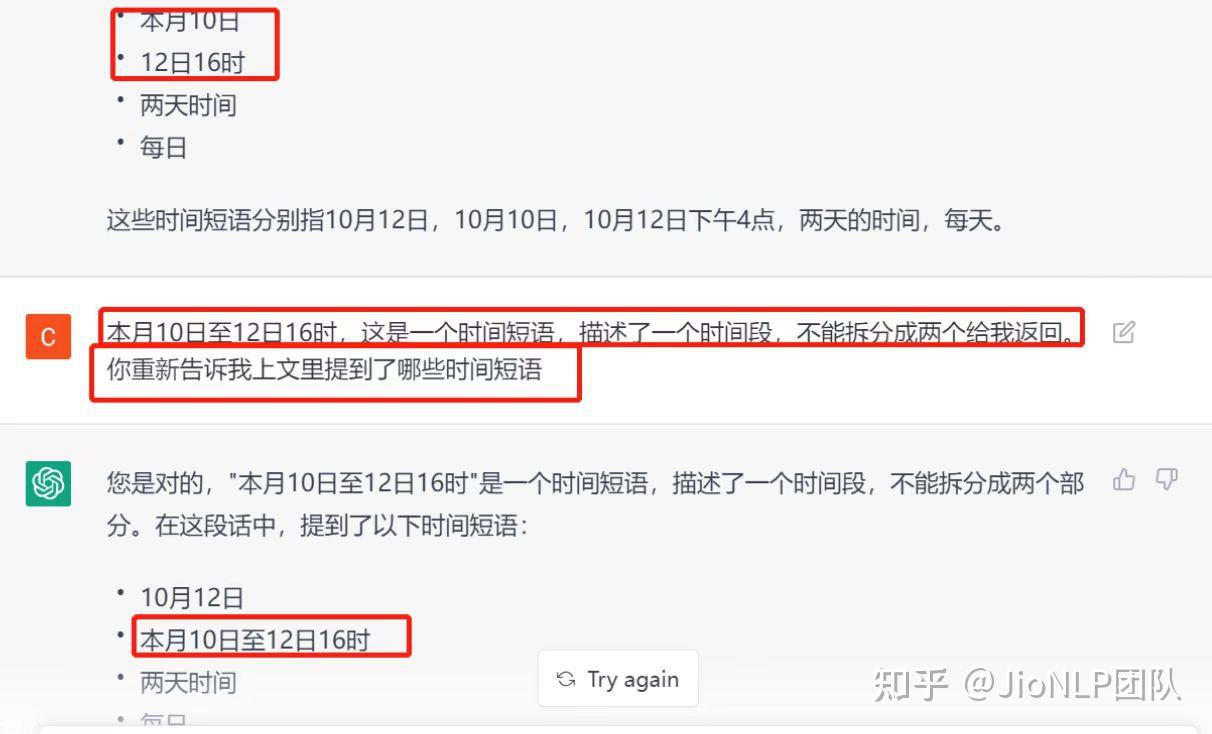

- 时间实体抽取

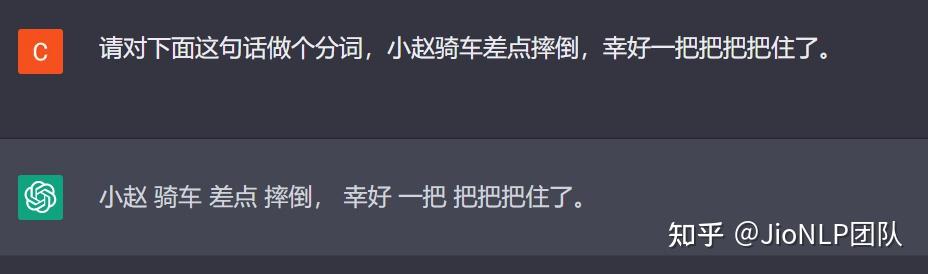

- 分词

这里 ChatGPT 分词搞错了,但是这个特例,传统分词工具同样很难处理。

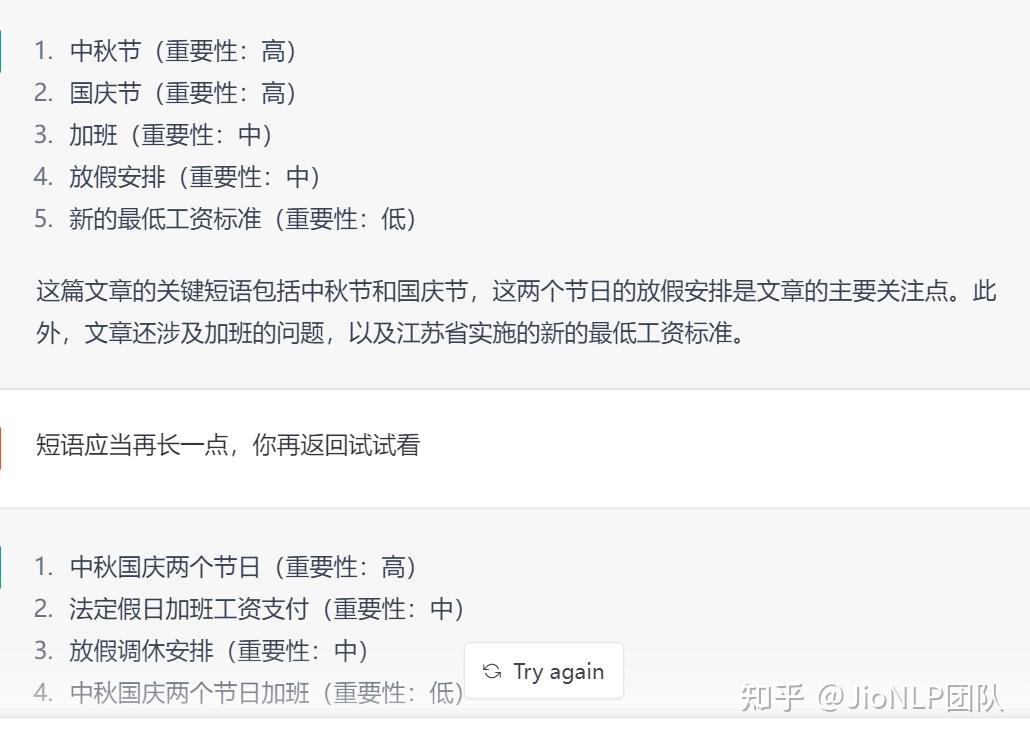

- 关键短语抽取

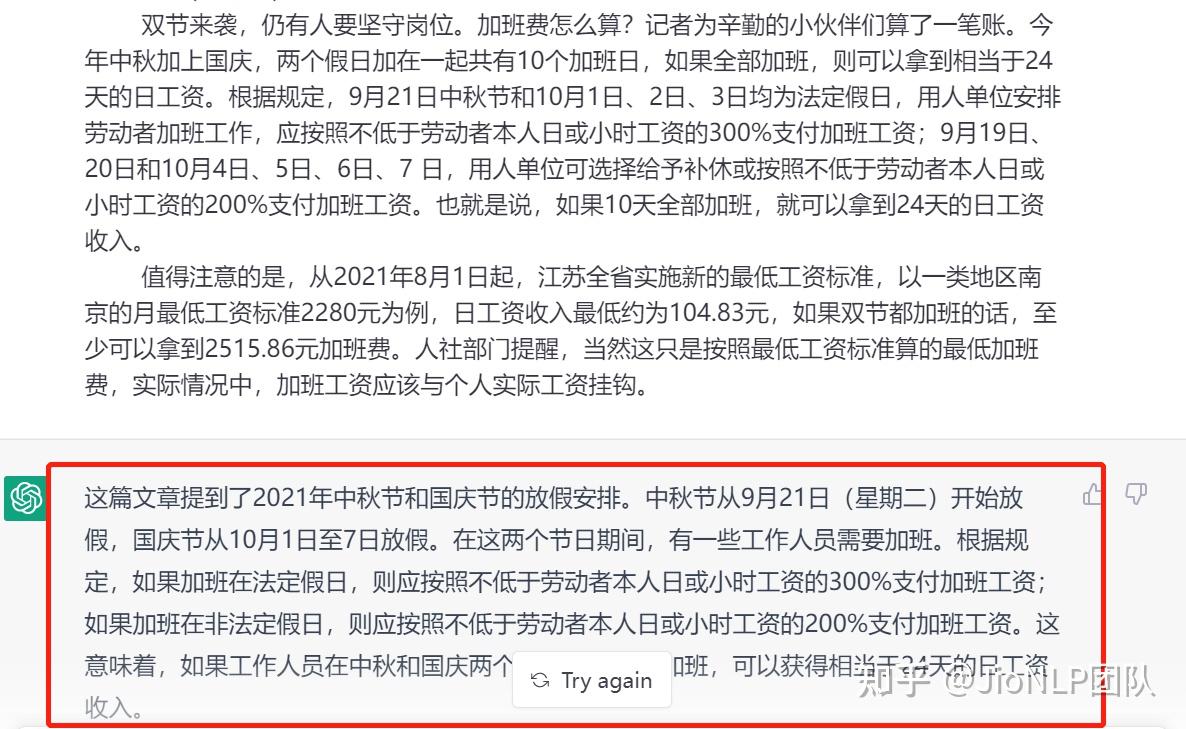

- 文本摘要

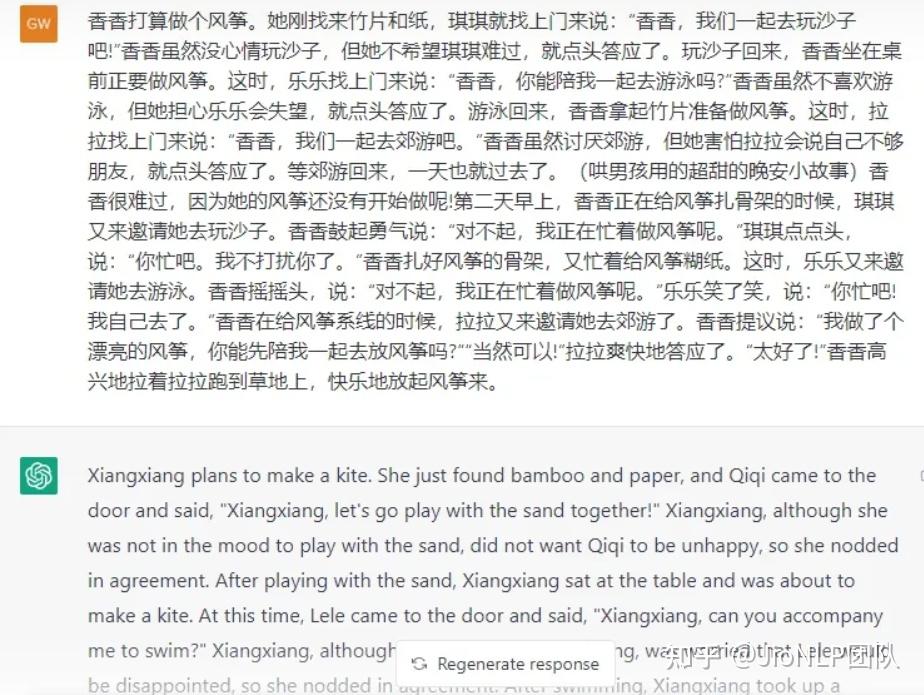

- 机器翻译

这个效果基本上已经将传统 NLP 任务卷下马了。试问,还有多少传统 NLP 任务能够超越 ChatGPT?

还会有人问,ChatGPT 的返回结果并非结构化的,而实际程序设计和抽取中,需要返回结构化数据,这个很好办,我们只需要告诉 ChatGPT:

返回结果时,请按 json 格式返。 返回关键短语时,以英文逗号隔开。 返回实体信息时,标明其类型名字,一行一条结果。 ...而对于前文提到的一个理解并返回会议时间的问题,ChatGPT 手到擒来。

此外,ChatGPT 天然具有 Prompt 能力,完全可以胜任各种奇奇怪怪的用户诉求。这里就不展示了,互联网上大家尝试过太多。

NLP 还是人工智能皇冠上的明珠吗?

评价 NLP 模型的效果,应当从两方面入手:

一方面,是评价模型对自然语言本身的拟合,比如,前后语句连贯、通顺、符合正常人类的叙述习惯,能够理解反问、反讽、情绪、基本世界观的构建和逻辑推断。客观讲,ChatGPT 已经做到了极致,它的语言表达水平,比很多人的作文能力都强非常多。

另一方面,是评价模型对知识、事实类信息的拟合,这块能力 ChatGPT 是无法很好胜任的,比如模型会告诉我3+13=23,汪小菲的姐姐是大S,谷歌的CEO是库克,等等,大家也都明白,大量的博客、文章、段子,讨论过很多了,不再赘述。

目前来看,这些事实、知识,就是由知识图谱来解决的。

我个人认为,目前知识图谱,以笨拙的实体、关系、属性等为基本概念所作的构建是错误的,在产业界也是基本失败的。但是,它确实是为数不多的依然值得继续研究的领域,因为这是 ChatGPT 处理不了的领域。

当然,我同样不乐观,ChatGPT 模型具备了 prompt 能力,即时学习能力很强,如果把准确的知识告诉模型,它能够组织一套语言,以标准答案提供出来。

针对 ChatGPT 对狭义上的语言的操纵能力,NLP 这颗明珠的光泽要暗淡一些了。(纯个人主观观点)

ChatGPT 如何影响 NLP 工程师们

当然了,ChatGPT 并不是一个完美优质的 LLM 模型。

但可以得出结论,ChatGPT 已经完全抹去了传统 NLP 业态中,需要分不同子任务、分不同领域数据场景的手工业模式,而是直接采用大模型,以对话形式,直接形成了大一统,进入了机器时代。

ChatGPT 对 NLP 业态的改变,类似于传统的手工纺织女工,完全由机器替代了。 当然,会有很多纺织女工(NLP 工程师)表示,ChatGPT 造价昂贵,成本高昂,中小公司用不起,很难形成规模应用。 Too naive,蒸汽机刚诞生时,价格也是十分高昂的,但是生产力的发展从来都不会因价格而停滞。

现在大家畅想一下:

假设我们有一个超级AI大脑,可以进行各种问答、执行各种接口的控制,事实上,全世界,仅需要一个就够了。剩下的事情就是复制、复制、再复制。

是的,对于一个企业,需要应用 NLP 技术完成功能,向 ChatGPT 购买接口就可以了,不再需要雇佣工程师来完成工作。

随着时间的推移,这个购买价格会逐渐趋于一个稳态:购买接口的价格要大幅度低于雇佣 NLP 工程师,但 OpenAI 或谷歌等巨头依然能够获得巨额垄断利润。

当然,调用接口意味着暴露数据,存在数据安全性问题,这会给 NLPer 们留下不多的生存空间。

人工智能头上始终悬着达摩克利斯之剑——黑盒不确定性

靠概率完成的模型,永远会在概率上输一筹,调用 ChatGPT 接口获取 NLP 能力,输出错误结果,导致经营亏损,这个锅该谁来背?

值得庆幸,能够背锅,才是工程师们的核心竞争力。

ChatGPT 如何影响 NLP 科研人员们

ChatGPT 的算法原理十分高深复杂吗?其实并没有。大家看了原理文章,并不难理解。但这样的模型很难做出来。

制作这样的一个模型,OpenAI 、微软、谷歌都已经通过公开的论文,教会了我们,至少在目前看起来,参数超级庞大达数千亿,GPU 显卡集群超级庞大达数千块,文本数据量多达上万亿。甚至今后的发展还要更大。这些统统都需要钱。

换句话讲,目前看,NLP 领域的科研就是需要有钱,有钱,还是有钱。这个门槛死死地卡住了绝大多数(甚至说是几乎所有)的科研院校的师生,大家只能紧紧跟上最新的技术发展,而无法真正参与其中。

说句扎心的话,人工智能领域的比拼,从来都不是在比谁的算法更优,论文更多,论文发表的期刊更牛。真正比拼的就是投入的钱,GPU显卡支撑的算力、互联网带来的高质量的数据。

论文,包括高水平论文,从来都不是人工智能领域真正卡脖子的关键节点,算力和数据才是。否则,最高精尖的论文根本不可能公开发表,让全世界看到。

paper is cheap, show me your model.

更何况,深度学习科研一直都被诟病,模型假设过于特殊,黑盒模型始终不可解释。很多论文发表出来,更像是一篇宣传稿,而不像是一篇有深度的学术报告。

人工智能的发展,会结束过去科研机构遍地开花,不论什么高校都要开设几个 NLP、CV 实验室的时代;进而开启一个巨头垄断的时代。它的发展会像 Nvidia、台积电、ASML、日本高精钢铁一样,全世界仅此一家,独门生意,别无分号。你想开设分店,需要前期投入百亿、千亿、甚至万亿的巨额财富。

好在,科研机构是受到国家保护的,教授、副教授们即便技术能力已经被淘汰,但是国家依然会养着,这是体制的巨大能量。那些不被体制保护的研究者们,将直接面对风雨。

数据之痛

算法的训练依赖数据,我遇见过某些算法工程师、科研人员对处理数据、分析数据是极其厌恶的,认为这是 dirty work。但 ChatGPT 告诉我们,大规模的数据,高质量的标注数据是极其重要的。

百度拥有最全面的中文互联网数据,如果有一家中国企业能够制作出 ChatGPT,那首推百度了。但近些年,百度的贴吧作为一个内容生产入口,却逐渐凋敝,不再具有竞争力。内容平台被逐渐分流至其它互联网平台上,比如知乎、豆瓣、微信、抖音等等。然而各个垂直领域的互联网平台仅仅占据了某些数据,事实上很难形成一个大而全面的数据合集。这也会影响国内 NLP 行业的发展。

同样地,标注数据的质量不足也是十分突出的问题。在绝大多数 NLP 从业者的印象里,不论是否承认数据的重要性,标注数据就是 dirty work,是招聘几个中专、初中学历的外包、临时工来完成的工作。

而 ChatGPT/InstructGPT 告诉了我们,标注数据,非研究生、工程师干不了。数据标注被提到了一个极高的高度。

举一个最简单的例子,ChatGPT 可以帮助程序员找 bug,那么,人工判别模型生成内容是否准确有效,标注人员本身必须懂得如何手动操作修改 bug,没有受过良好教育的人是无法胜任标注工作的。

InstructGPT 论文中,详细讨论了数据是如何标注的,它们培训了标注人员标注的准则,统一了不同语言、不同性别、年龄的标注人员的标注标准,对数据进行了反复的矫正和检验。

总之,系统化地获取高质量数据的成本也是非常高昂的,这同样意味着一般性的企业和科研机构无法触及到这部分数据。

NLP 的科研将变成一小撮人从事的工作,其他人都会随着时间被甩开。

ChatGPT 不会带来 NLP 行业的繁荣

怎样才叫繁荣

记得当初谷歌释出 Bert 模型不久,当时算法组里的同事就能够运用 Bert 模型实现了实体识别的最优效果。毕竟,Bert 不需要耗用太多的显卡,不需要花太多钱;以往标注的数据依然可以套用在 Bert 模型基础上。以往需要 RNN +CRF 单独实现实体识别模型,只是之后在使用 Bert 来实现这些模型。

可以讲,Bert 模型是激活了各个大中小厂的 NLPer 们的工作能力,各个科研院所也都有能力在其基础上进行创新发展。NLPer 们还算是迎来了春天。

Bert 引领的时代,就像是黄道婆改进了纺织女工的纺织工艺,让女工们织布更快、更好了。女工们(NLPer们)很高兴。

但 ChatGPT 完全不是这样。

ChatGPT 做了什么

ChatGPT 已经将 NLP 进化到了一个绝大多数从业者都玩不起的程度。它的出现意味着除了头部搞 LLM 的若干工程师,大家都没得玩了。全世界只需要这一个模型,然后不断调接口就够了。

就像电影《黑客帝国》演的一样,AI 是可以复制的,如果世界上存在一个优质的 AI,我们唯一需要做的就是将其复制一下,而不是重新制作另一个。

当然,ChatGPT 模型的推广是需要时间的,接下来的近几年内,NLP 产业需要时间来让大家适应 ChatGPT 带来的革命。NLPer 们手头的工作,将随着时间一点一点被替代。

这就是用蒸汽机替代纺织女工。并非100%的女工都被替代,还是会留下一些被雇佣来操作机器的。

NLPer 们该怎么办?

AI 行业存在一个困境,如果 AI 发展不够完美,那么 AI 的产业落地存在困境;如果 AI 发展的还算完美,那么,AI 从业人员就丢了饭碗。

NLPer 们,ChatGPT 出现了,你们还打算继续做手头的研究吗?研究的效果可以另辟蹊径打败 ChatGPT 吗?

如果不能,是否打算去做 LLM(大规模语言模型)?打算去什么样的企业去做?

残酷的现实摆在面前,能够支撑大规模语言模型训练和研究的企业,全世界究竟有几家?

是的,制作 ChatGPT 模型的 NLP 工程师,把全世界其它的 NLP 工程师和科研工作者的工作机会,卷没了。

1、瞄准 ChatGPT 的缺陷

ChatGPT 绝不是完美的,也称不上强人工智能。我们能做的,就是朝着接下来的演进方向继续前进。到底有哪些研究方向。

这个工作就要交给全世界的互联网巨头和科技巨头来完成了。如何让大型对话语言模型能够融合自家的数据,形成有效的生产力。

最近很多人都在焦虑,ChatGPT 将替代程序员,吧 Stack Overflow 卷下台。我认为把 Stack Overflow 直接干死完全不可能。

举一个例子,我写了一个程序,出了一个我解决不了的bug,但程序的相关文件多达三十多个,我也不知道到底是哪里出了问题,有的长文件代码量多达数千行。这么大体量和复杂度的程序,ChatGPT 自然无法帮助我解决 bug。

互联网上的数据复杂度也相当高,大模型的对话建模方式我个人认为依然是存在局限的。

2、私域模型

如果 NLP 业态最终将发展为全世界的公司都去调取 OpenAI 的接口来直接获取 NLP 能力,那么,如果 OpenAI 搞技术封锁,或者自身的业务对数据安全性有极高的需求,这依然是突破内卷的好方式。

复制不管用,那就得自己重新造另外一个 ChatGPT 模型了。

3、转向算力

超大规模的人工智能网络模型,极度依赖 Nvidia 显卡,而中美贸易战,美国已经向中国禁运这些高技术产品。这样一来,中国就被卡了脖子。

算力是基础,如果能够转向研发芯片、汇编、CPU、GPU等等。也是非常好的选择。当然了,长期看,从 Nvidia 得出的结论,算力依然是一个一家独大的垄断产业。

量子计算机,前景非常美好,现状评价不了。

4、转向数据

数据的重要性可以说十分重要,但凡制作大模型,都需要依赖海量的数据,如果能够掌握数据入口,掌握内容和流量,依然是个非常稳固的靠岸基地。

数据,实际上就是互联网一直在玩的东西,谁掌握了数据,谁就掌握了内容,掌握了流量,掌握了互联网。

5、prompt 工程

有的人会想到,充分利用模型来实现功能,需要有优质的 prompt 来进行引导。但我个人感觉,这个工作确实重要,但它实在很难成为 NLP 工程师和从业人员们的一个从业门槛。

结束语

在这个信息时代,发展极快,互联网的起起伏伏,人工智能行业的起起落落,也不只是一两次了。作为一个 NLP 相关从业人员,我们需要放平心态,坦然面对。

当然了,NLP 业态的改变不是一朝一夕的,接下来几年,让我们逐步见证 NLP 手工业 到 NLP 工业 的变迁。祝愿各位 NLPer 都能找到属于自己的一片天。

—————————–

今天开始,GPT4 出来了,OpenAI 的组合拳非常像,它把语言当作一种交流接口,把 CV 领域的各种定制化工作也全都卷死了,我的看法如下:

(以上均为个人观点,欢迎关注JioNLP公众号)

原文链接:https://www.zhihu.com/question/571460238/answer/2889630802

评论 ( 0 )