多实例gpu_MIG技术快速提高AI生产率

Ride the Fast Lane to AI Productivity with Multi-Instance GPUs

一.平台介绍

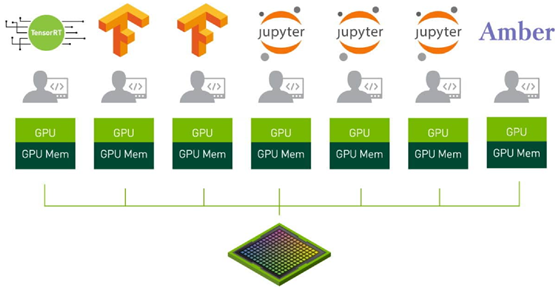

NVIDIA安培架构中的MIG模式可以在A100 GPU上并行运行七个作业。

二.技术原理

还记得夏天休息后,在饮水机前排着长队等你吗?现在想象一下一个多头的喷泉,流动着所有人的清凉善良。

这就是NVIDIA安培体系结构中启用的多实例GPU(MIG)的本质。

MIG将一个NVIDIA A100 GPU划分为多达七个独立的GPU实例。它们同时运行,每个都有自己的内存、缓存和流式多处理器。这使得A100 GPU能够以比以前的GPU高7倍的利用率提供有保证的服务质量(QoS)。

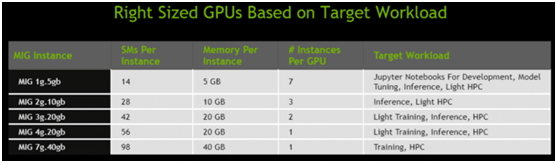

在MIG模式下的A100可以运行多达7个不同大小的AI或HPC工作负载的任意组合。这种能力对于通常不需要现代GPU所提供的所有性能的AI推理工作特别有用。 例如,用户可以创建两个MIG实例,每个实例的内存为20gb,三个实例的内存为10gb,七个实例的内存为5gb。用户创建适合其工作负载的组合。

MIG隔离了GPU实例,所以它提供了故障隔离——一个实例中的问题不会影响在同一物理GPU上运行的其他实例。每个实例都提供有保证的QoS,确保用户的工作负载获得他们期望的延迟和吞吐量。

云服务提供商和其他企业可以使用MIG来提高其GPU服务器的利用率,为用户提供高达7倍的GPU实例。

英伟达是谷歌云的战略合作伙伴,MIG使共享Kubernetes集群中gpu的效率和利用率达到新的水平成为可能。启用这些共享GPU用例,并通过googlekubernetes引擎提供用例。

三.企业对MIG的推断

对于企业用户来说,MIG加速了人工智能模型的开发和部署。

MIG让多达7个数据科学家同时访问一个感觉像是专用GPU的东西,这样他们就可以并行工作,微调深度学习模型,以获得最佳的精度和性能。这是一项耗时的工作,但它通常不需要太多的计算能力——这是MIG的一个很好的用例。

一旦模型准备好运行,MIG允许一个GPU同时处理多达七个推理作业。这对于批量1推理工作负载来说是非常理想的,这些工作负载包括不需要完整GPU的肌肉的小的、低延迟的模型。

英伟达技术对送货机器人平台服务至关重要,MIG将能够充分利用部署的每一个GPU,能够动态地重新配置计算资源,以满足不断变化的工作负载需求,优化我们基于云的基础设施,从而最大限度地提高效率和节约成本。

四.专为IT/DevOps而建

用户不必改变CUDA编程模型就可以获得MIG对AI和HPC的好处。MIG可以与现有的Linux操作系统、Kubernetes和容器协同工作。

NVIDIA通过它为其A100提供的软件启用MIG。其中包括GPU驱动程序、NVIDIA的CUDA11软件(即将上市)、更新的NVIDIA容器运行时以及通过NVIDIA设备插件在Kubernetes中的新资源类型。

将NVIDIA虚拟计算服务器(vComputeServer)与MIG结合使用,将提供管理和监视系统管理程序(如Red Hat Virtualization和VMware vSphere)的优点。这种组合将支持流行的功能,如实时迁移和多租户。

客户越来越需要管理运行在虚拟机上的多租户工作流,同时提供隔离和安全好处,NVIDIA A100 GPU上新的多实例GPU功能支持一系列新的人工智能加速工作负载,这些工作负载可以在红帽平台上运行,从云端到边缘。

随着NVIDIA A100及其软件的到位,用户将能够看到和调度他们的新GPU实例上的作业,就好像他们是物理GPU一样。

原文链接:https://www.cnblogs.com/wujianming-110117/p/13037220.html

评论 ( 0 )