本熊认为投稿就要省流+有用,然后伙伴们可以消化和复现,这才是高质量的稿件。

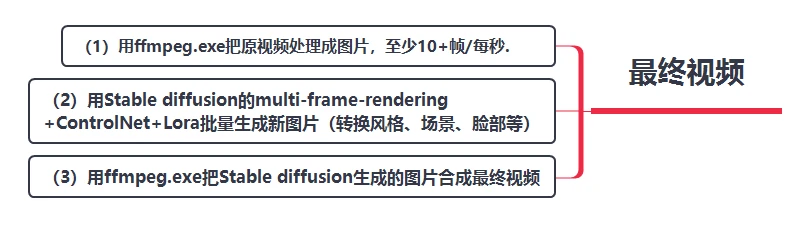

一、简单原理

二、详细操作

1)准备好原始视频素材,用ffmpeg.exe把视频出来成图片,命令为:

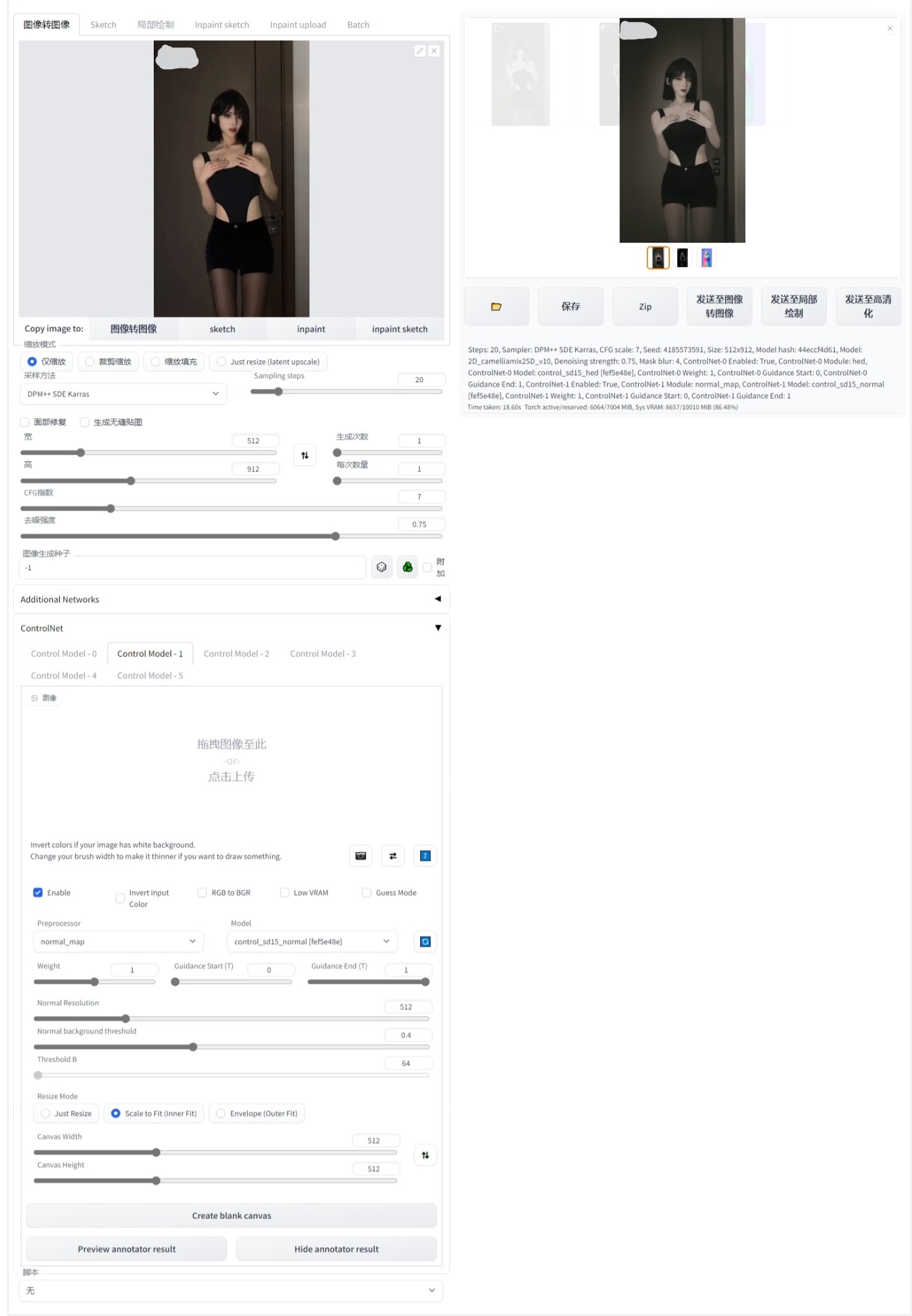

2)打开Stable diffusion webui的图生图TAB页面。首先通过第一张图先生成第一帧图片,看看效果,通过ControlNet进行姿势和画面控制,通过Lora进行风格和脸部控制。

配置项:

A)模型自己选,可以选动漫二次元或者真人三次元

B)ControlNet使用hed和normal map,自己调试weight合适就行

如图:

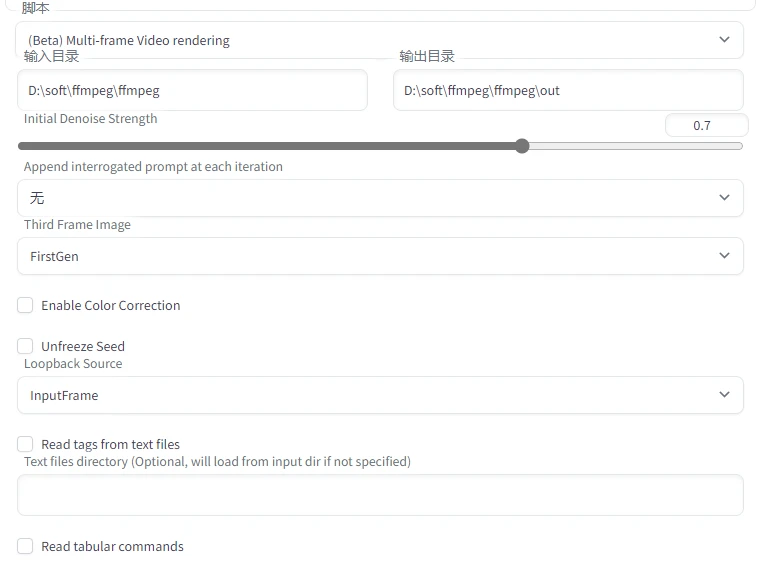

3)第一帧效果生成效果满意后台,进行脚本配置,

选择muti frame脚本,输入目录选择要批量转换的原图片目录,输出目录自己确定。

Third Frame Image选择 FirstGen

Loopback Source 选择 InputFrame

4)然后点击图生图的生成按钮,等待全部图片转换完成。

效率的话,参考:RTX 3080(10GB) 处理80张图大概30分钟左右。

5)最后用ffmpeg把渲染完的图片合成视频,命令如下:

对了,如果对渲染的图片分辨率不满意,可以进行图片高清处理,进入webui的高清化Tab页面,想要多高清就有多高清,然后再合成视频。

最终效果:

原文链接:https://www.bilibili.com/read/cv22984297/

评论 ( 0 )