Satble Diffusion 给视觉设计带来了前所未有的可能性和机会,它为设计师提供了更多选择和工具的同时,也改变了设计师的角色和设计流程。然而,设计师与人工智能软件的协作和创新能力仍然是不可或缺的。接下来我将从三个维度来向大家分享 Satble Diffusion 在视觉设计方向的技巧应用。

一、线稿/插画秒变3D

1. 线稿秒变 3D 场景

在人工智能绘画软件之前,我们如果想将一张线稿设计图转变为一幅 3D 场景可能需要非常复杂的过程,比如:线稿填色成平面插画,然后根据画面物体的结构在 3d 软件中进行建模,最终根据配色进行打光渲染等步骤来完成。而现在我们运用 stable diffusion 甚至数秒的时间就可以完成一系列方案。

关于 stable diffusion 的使用原理网络上有许多详细的教程,在这里就不向大家赘述。接下来我将向大家分享如何运用 SD 将 midjourney 生成的线稿图转变为 3d 场景。

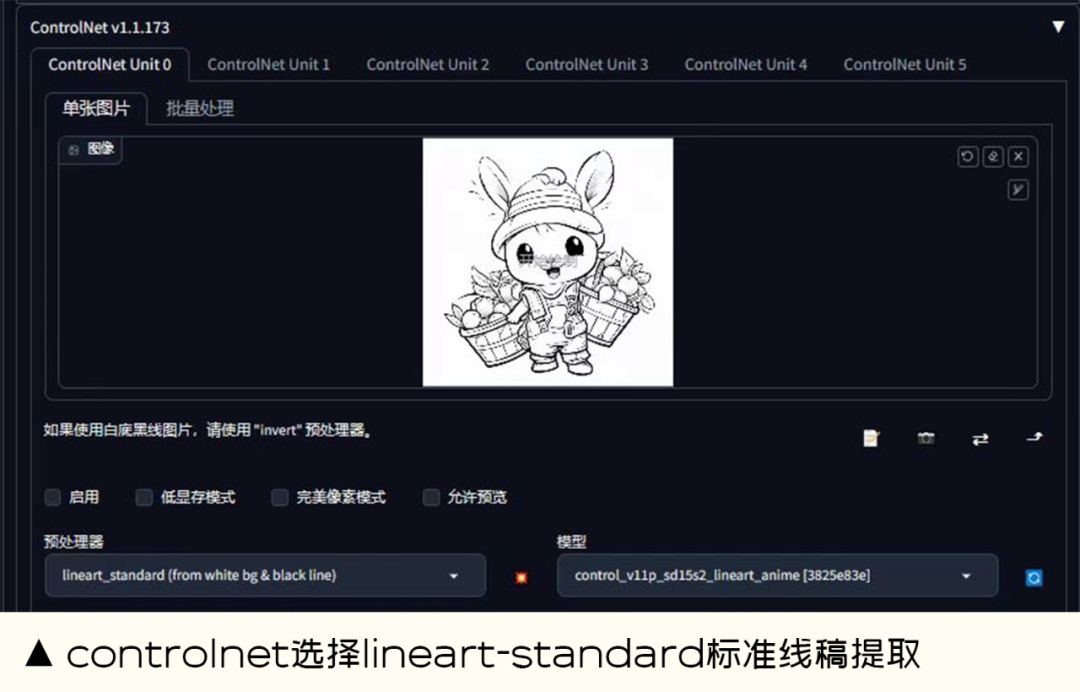

整个的创作过程在文生图模式下进行创作的,大模型选择的是 disneypixarcartoon_v10.safetensors,外挂 VAE 滤镜为 chilloutmix_Niprunedfp32fix.vae.ckpt;最关键的部分 controlnet,前后都选择为 canny-边缘检测或者也可以尝试 lineart-标准线稿提取(将线稿图上传其中),根据画面添加正反向具体的描述关键词,不断的去调整合适的参数,就可以得到我们想要的效果。

如果最终效果图部分视觉没有达到我们的预期,我们可以结合图生图模式下的局部重绘或者上传重绘蒙版功能,运用重绘蒙板结合关键词进行重新绘制,直达到我们的预期效果为止。当熟悉了整个创作模式后进行批量输出方案时,线稿输出 3d 画面的效率大大超出我们的想象。

2. 平面卡通 IP 秒变 3D 角色

除了上述的线稿转 3d 场景之外,我们日常的平面 IP 卡通人物也可以通过 stable diffuson 秒变 3d 人物,在实现过程上述的案例有所不同,因为我们需要更加精准的按照我们的平面插画进行 3d 人物的制作,当然我们更期望最终的 3d 形象与我们的平面效果完全吻合,因此这里我们不再使用文生图模式,而是采用图生图模式来进行更精准的控制。

以一张用 midjourney 生成的 ip 卡通平面三视图为例:根据我们卡通人物的特征,添加详细的正反向描述关键词来构建预期效果,重绘幅度数值设置为 0.5。另外,在模型的使用上还是有很大区别的,大模型选用了 revanimated_v122.safetensors,滤镜是 animevae.pt。controlnet 采用 depth-zoe 控制深度;canny 或者 lineart-anime 控制外形线稿的提取;关于 lora 模型选择了 blindbox 给予类似于盲盒有趣的 3d 效果,另外还使用了 charturnerv2:0.4 这个 lora 模型用来增强模型的塑料质感,最终就形成了如图的 3D 角色。

二、人物场景的精准控制

在互联网许多应用领域筛选出符合预期的人物场景图是一个难题,但是自从有了 stable diffusion 之后,这个难题几乎迎刃而解。通过 stable diffusion 的图生图模式,配合 controlnet 的精准控制就非常容易达到我们想要的预期效果。当然在这个过程中,为了避免版权纠纷问题,在使用图生图的底图时尽量选取我们拥有版权的图片,这样在这个基础上做衍生就规避了版权的风险。

比如,现在我想要一张(如下图)同样姿势的工作人员不是站在空调旁边,而是想让他站在微波炉旁边的场景,那么我们可以将原图放在图生图模式下,大模型同样选用 relistiCV20,滤镜选择 animevae.pt。lora 模型选择 filmvelvia2 类似于胶片质感来烘托真实的场景氛围;controlnet 运用的是 openpose_full 用其来控制人物的姿势状态,配合重绘幅度参数的调节以及正反关键词的描述来达到想要的效果。本案例的正反关键词描述如下:

正向关键词:A handsome smiling Chinese repairman is standing under the microwave oven, wearing a green T-shirt. There are some white furniture in the scene, dramatic lighting,

一位面带微笑的中国修理工站在微波炉下,身穿绿色 T 恤。场景中置放了一些白色的家具,引人注目的灯光。

反向关键词:EasyNegative ,GS-DeMasculate-neg,bhands-neg, lowres Unreasonable view (worst quality:2), (low quality:2),

前 3 个英文单词是调用的 embeddings 文件名称,低分辨率的,不合理的视图(最差质量:2),(低质量:2)

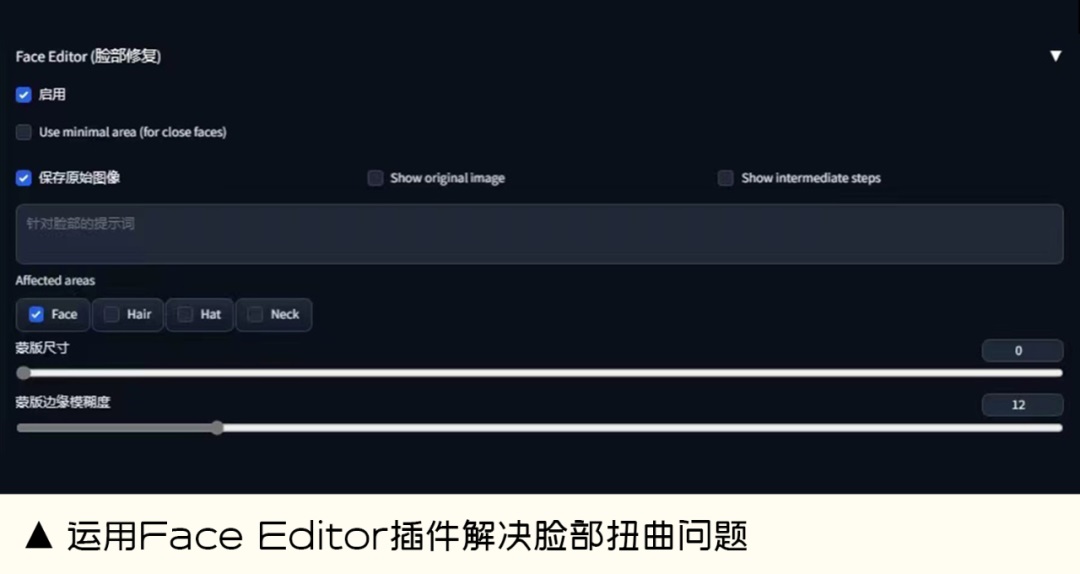

另外在真实人物场景的输出过程中,很多时候人物的手部、脸部会出现问题,我们可以通过 SD 的进阶模型 embeddings 在一定程度上去修复画面手部的问题,例如调节手部的模型 bhands-neg.pt;对于人物脸部扭曲的问题,我们可以运用 face editor 插件,通过调整参数来使人物的表情更加真实自然。

三、SD设计创意字体

Stable diffusion 除了可以创作上述的 3d、真实场景图之外,当然也可以完成创意风格字体的设计。对于创意风格字体我们可以通过文生图的形式,给予 sd 更多的创作空间可以产出多样风格的字体样式,接下来继续和大家分享如何将白底黑字转变为我们想要的创意风格的创作过程。

以上图冰块文字为案例:整个过程是在文生图模式下进行的,在大模型上需要选择是:realisticVision,滤镜选择的是:VAE 模型 vae-ft-mse-840000-ema-pruned.safetensors,如果没有的话可以前往 c 站去下载。采样方法在这个案例中选择了 DPM++ 2M Karras,Controlnet 预处理器运用的是 lineart(标准线稿提取),模型运用的是 lineart。然后在里面导入我们的白底黑字图片,在正反向描述语里描述我们想要的效果,经过多次尝试就会遇到意想不到的惊喜。最后为了更好地提高视觉效果细节,我们可以将最终图片导入到图生图模式下(描述同文生图),Controlnet 预处理器选择 tile_resample,模型选择 control_v11f1e_sd15_tile,经过二次处理后会发现视觉效果更加惊艳细致。当然在这里主要是向大家介绍制作创意风格字体的一个思路,具体的参数和模型大家可以根据具体情况去调节。

以下为本案例使用的关键词:

正向关键词:high quality, masterpiece, ((Transparent ice cubes)), glacier background,

高品质,杰作,(( 透明的冰块 )),冰川背景。

反向关键词:EasyNegative, BadArtist, BadPrompt, BadImages, poor anatomical structure, low quality, text errors, extra numbers, fewer numbers, jpeg artifacts, signatures, watermarks, username, blurring, cropped,

前 4 个英文单词是调用的 embeddings 文件名称,解剖结构差,低质量,文本错误,多余的数字,缺少的数字,jpeg 伪影,签名,水印,用户名,模糊,被裁剪的。

原文链接:https://www.bilibili.com/read/cv25435825/

评论 ( 0 )