深度学习是近年来人工智能领域最热门的话题之一。它是一种通过模拟人脑神经网络工作原理,进行大规模数据处理和模式识别的机器学习方法。随着计算能力的提升和大数据时代的到来,深度学习在图像识别、语音识别、自然语言处理等领域取得了突破性进展,成为推动人工智能技术发展的重要力量。

本文将简单介绍深度学习的基本原理和发展趋势,帮助读者更好地了解这一前沿技术。

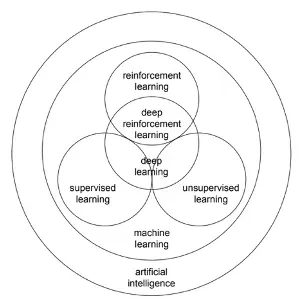

深度学习是一种基于人工神经网络的表征学习算法,它可以从大量的数据中自动学习特征和规律,从而实现智能化的任务。深度学习中的人工神经网络是一种模拟生物神经系统的计算模型,它由多个简单的单元组成,通过连接权重和激活函数来传递和处理信息。作为机器学习领域的一个重要分支,深度学习被认为是实现真正人工智能的关键技术之一。

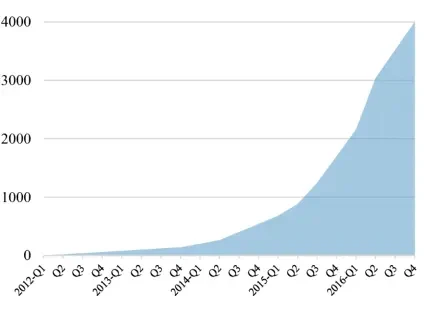

近年来,深度学习在学术界和工业界都取得了显著的进展和应用,它已经改变了许多领域和已有产品的形态,例如生活中的在线广告投放、视频推荐、垃圾邮件过滤、多语言翻译等等都有深度学习的影子。将深度学习技术融入产品之中已经成为互联网公司提升产品用户体验的重要方向,以Google为例,2012年到2016年间Google内部基于深度学习的项目数量呈指数级增长。

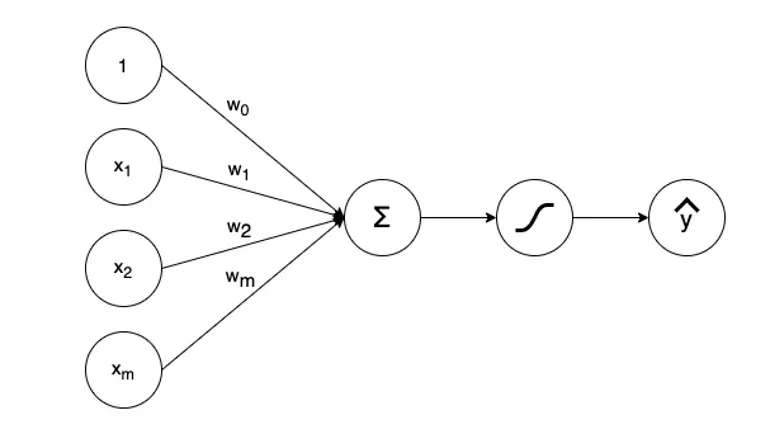

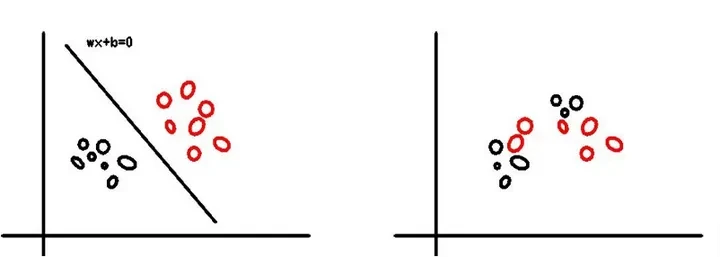

深度学习在人工智能领域掀起了一股热潮,现在CV和NLP领域的顶会每年都有上千篇论文接收,但是实际上深度学习的发展并非是一帆风顺的。深度学习的起源可以追溯到上世纪50年代,当时研究人员试图模拟人脑的神经元结构以实现智能行为。在1958年 Frank Rosenblatt提出了Perceptrons(感知器),这是一种二元线性分类器,但是这种单层的网络结构有个致命缺点是无法处理线性不可分的问题。到了1969年,Marvin Minsky和Seymour Papert在《Perceptrons》一书中对感知器为代表的单层神经网络的功能和局限进行了分析,证明了Perceptron不能解决线性不可分问题,自此之后神经网络的发展进入了低谷期。

1986 年Geoffrey Hinton发表了一篇名为《Learning representations by back-propagating errors》的论文,提出了Backpropagation算法,对解决非线性分类和学习的问题非常有效果,这篇论文也成为深度学习领域最有影响力的论文之一。自此深度学习开始有了新的发展,但是实际上Backpropagation算法仍然存在局限性,网络结构一旦超过 3 层的就训练不出好的结果。这些早期的神经网络模型受限于当时的计算能力以及缺乏足够的训练数据,模型性能一直无法取得重大突破。

2009 年吴恩达等人开始使用大规模的GPU进行深度学习训练,加快了深度神经网络的发展。2012 年 Alex Krizhevskyh和Hinton利用CNN构建的8层神经网络AlexNet夺得ImageNet冠军,达到最低的15.3%的Top-5错误率,远远低于第二名SVM(支持向量机)的分类错误率。AlexNet夺冠标志着深度学习在计算机视觉领域的重要突破,在《ImageNet Classification with Deep Convolutional Neural Networks》这篇论文中,Alex Krizhevskyh等人提出模型的深度对于提高性能至关重要。自此构建深层网络处理任务在计算机视觉领域吸引了众多学者的关注,大量围绕深层神经网络的论文涌现。

深度学习的主要研究方向有计算机视觉(Computer Vision)、自然语言处理和语音识别(Natural Language Processing)。计算机视觉是用计算机代替人眼对目标进行识别、跟踪和测量等机器视觉。我们熟知的OCR 、人脸识别很多都是利用 CV 技术的开发取得了很好的识别效果。在CV领域最热门的问题当属自动驾驶,这个难题吸引了大量的学者和企业投入资源进行研究,例如特斯拉在自动驾驶上一直坚持纯视觉的方案,认为基于深度学习的纯视觉方案就能够解决自动驾驶面临的技术问题,不过目前距离实现完全的自动驾驶仍然有很长的距离。

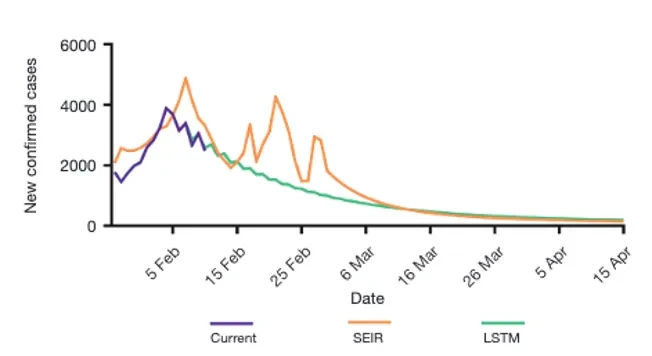

如何让程序读懂人类语言一直是NLP领域的难题,深度学习给NLP领域带来了革命性的变革,通过 word embeddings(词嵌入)可以让算法自动理解一些类似的词,这在 NLP 领域是重大的突破。随着Word2Vec、GloVe和BERT等词嵌入模型的引入,深度学习开始能够从大规模文本数据中自动学习单词和短语的语义表示,这使得机器在理解和生成自然语言方面取得了重大进展,如情感分析、问答系统和自动摘要等。基于 RNN、LSTM 构建的模型在处理一些预测任务时取得了不错的效果,在实际情况中也有很多的应用。例如在武汉疫情期间,钟南山团队在 OA 期刊上发表了论文《Modified SEIR and AI prediction of the epidemics trend of COVID-19 in China under public health interventions》,这篇论文就利用 LSTM 对疫情趋势进行了预测,原文的结论如下:

“The LSTM model is a type of RNN that was trained using the 2003 SARS epidemic statistics incorporating the COVID-19 epidemiological parameters, such as the probability of transmission, incubation rate. The probability of recovery ordeath and contact number. The LSTM model predicted that new infections will peak on February 4, resulting in 95,000 cases by the end of April (Figure 3A). We then plotted the number of daily new cases derived from SEIR, LSTM and the actual reported data for China. There was a remarkable fit between the actual number of new confirmed cases and the LSTM-predicted curve between January 22 and the February 10 (Figure 3B). Both the SEIR and LSTM-model predicteda peak of 4,000 daily infection between February 4 and 7.The SEIR model also predicted several smaller peaks of new infections in mid to late February.”

我们可以看到 LSTM 的预测和实际的情况相比很接近,比常用的传染病模型 SEIR 更加的接近实际情况。

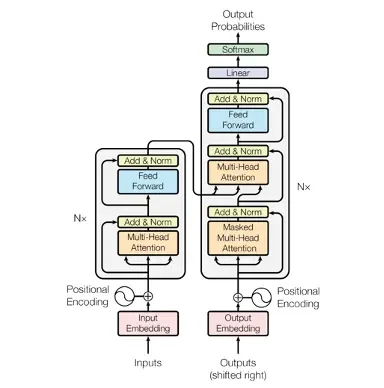

但是目前在 NLP 领域中,Transformer是学术界和工业界炙手可热的宠儿。2017 年 Google brain 的研究员发表了《attention is all you need》,这篇论文提出了一个Transformer的结构,在深度学习领域掀起了一阵狂潮,随后基于 Transformer 结构的任务处理的相关研究大量出现,并在工业界取得良好的效果,Transformer 似乎有统一整个 NLP 领域的趋势。

在Transformer之前,CNN、RNN、LSTM 这些传统的神经网络被应用于各种场景的任务处理,但是当Transformer出现后,许多之前基于传统结构的任务都开始使用 Transformer 进行模型训练。例如GPT-3.5就使用了Transformer架构,能够在输入序列中捕捉关键的上下文信息,使得ChatGPT能够更好地理解上下文和生成连贯的回答。

不可否认Transformer在很多场景的任务下的确要优于传统的 CNN、RNN 、LSTM等结构,但是Transformer 并非是一个完美无缺的结构,自身也有很多的问题,例如需要大量的样本进行训练和调优,训练成本很高等问题。有人甚至讽刺道“Money is all you need”,没有足够的GPU算力支撑很难做基于 Transformer 的大型训练任务。另外,Transformer缺乏对时间维度的建模,相比之下 LSTM在时序任务的表现要更加的优秀。

深度学习的快速发展主要得益于两个关键因素:大规模数据和强大的计算能力。互联网和社交媒体的兴起为我们提供了海量的数据,使得深度学习模型可以从中进行训练和学习。另外, GPU的出现以及分布式计算框架(如TensorFlow和PyTorch)的发展,大大加速了深度学习模型的训练和推理速度。

虽然深度学习在人工智能领域取得了巨大的成功,但仍然存在一些挑战和限制。例如深度学习模型通常需要大量的训练数据,对于某些领域或任务来说,获取这些数据可能非常困难。此外,模型的解释性也是一个问题,深度学习模型往往被视为“黑盒”,难以解释其决策的依据。我们可以期待随着深度学习的发展,现阶段所面临的问题终会得到解决,我们离人工智能时代也会越来越近。

参考文献:

-

Li Y. Deep reinforcement learning: An overview[J]. arXiv preprint arXiv:1701.07274, 2017.

-

Krizhevsky A, Sutskever I, Hinton G E. Imagenet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

-

Yang Z, Zeng Z, Wang K, et al. Modified SEIR and AI prediction of the epidemics trend of COVID-19 in China under public health interventions[J]. Journal of thoracic disease, 2020, 12(3): 165.

-

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[J]. Advances in neural information processing systems, 2017, 30.

更多AI小知识欢迎关注“神州数码云基地”公众号,回复“AI与数字化转型”进入社群交流

原文链接:https://www.bilibili.com/read/cv28771762/

评论 ( 0 )