目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于深度学习的电商评论情感分析系统

设计思路

一、课题背景与意义

随着电子商务的迅猛发展,大量的用户评论和评价成为了决策购买的重要参考依据。因此,对电商评论进行情感分析具有重要的研究意义和实际应用价值。基于深度学习的电商评论情感分析系统可以自动识别和分析用户评论中的情感倾向,帮助企业了解用户的真实反馈,改进产品和服务质量,提升用户满意度。对于消费者而言,该系统可以提供准确的购物决策参考,帮助他们做出更明智的选择。

二、算法理论原理

2.1 机器学习

监督学习、无监督学习和强化学习是机器学习的三大主要类型。监督学习通过已知的输入输出对训练模型,以便对新数据进行预测;无监督学习通过探索未标注的数据,发现数据内在的结构或规律;强化学习则是通过与环境的互动,不断学习和调整策略以达到最优行为。在分类模型方面,无论是在监督、无监督还是强化学习框架下,模型都是为了识别数据中的模式,并据此对新的数据样本进行分类或预测。在文本评论的情感分析中,我们通常使用监督学习方法,如支持向量机(SVM)、决策树、随机森林、神经网络等,来训练模型识别好评和差评。

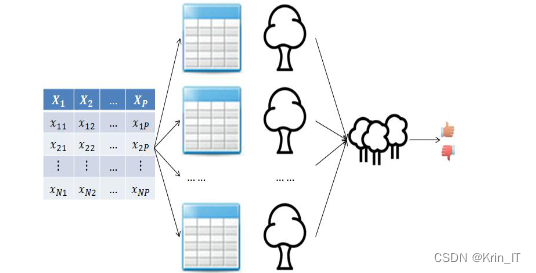

随机森林算法是一种集成学习方法,它通过构建多个决策树来提高分类或回归问题的预测性能。每个决策树都是通过随机选择特征和样本进行训练的,这样不仅减少了过拟合的风险,还能提高模型的泛化能力。在分类问题中,随机森林通过投票机制来确定新样本的类别,即多数树的预测结果决定最终预测;在回归问题中,它通过计算所有树预测结果的平均值来得到预测值。这种方法在处理电商用户评论情感分析等文本挖掘任务中表现出色,能够有效地识别出正面和负面的评论。

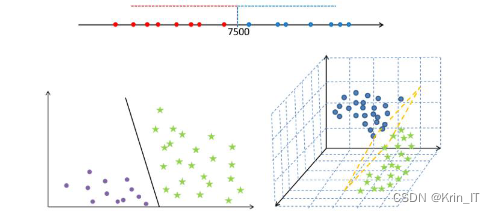

支持向量机(SVM)是一种强大的监督学习算法,适用于分类和回归任务,以及异常检测等。SVM通过将数据映射到高维空间,利用“支持向量”和“超平面”的概念来实现对数据的线性划分。它在处理线性不可分数据时表现出优越的性能,并且具有较高的准确度和较强的泛化能力。在支持向量机(SVM)算法中,为了找到最优的“超平面”,需要执行以下三个步骤:首先,计算每个样本点到候选分割线(超平面)的距离;其次,从两个类别的样本点中找出距离分割线最近的点,即支持向量;然后,比较两个类别的支持向量到分割线的距离,选择距离较小的那个;最后,在这些分割线中找出能够最大化分类间隔(分割带宽度)的直线,这条直线即为所求的最优“分割线”,它能够将数据最有效地分开,从而实现线性分类。

2.2 神经网络模型

全连接网络虽然结构简单,易于计算和求导,但随着特征变量数量的增加,其需要的训练参数也急剧增多,导致训练难度加大。为应对互联网时代数据量的爆炸性增长,特别是在计算机视觉和自然语言处理领域,提出了更高效的神经网络架构。卷积神经网络(CNN)专用于处理图像和视频等视觉数据,而循环神经网络(RNN)及其变体,如长短期记忆网络(LSTM)、门控循环单元(GRU)和双向RNN等,则适用于处理具有时间序列特征的数据,如文本。这些先进的神经网络架构显著提高了数据处理的效率和准确性。

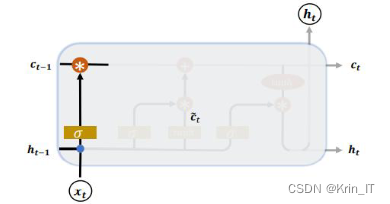

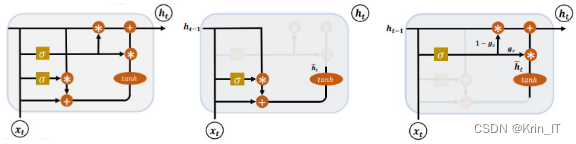

长短时记忆网络(LSTM)是针对传统循环神经网络(RNN)在处理长序列数据时遇到的梯度消失问题而设计的。LSTM通过引入门控机制和两个状态向量(隐藏状态ℎ和记忆状态c)来解决传统RNN的这一局限。在LSTM中,遗忘门控制信息遗忘的程度,输入门决定新信息的接受程度,而输出门负责更新最终的输出。这种结构使得LSTM能够有效地保持长期依赖性,并在处理诸如文本序列等复杂的序列数据时表现出色。

门控循环单元(GRU)是LSTM的一种简化版本,旨在降低模型的复杂性和参数数量,从而减少计算时间和资源消耗。GRU通过将LSTM中的两个状态向量(隐藏状态和记忆状态)合并为一个单一的状态向量,并且将门控机制简化为复位门和更新门两个,有效地减少了模型的复杂度。这种简化使得GRU在处理长序列数据时,尤其是在资源有限的环境中,成为一个更高效的选择。

三、检测的实现

3.1 数据集

由于网络上没有现有的合适的电商评论数据集,我决定通过相机拍摄和互联网收集两种方式进行数据集的收集。首先,我通过相机拍摄了不同电商平台上的用户评论页面截图,包括商品评价和用户留言等。其次,我通过互联网收集了大量的电商评论样本,包括正面、负面和中性的评论。通过这两种方式的数据采集,我得到了一个包含各种场景和丰富情感表达的电商评论数据集,为后续的情感分析研究提供了基础。

为了增加数据集的多样性和扩充训练样本,我使用了数据扩充技术。数据扩充是通过对原始数据进行变换和增强,生成新的样本,以增加训练集的多样性和数量。在数据扩充过程中,我采用了文本增强技术,包括词语替换、同义词替换和句子重组等方法。这些技术能够生成具有不同表达方式和变体的评论样本,增加了模型对各种情感表达的识别能力。数据扩充为深度学习的电商评论情感分析系统提供了更丰富的训练数据,提高了系统的性能和泛化能力。通过数据扩充,我能够获得更准确、更全面的训练集,从而提升了情感分析系统对电商评论的理解和分类能力。

3.2 实验环境搭建

实验环境使用Windows操作系统,并利用Python作为主要的编程语言进行算法和模型的实现。使用PyTorch作为深度学习框架,构建和训练神经网络模型。借助Pandas等库,完成数据的加载、处理和转换。这样的实验环境提供了一个方便和高效的平台,用于开发和测试算法系统。

3.3 实验及结果分析

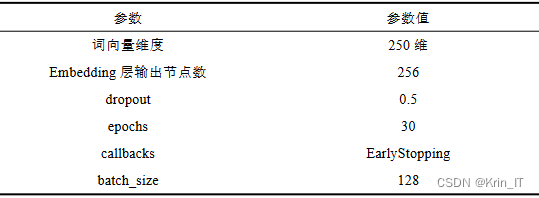

在使用TensorFlow框架下的Keras模块构建深度学习算法对电商评论数据进行分类预测时,我们按照给定的样本划分方案,将数据集划分为训练集、验证集和测试集。通过对评论文本数据进行预处理,我们准备好供模型训练使用的输入数据。然后,我们使用Keras模块构建深度学习模型,并设置各项通用参数以优化模型性能。在模型训练过程中,我们使用训练集进行训练,并在每一轮训练过程中使用验证集评估模型的性能。最后,我们使用测试集对训练好的模型进行评估,以检验模型的泛化能力。通过参数调优、模型结构调整和数据预处理的优化,我们可以提高模型的预测准确率和性能。

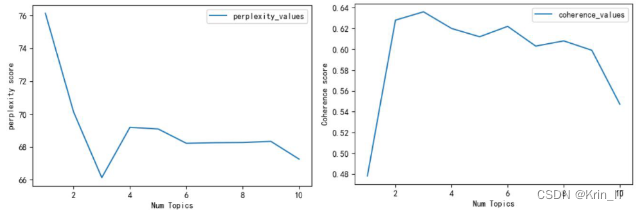

使用Python的gensim库中的LdaModel方法进行主题模型构建。首先需要创建自定义词典并去除停用词,然后对用户评论数据进行分词处理,最后将分词后的数据导入到构建好的模型中。模型输出的主题数可以根据需求进行设置,选择合适的主题数取决于Gibbs抽样的参数和困惑度值。较小的困惑度值表示模型聚类效果较好。此外,主题一致性也是选择最优主题数的方法之一,通过最大化一致性值(Coherence_value),可以认为模型达到最优状态。

相关代码示例:

from gensim import models from gensim.corpora import Dictionary from wordcloud import WordCloud import matplotlib.pyplot as plt # 用户评论数据预处理 # 假设good_reviews和bad_reviews分别为好评和差评数据列表 # 创建自定义词典 custom_dictionary = Dictionary([good_reviews, bad_reviews]) # 去除停用词 stop_words = ["的", "了", "很", "非常"] # 自定义停用词列表,根据实际情况添加 custom_dictionary.filter_tokens(stop_ids=custom_dictionary.token2id.values()) # 分词处理 good_reviews_tokenized = [custom_dictionary.doc2bow(review) for review in good_reviews] bad_reviews_tokenized = [custom_dictionary.doc2bow(review) for review in bad_reviews] # 统计高频词并生成词云图 good_reviews_word_freq = custom_dictionary.cfs # 好评评论词频统计 bad_reviews_word_freq = custom_dictionary.cfs # 差评评论词频统计 # 生成好评词云图 good_reviews_wordcloud = WordCloud().generate_from_frequencies(good_reviews_word_freq) plt.imshow(good_reviews_wordcloud, interpolation='bilinear') plt.axis("off") plt.show() # 生成差评词云图 bad_reviews_wordcloud = WordCloud().generate_from_frequencies(bad_reviews_word_freq) plt.imshow(bad_reviews_wordcloud, interpolation='bilinear') plt.axis("off") plt.show() # 构建LDA主题模型 num_topics = 5 # 设置主题数 good_reviews_lda = models.LdaModel(good_reviews_tokenized, num_topics=num_topics) bad_reviews_lda = models.LdaModel(bad_reviews_tokenized, num_topics=num_topics) 实现效果图样例:

创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

最后

原文链接:https://blog.csdn.net/2301_79555157/article/details/136383680?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522171851556316800222868750%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=171851556316800222868750&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-26-136383680-null-null.nonecase&utm_term=AI%E7%94%B5%E5%95%86

评论 ( 0 )