©原创作者 | 三金

写在前面

网易经过近20年的飞速发展,现已经跻身全球七大游戏公司之一,旗下拥有游戏行业领先的人工智能实验室——网易互娱AI Lab。该实验室致力于将AI技术应用在游戏中,现网易游戏已广泛应用AI技术,例如当前热门游戏《第五人格》、《梦幻西游》等。

今天小编给大家分享的便是关于AI Lab人工智能研究工程师岗位的面试真题。

01 面经干货

1)面经来源:牛客网(ID:算法小白菜不在了)

A、一面

1. 自我介绍

2. 介绍腾讯、艾耕实习内容

3. 讲讲Attention机制的原理。

AI面试指南参考答案:

在NLP任务中,一个句子的不同部分具有不同含义和重要性,Attention机制能够计算输出单词对应得输入语句中各个单词的概率分布,从而对重要单词进行重点关注并充分学习。

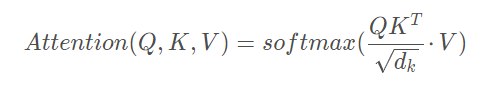

Attention机制首先将某个单词的查询向量与输入句子中所有单词的键向量进行运算得到单词的“分数”,这个分数表示该单词与句子中其它单词的联系程度,其次将“分数”通过sortmax后再乘以值向量得到权重,最后再进行加权求和。具体计算公式如下所示,其中Q表示查询向量,K表示键向量,V表示值向量。

4. 讲讲fastText原理。

AI面试指南参考答案:

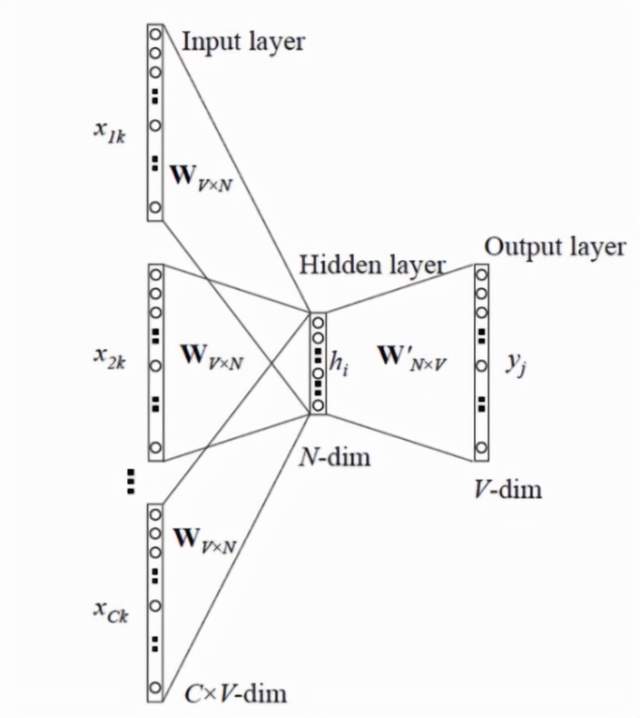

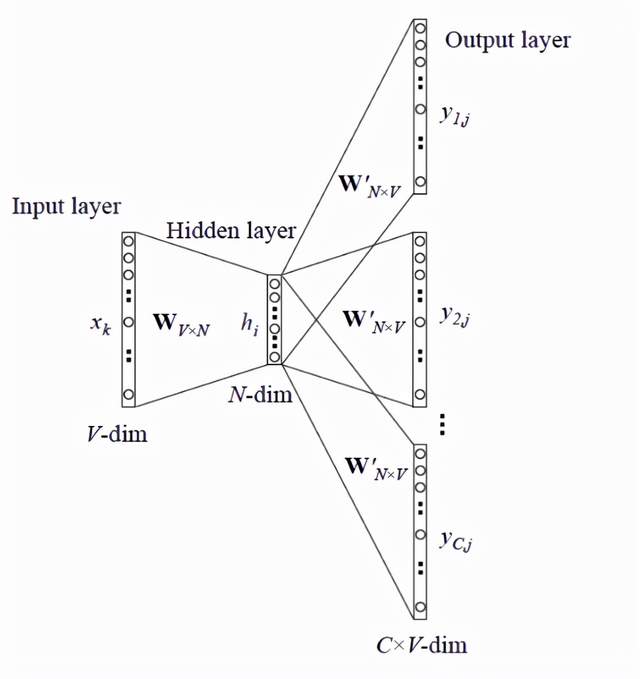

1)fastText的核心思想是将整篇文档的词以及n-gram向量进行叠加取平均值,从而得到文档向量,然后再使用文档向量进行softmax多分类。

2)其模型架构有3层:输入层、隐含层、输出层。输入的是多个单词以及n-gram特征,特征都是embedding过的,隐含层即对特征向量进行求和取平均操作,输出层输出文档对应的类别。

3)fastText有两个功能:文本分类、快速词向量训练。

5. fastText相比于word2vec有什么优势?

AI面试指南参考答案:

1)fastText使用字符级别的n-gram表示一个单词,即当两个词有相同的词缀时,可以学习到其语义之间的相似性,从而克服了word2vec忽视单词内部形态特征的问题。

2)fastText对于低频词生成的词向量效果会更好,因为n-gram可以和其他的词共享;

对于训练词库之外的单词,fastText可以通过叠加单词的字符集n-gram向量生成对应的词向量。

6. 文本分类除了CNN和RNN还知道哪些方法?

AI面试指南参考答案:

除此之外还有 LSTM、HAN(Hierarchical Attention Network)、BERT、fastText等方法。

7. Bi-LSTM + CRF模型的原理。

AI面试指南参考答案:

总体来看该模型主要由Embedding层、双向LSTM层以及最后的CRF层构成。输入的是词嵌入向量,输出的是每个单词对应的预测标签。具体而言,Bi-LSTM层输出每个单词对应各个类别的分数,其作为CRF层的输入,CRF可以自动学习句子的约束条件,在最后的输出分数中,类别序列分数最高的类别即为最终的预测标签。

8. 给定两个命名实体识别任务,一个任务数据量足够,另外一个数据量很少,可以怎么做 ?

AI面试指南参考答案:

1)重采样:通过数据增强、过采样、欠采样等方法,调整类别比例。

2)为每个类别设置不同的权重值,使模型训练更关注小样本类别。

3)更改损失函数,例如focal loss、dice loss。

9. word2vec是有监督的还是无监督的?

AI面试指南参考答案:

无监督学习。因为word2vec目的是为每个单词生成一个向量,即输出的是目标词汇,而不是对应的类别。

10. CBOW和Skip-gram的区别?

AI面试指南参考答案:

1)CBOW即用上下文的词预测目标词汇。

2)Skip-gram即根据输入词预测上下文的词。

11. 思考题:有A(红)B(蓝)两瓶墨水,从A中取一勺倒到B中,混匀后,再从B中取等量墨水,倒到A中。则A中蓝墨水多还是B中红墨水多?

AI面试指南参考答案:

一样多,理由如下:

设原始B中蓝墨水含量为m,两次取出的墨水设为a。则第一次混合墨水后,B中红墨水比例a/(a+m),蓝墨水比例为m/(a+m),第二次取墨水后,B中红墨水还有a-a·[a/(a+m)]=ma/(a+m),则减少的蓝墨水为:a·m/(a+m)=ma/(a+m)。所以两者一样多。

B、二面

1. 自我介绍

2. 摘要抽取怎么做的?

AI面试指南参考答案:

即从原文中抽取关键词、关键句组成摘要。

1)传统方法可以通过TextRank算法(将句子作为结点,根据句子间的相似度构造无向有权边,使用边的权值更新结点,最后选取得分高的结点作为摘要)、聚类算法(对句子进行聚类,得到多个类别,在每一个类别中选择离质心最近的句子组成摘要)实现。

基于神经网络的方法,例如将摘要抽取任务作为序列标注任务处理,每一个句子编码成一个向量作为输入,输出为二分类(0或1),摘要由标签为1的句子构成。

3. 命名实体识别的应用场景有哪些?

AI面试指南参考答案:

可以应用在信息抽取、机器翻译、问答系统等方面。

4. CRF模型说一下,优化目标是什么,怎么训练的?

AI面试指南参考答案:

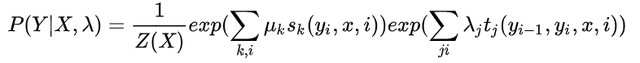

1)优化目标是条件概率P(Y|X),具体公式如下所示。其中X为特征合集,Y为所求目标值的概率分布,Z(X)为归一化函数,μk表示结点的特征函数,λj表示边的特征函数。

2)可以使用开源的CRF++的工具源代码。训练过程分为3步:首先对数据集进行预处理,选择特征,从而构建训练样本集,其次根据选择的特征构建特征函数,然后通过LBFGS算法, 学习特征函数的权重。

5. CRF和HMM的区别

AI面试指南参考答案:

1)HMM是概率有向图,即变量间存在明显的因果依赖关系,CRF是概率无向图,即变量间存在相关性但因果关系难以获得;

2)HMM是生成模型,需要求解联合分布P(X,Y),而CRF是判别模型,需要求解条件概率P(Y|X);

3)HMM求解过程可能是局部最优,CRF可以是全局最优。

6. HMM做了哪些独立性假设

AI面试指南参考答案:

1)齐次性假设:假设每个状态仅依赖于其前一个时刻的状态,与其他时刻的状态无关;

2)观测独立性假设:假设任意时刻的观测值只依赖于该时刻的马尔可夫链的状态,与其他观测及状态无关。

7. HMM的训练方法

AI面试指南参考答案:

1)若训练数据集包含观测序列以及对应的状态序列(标签),则通过监督学习来进行训练,其模型参数可以利用极大似然估计获得;

2)若训练数据集只有观测序列,则通过无监督学习进行训练,可以使用 Baum-Welch 算法求解。

8. HMM的预测方法,维特比算法的过程

AI面试指南参考答案:

1)针对预测问题可以使用近似算法和维特比算法。近似算法,即在每个时刻通过HMM计算该时刻可能状态的概率值,选择最有可能出现的状态(即概率值最大),依次计算所有的时刻从而得到状态序列,将其作为预测的结果。维特比算法即用动态规划求解概率最大路径,此时概率最大的一条路径对应一个状态序列。

2)维特比算法:首先初始化结点,第一个时刻作为第一个结点,其次遍历每一个时刻,计算概率最大值,然后最优路径回溯,直到第一个结点终止,最后输出最优路径。

9. 画Transformer的结构图,为什么self-attention可以替代Seq2Seq?

AI面试指南参考答案:

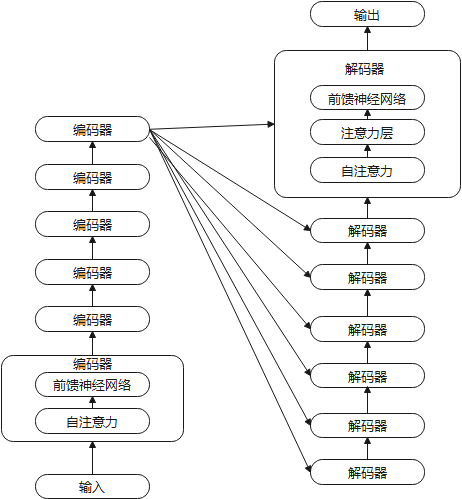

1)Transformer 是一种基于 encoder-decoder 结构的模型,结构图如下所示:

2)因为随着模型处理输入序列的每个单词,self-attention会关注整个输入序列的所有单词,建立单词之间的联系,帮助模型对本单词更好地进行编码,从而解决了Seq2Seq意义单元存储空间有限,句子太长出现信息丢失的问题。

10. 机器翻译的Attention机制里面的q,k,v分别代表什么

AI面试指南参考答案:

q(query),表示查询向量;k(key),表示键向量;v(value),表示值向量。

11. 讲一下fastText原理以及fastText哈希规则。

AI面试指南参考答案:

1)fastText的核心思想是将整篇文档的词以及n-gra 重庆干部培训学校 https://www.ganxun.cn/searchschool/cq.html m向量进行叠加取平均,从而得到文档向量,然后再使用文档向量进行softmax多分类。其模型架构有3层:输入层、隐含层、输出层。输入的是多个单词以及n-gram特征,特征都是embedding过的,隐含层即特征向量求和取平均,输出层输出文档对应的类别。fastText有两个功能:文本分类、快速词向量训练。

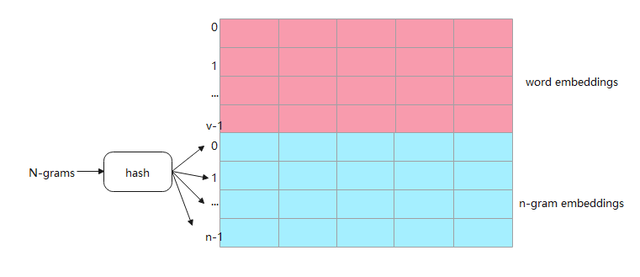

2)由于fastText中的n-gram的数量远大于word的数量,存储n-gram需要消耗大量内存空间,所以出现了fastText哈希规则用于解决此问题。如下图所示,每行代表一个word或n-gram的embeddings向量,其中前v行是word embeddings,后n行是n-grams embeddings。哈希规则即把所有的n-gram都哈希映射到n行里,且映射到同一行的所有n-gram共享一个embedding vector。

12. 为什么要用fastText做文本分类,是因为训练快还是预测快?

AI面试指南参考答案:

训练速度快。因为fastText模型简单仅三层,且最后一层可以采用分层softmax或负采样,所以运算速度快可以极大降低模型训练时间。

13. 讲一下分层softmax和负采样。

AI面试指南参考答案:

1)分层softmax使用了树的层次结构代替了扁平化的标准softmax回归,在计算某个输出结点的概率值时,只需要计算该结点经过路径上的所有结点的概率值,而不再需要对输出的所有结点做概率归一化,从而降低了计算复杂度。

2)负采样即每次从除当前标签外的其他标签中选择几个作为负样本,将负样本出现的概率加到损失函数中。

14. 讲一下腾讯的实习

15. 推导LR

AI面试指南参考答案:

1)逻辑回归基础公式:

原文链接:https://blog.csdn.net/cmdos/article/details/123202882?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522171851498716800184179110%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=171851498716800184179110&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-12-123202882-null-null.nonecase&utm_term=AI%E9%9D%A2%E8%AF%95

评论 ( 0 )