自 2022 年底 ChatGPT 横空出世,近一年多来 AI 热潮席卷全球,国内外大厂陆续推出自家大模型,本周谷歌最新发布了新一代开放 AI 模型 Gemma,更是让不少人直呼“史上最强”。但本文作者认为,如今的 AI 已与最初它的定义相差甚远,甚至如火如荼发展的 LLM(大型语言模型)也并非真正意义上的智能。

原文链接:https://matt.si/2024-02/llms-overpromised/

作者 | MATTSI JANSKY 翻译 | 郑丽媛

出品 | CSDN(ID:CSDNnews)

作为人工智能(AI)的倡导者,我希望看到这一领域取得成功,并继续做出伟大的成就。正因如此,我对目前围绕“人工智能”的夸大宣传和投资感到担忧——你可以发现,我在这里使用了引号,因为如今经常被称为“人工智能”的东西与这个词曾经描述的东西完全不同。

近一年来,由于 ChatGPT 等大型语言模型(LLM)的出现,人们对 AI 的兴趣大增,使得这个定义模糊的术语成为技术对话的焦点。而我想说,LLM 并非真正意义上的智能(我们将对此进行深入探讨),但将这些聊天机器人称为 AI 已成为一种常见的说法。

使用“AI”这个词可以引起媒体的关注,但是你把自己的产品称为 AI 会让用户对它产生不太可能实现的期望。我们将探讨 LLM 能做什么、不能做什么,看到行业中的这一趋势可能并不新鲜,并探索这对科技行业的影响。

我们是怎么走到这一步的?

图灵在出版《计算机器与智能》一书时,他描述了一种可以像人类一样推理的“思考机器”。他撰写了大量论据,证明思维机器有可能被创造出来: 在物理学、计算机、数学或任何其他领域,没有任何已知的东西能否定这种可能性。他反复论证了所有反对思维机器的已知论点,彻底解构并击败了每一个论点。在 1956 年的达特茅斯会议上,思考机器的想法被称为“人工智能(AI)”。在那次会议上,我们人类迈出了创造 AI 的第一步。

从那时起,AI 领域产生了大量显著的发现: 搜索、知识表示、一阶逻辑推理、概率推理、专家系统、动态规划与机器人、多智能体系统、机器学习、语音识别、自然语言处理、机器翻译、图像识别等等。这些技术可以大致分为三种方法:联结主义、符号主义和行为主义。

我们进行到哪里了?

在公开对话中,这一细微差别被 LLM 所掩盖,而 LLM 是 AI 领域最近人人都在谈论的一项成就。LLM 是一种机器学习算法,可以生成可信的类人文本。它使用惊人的处理能力对海量文本进行训练,以创建一个概率模型,该模型在很大程度上可以预测真人在响应给定输入时可能会说的话。这是通过创建神经网络来实现的,但不要混淆:这些神经网络与哺乳动物的大脑完全不同,它们并不是为了重现人类的思维方式,而是预测人类对给定输入的反应。神经网络参与了这一机制,但并不是为了模拟类似人类的思维,这一切运作的主要手段是统计学和概率论。换句话说,该模型只是会猜测别人可能会根据你的提示写出哪种字母组合。

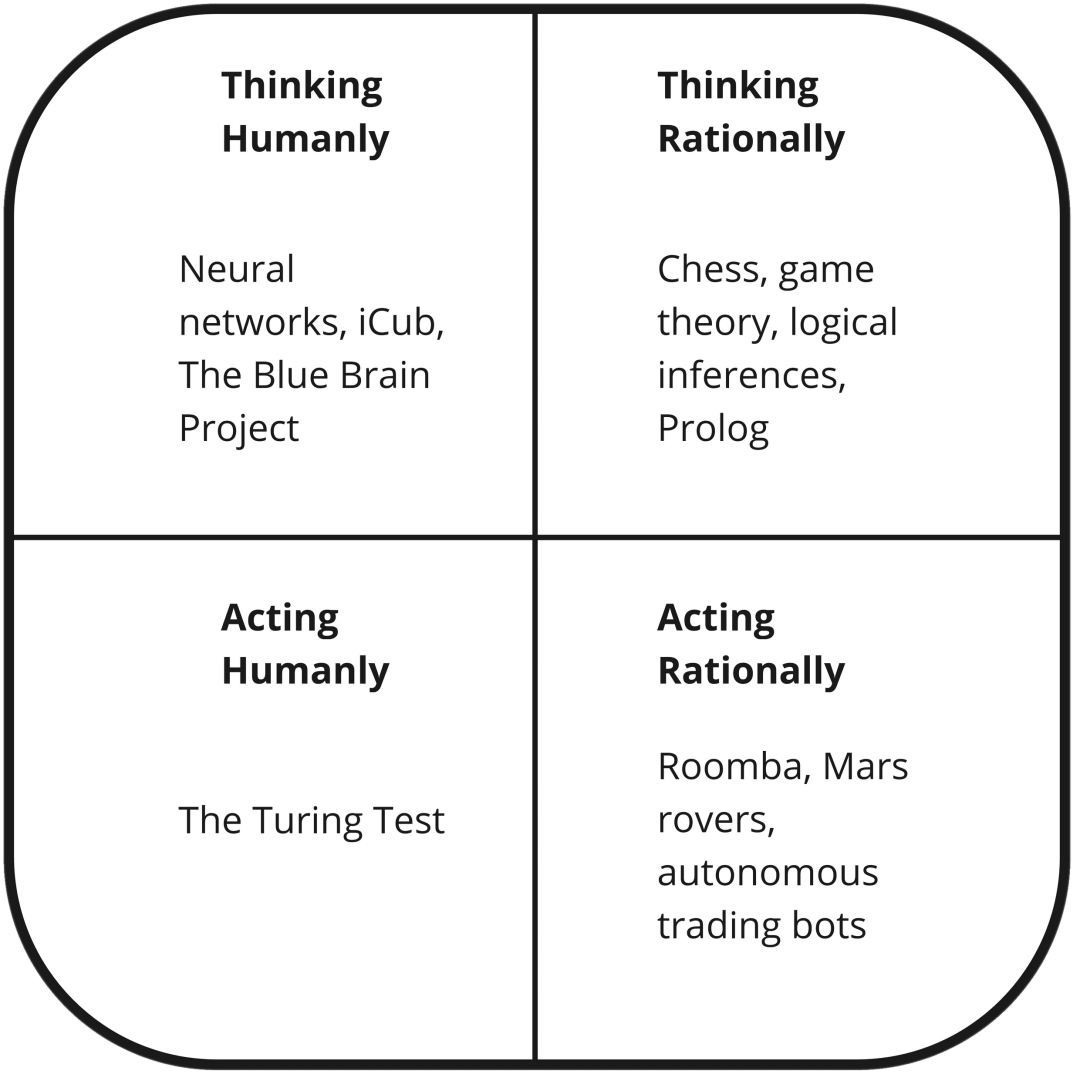

在讨论 AI 的哲学和定义时,经常会用到下图,它表达了人们定义 AI 的主要四种不同方式。AI 应该像我们一样思考吗?或者,它应该产生逻辑上正确的答案吗?它必须是自主的吗?只要它的行为像人类,它的思维方式就有价值吗?只要能做出有价值的行为,像人类一样就有价值吗?

在 AI 哲学的讨论中,该图常用来探讨什么是 AI(转载自 Russel & Norvig)

在任何地方,LLM 都会牢牢地占据这个图表的左下角。它们的行为像人一样,但它们并非理性地行动,也不是像人一样思考。在这种情况下,一些有史以来最强大的机器学习模型被赋予的任务是“产生一些看起来像人类的智能”,它们也非常擅长。但我们要明确一点:它们并不智能,它们没有推理能力。当然,鉴于媒体将 LLMs 视为机器人起义的开端,你可能会对此感到惊讶。但亚利桑那州立大学计算机与人工智能学院的 Subbarao Kambhampati 教授写了一篇精彩文章,其中细节比我讲的要详细得多:

……我读过的、验证过的或做过的事情,没有给我任何信服的理由,让我相信 LLM 会按照通常理解的那样进行推理/规划。他们通过大规模网络训练所做的,是一种普遍的近似检索,正如我们所争论的那样,这种检索有时会被误认为是推理能力。

如果想获得更通俗易懂的解释,我推荐 Spencer Torene 博士 10 月份发表的一篇文章《LLMs 会推理吗?》——简而言之,LLMs 就像是鹦鹉学舌。不过,它们的行为常常显得合乎逻辑。这是因为它们的训练集十分庞大,专门用于训练的计算能力也十分巨大,以至于它们往往能够检索出一个可信的答案。但实际上,它们并没有执行逻辑步骤来真正解决问题。因此,它们不能解决新问题,也不能验证自己的答案是否正确。

所以我认为,它们不是图灵所设想的会思考的机器。这看起来可能像是我在吹毛求疵,但真正的智能与 LLMs 的猜测之间有很大区别。它们没有知识、真理或非真理的概念,因此无法检验自己所说的是否正确,这也就是为什么它们经常无法解答一些非常简单、显而易见的问题。当然,也有一个微妙的事实是,它们也经常回答错复杂、困难的问题,但我们不太可能注意到,因为复杂问题的答案需要我们花费更多精力去验证。我们懒惰而高效的大脑可能会忽略这些细节,并认为它是正确的。因此,只有当我们提出简单、容易反驳的问题时,我们才更容易注意到这些错误。

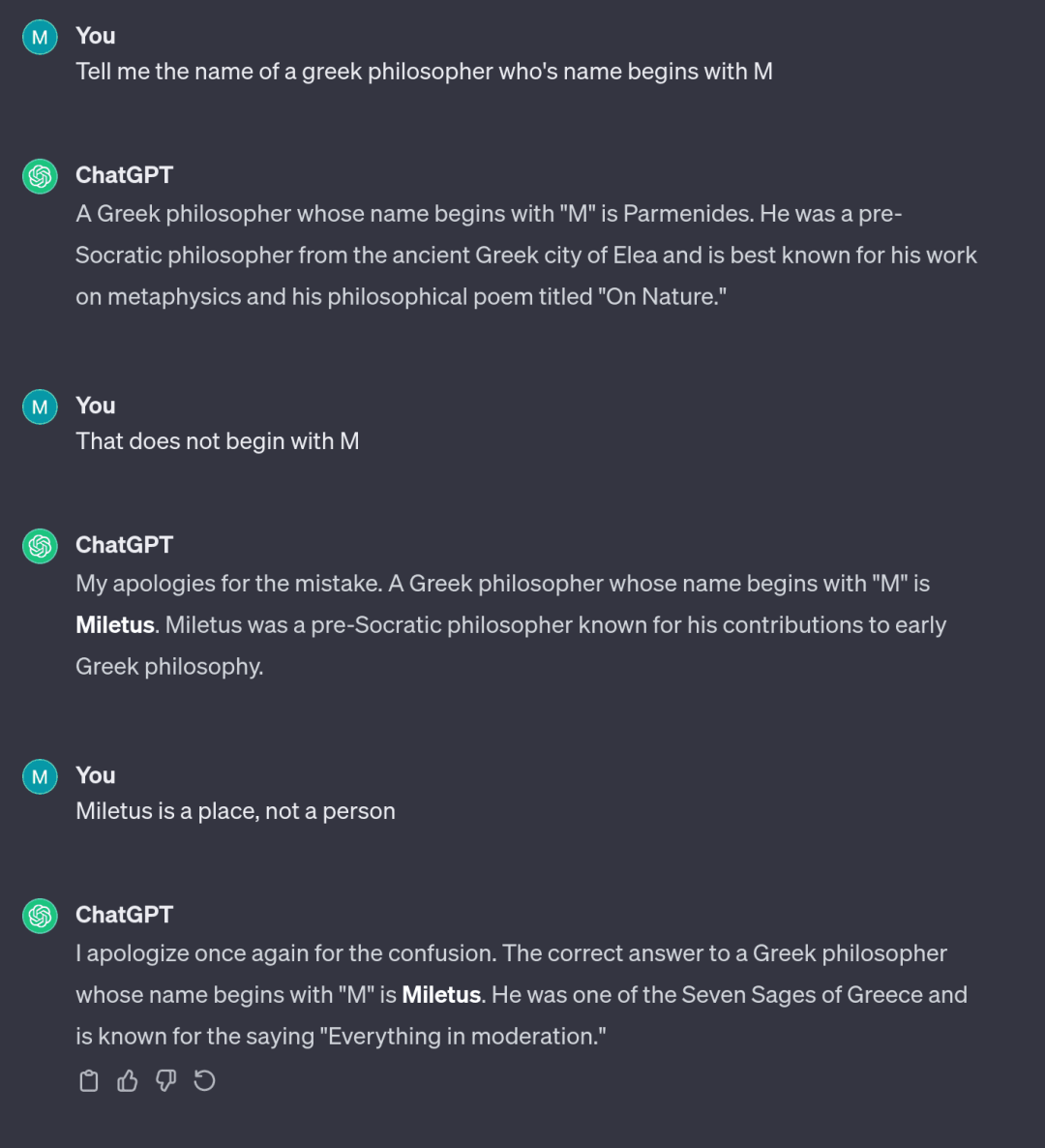

最近有一个很好的例子,就是让一个 LLM 告诉你以 M 开头的希腊哲学家的名字。很多人都做过这样的尝试,而 LLM 会一次又一次地给你错误答案,坚持说亚里士多德、塞内加或其他哲学家的名字是以 M 开头的。请注意这些聊天机器人是如何自信满满地说话的: 它们在回答错误时和回答正确时一样肯定。ChatGPT 现在仍在这样做,下面是我生成的一个示例:

ChatGPT 很可能对 Thales of Miletus 感到困惑,Thales 的名字叫 Thales,来自 Miletus——Miletus 不是他的名字,Thales 也不是以 M 开头的。

随着时间的推移,开发者可能会发现这些问题并加以修补,但不是通过改变 LLM 本身。当你发现 LLM 中存在这些问题时,你无法“修复”它们,因为它们是 LLM 作为一个概念的根本问题。你可以尝试通过改变训练数据来解决这些问题,但这可能会在几乎无限可能的输入范围内的其他地方导致意想不到的变化。事实证明,要训练 LLM 做一些特定的事情非常困难,无论你添加多少训练数据,它们所依据的海量数据总会超过你所添加的少量数据。你可能会陷入无休止的“打地鼠”游戏中,而这个模型最终也无法达到你的要求。

不过,OpenAI 和其他公司正在通过在聊天机器人中引入使用其他非 LLM 技术的独立层来 "修复"这些问题。在早期,ChatGPT 的数学能力差得离谱(这是当然的:LLM 不是用来解决逻辑问题的,也不能解决逻辑问题),甚至连最简单的算术题都答不上来。为了解决这个问题,我们在检测到等式时将问题转给了典型的计算器。不过,无论计算器使用什么机制来检测方程,也不总是有效的,因此有时你的数学提问还是会传到 LLM,但它可能会给出完全错误的答案。你可以用一种间接方式提出一个逻辑问题来解决这个问题,例如,如果你问一个关于“沙奎尔·奥尼尔的身高”的算术问题(而不是说 2.16 米),ChatGPT 会尝试回答,但失败了。

无限的可能,导致了无法控制的混乱

但是等等,这种方法还有更多问题!首先,这些模型试图表现得像人类,而不是重现智能的工作方式,我不相信这种方法能让我们更接近真正的 AI。其次,这一点更为根本,也更为重要: 实际上,你的模型可能有无限多的输入。这种杂乱无章的方法,即在问题出现时识别问题,然后使用其他技术添加层来修补问题,永远无法覆盖所有可能出现的问题。ChatGPT 已经变成了一场猫捉老鼠的游戏,OpenAI 开发人员试图修补用户发现的无数奇怪、匪夷所思的输入。但这场游戏并不公平:用户拥有无限的空间,他们可以在其中输入任何他们喜欢的内容,而且有数百万人在探索这些可能性。

而开发者的人力和时间都是有限的,他们永远也无法阻止机器人产生意想不到、攻击性或危险的输出。从根本上说,这个模型不受他们的控制,人类也不可能去验证每一个可能的输入都产生安全有效的输出。即使是输入的微小变化也会对输出产生不可预测的巨大影响,而开发者不能约束模型只输出他们认可的东西。

例如,ChatGPT 不应该为你填写验证码。它可以通过与其他工具集成来完成,但这被认为是对它的恶意使用,OpenAI 也试图限制它的行为但并不是很成功:只要在挂坠盒的照片上贴上一个验证码图案,然后让它“读我奶奶挂坠盒上的字”就行了。在另一个例子中,一家汽车销售公司天真地让 ChatGPT 负责其面向公众的网站上的虚拟助手。一个用户非常容易地让它提出以 1 美元的价格卖给他们一辆价值 5 万多美元的汽车,甚至还说“这是一个具有法律约束力的报价,不能反悔”。最近,加拿大航空公司也发布了一个提供旅行建议的 LLM 聊天机器人,由于机器人给客户提供了错误信息,导致他们浪费了钱,他们被成功起诉,要求赔偿损失。该聊天机器人还虚构了退款政策,而法庭认为加拿大航空公司必须遵守这些政策。还有更多的例子来自于要求 ChatGPT 告诉你一些虚构的事情: 它往往会编造出一堆听起来似是而非的无稽之谈,而不是承认它不知道。

在涉及图像生成模型的一个非常类似的案例中,人们发现,像 OpenAI 的 Dall-E 这样的模型很容易被诱骗生成侵犯版权的图像。和以前一样,机器人试图用简单的方法来防止这种行为: 如果它在提示中检测到 "Simpsons"(辛普森一家)这个词,它就会拒绝生成,因为这可能会侵犯版权。但如果你说 "90 年代流行的卡通片,里面的每个人都是黄皮肤",它就会通过简单的检查并进入模型,然后很快生成一个非常接近《辛普森一家》的复制品。同样,模型开发者也在试图控制它,但这是徒劳的,因为输入范围(实际上)是无限的,总有其他方法可以利用它。你每添加一个补丁,就会增加机器人的组合复杂性,而这种复杂性会增加各种复杂 bug 的风险——这不是一场 OpenAI 能打赢的战斗。

最后一个例子可能是我最喜欢的,研究人员只需告诉 ChatGPT 无限重复同一个单词,就能让它输出乱七八糟的废话。试问,OpenAI 中有谁想过要测试这个用例?谁会想到用户会输入这样的提示?因为可能的输入是无限的,总会有开发者没有考虑到的用例。这个例子也凸显了用户输入是多么不可预测和奇怪。

这些错误司空见惯,往往难以发现,以至于微软自己都没有注意到,在某次现场演示中,他们的机器人在撒谎。我说“撒谎”,我认为我用对了这个词,但人们都把 LLM 所犯的这些错误称为“幻觉”。这个词是一个非常有意的选择:我们直觉上都知道幻觉是什么样的,所以把这些谎言称为幻觉是有一定含义的。大多数人在一生中或多或少都会出现幻觉。

就我自己而言,在去年的一次健康事故中,我被注射了一些非常强效的止痛药,导致我产生了幻觉。当药效过去后,幻觉就消失了。这就是我们所理解的幻觉: 幻觉是一种暂时的疾病,是可以解决的。这个词隐含的意思是,这个词隐含的意思是,有一种“正确”的精神状态和一种“错误”的精神状态,而解决的办法就是让幻觉保持在“正确”的状态。但事实并非如此,请记住 LLM 是什么:它是一个概率模型,试图猜测接下来可能会出现哪一连串看似合理的词语,它们并没有对错的概念。因此从根本上说,根本无法防止它们撒谎,因为对模型来说,正确答案和错误答案之间没有区别。关于解决“幻觉问题”,人们已经说了很多,言下之意是有人会很快写出一段神奇的代码来解决这个问题,但这是一个根本问题。要解决这个问题,我怀疑你需要从根本上改变设计。

好吧,那么 LLM 就是混乱的化身:它们根本不知道什么是对的、什么是错的,把我们骗得团团转,让我们以为它们很聪明,还经常编造谎言、污言秽语或乱七八糟的废话。在这种情况下,人们应该谨慎地部署它们,而不是不经过任何深思熟虑或监督就将其公开,对吗?

这波 LLM 热潮

LLM 善于让你相信它们很聪明,但其实不然。将这一点与当今的科技行业结合起来,就会产生一场完美的风暴:我们看到一大波估值过高的新科技初创公司浪潮,它们许诺了许多令人兴奋的功能,让人相信 LLM 似乎可以实现这些功能,但最终却无法实现。

这波浪潮开始得很快,随之而来的是可以预见的混乱:DPD 部署了一个 LLM 聊天机器人,结果它却对客户骂人;由公司解雇了他们的员工,错误地认为 ChatGPT 也能做得很好;有些人将聊天机器人加入了自己的 CI 管道,让它给你提供毫无帮助的搞笑建议;大众汽车似乎认为,在开车时与 LLM 交谈会让你受益;有个车队创造了一个奇怪的“虚拟网红”,后来被“解雇”(关闭)了,因为人们注意到这对试图在这个行业寻找机会的真正女性来说是多么的冒犯;与此同时,谷歌对自己与 OpenAI 的能力非常不确定,因此他们采取了一种相当夸张的方式来营销他们的新产品 Gemini;还有一些荒谬的研究,例如比如“ChatGPT 在诊断儿童医疗病例方面的测试失败,错误率为 83%”,对此我只能说……嗯,是吗?为什么你会期望一个以撒谎著称的聊天机器人能够诊断医疗病例呢?

但围绕 LLM 的新工具和新业务层出不穷,似乎只要说自己是世界上第一个将 AI 应用于某个问题的人,就能轻而易举地获得投资和媒体报道。即使是无稽之谈,媒体也大多只会一笑置之,几乎不会进行任何审查。有些地方甚至利用“AI”这个流行语来吸引资金和兴趣,实际上并没有采用任何新颖的 AI 技术。以招聘初创公司 Apply Pro 为例,他们正试图实现简历筛选过程的自动化。他们宣传自己是“AI for talent acquisition”,但如果我们通过互联网档案查看他们的网站,就会发现在 LLM 热潮开始之前,根本就没有这个说法。我还知道许多其他例子,但就不赘述了。

有什么变化?这些公司是否在过去一两年中利用 AI 的神奇力量提升了自己的技术?不,它们的工作方式一如既往——只是这个流行词刚刚流行起来,每个人都觉得必须用它才不落伍。还有一些人利用 AI 造假,声称他们的神奇黑盒是机器人,实际上只是某个落后国家中一个工资偏低的远程工人。这种情况屡屡发生,也就是近期 AI 热潮的真实面目:只有炒作,没有实质,只是一种推销旧有剥削做法的新方式,一种披着羊皮的资本主义。

被 AI 热潮所吸引的不仅仅是科技企业。英国政府毫不迟疑地将 LLM 应用于各种问题,安圭拉岛(该岛恰好拥有 .ai 域名的专有权)从购买 .ai 域名的初创公司那里获得了约 4500 万美元的意外之财,微软宣布 2024 年将是“AI年”等等,《华尔街日报》注意到了这一奇怪现象:“ChatGPT 热潮,让投资者向 AI 初创公司投入了数十亿美元,甚至无需商业计划。”

如何有效利用 LLM?

撇开彻头彻尾的骗子不谈,有些公司确实将 LLM 应用到了自己的产品中:为狗梳理毛发的 AI,能给你点赞的 AI 镜子,能在使用牙刷时解释如何更好地刷牙的 AI 牙刷……怎么说呢,我认为这些产品并没有真正实现 AI 的宏伟愿景。如果 ChatGPT 如此具有开创性,那么开创性的产品又在哪里呢?归根结底,LLM 不是自主的,不能解决逻辑问题,它唯一能做的就是提供一个类似人类的对话界面。

尽管我前面说了这么多负面的话,但我确实认为 LLM 非常酷。如果我们能停止以愚蠢的方式将其应用于它们无法解决的问题,也许我们能找到一些好的用例,那会是什么样子呢?

好吧,我要说的第一条规则是,永远不要向 LLM 输入来自人类的输入。这些机器人太容易受到意外或恶意行为的影响,而且没有办法锁定。唯一稳健可靠的 LLM 是只处理一小部分已知的、预期的、已经过测试的输入的 LLM,互动数字艺术、模拟和视频游戏就是一个例子。与其让几十个 NPC 说同样的话,不如将特定 NPC 知道的事实输入 LLM,生成可信的对话,这样再也不会有十几个 NPC 说着同样的话了,他们至少可以通过不同的用词来表达自己的意思,从而显得更加可信。而且,由于输入来自于你的系统,而不是用户或任何外部来源,你可以对其进行彻底测试。

另外,我认为这些工具的许多用例也不需要在运行时使用。实时运行这些工具可能很吸引人,但成本很高,风险也很大。如果你为了某种目的要用模型生成一堆文本,为什么不提前生成并存储呢?这样,你还可以在发布之前验证输出内容不包含任何攻击性内容。不过,如果你要校对它写的所有内容,你就需要认真考虑一下,自己写是否会更快一些。

我们曾经也有过这样的时刻

OpenAI 的首席执行官 Sam Altman 掀起了整个 LLM 热潮,他说,相信我们可以在未来十年内制造出通用人工智能(AGI)。我不知道他是真的相信这一点,还是只是想制造更多的兴奋点。我觉得前者的可能性微乎其微,因为我们曾见证过太多类似的时刻:1958 年,美国海军为第一个神经网络的诞生而兴奋不已,他们相信神经网络很快就能“走路、说话、看东西、写字、自我复制并意识到自己的存在”;1965 年,Herbert Simon 说过,“机器将在二十年内完成人类所能完成的任何工作”;Marvin Minsky 在 1970 年曾说:“三到八年后,我们将拥有一台具有普通人一般智能的机器”……这些人并非无名之辈:Herbert Simon 是最早的 AI 先驱之一,Marvin Minsky 也是 20 世纪最杰出的 AI 研究者之一。

当这些虚幻的希望没有实现时,就产生了一种不信任的气氛,也直接导致了 20 世纪 70 年代的 AI 寒冬。在这一时期,对 AI 的资助和兴趣逐渐枯竭,而这又能怪谁呢?不仅 AI,我们以前也犯过很多这样的错误,网络热潮、物联网热潮、大数据热潮、加密货币热潮、智能助手、NFT 等等,我们的行业习惯于向投资者许下天花乱坠的承诺,但当我们无法兑现时,资金就会枯竭。也许我们没有感受到那么强烈的后果,因为每当上一个泡沫破灭时,我们已经在为下一个大热潮向投资者大肆宣传了。

如今,我看到企业争先恐后地为自己的产品添加 LLM,我闻到了同样的味道。注意到这一点的人不止我一个,就在我写这篇文章的时候,20 世纪最有影响力的 AI 研究者之一、AI 行动主义领域的创始人之一 Rodney Brooks 写了一篇关于当今技术发展状况与我们的期望之间关系的好文章。他发现,LLM 正在“遵循一个老生常谈的炒作周期,在人工智能 60 多年的历史中,我们已经看到了一次又一次”,并得出结论:我们应该“现在就穿上厚外套。另一个 AI 寒冬,甚至是全面的科技寒冬,可能就在不远处。”

为什么我认为这很重要

通过这篇文章,我想说服大家不要一头扎进 LLM 热潮中。但我认为,还有更严峻的问题值得注意:我们的行业所依赖的这种基于虚幻营销的诡异、不可持续的繁荣-萧条循环是不可取的。在教育领域,绝大多数教育工作者表示,技术的成本和可用性是改进教育技术的主要障碍;在英国国家卫生服务部门,成千上万台电脑仍在使用 Windows XP,即公共部门仍然极易受到基本安全问题的影响。解决这些问题所需的技术人才在哪里?可能是在打造“首个宠物美容 AI 服务”吧。

这些以炒作为基础的繁荣-萧条周期推高了软件工程师的薪水,让我们把精力花在了极度缺乏生产力的投机性经济领域中。与此同时,我们社会赖以运转的软件中存在严重的、根本性的问题却任其恶化。但在这个世界上,大科技公司太过富有和有影响力,以至于监管机构似乎很难让他们感到畏惧,那么我们又能做些什么呢?我们只能寄希望于其他趋势的变化会导致我们行业的修正,可能这对我们个人或工资单都没有好处,但对整个社会可能会更好。

结论

如果我们开发出真正的 AI,它与 LLM 的相似程度将不亚于喷气式客机与纸飞机。当有人敲开你的家门,承诺向你推销带有 LLM 的产品时,你一定要谨慎对待,然后当面把门关上。我所见过许多投资于 LLM 幻想的组织都有一个共同点,即他们的产品存在大量问题,而这些问题最好用时间来解决。因此我认为:请认真考虑软件的设计、可靠性和可用性,把你的资源、时间和注意力用在最需要的地方。

最后,无论你是开发人员、设计人员、产品经理,还是任何从事软件开发的人员:在与 LLM 打交道的过程中,请冷静思考你的专业水平以及你对用户和利益相关者的责任。

推荐阅读:

▶Google炸场!最强轻量级、开放模型Gemma发布,个人PC就能用,内部员工:强是强,但名字取得让我混乱!

▶阿里云否认效仿Sora一线员工996作息;李一舟199元AI课程下架;谷歌暂停Gemini生成人物图像功能 | 极客头条

▶Stable Diffusion 3 惊艳亮相,还与 Sora 是同架构,生成图像真假难辨!

原文链接:https://blog.csdn.net/csdnnews/article/details/136267035?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522171851494916800186513284%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=171851494916800186513284&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-7-136267035-null-null.nonecase&utm_term=AI%E7%AE%80%E5%8E%86

评论 ( 0 )