“AI在国内企业渗透率如何?”调研中Gartner向界面新闻记者提供了部分参考,截至今年4月底企业调研报告数据显示,有6%的企业已经部署了生成式AI工具,50%的企业正在试点使用或计划在半年内部署使用相关工具,这一比例高于中东与南亚企业。

不论是企业自身使用大模型训练自己的AI服务,还是内部员工使用AI工具提高生产力,当下都已逐渐演变为常态。近期,国内某互联网大厂也被传出正通过API将ChatGPT集成至内部的应用程序和服务中用以打造自己的大模型….然而,潮流的背后,潜在的安全隐患是否能够被及时识别呢?…

随着类ChatGPT人工智能技术的快速发展,ChatGPT等AI工具爆火,众多AI衍生产品的不断涌现加速渗透各行各业,逐渐演变为当今社会中不可或缺的一部分。与此同时,大型AI模型在文案处理、搜索引擎、图像识别、网站以及代码辅助编写插件等领域取得显著进展。

尽管这些AI工具在提高办公效率方面发挥了关键作用,却也带来一系列潜在风险。企业员工在使用AI工具时可能无意中将企业敏感数据粘贴或上传至AI工具中,而AI开发商在未经用户同意和授权的情况下,可能存在非法收集数据、违法售卖数据的风险,从而导致公司商业机密泄露的危险。

有公开信息报道ChatGPT曾发生过泄密事件:“三星公司在使用ChatGPT不到20天时,就发现自己的半导体设备测量资料、产品良率等数据被盗取,并存入了美国的ChatGPT数据库中,原因是员工直接将企业机密信息以提问的方式输入到ChatGPT中,从而导致相关内容进入学习数据库。”AI服务这种默认保存信息的做法使得使用AI工具存在数据泄露的风险,可能会给公司带来难以估量的损失。

因此,亿格云团队经过调研后发现,在实际使用AI工具过程中,企业往往面临着两个核心挑战:

目前公司内有多少员工正在使用可能造成数据泄露的AI工具?

是否有敏感数据可能正在或已经泄露到多少AI工具中?

出于对企业真实痛点的洞察,亿格云团队发布扩展数据防泄漏(XDLP)新功能,借助亿格云枢XDLP功能能对市面上主流的AI工具进行检测与审计,充分满足多种场景:

数据泄露风险管控:

实时检测并阻止AI工具使用过程中泄露敏感数据行为

合规审计:

对使用AI工具处理数据行为进行完整检测和审计,以符合企业合规要求

功能亮点解析

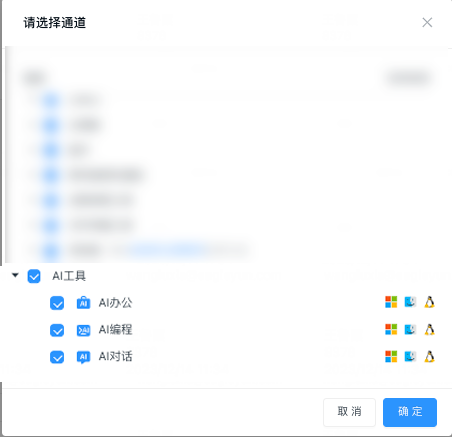

全面了解AI工具数据安全风险态势。亿格云枢内置海内外常见3000+网站域名,分为AI办公、AI对话、AI编程三大类,如常见的ChatGPT、通义千问、文心一言、百川大模型、Gemini、Copilot等AI工具。高效帮助企业管理者梳理敏感数据风险态势。

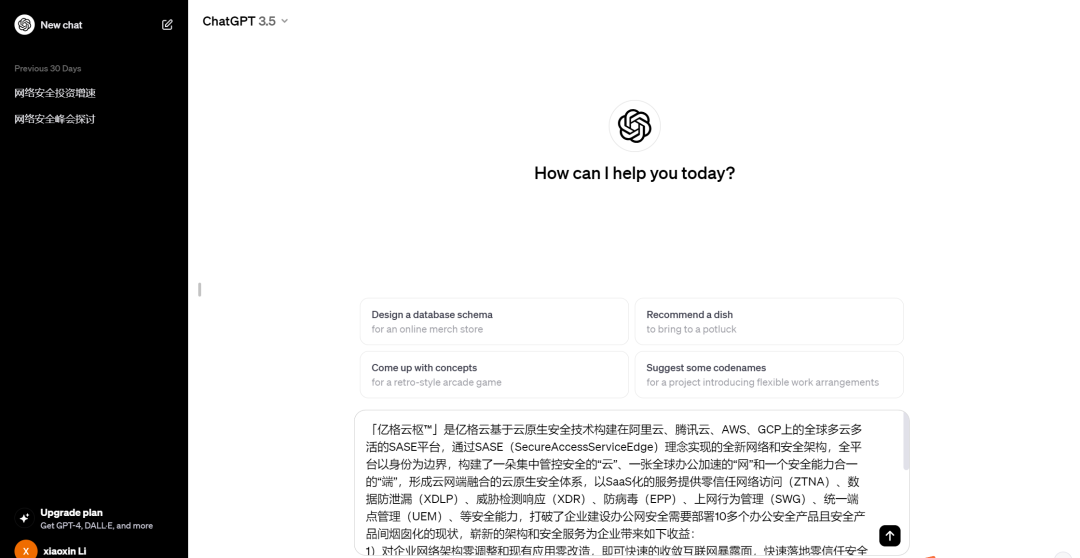

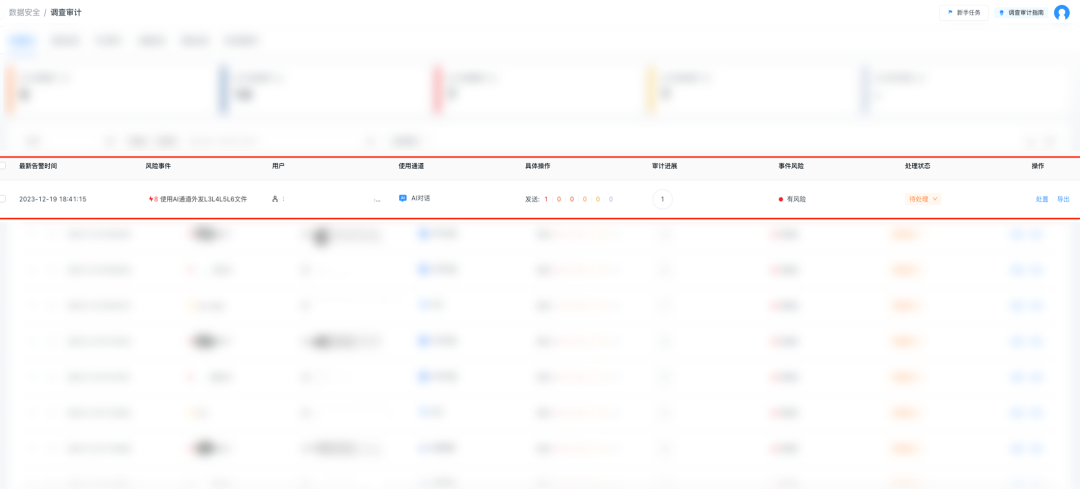

减少数据泄露风险。亿格云枢可精准识别向AI工具网站的文本粘贴、文件上传等动作,自动检测其敏感数据内容并生成告警事件,自动发现已安装代码工具IA插件的人员与终端,帮助企业管理者快速发现可能存在数据泄露的风险人员和风险事件。

(模拟用户粘贴上传敏感信息至AI工具)

(该高危风险行为产生告警)

满足数据安全保护法律法规与合规要求。确保在数据处理中符合相关法律法规,避免因违规造成更多损失。

除了能多维度对AI工具使用的识别与检测分析之外,亿格云枢对企业数据安全建设还大有裨益,包括优化企业安全策略、提高内部安全意识、减少数据泄露事件发生、降低数据泄露事件影响等。

在企业发展经营的世界里,数据安全绝无小事。负责任的对AI工具投入管理亦迫在眉睫。亿格云也将持续致力于解决企业数据安全管理中的真实痛点,打造“企业真正受用的安全产品”。实现All in One的全效安全!

原文链接:https://blog.csdn.net/Eaglecloud/article/details/135227862?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522171851551916800222824460%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=171851551916800222824460&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-6-135227862-null-null.nonecase&utm_term=AI%E5%B7%A5%E5%85%B7

评论 ( 0 )