Ollama 是一个开源的本地化大模型(LLM)部署和管理工具,核心作用是让用户轻松在本地运行、管理和交互大型语言模型(如 LLaMA、Mistral、DeepSeek等)。

与同类工具的区别

| 工具 | 特点 | 适合人群 |

|---|---|---|

| Ollama | 极简部署、开箱即用、轻量化 | 开发者、普通用户 |

| Hugging Face | 需手动配置环境,灵活性高 | 专业开发者、研究人员 |

| Docker | 容器化部署,适合复杂环境 | 运维、企业级部署 |

Ollama 是一个“极简版”的本地大模型运行工具” 核心价值是降低大模型的使用门槛,让用户无需关心技术细节,专注于实际应用(如写作、编程、数据分析)。如果你需要快速体验或轻量化部署,Ollama 是最佳选择之一。所以目前火的一塌糊涂的DEEPSEEK模型完全可以通过Ollama进行本地化部署。

但是通过Ollama进行本地化部署时,无法直接进行路径设定,默认会部署到C盘下,如何将模型下载到指定的路径下呢?

一、首先安装Ollama

1.浏览器打开Ollama,点击Download

但是一般速度很慢,甚至无法下载,那么给大家推荐一个镜像网站,我本人的Ollama就是从这里下的:Ollama download | SourceForge.net。

2.下载后双击进入,点击install安装,等待安装完成.

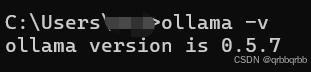

3.安装完成后Win+R,输入cmd进入,输入ollama -v并回车,显示版本号,则ollama安装成功

二、安装大模型

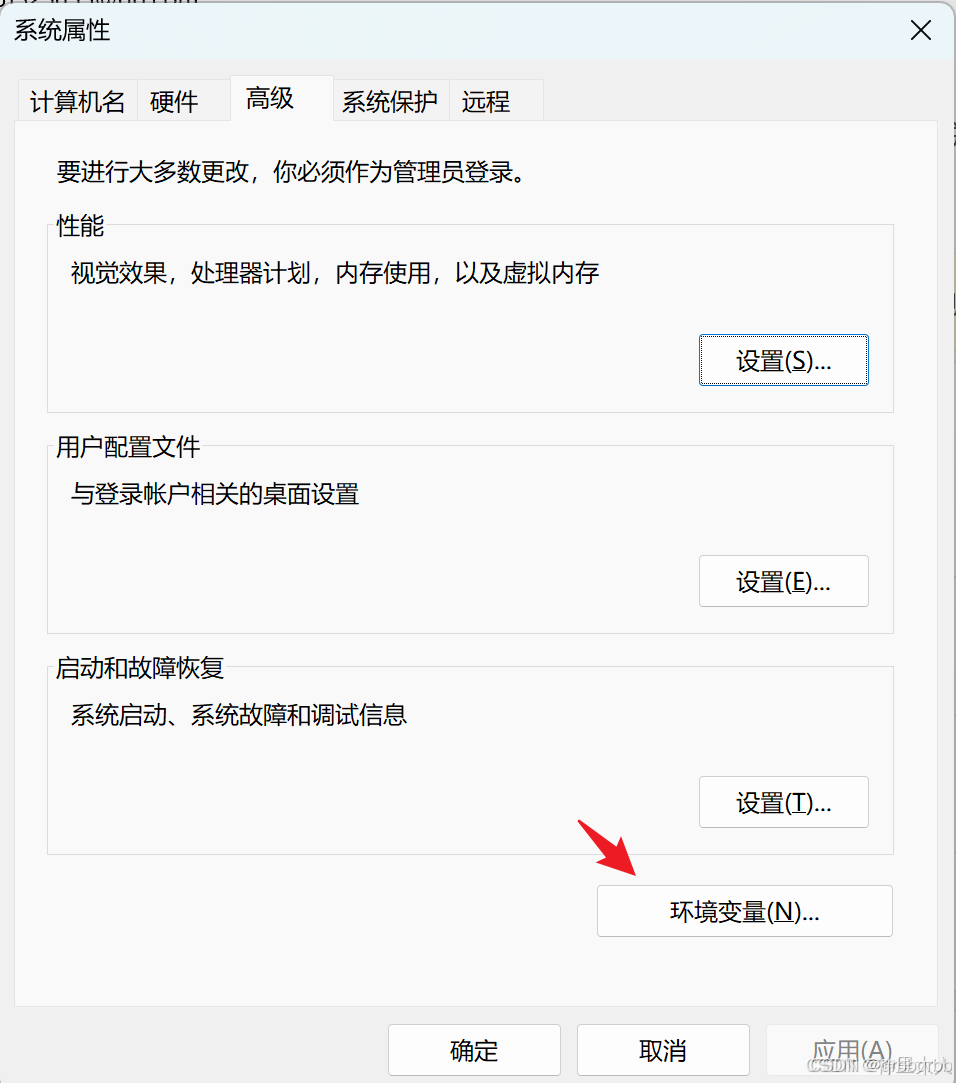

1.修改环境变量,安装大模型到D盘(默认是C盘)。Win+i进入设置,搜索【查看高级系统设置】,进入【环境变量】

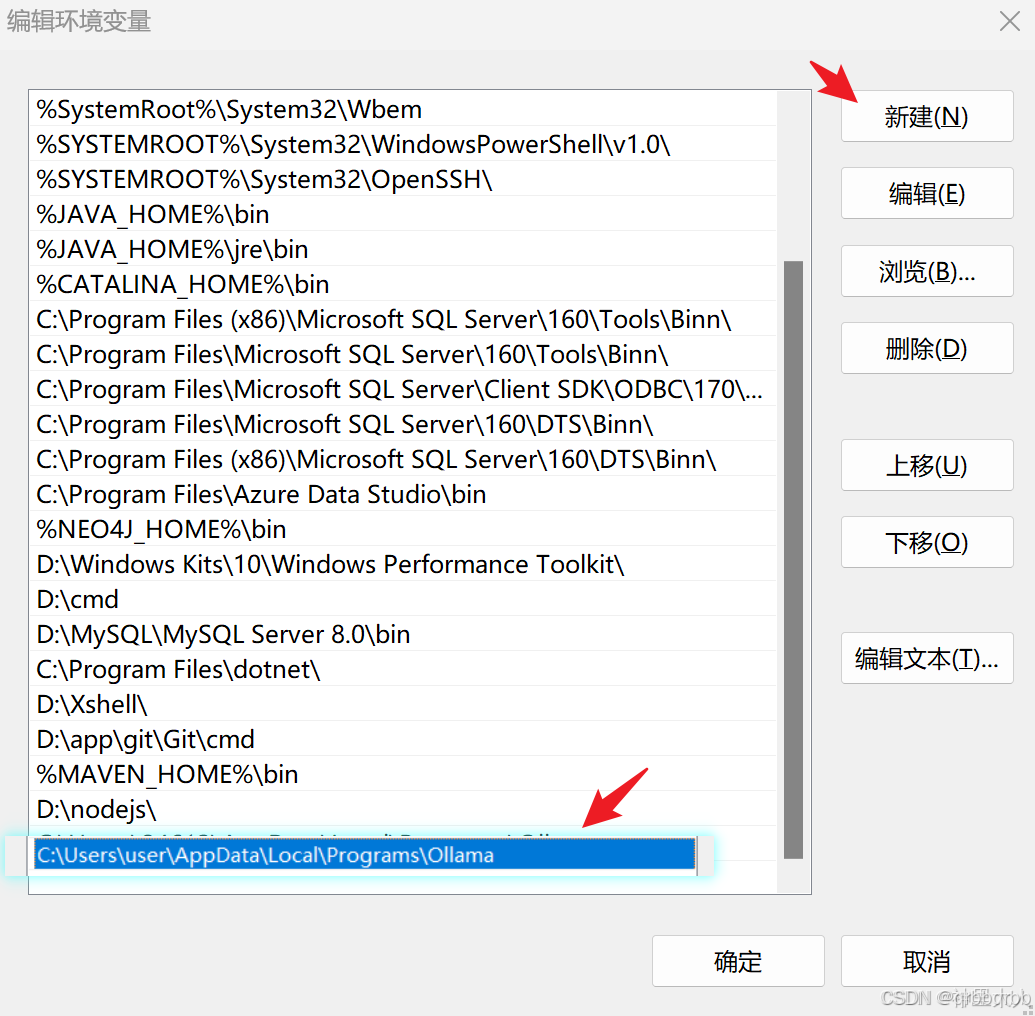

2.进入用户变量的Path,添加配置Ollama安装位置的环境变量,配置完后点击确定

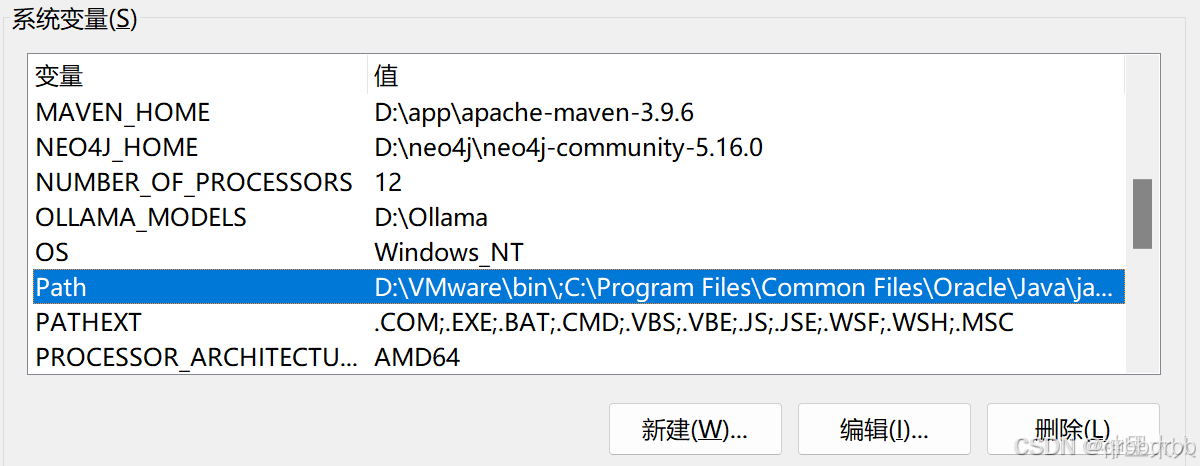

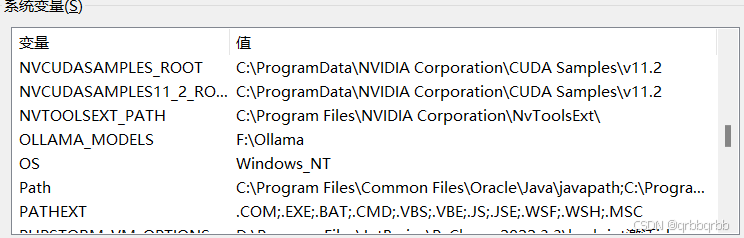

3.在系统变量栏,新建变量名OLLAMA_MODELS,设置路径,三连【确定】。注意:一定要重启Ollama!!!否则依然会安装到C盘,步骤在图片后

三、重启电脑:重启后,右下角羊驼图标运行后,在cmd下输入

ollama pull deepseek-coder:7b # 示例:下载DeepSeek-Coder 7B模型即可实现将deep seek模型保存进设置的路径下。

原文链接:https://blog.csdn.net/qrbbqrbb/article/details/145445150?ops_request_misc=%257B%2522request%255Fid%2522%253A%252292cdf893db0455a8db40cdc64431da5e%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=92cdf893db0455a8db40cdc64431da5e&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-13-145445150-null-null.nonecase&utm_term=deepseek%E9%83%A8%E7%BD%B2

评论 ( 0 )