国产大模型DeepSeek非常火,但由于访问人数过多经常频繁出现反应迟缓甚至是宕机的情况。DeepSeek是一个开源模型,我们通过本地部署在自己的终端上随时使用,而且部署到本地后无需联网即可直接使用。

一、下载并安装Ollama

进入Ollama并安装与自身操作系统一致的版本

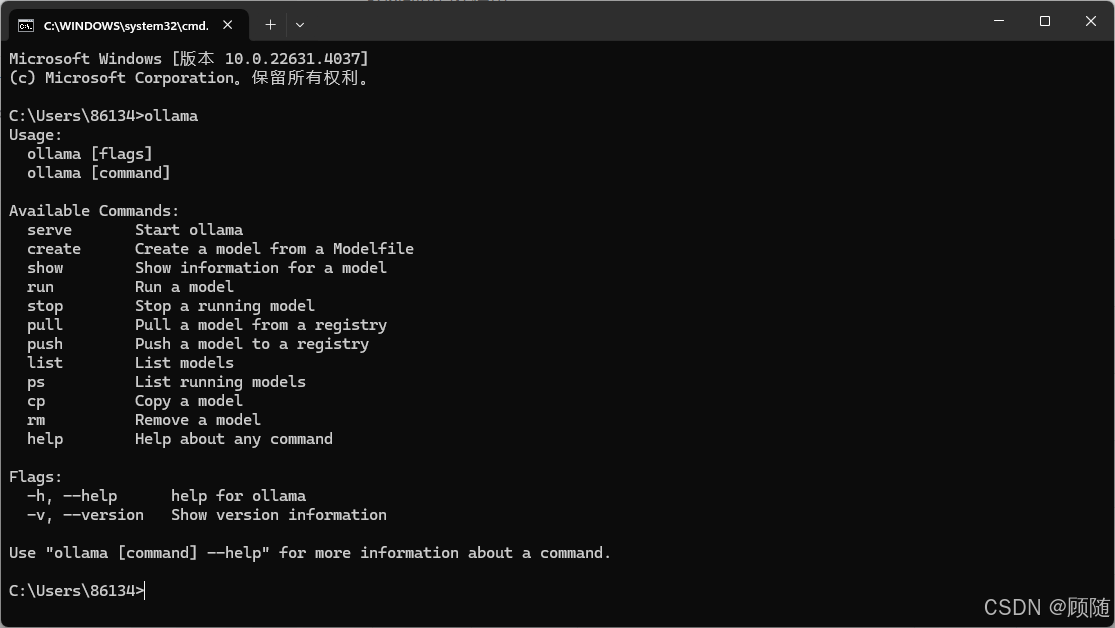

安装完毕后,按 win + R 键钮,输入 cmd。

在命令中断页面输入 ollama ,如果显示了以下信息则代表安装成功。

二、选择合适的deepseek

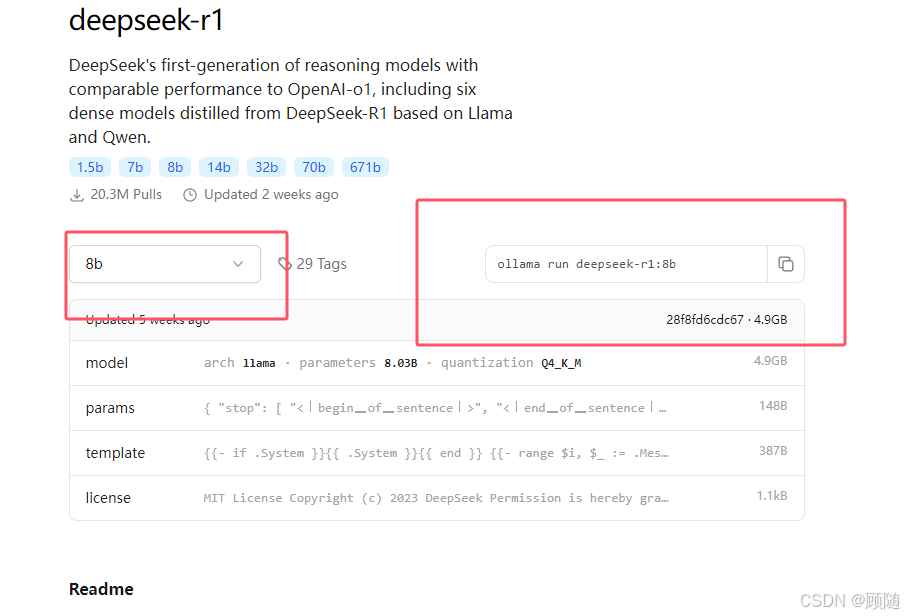

在 ollama 官网上搜索deepseek

选择合适的版本,博主使用的是 RTX 3050 16GB。选择的是8b

复制后面的代码

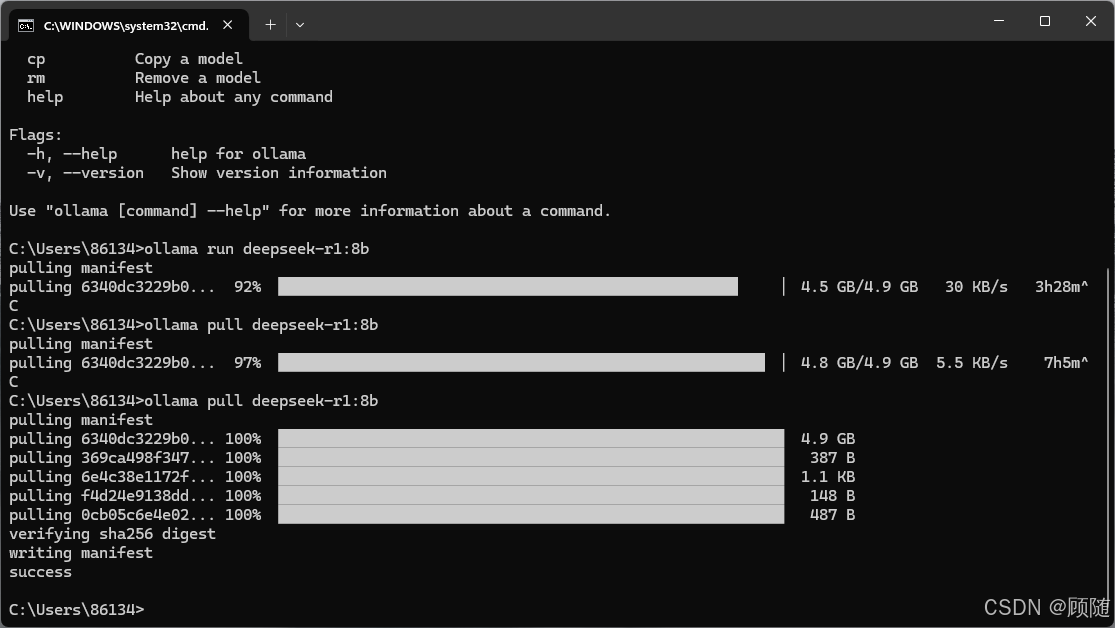

等待安装完毕

如果像我这样,最开始速度很快,后来速度变的很慢,可以使用 ctrl + C 停止,并使用 ollama pull命令,拉去,如果速度再次变慢,则重复此操作。

如果像我这样,最开始速度很快,后来速度变的很慢,可以使用 ctrl + C 停止,并使用 ollama pull命令,拉去,如果速度再次变慢,则重复此操作。

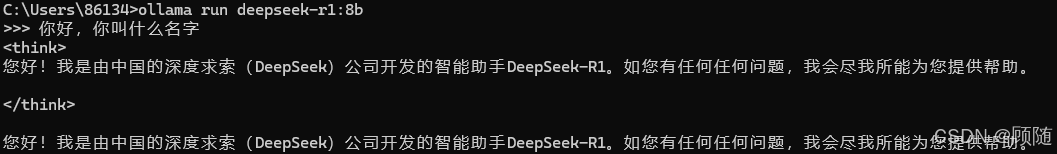

三、运行deepseek

使用 ollama run deepseek-r1:8b 来运行deepseek

四、可视化deepseek

使用 chatbox 进行可视化管理

Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

下载并安装 chatbox Ai

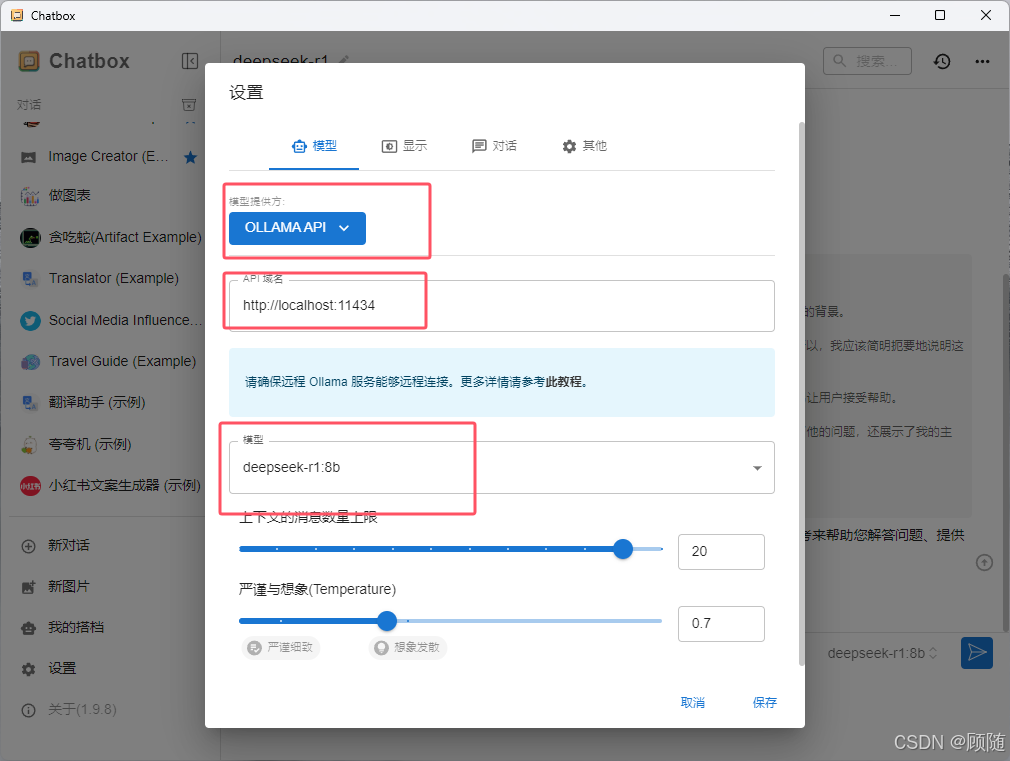

首次打开会进入设置,模型提供方选择 ollama

API域名不动

模型下拉选择刚才下载的对应的deepseek模型即可

原文链接:https://blog.csdn.net/gs2516230558/article/details/145858407?ops_request_misc=%257B%2522request%255Fid%2522%253A%25223b225299839f95f1c92386dccc58cf9f%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=3b225299839f95f1c92386dccc58cf9f&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-1-145858407-null-null.nonecase&utm_term=deepseek%E5%91%BD%E4%BB%A4

评论 ( 0 )