大模型资讯:

讯飞星火V3.0发布,面向教育、医疗领域发布AI答疑辅学、讯飞晓医等重磅产品

在10月24日举办的第六届世界声博会暨2023全球1024开发者节现场,科大讯飞董事长刘庆峰、研究院院长刘聪发布讯飞星火认知大模型V3.0,七大能力持续提升,整体超越ChatGPT,医疗领域超越GPT-4。星火3.0升级启发式对话、AI人设功能,能够打造更个性化的AI助手。

面向应用场景,讯飞星火面向行业进一步升级智能编程助手iFlyCode2.0,面向科研人员推出星火科研助手;面向学生群体,推出AI心理伙伴关爱青少年的心理健康,首次发布启发互动式英语AI答疑辅学并落地讯飞AI学习机中;面向每个家庭,发布讯飞星火医疗大模型,打造每个人的AI健康助手。此外,讯飞机器人超脑平台迎来升级,亮相业界首个大模型+具身智能的人形机器人 。

大模型也带动产业生态的繁荣。自5月6日星火发布以来,讯飞开放平台新增143万开发者团队,同比增幅331%,其中新增大模型开发者17.8万,讯飞正与10万+企业客户用星火创新应用新体验。讯飞还联合行业龙头共同发布12个行业大模型,加速产业落地。另一方面,讯飞联合昇腾生态共同发布“飞星一号”大模型算力平台,并启动对标GPT4的更大参数规模的星火大模型训练。2024年上半年将实现对标GPT-4。

郭明錤预估苹果明年斥资 47.5 亿美元采购 2 万台 AI 服务器

郭明錤近日发布市场研究简报,表示预估 2023 年将采购 2000-3000 台,在全球 AI 服务器出货量中占比为 1.3%;2024 年将采购 1.8 万-2 万台 AI 服务器,占比达到 5%。

郭明錤认为,苹果采购的 AI 服务器主要为最常见、用于训练和推理生成式 AI 的英伟达 HGX H100 8-GPU,明年第 4 季度的采购芯片会加入 B100。

每台HGX H100 8-GPU售价约为25万美元,预计苹果在2023和2024年分别需要支出约6.2亿和47.5亿美元在AI 服务器上。

微软 Edge 浏览器或正收集用户数据训练 AI

据 WindowsCentral 报道,微软的Edge 浏览器正在收集用户数据,以帮助 Copilot AI 助手实现个性化。

据悉,微软会在用户首次使用 Copilot 的时候弹窗提醒用户他们会收集用户信息,但在之后不会继续提醒。不过用户可以通过操作来关闭这项功能。用户可以在 Edge 浏览器的设置中找到 Copilot 选项,并关闭“允许微软访问页面内容 ”选项。

据悉,除了 Edge,微软还在包括 bing 等产品中加入了数据分享选项。

携程将进一步完善问答大模型,生成式 AI 融入各项产品

据华尔街见闻报道,携程全球合作伙伴峰会今日在新加坡召开,携程集团联合创始人、董事局主席梁建章宣布了生成式 AI、内容榜单、ESG 低碳酒店标准三重创新的战略方向。

AI 方面,携程进一步完善携程问答大模型,将生成式 AI 融入各项产品,基于自然语言的交互界面,提高用户体验,帮助商家降本增效;内容方面,携程将基于“每张榜单平均 500 万次的数据运算和人工校验”,打造旅游行业“可靠答案库”;ESG 方面推出可量化低碳酒店标准,全面推进环境友好、家庭友好、社区友好等。

科大讯飞联合华为推出算力底座飞星一号,讯飞星火大模型将开启大规模训练

科大讯飞董事长刘庆峰在 2023 全球 1024 开发者节上宣布,公司已联合华为打造基于昇腾生态的自主可控大模型算力底座“飞星一号”平台,在此基础上,讯飞星火大模型将开启对标 GPT-4 的更大规模训练。

据华为轮值董事长徐直军表示,今天发布的基于昇腾生态的“飞星一号”平台,让星火的训练效果翻番。刘庆峰表示,相对于万亿参数的 GPT4,目前所有大模型与之相比都仍有差距,大家要正视与 GPT4 的差距,需要从复杂知识推理、小样本快速学习等方面进行加强。大模型之战绝对是一场硬仗,绝不是靠吹牛能做成的,只有实事求是的精神才能真正实现超越。

刘庆峰现场表示,在 2024 年上半年,讯飞星火 4.0 发布将全面对标 GPT-4。

腾讯联手福佑卡车,将共创首个数字货运大模型

据腾讯云智能官方消息,腾讯近日与福佑卡车在腾讯北京总部大楼举行“数字货运大模型战略合作签约仪式”。

接下来,双方将联合共创行业首个数字货运大模型,通过大模型技术的深度应用,共同推动数字货运实现运营效率和客户体验全面提升。

腾讯和福佑卡车从货运物流证件识别大模型方向切入,目前已形成了端到端的OCR智能识别大模型能力,并针对物流证件识别、各类回单识别等场景实现了智能识别与自动处理,进一步降低运营成本,提升了服务效率。与此同时,双方也会基于腾讯云行业大模型能力,在智能客服、运营分析等场景逐步展开合作。

重点论文:

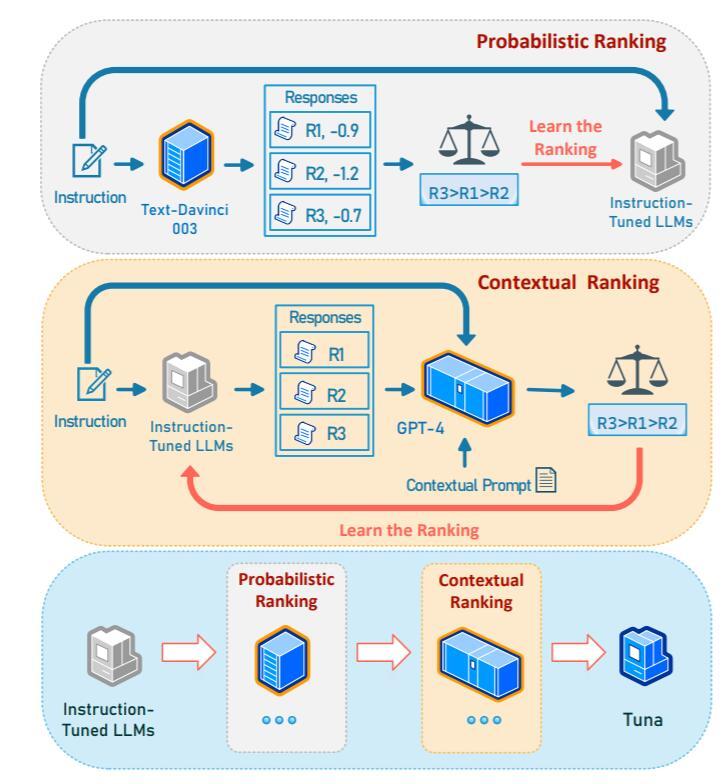

新加坡科技设计大学联手清华、微软研究院,推出大模型调优方法 Tuna

据 Arxiv 页面显示,一支由来自新加坡科技设计大学、微软研究院和清华大学的研究者所组成的研究团队今日发布了一款名为 Tuna 的提起有方法,让模型可以使用大语言模型的反馈进行指令调整。

研究团队使用其新颖的概率排名和上下文排名方法来微调指令调整后的 LLM,以增加生成更好响应的可能性。概率排名使指令调整后的模型可以从高阶大模型处继承高质量和低质量响应的相对排名。另一方面,使用上下文排名学习允许模型使用更强大模型的上下文理解能力来精炼其自己的响应分布。

据研究团队表示,Tuna 在Super Natural Instructions(119 个测试任务)、LMentry(25 个测试任务)、Vicuna QA 等任务上均表现出色。

论文地址:https://arxiv.org/pdf/2310.13385.pdf

原文链接:https://www.pingwest.com/w/289468

评论 ( 0 )