机器之心报道

编辑:陈萍、小舟

根据广大网友的反馈,GPT-4 好像真的变笨了。

距离 OpenAI 最初发布 GPT-4 已经过去差不多 4 个月的时间了。然而,随着时间的推移,近期,网上开始出现了一些质疑声,他们认为世界上最强大的 GPT-4 变得不那么强大了。

有些业内人士认为,这可能和 OpenAI 对该系统的重大重新设计有关。

其实,最近几周,我们或多或少的在网上看到 GPT-4 的用户们对其性能下降怨声载道,有用户称这个模型与其先前的推理能力以及其他输出相比变得「懒惰(lazier)」和「愚笨(dumber)」。

不仅如此,在 Twitter 和 OpenAI 的在线开发者论坛的评论中,用户们表达了对这一问题的不满,例如 GPT-4 的逻辑能力减弱、错误回答增多、对提供的信息失去追踪能力……

GPT-4 到底变得如何了,我们看看网友反馈。

GPT-4「变笨」,抱怨声不断

一位使用 GPT-4 进行网站开发的网友写道:「现在的 GPT-4 非常令人失望。那感觉就像你开了一个月的法拉利,它突然变成了一辆破旧的皮卡车。照这样下去,我不确定我是否愿意为此付费。」

还有用户表示:「我使用 ChatGPT 已经有一段时间了,自从 GPT-4 发布以来,我一直是 GPT Plus 的付费用户。过去几天里,GPT-4 似乎在之前做得很好的事情上遇到了困难。我在使用 GPT-4 时,过去,它似乎能很好地理解我的请求。现在,它对信息的追踪能力下降了,给我提供的信息有误,而且经常误解我的问题。」

Roblox 的产品负责人 Peter Yang 在 Twitter 上声称,GPT-4 的输出速度变快了,但输出质量却更差了。例如一些简单的问题,比如让它输出更清晰简洁、更有创意的文字任务上。GPT-4 给出的结果在我看来,质量下降了:

「GPT-4 开始一遍又一遍地循环输出代码和其他信息。与之前相比,它就像脑死亡了一样。如果你没有真正见识过它之前的能力,你可能不会注意到。但如果你之前充分使用了 GPT-4,你会明显感觉到它变得更愚蠢。」另一位用户抱怨道。

「我对 GPT-4 的反应质量也有同样的问题,有谁知道一种方法来排除或纠正这种情况?」

「我确实注意到了这一点。在一天中的某些时候,它似乎只记得最近的提示。但在一整天的使用中,GPT-4 性能似乎有波动,不同时间进行尝试,感觉性能不一样。」

通过网友的反馈,看来大家都感受到了 GPT-4 变笨的事实。

从前是又慢又贵,现在是快但不准确

去年年底,OpenAI 发布 ChatGPT 震惊整个 AI 界,最初 ChatGPT 运行在 GPT-3 和 GPT-3.5 之上。3 月中旬,GPT-4 发布,并迅速成为开发者和其他科技行业人士的首选模型。

GPT-4 被认为是广泛可用的最强大的 AI 模型,具备多模态功能,可以理解图像和文本输入。根据 Lamini 创业公司首席执行官 Sharon Zhou 的说法,它虽然慢但非常准确。

然而,几周前,情况开始发生转变,虽然 GPT-4 变得更快,但性能明显下降了,这引发了整个 AI 社区的讨论,根据 Sharon Zhou 和其他专家的说法,这意味着一个重大的变化正在进行中。

他们认为 OpenAI 正在创建几个较小的 GPT-4 模型,这些模型的功能类似于大型模型,但运行成本更低。

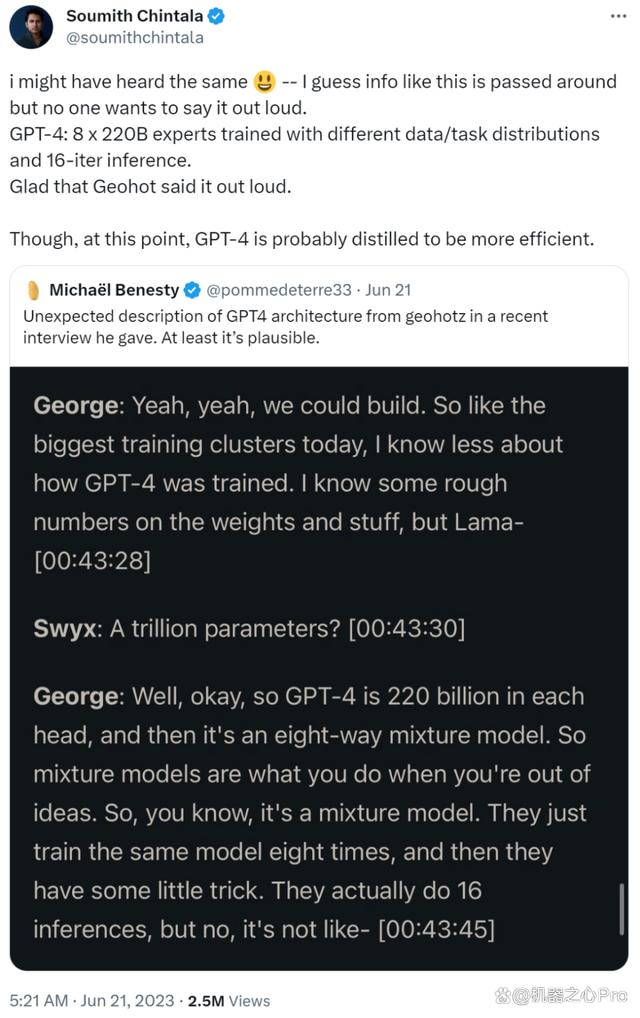

几天前 SemiAnalysis 发布的一篇付费订阅内容也谈到这一点。文中提到了 OpenAI 能够通过使用混合专家(MoE)模型来保持合理成本。他们在模型中使用了 16 个专家模型,每个专家模型大约有 111B 个参数。这些专家模型中的 2 个被路由到每个前向传递。

「这些较小的专家模型分别针对不同的任务和领域进行了训练。可能会有一个针对生物学的迷你 GPT-4,以及其他可用于物理学、化学等的小模型。当一个 GPT-4 用户提出问题时,新系统会知道将该查询发送给哪个专家模型。新系统可能会决定将查询发送给两个或多个专家模型,然后将结果合并起来。」Sharon Zhou 表示。

开发人员兼黑客 George Hotz 在最近的播客中描述了 GPT-4 是 8 路混合模型。

值得一提的是,艾伦人工智能研究所创始 CEO Oren Etzioni 在网络上看到这些信息后,给 Business Insider 发了一封电子邮件写道:「我『推测』这些猜测大致准确,但我没有证据。」

Oren Etzioni 认为:使用 MoE 方法主要是为了让生成式模型输出质量更高、成本更低、响应更快。

eEtzioni 补充道:「正确使用混合模型的确可以同时满足上述需求,但通常需要在成本和质量之间进行权衡。在这种情况下,有传闻称 OpenAI 正在牺牲一些质量来降低成本,但这只是传闻。」

实际上,2022 年 OpenAI 总裁 Greg Brockman 曾与几位同事共同撰写了一篇关于 MoE 方法的文章。

这篇文章中提到:「采用 MoE 方法,模型可以在不增加计算成本的情况下支持更多参数。」

Sharon Zhou 表示:「GPT-4 最近几周的性能下降很可能与训练和 OpenAI 推出的小型专家 GPT-4 模型有关。当用户测试它时,我们会问很多不同的问题。它不会回答得很好,但它会从我们那里收集数据,并且会改进和学习。」

https://www.businessinsider.com/openai-gpt4-ai-model-got-lazier-dumber-chatgpt-2023-7

举报/反馈

原文链接:https://baijiahao.baidu.com/s?id=1771290721863941093&wfr=spider&for=pc

评论 ( 0 )