人工智能演进过程及基本概念

人工智能的兴起,无疑是近几年科技界最为热门的话题之一,其热度已经跨越了世界的界限。

AI发展路线

一、起点:萌芽期(1940-1979)

人工智能的产生,起始于20世纪40年代至70年代之间。在此期间,学术界学者们主要致力于探索逻辑推理和计算机科学,他们通过构建模拟器,试图实现人类智能的模拟。例如,1950年图灵发表了被誉为人工智能基石的"思维理论"论文,探讨了人工智能的可能性。在此基础上,许多科研工作者苦心钻研,力图实现人工智能梦想。尽管早期的研究成果如ELEZA这样的程序还略显稚嫩,但是科技进步的种子已经埋下,人工智能的曙光初现。

二、初探:研究停滞(1980-1999)

自上个世纪八九十年代以来,人工智能进入了相当长时间的低谷期。在这段时间里,学者们在破解非线性问题的过程中,遇到了各种难题,关于 XOR 问题的解决方案意见分歧严重,导致人工智能对未来发展陷入了迷茫和质疑,研究进展相当缓慢。尽管如此,业界仍然坚信人工智能的潜力,不断朝着正确的方向前行。特别值得一提的是专家系统的出现,虽然受限于狭窄的规则系统,但专家系统以其独特的定位帮助我们更好地了解人类决策的过程。

三、新篇章的开启:21世纪伊始至今

当我们迈进新世纪的门槛,深度学习特别是卷积神经网络(CNN)和循环神经网络(RNN)的出现,给人工智能产业带来了前所未有的发展契机。人工智能的研究重点转向对图像识别、语音识别、自然语言处理等复杂任务的求解。这些优秀成果犹如绚烂的烟花在科技之夜璀璨绽放,引人瞩目。然而,随着人工智能的广泛应用,我们也必须面对新的挑战——伦理和道德问题逐渐浮出水面。这提醒我们,在推广这项新兴技术的同时,需要严格遵守安全与公平原则,避免可能的潜在风险。

GPT发展路线

初代GPT:基础和突破

初代GPT(GPT-1)由OpenAI在2018年推出,标志着基于大规模数据集和深度学习的语言模型的一个重要开始。GPT-1的核心是一个基于Transformer的模型,它通过无监督学习从巨大的文本数据集中学习语言模式。尽管它的能力有限,但这一代GPT已经展示了处理自然语言和生成连贯文本的潜力。

GPT-2:能力的飞跃

2019年,OpenAI发布了GPT-2。与其前身相比,GPT-2在模型大小和数据集方面都有显著的扩展。它包含了15亿个参数,能够生成更加流畅和连贯的文本,展示出惊人的语言理解和生成能力。这一进步不仅在技术社区引起轰动,也引发了关于AI伦理和安全性的讨论。

ChatGPT:交互式语言模型的诞生

紧随GPT-2之后,OpenAI推出了ChatGPT。ChatGPT是一种专为对话而优化的模型,能够更好地理解和响应用户输入。这一创新使得ChatGPT不仅能生成文本,还能在对话中提供有帮助的信息和娱乐性内容,从而在实际应用中大放异彩,例如在客服、教育和娱乐等领域。

GPT-3:向着更高的智能迈进

2020年,GPT-3的推出再次改写了AI语言模型的规则。拥有1750亿个参数的GPT-3在理解和生成语言方面达到了前所未有的水平。GPT-3不仅能够生成高度逼真的文本,还能进行翻译、问答、摘要、编程等多种任务,展示了AI在多模态学习方面的巨大潜力。

GPT-4:支持图像输入

在多个自然语言处理任务中的表现都比之前的版本更好,具有更强的适应性和通用性。ChatGPT 4.0可应用于多个领域和应用中,如语音助手、智能客服、虚拟人物等,其中最瞩目的便是ChatGPT-4.0相比ChatGPT-3.5在理解能力上有了很多进步,其中ChatGPT-4.0做到了能够接受图像输入,而ChatGPT-3.5只能处理文本输入和输出。

什么是N-Gram?

N-gram是自然语言处理(NLP)中的一个基本概念,用于文本建模和分析。一个N-gram是指一个序列中连续的N个项目(通常是单词或字符)。N-gram模型通过统计和分析文本中N个项的序列出现的频率,用于语言模型、文本挖掘、语音识别等领域。

定义

- 单个项:在N-gram中,每个项可以是一个字母、一个音节、一个单词或一个标记(token)。

- N的值

:N的具体值代表序列中的项目数。常见的N-gram类型包括: - Unigram (1-gram):单个项目,例如单个单词。

- Bigram (2-gram):两个连续项目的序列。

- Trigram (3-gram):三个连续项目的序列。

- 以此类推,N可以是任何正整数。

应用

- 语言模型:N-gram模型是构建语言模型的基础,用于预测序列中下一个项目(如下一个单词)的概率。

- 文本挖掘和分析:在文本分析中,N-gram可以用来识别和提取关键短语、做情感分析、检测语言模式等。

- 语音识别:在语音识别系统中,N-gram模型帮助将语音信号转换为文字。

优点和局限性

- 优点:N-gram模型简单易于实现,对于初步的语言处理任务非常有效。

- 局限性:

- 数据稀疏性:随着N的增加,可能出现的N-gram组合数量呈指数级增长,导致数据稀疏问题。

- 上下文限制:N-gram模型只能捕捉到有限的上下文信息(仅限于N个项目内的上下文)。

- 性能问题:对于复杂的语言处理任务,单纯依赖N-gram可能不足够。

尽管存在局限性,N-gram模型由于其简单性和易于实现,在自然语言处理的许多领域中仍然是一个重要的工具。随着技术的发展,更复杂的模型(如神经网络)正在被用来克服N-gram模型的一些限制。

举例:

Unigram(1-gram)

在1-gram模型中,我们只关注单个字(或词):

- 今天

- 天气

- 很

- 好

- ,

- 我们

- 去

- 公园

- 散步

- 吧

- 。

每个字都是一个unigram。

Bigram(2-gram)

在2-gram模型中,我们关注相邻的两个字的组合:

- 今天 天气

- 天气 很

- 很 好

- 好 ,

- , 我们

- 我们 去

- 去 公园

- 公园 散步

- 散步 吧

- 吧 。

这里,每一对相邻的字构成一个bigram。

Trigram(3-gram)

在3-gram模型中,我们关注相邻的三个字的组合:

- 今天 天气 很

- 天气 很 好

- 很 好 ,

- 好 , 我们

- , 我们 去

- 我们 去 公园

- 去 公园 散步

- 公园 散步 吧

在这个例子中,每一组相邻的三个字构成一个trigram。

通过这个过程,我们可以看到,随着N的增加,N-gram可以捕捉到更长的字或词序列,从而获得更多的上下文信息。然而,同时也会增加模型的复杂性和对数据的需求。在实际的自然语言处理应用中,选择合适的N值是一个关键的决策,这取决于特定任务的需求和可用数据的量。

词袋模型

词袋模型(Bag of Words,简称BoW)是自然语言处理和信息检索中的一种简单但强大的特征提取技术。这种模型的核心思想是将文本(如句子或文档)转换为一组不考虑语法和词序的词汇频次。

基本原理

- 词汇统计:在词袋模型中,首先创建一个词汇表,该表包含文本数据集中出现的所有不同词汇(通常是去除停用词后的单词)。

- 向量表示:然后,每个文本(可以是一个句子或一个文档)被转换为一个向量,该向量的长度等于词汇表的大小。每个向量的元素表示对应词汇在文本中出现的次数或频率。

示例

假设我们有两个文档:

- 文档1: "猫喜欢玩"

- 文档2: "狗喜欢跑"

假设词汇表是 {"猫", "狗", "喜欢", "玩", "跑"},根据词袋模型,我们可以将这两个文档表示为:

- 文档1: [1, 0, 1, 1, 0]

- 文档2: [0, 1, 1, 0, 1]

每个数字代表词汇表中相应单词在文档中出现的次数。例如,在文档1中,“猫”出现1次,“喜欢”出现1次,“玩”出现1次,而“狗”和“跑”都没有出现。

特点和应用

- 简单有效:词袋模型虽然简单,但在许多文本分类和聚类任务中非常有效。

- 缺点:忽略了词序和语法结构,可能导致信息丢失。例如,“狗追猫”和“猫追狗”在词袋模型中有相同的表示。

- 应用:广泛应用于主题建模、文档分类、情感分析等领域。

变体

- TF-IDF:一种改进的词袋模型,不仅考虑词汇在文档中的频次(TF,词频)还考虑其在整个数据集中的反文档频率(IDF)。这种方法能够减少常见词的影响,增加罕见词的权重。

词袋模型的简洁性和有效性使其成为文本分析中的一个重要工具,尽管现代方法如词嵌入和神经网络提供了更复杂和强大的方式来处理自然语言。

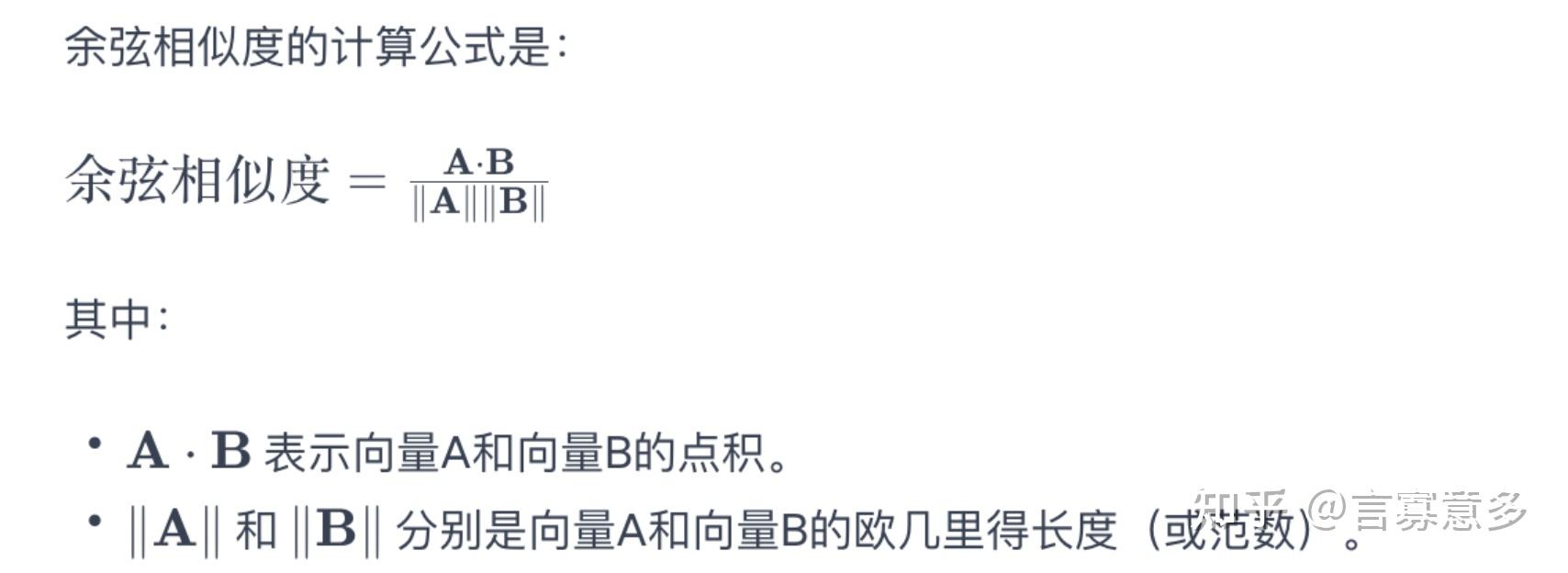

余弦相似度

余弦相似度(Cosine Similarity)是一种用于度量两个非零向量在空间中的相似度的方法。这种方法通过计算两个向量间夹角的余弦值来确定它们之间的相似性。余弦相似度的范围从-1到1,其中1表示向量完全相同,0表示两个向量独立,-1表示两个向量完全相反。

在文本处理和自然语言处理中,余弦相似度经常被用来度量文档或文本之间的相似性。例如,将文本转换为向量(例如,通过词频或TF-IDF),然后计算这些向量之间的余弦相似度,以确定文本之间的相似程度。

余弦相似度的一个重要特点是它仅考虑向量的方向而非其大小。这意味着它只衡量方向上的相似性,而不受向量长度的影响,这在很多应用场景下是有益的,因为它可以减少量纲和大小的影响。

余弦相似度在人工智能领域,尤其是在自然语言处理(NLP)和机器学习中,是一种重要的相似性度量方法。它主要用于计算两个非零向量之间的相似程度。这种相似度是通过测量两个向量之间的夹角的余弦值来确定的。在文本分析和其他AI应用中,余弦相似度具有多种用途:

文本相似度

- 文档对比:余弦相似度常用于比较两个文档或文本片段的相似性。例如,在信息检索、文档分类、抄袭检测中,可以通过计算文档向量之间的余弦相似度来评估它们的相似程度。

- 推荐系统:在推荐系统中,余弦相似度可以用于评估用户或物品之间的相似性,从而推荐相似的产品或内容。

机器学习和数据挖掘

- 聚类:在聚类分析中,余弦相似度可以帮助确定数据点的集群,尤其是在处理高维数据(如文本数据)时。

- 特征相似度:在机器学习模型中,余弦相似度有时用于衡量特征向量之间的相似度,特别是在文本和其他类型的高维数据中。

词嵌入和语义分析

- 词嵌入向量:在使用词嵌入(如Word2Vec或GloVe)时,余弦相似度常用于衡量单词之间的语义相似性。例如,可以计算“国王”和“皇后”词嵌入向量之间的余弦相似度,以确定它们在语义上的接近程度。

- 语义搜索:在语义搜索应用中,使用余弦相似度来评估查询向量与文档或文章向量之间的相关性。

优势和应用场景

- 规范化的度量:由于余弦相似度仅取决于向量间的角度而不依赖于向量的大小,它对不同长度的文档或向量的变化不敏感,适用于文本长度不一的场景。

- 灵活性和广泛适用性:余弦相似度可以应用于任何类型的向量化数据,不仅限于文本数据。

词向量

词向量是一种用于表示单词的方法,它将单词转换成数字形式,这样计算机就能够理解和处理它们。想象一下,我们要让计算机理解单词,就好比教一个外星人学习地球上的语言。外星人不懂地球语言,但如果我们把每个单词转换成它能理解的数字代码,它就能开始学习了。词向量就是这样的数字代码。

内涵

- 将单词转换为数字:词向量是一种将单词变成数字(通常是一串数字,即向量)的方法。这使得计算机能够像处理数字一样处理文本数据。

- 保持单词间的关系:这些数字不是随机的,它们以一种特殊的方式排列,以反映单词之间的关系。例如,词向量能够以数字的形式表达“国王”和“皇后”之间的关系,或者“苹果”和“橘子”之间的相似性。

使用方法

- 文本分析:在处理文本时,首先需要将单词转换为词向量。比如,在做情感分析(判断文本是积极的还是消极的)时,计算机会使用这些词向量来理解文本的含义。

- 寻找单词间的关系:词向量还可以用来找出单词间的关系,比如哪些单词意思相近,哪些单词常常在一起出现等。

- 机器翻译和语音识别:在机器翻译或语音识别等应用中,词向量帮助计算机理解单词的意思,从而更好地翻译语言或识别语音指令。

词向量就像是给单词制作的身份证,上面的数字帮助计算机理解单词的含义和单词之间的关系。这种方法让计算机能够像处理数学问题一样处理语言问题。

词向量的例子

假设我们有三个单词:“猫”,“狗”和“汽车”。我们可以使用一个简单的方法来为这些词生成向量。比如:

- 猫:[1, 0, 0]

- 狗:[0, 1, 0]

- 汽车:[0, 0, 1]

在这个非常简单的例子中,每个单词被表示为一个有三个元素的向量。每个向量只在一个位置上是1,其他位置都是0。这种表示方法叫做“独热编码”(one-hot encoding),它是最简单的词向量形式。但实际中,词向量通常更复杂,能够捕捉更多词之间的关系。

Skip-Gram模型

Skip-Gram模型是Word2Vec的一种实现,它通过学习预测给定单词的上下文,从而生成词向量。这些向量能够捕捉词汇间复杂的语义和语法关系。下面是一个简化的Skip-Gram模型的代码示例:

pythonCopy code import gensim.downloader as api from gensim.models import Word2Vec # 加载预训练好的词向量模型,这里使用Gensim库提供的一个示例模型 model = api.load('glove-wiki-gigaword-50') # 选择一个较小的模型,例如GloVe的50维版本 # 选择一些单词来查看它们的词向量 words = ['king', 'queen', 'car', 'bike'] # 打印这些词的向量 for word in words: print(f"Word: {word}") print(f"Vector: {model[word]}") print("------")这段代码使用了Gensim库和一个预训练的GloVe模型,来展示几个单词的词向量。这些向量是在大量文本上训练得到的,它们捕捉了词与词之间的语义和语法关系。

实际上,Skip-Gram模型的训练过程涉及到大量的文本数据和深度学习技术。它通过优化模型参数使得对于每个目标单词,模型能够尽可能准确地预测其上下文中的单词。通过这个过程,模型学会了将语义和语法信息编码到词向量中。

注意:运行上述代码需要安装Gensim库和网络连接以下载模型。这个模型是一个简化的例子,用于说明Skip-Gram的基本概念。在实际应用中,可能需要更大的模型和更复杂的训练过程。

什么是NPLM(Neural Probabilistic Language Model)?

NPLM,即神经概率语言模型,是一种利用神经网络来预测下一个单词出现的概率的模型。简单来说,NPLM像是一个猜词游戏的高级玩家。比如你给它一段话的开头,它可以根据已有的单词来猜测下一个单词是什么。例如,如果你说“今天天气真”,NPLM可能会猜测下一个单词是“好”或“不好”。

NPLM的特点是利用神经网络捕捉单词之间的复杂关系,从而更准确地预测下一个单词。

什么是LSTM(Long Short-Term Memory)?

LSTM,长短期记忆网络,是一种特殊类型的神经网络,专门设计来处理序列数据,比如文本或时间序列数据。LSTM的独特之处在于它能够记住序列中的长期依赖关系。这就像是阅读一本小说时,你能够记住之前章节中发生的事情,并用这些信息来理解当前的情节。

例如,在处理句子时,LSTM可以记住句子的开始部分,并使用这些信息来帮助理解句子的后面部分。

NPLM和LSTM之间的关系

NPLM和LSTM之间的关系可以这样理解:NPLM是一个总体的框架或目标(即使用神经网络预测下一个单词),而LSTM是实现这个目标的一种工具或方法(即一种特殊的神经网络,能够记住并利用长期的信息)。

在实际应用中,LSTM经常被用作NPLM中的核心组件,因为它擅长处理和记忆语言中的长期依赖关系。比如,在预测一个长句子中的下一个单词时,LSTM能够利用它对前面句子部分的“记忆”,来做出更准确的预测。

损失函数

损失函数(Loss Function)在机器学习和深度学习中是一个非常重要的概念。它是一个用来估量模型的预测值与真实值之间差异的函数。简单来说,损失函数就像是一个评分标准,它告诉我们模型的预测有多差。

损失函数的作用

- 性能评估:损失函数衡量了模型的预测结果与实际数据之间的误差。损失越小,表示模型的预测越准确。

- 模型训练:在训练过程中,目标是最小化损失函数。通过调整模型参数(如神经网络中的权重),可以减少预测误差,提高模型的准确性。

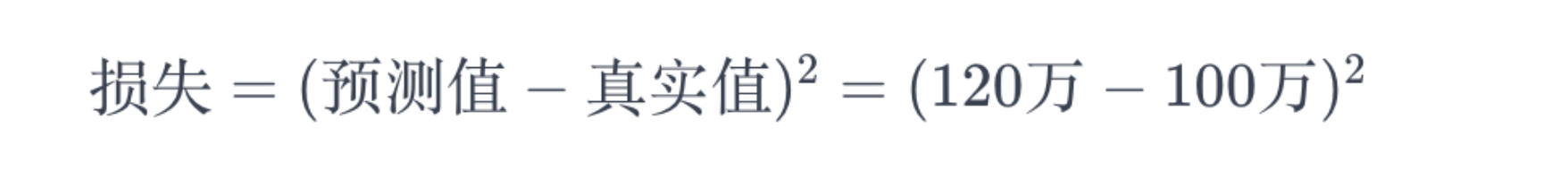

举例说明

假设你正在训练一个模型来预测房价。你的模型会根据一些输入数据(如房屋的大小、位置、年龄等)来预测房价。

- 真实值:实际的房价,比如说某个房子的实际售价是100万。

- 预测值:你的模型对这个房子价值的估计,比如说模型预测这个房子的价值是120万。

在这个例子中,损失函数会计算预测值(120万)和真实值(100万)之间的差异。这个差异就是损失。常见的损失函数有均方误差(Mean Squared Error, MSE),如果使用MSE,那么损失计算为:

训练过程中,我们通过调整模型的参数来尽量减小这个损失值,使模型的预测更接近实际的房价。

常见的损失函数

- 均方误差(MSE):用于回归问题,计算预测值与真实值之差的平方。

- 交叉熵损失:常用于分类问题,特别是在处理二分类或多分类问题时。

- 绝对误差:另一种用于回归的损失函数,计算预测值与真实值之差的绝对值。

损失函数在机器学习和深度学习中扮演着衡量模型性能和指导模型训练的关键角色。通过最小化损失函数,我们可以使模型的预测更加准确。

原始的NPLM使用效果如何,有哪些局限性

原始的神经概率语言模型(NPLM)在推出时相比于传统的统计语言模型,如N-gram模型,确实展示了一些显著的优势。不过,它也存在一些局限性。以下是NPLM的效果和局限性的概述:

效果

- 更好的语义捕捉能力:NPLM能够更有效地捕捉词语之间的复杂关系,包括语义关系,这是传统模型难以做到的。

- 泛化能力:由于NPLM利用神经网络进行学习,它具有更好的泛化能力,能够处理未在训练集中直接出现的词组合。

- 长距离依赖:NPLM相较于简单的N-gram模型,在一定程度上能够处理语言中的长距离依赖问题。

局限性

- 计算复杂度:原始的NPLM由于涉及到复杂的神经网络计算,其训练和使用的计算复杂度较高。

- 训练数据需求:NPLM需要大量的训练数据来有效学习词语间的关系,这在数据受限的情况下可能是一个问题。

- 时间消耗:与传统的统计模型相比,NPLM在训练和预测时通常需要更多的时间。

- 长距离依赖的限制:尽管比N-gram模型好,但原始的NPLM在处理非常长的依赖关系时仍有限制。

发展

随着时间的推移,为了克服这些局限性,出现了更先进的模型和技术,如长短期记忆网络(LSTM)和Transformer架构。这些模型在处理语言中的长距离依赖和复杂语义关系方面比原始的NPLM有显著的提升,同时也在计算效率上取得了改进。

原始的NPLM是神经网络在语言模型中应用的重要起点,它为后续更高级的模型和技术的发展奠定了基础。

RNN

循环神经网络(Recurrent Neural Network,简称RNN)是一种专门用于处理序列数据的神经网络。它的核心特点是网络中存在着循环,这使得信息可以在序列的不同部分之间传递。

RNN的基本原理

在传统的神经网络中,所有的输入和输出都是独立的。但在RNN中,为了处理类似语言这样的序列数据,网络会记住前一个时刻的信息,并利用这些信息影响当前时刻的输出。这种循环结构使得RNN在处理时间序列数据或任何顺序数据时非常有效。

RNN的典型应用

- 语言建模和文本生成:RNN可以用于语言模型,通过学习文本中的单词顺序,它可以生成连贯的文本。例如,给定一个词序列的开始,RNN可以继续生成后续的文本。

- 机器翻译:RNN能够处理不同长度的输入序列,并生成新的序列,使其适合机器翻译任务。

- 语音识别:在语音识别中,RNN可以用于将语音信号序列转换成文字。

- 时间序列分析:在金融、气象等领域,RNN可以用于预测未来的趋势或模式。

举例说明

假设你正在使用RNN来生成文本。你给网络输入了一个句子的开始:“在一个遥远的国度,有一个”。RNN会分析这个序列,然后预测下一个最可能的单词,比如“王子”。接着,它会把“王子”作为新的输入,再生成下一个单词,如此循环下去,直到生成一个完整的故事。

RNN的局限性

尽管RNN在处理序列数据方面非常有用,但它也有一些局限性,主要是“长期依赖问题”(Long-Term Dependencies Problem)。这个问题是指RNN在处理长序列时,很难保留早期的信息。为了解决这个问题,后来发展出了更先进的RNN变体,如长短期记忆网络(LSTM)和门控循环单元(GRU)。

RNN由于其独特的循环结构,在处理各种序列数据方面扮演着重要角色,尽管它也有一些局限性。

RNN和GPT的不同

RNN(循环神经网络)和GPT(生成预训练变换器)是两种不同类型的神经网络模型,它们在结构、功能和应用方面都有显著的区别。下面我将分别介绍这两种模型的特点,并说明它们之间的主要差异。

RNN(循环神经网络)

- 结构特点:RNN是一种序列模型,其特点是网络中存在循环连接,使得信息可以在序列的不同部分之间传递。RNN非常适合处理序列数据,如时间序列数据或文本。

- 主要应用:RNN经常用于语言建模、文本生成、机器翻译和语音识别等任务。

- 长期依赖问题:RNN的一个主要挑战是处理长期依赖问题,即难以记忆和利用序列中较早位置的信息。

- 变体:为解决长期依赖问题,出现了RNN的一些变体,如长短期记忆网络(LSTM)和门控循环单元(GRU)。

GPT(生成预训练变换器)

- 结构特点:GPT基于Transformer架构,特别是其解码器部分。它使用自注意力(self-attention)机制来处理输入数据,这使得模型能够同时考虑序列中的所有位置,从而更有效地捕捉全局依赖关系。

- 主要应用:GPT主要用于自然语言理解和生成任务,如文本补全、文本生成、翻译和问答系统等。

- 预训练和微调:GPT通过在大量数据上进行预训练,学习了丰富的语言模式,然后可以在特定任务上进行微调。

- 处理长序列:相比RNN,GPT更擅长处理长期依赖问题,它可以更有效地整合长序列中的信息。

RNN和GPT的主要差异

- 架构:RNN是基于循环结构,处理序列数据时依赖于前一个状态的输出;而GPT基于Transformer架构,使用自注意力机制来同时处理序列中的所有元素。

- 长期依赖能力:GPT比传统的RNN更有效地处理长期依赖问题。

- 计算效率:由于自注意力机制的特点,GPT在处理长序列时通常比RNN更加高效。

- 适用性:虽然两者都适用于序列数据,但GPT在自然语言处理领域表现更为出色,尤其是在生成相关的任务上。

Seq2Seq架构

想象一下Seq2Seq架构就像一个翻译过程。这个过程分为两部分:编码器(Encoder)和解码器(Decoder)。

- 编码器:就像一个聆听者,它听一个语言的句子(比如英语),然后理解这个句子的含义。编码器的工作就是把听到的句子转换成一个内部的“思想气泡”,这个气泡包含了句子的所有意义,但不再和原来的语言绑定。

- 解码器:接着,解码器像一个说话者,它看着这个“思想气泡”,然后用另一种语言(比如中文)来表达同样的意思。解码器的工作是把这个内部的意义转换回一个具体的句子,但是用的是另一种语言。

在Seq2Seq模型中,编码器和解码器通常是由神经网络构成的,它们协同工作,将一个语言的句子转换成另一个语言的句子。这个过程就像是先理解意义,再用另一种语言表达出来。

Seq2Seq(序列到序列)架构在自然语言处理(NLP)任务中之所以具有优势,主要是因为它能够有效处理涉及到序列转换的问题,即将一个序列(通常是一串文字)转换成另一个序列。这种架构特别适合于以下类型的NLP任务:

1. 机器翻译

- 原理:Seq2Seq模型可以将一种语言的文本作为输入(编码器处理),然后输出另一种语言的对应文本(解码器处理)。

- 优势:能够处理不同长度的输入和输出序列,适应各种大小和结构的句子。

2. 文本摘要

- 原理:Seq2Seq模型用于将长文本(如新闻文章)压缩成短文本(如摘要),保留关键信息。

- 优势:能够理解原始文本的主要内容,并生成连贯、精炼的摘要。

3. 问答系统

- 原理:在问答系统中,Seq2Seq模型可以根据给定的问题(输入序列)生成答案(输出序列)。

- 优势:能够理解问题的上下文,并生成相关的、准确的答案。

4. 语音识别

- 原理:Seq2Seq模型用于将语音输入(经过预处理的音频序列)转换为文字输出。

- 优势:适应不同长度的语音输入,并能够生成准确的文字转录。

5. 聊天机器人

- 原理:在聊天机器人应用中,Seq2Seq模型处理用户的输入(问题或评论),并生成自然的响应。

- 优势:能够生成流畅自然、上下文相关的回复。

为什么在这些任务中有优势?

- 上下文理解:Seq2Seq模型通过编码器理解整个输入序列的上下文,然后解码器基于这个理解生成输出,这使得模型能够生成更准确和相关的输出。

- 灵活性:它们能够处理不同长度的输入和输出序列,这在NLP中尤为重要,因为自然语言的长度和结构变化很大。

- 记忆能力:尤其是当Seq2Seq模型与LSTM或GRU结合使用时,它们能够记住长序列中的信息,这对于理解复杂的语言结构至关重要。

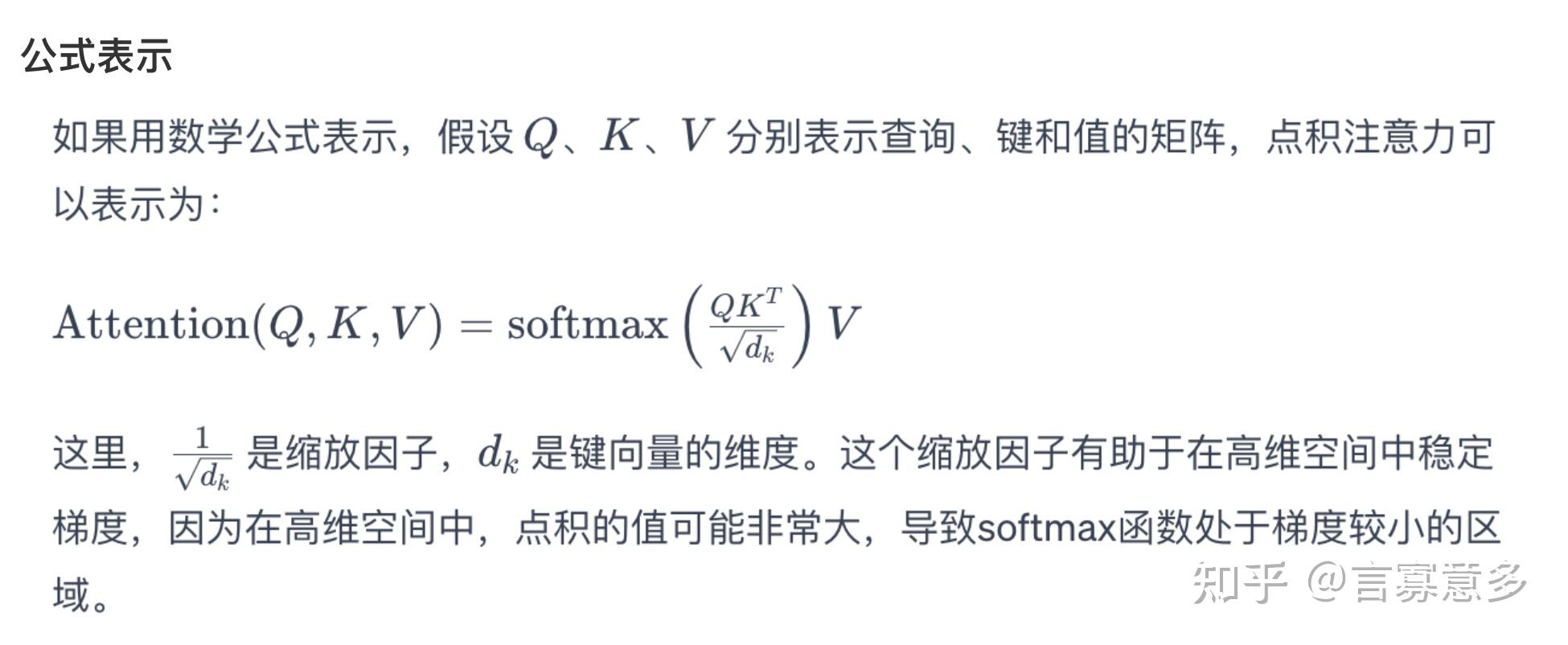

点积注意力

点积注意力(Dot-Product Attention),也被称为缩放点积注意力(Scaled Dot-Product Attention),是一种在神经网络中用于计算注意力权重的机制。它是Transformer模型中的一个关键部分,Transformer模型在自然语言处理领域特别流行,用于任务如机器翻译、文本生成等。点积注意力的核心思想是基于输入的不同部分计算注意力分数,然后根据这些分数聚焦于输入中更重要的部分。

工作原理

点积注意力涉及以下三个主要组成部分:

- 查询(Query)

- 键(Key)

- 值(Value)

在点积注意力机制中,我们首先计算查询(Query)和键(Key)之间的点积,用于表示查询和键之间的相似度。然后,这些点积通常会经过缩放处理(特别是在维度较高时),接着应用一个softmax函数来得到注意力权重。最后,这些注意力权重会与值(Value)相乘,得到加权的输出,这个输出代表了网络在特定查询下应该关注的信息。

公式表示

应用

点积注意力(尤其是在Transformer模型中)使得神经网络能够更加聚焦于输入数据的重要部分,提高了模型对序列数据的处理能力。这种注意力机制在自然语言处理任务中尤其有效,如机器翻译、文本摘要、问答系统等,它帮助模型更好地捕捉长距离依赖和理解复杂的语言结构。

想象一下你在阅读一本故事书,但你没有时间读完整本书,所以你想快速找出书中最重要和最有趣的部分。点积注意力(Dot-Product Attention)就像是你大脑中的一个神奇助手,帮你在阅读时找出最关键的信息。

这个过程可以这样想象:

- “查询”:你脑中的一个问题,比如“这个故事的主要情节是什么?”

- “键”:书中每个句子或段落的“标签”,帮助你识别它们是否包含你想要的答案。

- “值”:书中每个句子或段落的实际内容。

点积注意力的工作就像是用你的“查询”(问题)去匹配所有的“键”(标签),找出哪些“键”与你的问题最匹配。然后,它会告诉你这些匹配的“键”对应的“值”(内容)是最重要的。这样,你就可以直接阅读这些最关键的部分,而不是整本书。

用更简单的话来说,点积注意力就是一个帮助你快速找到最重要信息的工具,它通过比较你的问题和书中的各个部分,确定哪些部分最值得关注。在计算机和人工智能领域,这个原理帮助机器在处理大量数据(如文本、语音)时,快速找到最关键的信息。

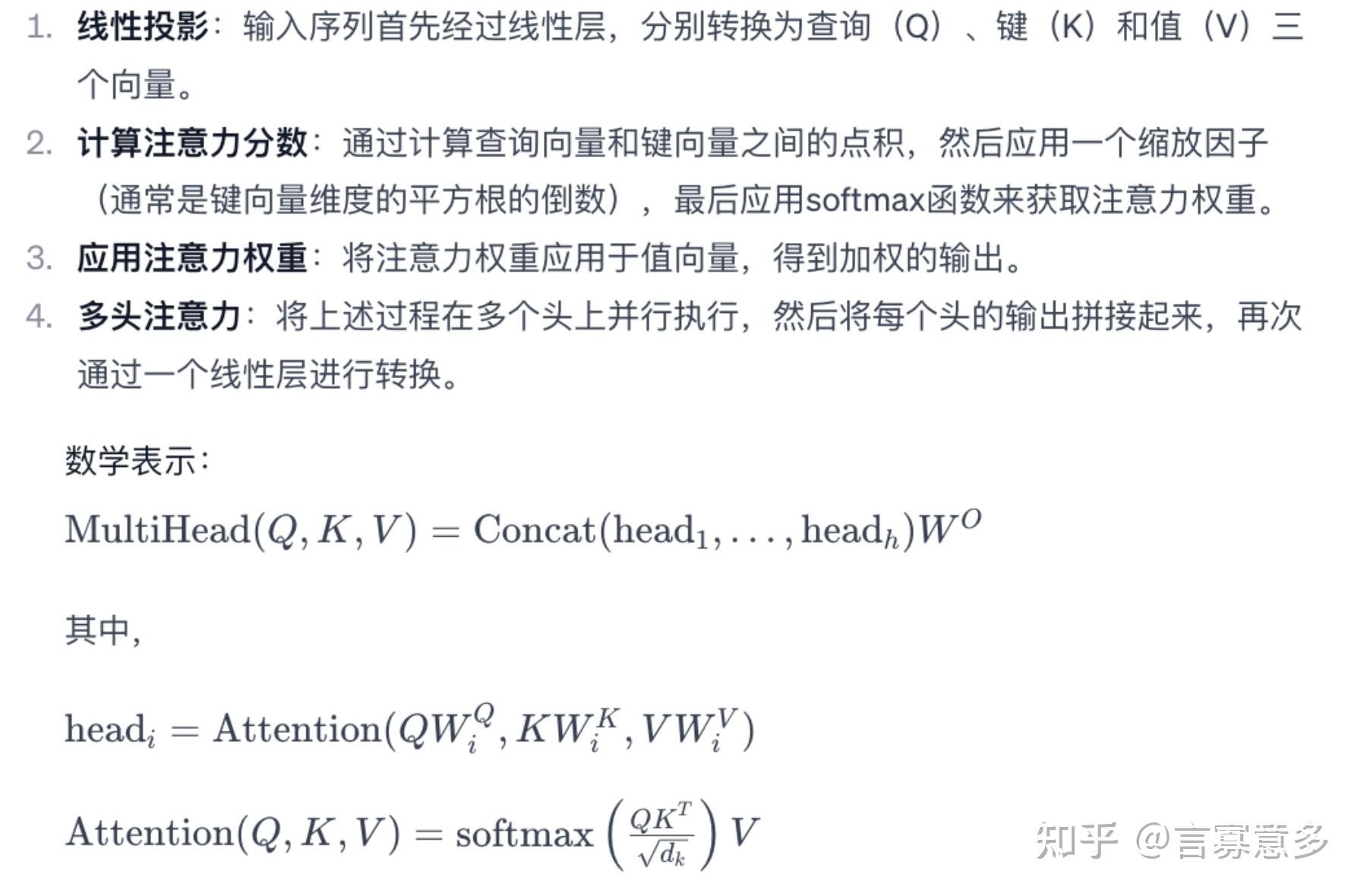

多头自注意力

多头自注意力(Multi-Head Self-Attention)是一种在深度学习,特别是在处理自然语言处理任务中常用的技术。它是Transformer模型的核心组件之一。为了理解多头自注意力,我们需要先了解自注意力(Self-Attention)的概念。

自注意力

自注意力是一种机制,它允许输入序列的每个元素(比如一个句子中的每个词)注意(也就是计算相关性)序列中的其他所有元素。这种机制使得模型能够捕捉序列内各个部分之间的关系,如单词之间的语义关联。

多头自注意力

多头自注意力基本上是对自注意力机制的一种扩展和改进。在多头自注意力中,注意力机制被分割成多个“头”,每个头独立地进行自注意力计算。这些独立的头可以被看作是不同的注意力“观察者”,每个观察者从不同的角度分析输入数据。

为什么使用多头自注意力?

使用多头自注意力的优势在于它允许模型同时从多个角度捕捉数据的不同方面,这对于理解复杂的语言结构特别有用。例如,在处理一个句子时,一个头可能专注于捕捉语法结构,另一个头可能专注于寻找词义上的联系,还有一个头可能关注句子的情感色彩。这样,模型就能获得更全面、更深入的理解。

应用

多头自注意力在许多自然语言处理任务中都非常有用,如机器翻译、文本摘要、情感分析等。它使得Transformer模型能够有效处理长距离依赖问题,并在许多任务上取得了突破性的性能。

多头自注意力通过在不同的子空间中并行地关注输入序列的不同部分,增强了模型对信息的处理能力,从而提高了在复杂任务上的表现。

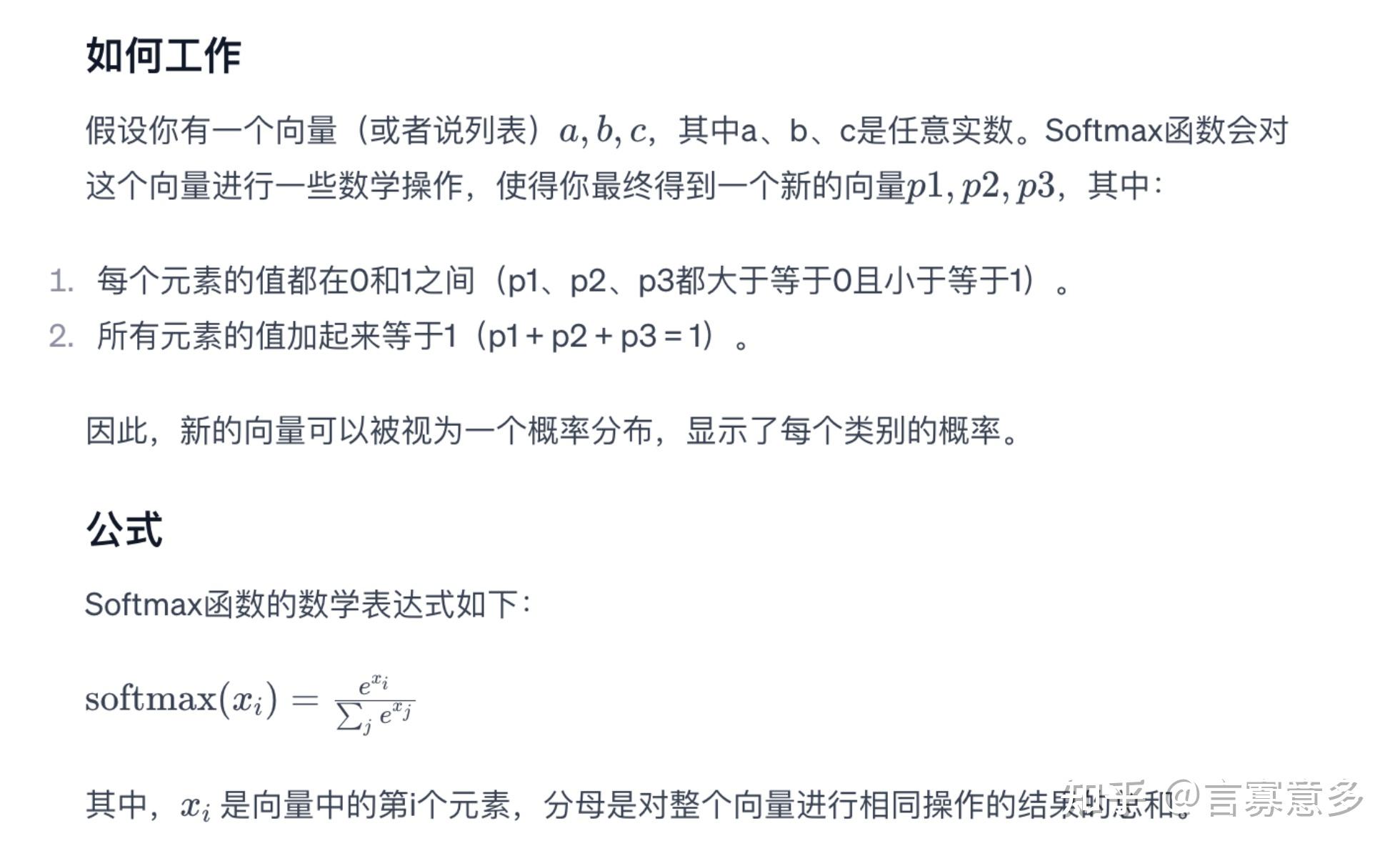

softmax函数

Softmax函数是一种在机器学习和深度学习中常用的函数,特别是在分类任务中。它的主要作用是将一个含任意实数的向量转换成一个概率分布。

应用

在机器学习中,尤其是在分类问题中,softmax函数被广泛用于最后一层,将模型的输出转换为概率分布。这对于多分类问题特别有用,因为它可以清楚地表示模型认为每个类别是正确的概率有多大。

例如,在一个识别图片中动物的模型中,模型的最后一层可能会输出一个向量,表明图片中是猫、狗还是鸟的概率。通过应用softmax函数,你可以得到每种动物出现的概率,然后选择概率最高的类别作为预测结果。

Transformer和注意力机制

Transformer是一种基于自注意力机制的深度学习模型,最初由Vaswani等人在2017年提出,主要用于处理序列数据,尤其是在自然语言处理(NLP)领域。它的创新之处在于完全放弃了传统的递归网络结构和卷积网络结构,而是依赖于注意力机制来捕捉序列内的依赖关系。Transformer是一种特别设计的神经网络结构,它在处理诸如文本翻译这样的任务时表现出色。Transformer的核心特点之一就是使用了“注意力机制”。这种注意力机制的主要作用是帮助模型在处理一段文本时,能够“关注”到最相关的部分。

注意力机制的工作原理

想象一下,当你阅读一本书或一篇文章时,并不是所有的单词或句子都同等重要。有些部分对理解全文的意思更为关键。Transformer通过注意力机制模仿了这一点。

在注意力机制中,对于给定的输入(比如一句话),模型会学会给予每个单词不同的“注意力”或者说“重视程度”。这样,模型就能够专注于那些更加重要的词汇,而不是把所有词汇都平等对待。

自注意力机制

自注意力(Self-Attention),也称为内部注意力,是一种使模型能够将不同位置的输入序列联系起来的机制。在Transformer中,自注意力的作用是对输入序列的每个位置进行编码,同时考虑到序列中的所有位置,从而捕捉这些位置之间的全局依赖关系。

多头注意力机制

Transformer模型中采用的是多头注意力(Multi-Head Attention)机制。这种机制不仅允许模型在不同的位置关注输入序列,而且还允许模型在多个表示子空间中并行地执行这种关注操作。

三个关键概念:查询、键、值

在Transformer的注意力机制中,有三个关键概念:查询(Query)、键(Key)和值(Value)。

- 查询(Query):你可以把它想象成一种问题或需求,比如在阅读句子时,“这个词是主语吗?”

- 键(Key):它们像是各种信息的标签,帮助模型决定哪些信息与查询相关。

- 值(Value):如果键表示信息是相关的,那么值就是这些信息的实际内容。

如何计算“注意力”

- 匹配查询和键:模型首先会检查每个键与查询的匹配程度。如果一个键与查询非常匹配,那么它对应的值就是重要的信息。

- 计算注意力分数:模型会为每个键计算一个分数,表示它有多匹配查询。这些分数决定了模型应该“多么关注”每个值。

- 加权和得出输出:最后,模型会根据这些分数对所有值进行加权和计算,得到最终的输出。这个输出是模型根据当前查询“关注”的信息的汇总。

Transformer中的注意力机制就像是一个智能的聚焦灯,它可以照亮文本中最重要的部分,帮助模型更好地理解和翻译语言。这种机制使得Transformer非常擅长处理语言任务,特别是那些需要理解文本中复杂关系的任务,如翻译、摘要和文本生成等。

解码器的角色

在Transformer模型中,解码器的主要作用是生成输出序列,这通常是在诸如机器翻译、文本生成等任务中需要的目标序列。解码器的每一步都产生序列中的下一个元素(比如下一个单词)。

解码器的输入序列

解码器的输入序列通常是到目前为止已经生成的输出序列的部分。在序列生成的开始阶段,这个输入可能是一个特殊的起始符号。随着解码器逐步生成更多的输出元素,这些新生成的元素就被加入到输入序列中,用于下一步的预测。

为什么称之为“输出”

- 迭代过程:在解码器中,每一步的输出成为下一步的输入。这意味着在任何时刻,解码器的输入实际上是之前所有步骤的累积输出。

- 生成目标:在任务如机器翻译中,解码器的目的是生成目标语言的文本。因此,即使在解码过程中,每个步骤的输入(到目前为止的部分输出)也是最终输出序列的一部分。

- 自回归特性:Transformer解码器通常具有自回归特性,即每一步的输出依赖于之前所有步骤的输出。这种特性使得每一步的输入(之前步骤的输出)和最终的输出序列紧密相关。

Transformer架构中的主要组件:

1. 编码器(Encoder)

Transformer模型通常包含多个编码器层的堆叠。每个编码器层主要包含以下两个子层:

- 自注意力层(Self-Attention Layer):允许编码器在处理输入序列的每个位置时查看序列中的其他位置。

- 前馈全连接层(Feed-Forward Neural Network):对自注意力层的输出进行进一步处理的简单神经网络。

每个子层后面都跟着一个规范化层(Normalization Layer),并且每个子层都采用了残差连接(Residual Connection)。

2. 解码器(Decoder)

解码器也是由多个层堆叠而成,每个层包含三个主要的子层:

- 掩蔽自注意力层(Masked Self-Attention Layer):与编码器的自注意力层类似,但添加了掩蔽机制,防止位置向后看。

- 编码器-解码器注意力层(Encoder-Decoder Attention Layer):使解码器能够关注编码器的输出。

- 前馈全连接层:与编码器中的相同。

解码器的每个子层也都有规范化层和残差连接。

3. 位置编码(Positional Encoding)

由于Transformer不使用循环网络,因此需要另一种方法来考虑单词在序列中的位置。位置编码通过将一个相对或绝对位置的信息添加到输入序列的每个位置来解决这个问题。

4. 最终线性层和Softmax层

在解码器的最后,一个线性层和一个Softmax层用于生成最终的输出,比如在翻译任务中的目标语言文本。

BERT(Bidirectional Encoder Representations from Transformers)和GPT(Generative Pretrained Transformer)是两种流行的基于Transformer架构的模型,它们在自然语言处理(NLP)领域有着广泛的应用。尽管它们都使用了Transformer的核心思想,但在训练方法、架构和应用方面有显著的不同。

BERT模型

- 双向上下文理解:BERT的主要特点是其能够捕捉双向上下文信息。这意味着在处理每个单词时,BERT考虑到了它前面和后面的所有单词。

- 预训练任务:BERT使用两种主要的预训练任务:掩蔽语言模型(Masked Language Model, MLM)和下一个句子预测(Next Sentence Prediction, NSP)。

- 使用场景:BERT特别适用于理解任务,如情感分析、问答、命名实体识别等。

- 架构:BERT仅使用了Transformer的编码器部分。

GPT模型

- 单向上下文理解:GPT是自回归的,它在生成每个单词时只考虑前面的单词(即单向上下文)。

- 预训练任务:GPT使用传统的语言模型作为其预训练任务,目标是预测下一个单词。

- 使用场景:GPT更适用于生成任务,如文本生成、机器翻译等。

- 架构:GPT仅使用了Transformer的解码器部分。

主要区别

- 上下文理解:BERT能够理解双向上下文,而GPT只能理解单向上下文。

- 预训练机制:BERT的预训练包括掩蔽语言模型和下一个句子预测,而GPT使用传统的语言模型预测。

- 适用性:BERT通常更适合于理解和分类任务,而GPT更适合于生成任务。

- Transformer的部分使用:BERT只用了编码器,而GPT只用了解码器。

小型的transformer

import torch import torch.nn as nn # 自注意力机制的实现 class SelfAttention(nn.Module): def __init__(self, embed_size, heads): super(SelfAttention, self).__init__() self.embed_size = embed_size self.heads = heads self.head_dim = embed_size // heads assert ( self.head_dim * heads == embed_size ), "Embedding size needs to be divisible by heads" self.values = nn.Linear(self.head_dim, self.head_dim, bias=False) self.keys = nn.Linear(self.head_dim, self.head_dim, bias=False) self.queries = nn.Linear(self.head_dim, self.head_dim, bias=False) self.fc_out = nn.Linear(heads * self.head_dim, embed_size) def forward(self, values, keys, query, mask): N = query.shape[0] value_len, key_len, query_len = values.shape[1], keys.shape[1], query.shape[1] # Split the embedding into self.heads different pieces values = values.reshape(N, value_len, self.heads, self.head_dim) keys = keys.reshape(N, key_len, self.heads, self.head_dim) queries = query.reshape(N, query_len, self.heads, self.head_dim) values = self.values(values) keys = self.keys(keys) queries = self.queries(queries) # Attention mechanism attention = torch.matmul(queries, keys.transpose(-1, -2)) / (self.head_dim ** 0.5) if mask is not None: # 重新调整 mask 的形状以适应 'attention' 的形状 mask = mask.unsqueeze(1).unsqueeze(2) # mask shape: [batch_size, 1, 1, src_length] mask = mask.expand(N, self.heads, query_len, value_len) # Expand mask attention = attention.masked_fill(mask == 0, float("-1e20")) attention = torch.softmax(attention, dim=-1) out = torch.matmul(attention, values).reshape( N, query_len, self.heads * self.head_dim ) out = self.fc_out(out) return out # Transformer Block class TransformerBlock(nn.Module): def __init__(self, embed_size, heads, dropout, forward_expansion): super(TransformerBlock, self).__init__() self.attention = SelfAttention(embed_size, heads) self.norm1 = nn.LayerNorm(embed_size) self.norm2 = nn.LayerNorm(embed_size) self.feed_forward = nn.Sequential( nn.Linear(embed_size, forward_expansion * embed_size), nn.ReLU(), nn.Linear(forward_expansion * embed_size, embed_size) ) self.dropout = nn.Dropout(dropout) def forward(self, value, key, query, mask): attention = self.attention(value, key, query, mask) # Add skip connection, followed by layer normalization x = self.norm1(attention + query) forward = self.feed_forward(x) out = self.norm2(forward + x) return out # 简化的Transformer模型 class Transformer(nn.Module): def __init__(self, src_vocab_size, trg_vocab_size, src_pad_idx, trg_pad_idx, embed_size=256, num_layers=6, forward_expansion=4, heads=8, dropout=0, device="cpu"): super(Transformer, self).__init__() self.device = device # Initial embedding layers self.src_word_embedding = nn.Embedding(src_vocab_size, embed_size) self.src_position_embedding = nn.Embedding(1000, embed_size) self.trg_word_embedding = nn.Embedding(trg_vocab_size, embed_size) self.trg_position_embedding = nn.Embedding(1000, embed_size) self.layers = nn.ModuleList( [ TransformerBlock( embed_size, heads, dropout=dropout, forward_expansion=forward_expansion ) for _ in range(num_layers) ] ) self.fc_out = nn.Linear(embed_size, trg_vocab_size) self.dropout = nn.Dropout(dropout) def make_src_mask(self, src): src_mask = (src != src_pad_idx).unsqueeze(1).unsqueeze(2) # src_mask shape: [batch_size, 1, 1, src_length] return src_mask.to(self.device) def forward(self, src, trg): src_seq_length, N = src.shape trg_seq_length, N = trg.shape src_positions = ( torch.arange(0, src_seq_length) .unsqueeze(1) .expand(src_seq_length, N) .to(self.device) ) trg_positions = ( torch.arange(0, trg_seq_length) .unsqueeze(1) .expand(trg_seq_length, N) .to(self.device) ) embed_src = self.dropout( (self.src_word_embedding(src) + self.src_position_embedding(src_positions)) ) embed_trg = self.dropout( (self.trg_word_embedding(trg) + self.trg_position_embedding(trg_positions)) ) src_mask = self.make_src_mask(src) out = embed_src for layer in self.layers: out = layer(out, out, out, src_mask) out = self.fc_out(out) return out # 参数和模型实例化 src_vocab_size = 10000 trg_vocab_size = 10000 src_pad_idx = 0 trg_pad_idx = 0 model = Transformer(src_vocab_size, trg_vocab_size, src_pad_idx, trg_pad_idx).to("cpu") # 随机生成一些输入数据,进行测试 src = torch.randint(0, src_vocab_size, (10, 32)) # 假设序列长度为10,批次大小为32 trg = torch.randint(0, trg_vocab_size, (10, 32)) # 同上 # 将数据移动到相应的设备(CPU,在这个例子中) src = src.to(model.device) trg = trg.to(model.device) # 使用模型进行推理 with torch.no_grad(): # 不需要计算梯度 output = model(src, trg) # 打印输出的一部分 print(output) 小型chatgpt

# chatgptlittle.py import torch from transformers import GPT2Tokenizer, GPT2LMHeadModel, AdamW, get_linear_schedule_with_warmup from torch.utils.data import Dataset, DataLoader from torch.optim import AdamW # 预训练模型和分词器 tokenizer = GPT2Tokenizer.from_pretrained("gpt2") model = GPT2LMHeadModel.from_pretrained("gpt2") # 确保分词器有一个填充令牌 if tokenizer.pad_token is None: tokenizer.pad_token = tokenizer.eos_token # 为了微调,我们需要定义一个数据集 class ChatDataset(Dataset): def __init__(self, tokenizer, chats, max_length): self.tokenizer = tokenizer self.inputs = [] self.attn_masks = [] for chat in chats: self._add_chat(chat, max_length) def _add_chat(self, chat, max_length): encoding = self.tokenizer.encode_plus( chat, add_special_tokens=True, max_length=max_length, return_tensors="pt", padding="max_length", truncation=True, ) self.inputs.append(torch.squeeze(encoding["input_ids"])) self.attn_masks.append(torch.squeeze(encoding["attention_mask"])) def __len__(self): return len(self.inputs) def __getitem__(self, idx): return self.inputs[idx], self.attn_masks[idx] # 示例聊天数据 chats = [ "Hello, how are you?|I am fine, thanks!", "What is your name?|I am a chatbot.", # 更多对话... ] # 创建数据集和数据加载器 dataset = ChatDataset(tokenizer, chats, max_length=50) data_loader = DataLoader(dataset, batch_size=2, shuffle=True) # 微调模型 device = torch.device("cuda" if torch.cuda.is_available() else "cpu") model.to(device) optimizer = AdamW(model.parameters(), lr=5e-5) scheduler = get_linear_schedule_with_warmup( optimizer, num_warmup_steps=100, num_training_steps=len(data_loader) * 3 ) model.train() for epoch in range(3): for inputs, masks in data_loader: inputs, masks = inputs.to(device), masks.to(device) optimizer.zero_grad() outputs = model(inputs, attention_mask=masks, labels=inputs) loss = outputs.loss loss.backward() optimizer.step() scheduler.step() # 保存模型 model.save_pretrained("./my_gpt_model") # main.py import torch from transformers import GPT2Tokenizer, GPT2LMHeadModel # 其他必要的导入... def generate_response(model, tokenizer, chat_history, device): # 对新的输入文本进行编码 new_input_ids = tokenizer.encode(chat_history + tokenizer.eos_token, return_tensors='pt').to(device) # 生成响应 chat_history_ids = model.generate(new_input_ids, max_length=1000, pad_token_id=tokenizer.eos_token_id) # 将生成的token ids转换为文本 response = tokenizer.decode(chat_history_ids[:, new_input_ids.shape[-1]:][0], skip_special_tokens=True) return response # 加载模型 tokenizer = GPT2Tokenizer.from_pretrained("gpt2") tokenizer.padding_side = "left" model = GPT2LMHeadModel.from_pretrained("gpt2") device = torch.device("cuda" if torch.cuda.is_available() else "cpu") # 确保分词器有一个填充令牌 if tokenizer.pad_token is None: tokenizer.pad_token = tokenizer.eos_token device = torch.device("cuda" if torch.cuda.is_available() else "cpu") model.to(device) # 用户输入 user_input = "Hello, who are you?" # 生成回复 response = generate_response(model, tokenizer, user_input, device) print(response) 原文链接:https://zhuanlan.zhihu.com/p/671413642

评论 ( 0 )