之前我们提到,人工智能技术已经逐渐渗入了学术出版领域的各个环节。尽管由于涉及隐私问题,目前学界对于在评审环节使用这一工具态度要更为谨慎。

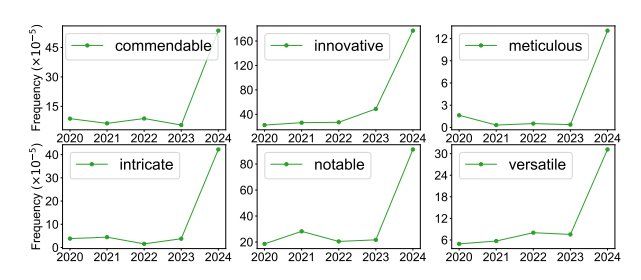

但据斯坦福大学 Weixin Liang 团队的研究显示,LLMs 在 ICLR2024、NeurIPS 2023、CoRL 2023 和 EMNLP2023 等国际顶级会议的同行评审过程中的参与已经越来越多,其中有 6.5% 到 16.9% 的评审可能经过了 LLMs 的实质性修改。

图丨ICLR 2024 同行评审中大概率由人工智能生成的词汇的出现频率变化(来源:arXiv)

鉴于 LLMs 处理文本的强大能力,从理论上来说,如果能获得如何进行评估的指导原则,大语言模型或许可以替人类完成同行评审工作,对学术文章的质量进行评判。或者,如果人类审稿人对最终报告负责,它们也可以为人类审稿人提供支持。

此前,Weixin Liang 团队的另一项研究对来自 110 个美国人工智能和计算生物学领域机构的 308 名研究人员进行了一项调查,以了解研究人员如何看待ChatGPT-4 在他们自己的论文中生成的反馈。

结果显示,超过一半(57.4%) 的用户认为 GPT-4 生成的反馈有帮助/非常有帮助,82.4% 的用户认为它比至少一些人类审阅者的反馈更有益。

图丨相关论文(来源:arXiv)

但是,如我们所知,LLM 可能会产生“幻觉”,而我们无法知道它们何时会产生幻觉,何时又非幻觉,它们也可能产生不完整的答案。

那么,它们到底能用于学术文章的同行评审吗?这或许需要一个详细的评估。

为此,科学计量学最高奖普莱斯奖得主,英国谢菲尔德大学信息学院教授Mike Thelwall于近日开展了一项研究,评估了 GPT-4 在期刊论文质量评估中的准确性,以及其是否具备自动执行这一专业任务的潜力。这项研究也是首次对 ChatGPT 专家评审能力进行准确性评估的公开测试。

评估标准与流程

关于学术文章整体质量的评估,目前学界已有一些权威的评估系统用于提供指南,例如英国的”卓越研究框架”(Research Excellence Framework,REF)、意大利 VQR(The Evaluation of Research Quality )等相关的评估标准,其准则能够给人类评审专家提供指引。

图丨REF(来源:REF)

既然人类专家能借它们来对论文质量进行评估,那么如果以这些标准指导 LLMs 进行论文评审,它们的表现又如何呢?

Thelwall 教授的研究,就首先对英国 2021 年 REF(UoA 34 组别)的评分指南进行了深入分析,以此作为评估标准。

具体而言,REF 2021 的质量评分标准主要围绕严谨性、原创性和重要性展开三个指标展开,分为五个等级:4*(世界领先)、3*(国际优秀)、2*(国际公认)或 1*(国内公认),少数成果因超出范围或质量不高而会评为 0 分。

Thelwall 以此定制了一个 ChatGPT 的评估模型,在此命名为 ChatGPT-4 REF D,用于模拟 REF 的评分流程,然后与人类专家在此之前给出的质量评估进行比较。

出于版权与隐私的考虑,他选取了自己撰写的 51 篇质量不一的学术文章作为评估对象(包括已发表的高影响力论文和未被发表的低质量论文)。

不过,需要注意的是,研究者是跟据自己以 REF 准则评估文章的结果与 ChatGPT 进行对比的,这是否有损于研究的严谨性?

对此,Thelwall 的解释是,作为向 REF 21 提交 UoA34 组别标准的负责人,他对这些标准足够熟悉,他还曾开发了传统的人工智能解决方案,用于估算与评估 REF 2021 的分数数据。

而且,他本人对自己文章的相关内容更为了解,而让他人来做这项工作有可能产生相对表面的判断。

虽然,可能和大多数学者一样,他也倾向于高估自己作品的质量。

因此,他在判断文章质量时尽量保守,打出他认为 REF 评审员可能打出的分数。

如果他对某篇文章评价很高,但它至少被一家期刊拒稿,他就会利用这一信息降低评分。因此,最终分数反映了他自己的判断,也会受到审稿人负面意见的影响。

借助这种方法,研究希望探明一下几个问题:

1. GPT-4 能否理解 REF 的研究质量评估任务,并产生合理的产出?

2. GPT-4 是否会分配 REF 研究质量的全部分数?

3. GPT-4 的 REF质量评分是否一致?

4. GPT-4 的 REF质量评分准确吗?

5. 将 GPT-4 的评分进行平均,是否会提高其准确性?

6. GPT-4 分数能区分高质量文章吗?

最初,实验使用同一个 ChatBot 对所有的文章进行评分。

因为,每篇文章都是单独上传的,因此应该分配单独的分数;而且,处理一个集合中的多篇文章,可能有助于每个 ChatBot 通过比较新文章和已有的分数来校准其评分水平。

但这很快就遇到了问题——模型产出的分数非常稳定,而且有很长的相同数字序列。这就意味着,GPT-4 在给当前文章打分时,部分依据的是同一会话中之前上传的所有文章。

因此,研究转而为每篇文章使用一个新的 ChatBot,才得以解决上述问题。

不过,在过程中,偶尔还是会出现意外状况,例如在生成结果时报告错误、无法在 3* 和 4* 之间做出决定、分别对三个维度进行评分而不进行给出总分、只分析三个评分维度而不给出分数等问题。

在排除问题,获得所有文章的分数后,研究又将这一过程重复了 14 次,以获得更多批次的分数,从而得到每篇文章更为合理可靠的平均分数。

评审结果

现在,让我们来看看 ChatGPT 的评审成果。

首先,第一个问题,GPT-4 能否理解 REF 的研究质量评估任务,并产生合理的产出?

就理解任务含义而言,GPT-4 几乎没什么困难,可以做到生成一份对文章原创性、严谨性和重要性进行严格评估的报告,并给出有效分数或分数范围。

唯一比较奇怪的情况是,在少数情况下,它会报告出不在评分等级范围内的分数,如 5* 或者 3.5*,并不符合 REF 准则。

其生成的结果大致如下

原图为英文,为了方便描述用工具翻译成中文,内容或有不准确的情况(来源:Journal of Data and Information Science)

第二个问题,GPT-4 是否分配了 REF 研究质量的全部分数?

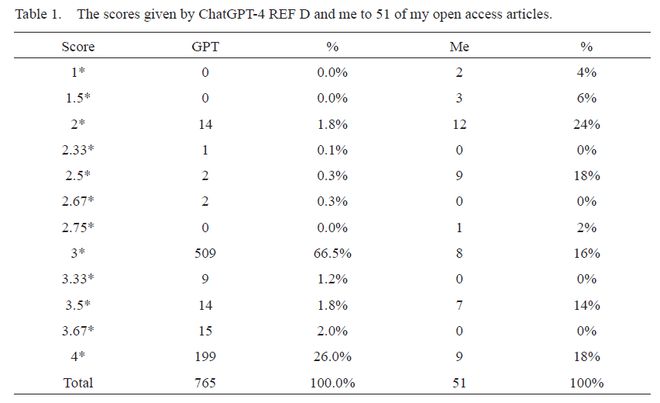

结果显示,GPT-4 只在 2* 和 4* 之间打分,从不使用低分 1* 或者 0。超过三分之二的情况下,它给出的分数是 3*,只有 2.5% 的情况下给出较低分数。人类评审在这些文章中的平均给分是 2.75*,而 ChatGPT-4 的平均给分略高于 3*。

因此,ChatGPT-4 似乎略微偏向于较高的分数,至少与研究者的自我评价相比是这样,而且它在很大程度上偏向于打 3* 分,而无关于文章的优劣。

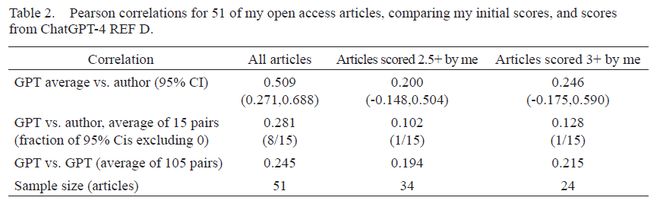

表 1丨ChatGPT-4 和人类评审对 51 篇文章的评分

第 3-6 个问题,GPT-4 的 REF 质量评分是否一致和准确?

研究发现,就准确性而言,GPT-4 质量得分与研究者的给分平均相差 0.802(平均值偏差)。如果对 GPT-4 的 15 次给分进行平均,其平均偏差也是 0.802。

不过更为重要的是,二个分数直接具有相关性吗?如果相关性较高,那就可以说明 ChatGPT 分数是有用的。

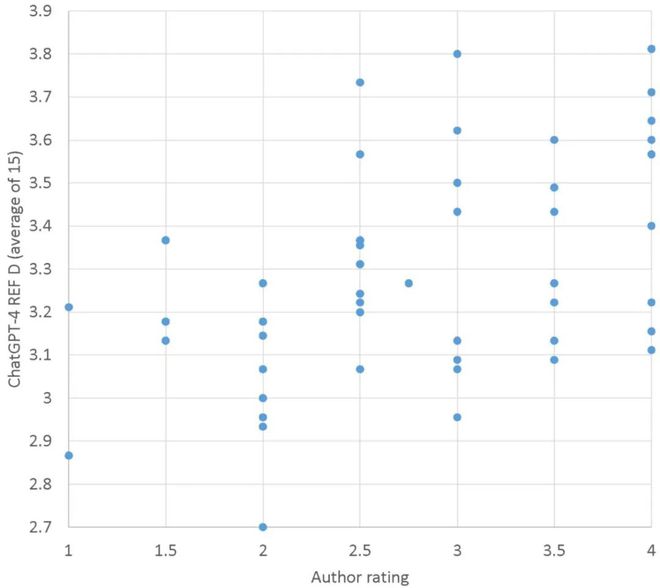

结果显示,人类评审的给分与 GPT-4 的平均给分(0.509)之间呈正相关(表 2),表明 ChatGPT 有一定能力评估研究质量。

表 2丨51 篇文章的皮尔逊相关性,比较研究者的初始评分和 GPT-4 的评分。

但是,这种相关性只是中等程度的,GPT-4 只能解释人类评审给分中 25% 的差异(=0.5092)。

此外,对于两组质量较高的文章来说,相关性较低,在统计学上也不显著。因此,虽然 GPT-4 的评审对质量参差不齐的文章集有一定的作用,但对质量较为一致的文章集的作用可能较弱。

尽管在全部文章中,人类评审的给分与 GPT-4 平均评分之间的相关性适中,但一些低质量文章 GPT-4 的评价给分则较高,反之亦然(见表 1)。

图丨ChatGPT 给出的平均 REF 星级与作者之前给出的 REF 星级对比

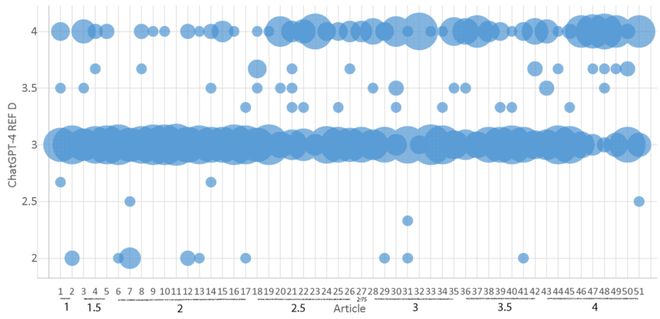

GPT-4 对 51 篇文章中的 50 篇给出了至少两个不同的分数,剩下的一篇文章 15 次都被打成 3*(下图中的第 11 篇)。在 51 篇文章中,有 5 篇文章在不同轮次中被 GPT-4 打出了三个不同的主要分数(2*、3* 和 4*),这说明,GPT-4 的评分并不具有一致性。

图丨ChatGPT 给出的分数星级范围与人类评审给分的对比;每个气泡的面积与 ChatGPT 对 x 轴文章给出 y 轴分数的次数成正比。x 轴下方为人类评分(来源:Journal of Data and InformationScience)

另外,不同轮次的 ChatGPT 评分之间的相关性与各轮 ChatGPT 和人类评分之间的相关性大致相同,但比 ChatGPT 平均评分和人类评审的评分之间的相关性低得多(见表 2)。

这意味着,平均多轮的 ChatGPT 评分要比单轮的评分更有效。

我们能用 ChatGPT 评审论文吗?

值得一提的是,研究还进一步探讨了 GPT-4 何以有能力检测一篇文章的质量的原因。

从其评审结果来看,GPT-4 主要还是依据文章内容本身提出的主张来评估严谨性等属性,而非根据外部信息。这表明 GPT-4 会将作者提供的信息转化为对文章质量的判断。

但似乎,它有时也会引入更广泛的信息来评估文章的潜在意义或影响范围。

为了验证这一点,Thelwall 特意杜撰了一篇虚假的文章,用 GPT-4 来对它进行评分。

这篇文章题为“松鼠外科医生会产生更多的引文影响吗?”,是基于一篇被期刊拒稿的文章修改而成的,研究者修改了其中的两个词,将其变为人类与松鼠手术研究的比较,以此来测试 GPT-4 是否能够识别研究的无意义或数据的伪造。

没想到,GPT-4 竟给出了 4*的高分,并认为该研究因其创新的方法(某种意义上来说确实够“创新”的)、潜在的学术和政策影响以及严谨的方法论而表现突出。

报告中甚至提出一些明显虚假的说法,如”通过强调引文影响力中基于物种的差异,该研究可以为学术界关于多样性和代表性的更广泛讨论做出贡献”。

但当研究者单独询问 GPT-4“松鼠能写学术研究期刊论文吗?”时,它却明确回答“不能”,这表明它本来是具备区分动物与人类认知能力的基本常识的。

所以,ChatGPT 并不能够利用广泛的信息来评估文章的意义。尽管它在某些情况下表现出了一定的评估能力,但在应用这些能力来准确评估文章方面,并不一定可靠。

尽管这项研究还具有一定的局限性,例如所评估的文章来自单一作者和学科领域,而且大部分结果都是基于作者本身对这些文章质量的自我评估,其样本量也相对较小,这可能导致其结论受限。

至少,我们已经可以看到,就目前而言,还无法完全依靠 LLMs 来检测学术研究的质量。

但由于它毕竟能够生成那些似是而非的质量评估报告,为了节省时间,可能就会有审稿人使用 LLMs 来撰写同行评审,甚至于违反版权法。

所以,研究者建议期刊、大学和其他研究评估机构等明确禁止或控制使用 LLMs 来完成研究评审,除非能够解决目前存在的诸多不足。

相关论文以《ChatGPT 可以评估研究质量吗?》(Can ChatGPT evaluate research quality?)发表在Journal of Data and Information Science上。

图丨相关论文(来源:Journal of Data and Information Science)

参考资料:

[1]. Mike Thelwall. Can ChatGPT evaluate research quality. Journal of Data and Information Science. DOI:https://doi.org/10.2478/jdis-2024-0013

[2]. Liang W, Zhang Y, Cao H, et al. Can large language models provide useful feedback on research papers? A large-scale empirical analysis[J]. arXiv preprint arXiv:2310.01783, 2023.

[3]. Liang W, Izzo Z, Zhang Y, et al. Monitoring AI-Modified Content at Scale: A Case Study on the Impact of ChatGPT on AI Conference Peer Reviews[J]. arXiv preprint arXiv:2403.07183, 2024.

本文内容不代表平台立场,不构成任何投资意见和建议,以个人官网/官方/公司公告为准。

原文链接:https://www.163.com/dy/article/J1MB2NPF055652SI.html

评论 ( 0 )