今年以来,全球互联网大厂掀起“百模大战”,微软、谷歌、百度、阿里等接连下场。经过半年多的竞争,科技巨头们围绕大模型生态正迎来新一轮道路之争:面对参数“天花板”,大模型的未来走向封闭还是开放?

开源模型可在家用电脑运行

8月3日,国内AI开发者社区“魔搭”(ModelScope)上架两款开源模型Qwen-7B和Qwen-7B-Chat,分别为阿里云通义千问的70亿参数通用模型和对话模型,两款模型均开源、免费、可商用。

据介绍,通义千问Qwen-7B是支持中英等多种语言的基座模型,在超过2万亿token(文本单位)数据集上训练,而Qwen-7B-Chat是基于基座模型的中英文对话模型,已达到人类的认知水平。简而言之,前者好比“地基”,后者是地基之上的“房屋”。

经过实际测试显示,Qwen-7B模型的综合表现不俗。其中在英文能力测评基准MMLU上,得分普遍高于同等参数规模的主流模型,甚至赶超120亿、130亿参数规模的部分模型。而在中文评测C-Eval验证集上,该模型也取得了同等规模的最高分。在数学解题能力评测GSM8K和代码能力评测HumanEval方面,Qwen-7B模型表现也名列前茅。

也就是说,在中英文写作、数学解题以及写代码等考试中,Qwen-7B模型妥妥是一名“学霸”,分数甚至超过同等参数级别的国际主流大模型。

除此之外,业界更关心Qwen-7B模型的易用性。众所周知,主流大模型的训练和运行需要专门的AI训练芯片(如英伟达A100),这些芯片不仅售价昂贵,每块英伟达A100售价高达1万—1.5万美元,而且被欧美等国家垄断,国内几乎无法购买。而国产Qwen-7B模型支持消费级显卡上部署,相当于高性能的家用电脑就能运行该模型。

得益于免费商用加上低门槛,Qwen-7B模型的上架,引起了AI开发者的关注。短短一天,在代码托管平台GitHub上,Qwen-7B模型已被千余名开发者标星收藏,绝大多数提问者均为中文开发者。正如阿里云在声明中所说:“相比英文世界热闹的AI开源生态,中文社区缺少优秀的基座模型。通义千问的加入有望为开源社区提供更多选择,推动中国AI开源生态建设。”

开源还是封闭

事实上,Qwen-7B模型并非首款开源的大模型,其实ChatGPT的“前辈”GPT-2也是彻底开源的,其代码和框架在互联网上均可免费使用,还有相关论文可供查阅。而OpenAI在ChatGPT火遍全球之后选择了闭源发展,GPT-3和GPT-4等模型代码已成为OpenAI的商业机密。

所谓开源,就是开放源代码。比如大模型一旦宣布开源后,在版权限制范围内,任何人都可以公开获取模型源代码,并进行修改甚至重新开发。打个简单的比方,源代码就像是一幅画的底稿,所有人可以照着底稿填色创造自己的艺术画作。

闭源与开源正好相反,只有源代码所有者(通常是软件开发商)掌握代码修改的权力,其他人没办法获取“底稿”,只能向软件开发商购买成品。

开源和闭源的优劣都非常明显。大模型开源后无疑会吸引更多开发者,大模型的应用也将更加丰富,但相应的监管和商业化将成为难题,容易出现“替人做嫁衣”的尴尬局面。毕竟,开源考虑的是生态共荣,到底能赚多少钱的经济账,这一阶段很难算清楚,而这些难题恰好是闭源的机遇。

开源还是闭源,这是一道大模型的生死题,国际巨头已给出答案。

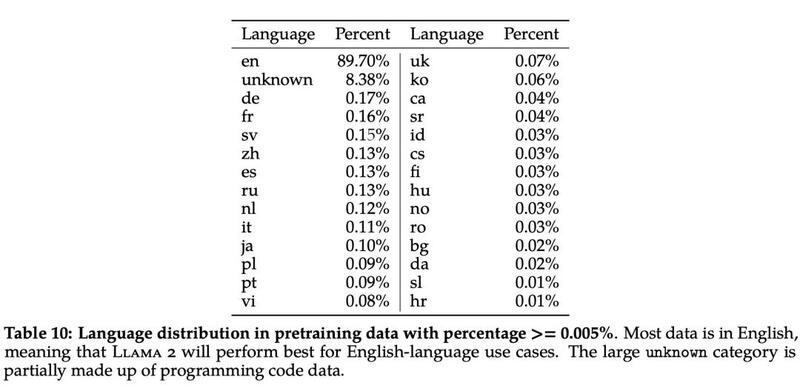

Facebook母公司Meta在上个月发布了大模型Llama2,开源免费给开发者和商业伙伴使用,而OpenAI则坚定地选择了GPT-4闭源发展,不仅能保持OpenAI在生成式AI行业的领先地位,还能赚取更多营收。根据权威杂志《Fast Company》预测,OpenAI在2023年的收入将达到2亿美元,包括提供API数据接口服务、聊天机器人订阅服务费等。

国内大模型也逐渐开始“分道扬镳”。阿里云的通义大模型早在今年4月宣布向企业开放,Qwen-7B模型的开源将开放之路走得更远一些。百度的文心一言也在近期宣布,将逐步开放插件生态给第三方开发者,帮助开发者基于文心大模型打造自己的应用。

相比之下,华为则不走寻常路。在发布盘古大模型3.0时,华为云公开表示,盘古大模型全栈技术均由华为自主创新的,没有采用任何开源技术,同时盘古大模型将聚集无数行业大数据(涉及行业机密等),因此盘古大模型在未来也不会开源。

大参数还是小而美

除此之外,Qwen-7B模型的开源,还带来了另一个思考:我们到底需要多大参数的大模型?

不可否认,大模型的参数规模正在不断膨胀。以OpenAI旗下的GPT大模型为例,GPT-1仅包含1.17亿参数,GPT-3的参数已经高达1750亿,几年时间内增长了1000多倍,而GPT-4的参数已超过万亿级别。

国内大模型亦是如此。百度文心大模型为2600亿参数,腾讯混元大模型达到千亿级参数,华为盘古大模型参数规模推测接近GPT-3.5,阿里通义大模型官宣已达10万亿参数……据不完全统计,中国10亿参数规模以上的大模型至少有79个。

遗憾的是,参数越大并不代表大模型的能力越强。在世界人工智能大会上,腾讯云副总裁吴运声有一个很恰当的比喻:“就像运动员练体力,举重运动员要举200斤杠铃,游泳运动员举100斤就够了,不同类型的运动员不需要每个人都练习200斤重的杠铃。”

众所周知,大模型的参数越高,消耗的资源和成本也越相应增加。而深耕行业的垂直类大模型,并不需要一味追求“规模大”或是“参数高”,更应该根据客户需求制定相关的模型参数。比如生物大模型BioGPT-Large仅有15亿参数,而在生物医学专业测试中的准确率,却优于千亿级别参数的通用大模型。

OpenAI联合创始人Sam Altman也公开表示,OpenAI正接近LLM(大型语言模型)规模的极限,规模越大并不一定意味着模型越好,参数规模不再是衡量模型质量的重要指标。

火山引擎智能算法负责人吴迪也有类似观点,长期来看,降低成本将成为大模型应用落地的重要因素,“一个经过良好精调的中小规格模型,在特定工作上的表现可能不亚于通用大模型,而成本可能仅为原来的十分之一。”

当下,国内科技大厂几乎都拿到了大模型的入场券,但真正的道路抉择才刚开始。

原文链接:https://news.cctv.com/2023/08/06/ARTIAfJU7C9IR5UIqJnHiqb9230806.shtml

评论 ( 0 )