今天分享的是人工智能系列深度研究报告:《 2023大模型时代的AI十大趋势观察 》。(报告出品方:腾讯研究院 )

趋势一:涌现

LLM 推动人工智能快速进化到AGI阶段

自2010年代初深度学习问世以来,人工智能进入到第三次高潮。而2017年Transformer算法将深度学习推向了大模型时代。OpenAl调基于Transformer的Decoder部分建立起来了GPT家族。ChatGPT一经面世便风靡全球,人们惊讶于其能够进行连贯,有深度对话的同时,也惊异地发现了它涌现了推理、思维链等体现智能的能力。GPT4的能力更是进化神速,在多种能力测试中达到人类顶级水平,让人类看到了AGI的曙光。

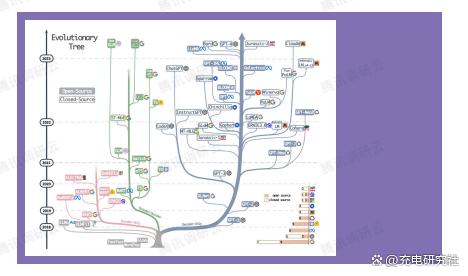

随着2010年深度学习问世,人工智能的发展推进了第三次高潮,而大模型将这次高潮带到了AGI的阶段。2017年谷歌在(Attentionis All You Need)一文中发布了具有里程碑意义的Transtormer算法,虽然依然是深度学习的延续,但是它使得深度学习模型参数突破了1亿,Transformer取代RNN、CNN进入大模型时代,这无疑是一个重大的里程碑。

Transformer是一种基于自注意力机制的神经网络模型,最初用来完成不同语言之间的文本翻译任务,主体包含Encoder和Decoder部分,分别负责对源语言文本进行编码和将编码信息转换为目标语言文本,而后基于Encoder和Decoder,大模型的发展大致走上了两条路:一条路是舍弃Decoder部分,仅仅使用Encoder 作为编码器的预训练模型,其最出名的代表就是Bert家族:另一条路,通过舍弃Encoder 部分而基于 Decoder 部分的 GPT 家族。

此前,谷歌一直主推BERT路线。2018年谷歌发布BERT,便一举击败11个NLP任务的Sota结果,成为了NLP 界新的里程碑,同时为模型训练和NLP 领域打开了新的思路,预训练模型逐渐成为自然语言处理(NLP)领域的主流;同时,网络模型参数量首次超过3亿规模。BERT的阶段性成功获得了其他研究者的纷纷效仿,比如百度的ERNIE、Meta的RoBERTa、微软的DeBERTa等等。这些模型开始尝试”无监督预训练”的方式来更好的利用相较其他数据而言更容易获得的大规模的自然语言数据,而”无监督”的方式就是Masked LanguageModel(MLM),通过让遮盖句子中的部分单词。让模型去学习语境去预测被遮盖的单词的能力,类似于”完形填空”。

与此同时,OpenA一直延续着GPT路线。GPT的成功在于扩大语言模型的规模可以显著提高零样本(zero-shat)与小样本(few-shot)学习的能力,这一点与基于微调的Bert 家族有很大的区别,也是当下大规模语言模型神奇能力的来源。GPT基于给定前面单词序列预测下一个单词来进行训练,类似于“文字接龙”。而GPT的自回归语言模型的优越性在GPT-3之后得以显现,展示了大模型带来的超越文本生成本身的神奇能力。当下的ChatGPTGPT-4Bard,PaLMLLaMA等带来了当下的大模型感世,也带来了AGI的曙光。

完整(2023大模型时代的AI十大趋势观察)来源于公众:百家全行业报告

内容摘要如下:

ChatGPT一经推出,便风靡全球。人们惊讶于其能够进行连贯、有深度对话的能力,仿佛是与一个真人进行交谈。更令人惊异的是ChatGPT展现出了推理、思维链等体现智能的能力。这一切都源于其大规模的训练数据和复杂的机器学习策略。ChatGPT大经过三个训练阶段:“开卷有益”–无监督学习,让ChatGPT对”海量互联网文本”做单字接龙,以扩充模型的词汇量,语言知识,世界的信息与知识,使ChatGPT从“哑巴鹦鹉”变成脑容量超级大的懂王鹦鹉”;

模板规范”–监督学习,让ChatGPT对”优质对话范例”做单字接龙,以规范回答的对话模式和对话内容。使ChatGPT变成”懂规矩的博学鹦鹉”;

“创意引导”– 基于人类反情的强化学习RLHF,让ChatGPT根据”人类对它生成答案的好坏评分来调节模型,以引导它生成人类认可的创意回答。使ChatGPT变成”既懂规矩又会试探的博学鹦鹉”。

2017年,朱松纯教授在《浅谈人工智能:现状、任务、构架与统一》一文中提出并阐述了鹦鹉和乌鸦的能力。过去的深度学习只是”鹦鹉学舌”式的模仿,即鹦鹉是不知道那段话的含义的。它用自己的方式去理解了发音,然后模仿了出来。机器学习,包括深度学习,道循的范式是”datafitting,在已有的信息范畴内寻找X与Y的关系,当见到一个新的X时,可以根据规律推断出属于哪个Y。这种方式依赖于应用场景和数据集中的样本特征,如果场景或数据集发生变化,就需要重新训练一遍。因此,这个阶段的深度学习不具有学习的迁移能力和通用性。

朱松纯教授在论文中举了一个乌鸦的例子。一只乌鸦,在寻找食物时发现了坚果,却无法砸碎吃到里面的果肉。这时,它发现一个诀窍,可以把果子放到路上让车压过去。进一步发现,虽然坚果被压碎了,但它到路中间去吃是一件很危险的事。然后,它进一步观察,发现在有红绿路灯的路口,车子和人有时候会停下来。这时,它必须进一步领悟到红绿灯、斑马线,车停、人停之间的关系。搞清楚这些后,它把坚果抛到斑马线上,等车子压过去,然后等到行人灯亮了,它从容不迫地走过去,吃到了地上的果肉。在这个过程中,乌鸦展现出了完全自主的智能:感知、认知、推理、学习、和执行。而ChatGPT涌现的便是类似于乌鸦思维链条能力

并且,GPT-4相较于ChatGPT,其能力更是在加速升级。OpenAl表示,虽然GPT4在许多现实世界场景中的能力不如人类,但在各种专业和学术基准上表现出人类水平。这让人们看到了通用人工智能(AGI)的曙光。AGI是指一种具有所有人类智能能力的机器,它可以理解、学习、适应和实现任何知识工作。GPT-4的出现,无疑让这一愿景更近了一步。在OpenAl提供的一个示例中,GPT-4 准确地回答了几个网络图片为什么搞笑的问题,虽然解释得比较初级,但确实能准确分析出图片中的各种元素,并分析出它们之间的逻辑。

2023年2月24日,OpenAlCEO萨姆·阿尔特曼(Sam Altman)发布博客文章,分享OpenAl对通用人工智能(AGI)的当前和后续规划。阿尔特曼强调 OpenAl的使命是确保AGI造福全人类,AGI可通过增加丰富度、推动全球经济发展以及帮助发现改变可能性极限的新科学知识,来帮助我们提升人类。他相信,AGI可能在不久的将来或,远的将来出现。

多模态Al是指能够处理和理解多种类型信息的人工智能,如文本、图像、音频、视频等。这种 Al 不仅能够处理单一数据类型的任务,而且可以在不同数据类型间建立联系和融合,从而实现一个综合、全面的理解多模态。AI 能够对各种不同类型的数据进行关联分析,为解决复杂问题提供支持。未来在诸多创新领域,多模态技术的发展将带来创新应用的蓝海。

多模态Al是指可以处理、分析和交互多种调研云类型数据的人工智能系统。多模态Al不仅能够处理单一数据类型的任务,而且可以在不同数据类型间建立联系和融合,从而实现一个综合、全面的理解。多模态Al能够对各种不同类型的数据进行关联分析,为解决复杂问题提供支持。

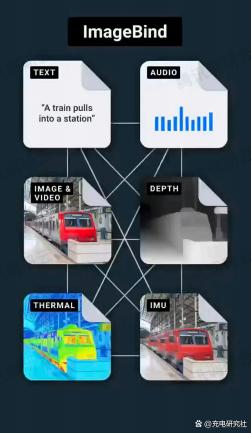

5月9日,Meta宣布开源多模态大模型ImageBind,一个跨六种模态(图像、文本、深度、热度图、音频和IMU数据)的整体化人工智能模型。展示了未来的人工智能模型如何能够生成多感官内容。通过利用多种类型的图像配对数据来学习单个共享表示空间。该研究不需要所有模态相互同时出现的数据集,相反利用到了图像的绑定属性,只要将每个模态的嵌入与图像嵌入对齐,就会实现所有模态的迅速对齐。

多模态技术处于爆发的早期

在多模态技术发展初期,不同模态的AI开始进行集成,比如图像识别和自然语言处理技术的结合。除了ImageBind 打通六种模态外,多数仍在探索文本与图像的融合,但进展飞快。UniDiffuser:除了单向文生图,还能实现图生问、图文联合生产、无条件图文生成等多种功能

OpenAI开发了许多多模态AI案例如DALL-E、CLIP 等,可以识别图像中的对象,同时生成与图像相关的描述性文本,或由文本指导生成有关物品的新图像。

随着多模态技术的进展,多模态Al在理解和处理不同类型数据时能够实现更高程度的融合。算法和模型可以在不同数据类型之间建立联系,提取跨模态的共享信息。这使得Al能够深度理解和解决复杂问题。

多模态技术将助力人工智能向AGI发展。未来真正的AGI必然是与人类相仿的,高效的多模态智能处理机;人类可以自然地处理多种类型的信息,如文本、声音、图像、触觉等。为了让 AGI 具备类似的能力,它需要具有高效的多模态信息处理机制。这让AGI 能够在不同的任务和环境中灵活适应,从而更好地模拟人类智能。单纯从语言文字中学习大概率无法获得完整的世界认知,人类擅长根据当前的环境、情境、目标和心理状态理解和处理信息。具有类似能力的AGI 将能更好地理解现实环境中的复杂信息,并根据不同的情境调整其行为和策略。未来真正的AGI很可能会是与人类相仿、高效的多模态智能处理机,从所有模态信息中学习知识、经验、逻辑、方法。

多模态应用的创新“蓝海”

与单纯通过自然语言进行交互或输入输出相比,多模态应用显然具备更强的可感知、可交互、可“通感”等天然属性。目前 Midjourney在文生图领域的应用模式创新,只是未来多模态应用世界的冰山一角。随着多模态技术的应用,未来在诸多创新领域,多模态技术的发展将带来创新应用的蓝海。

提升Al模型性能:多模态Al在相互补足和辅助各种模态的数据信息的同时,可以提升Al模型的精度和性能。同时,可以借助融合后的数据集进行自监督学习,使模型在更富有挑战性的任务中获得更好的泛化能力。

跨多模态语义的知识检索与数据提取;跨模态的知识挖掘,典型如医药领域(跨病历,医疗影像,基因序列,分子结构等)的知识挖掘;

跨领域融合应用:多模态Al可以跨领域整合数据来源,扩展Al的应用领域。

在医疗诊断中,结合图像、患者病史、基因数据等多模态信息,提高诊断准确性;在商业领域,通过融合销售数据、客户反馈、市场趋势等多维信息,实现更精确的市场预测。

Google DeepMind 旗下的 AlphaFold 是一个基于深度学习的多模态Al系统,结合生物学和计算机科学,预测蛋白质三维结构,重新定义了生物科学在药物研发和疾病研究领域的应用。

创新的创作与设计:多模态Al可以为创意、设计和艺术领域带来新的可能性。例如,Al可以通过分析图片和文本数据,自动生成新的艺语术作品,或为设计师提供更具创意的设计方案。

多模态信息展示(如产品、年报、课程、演讲)的自动生成;多模态网页或小程序的自动生成等等。混合了多模态创建能力的下一代用户原创内容(UGC)工具或平台;

NVIDIA NVIDIA的 Omniverse平台是一个支持多模态数据输入的实时三维设计和协同工作平台。它可以同时处理文本、图形、音频和视频,提供强大的渲染、建模和模拟功能。这种多模态的交互将极大地促进创意和设计的产生。

提升人机交互体验:多模态AI结合了语音、图像、文本、视频等多种信息来源,使得人机交互更加自然、直观和高效。这有望改善交流方式,例如在对话系统、虚拟助手和机器人领域,实现更高级别的交互。

多模态Al可以扩展在社交媒体中的实时语音、文字、图像和视频的处理能力,为传统游戏和增强现实/虚拟现实(AR/R)应用带来更为丰富和沉浸式体验。

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)

本内容共计:50页。受篇幅限制,仅列举部分内容。

精选报告来源公众:百家全行业报告

举报/反馈

原文链接:https://baijiahao.baidu.com/s?id=1777923193115886452&wfr=spider&for=pc

评论 ( 0 )