作为一个重要的迭代升级版本,GPT-4相对于上一代而言,在多个性能上有显著的提升,这没有让我们失望。具体来看,关键的升级主要是以下几个方面:

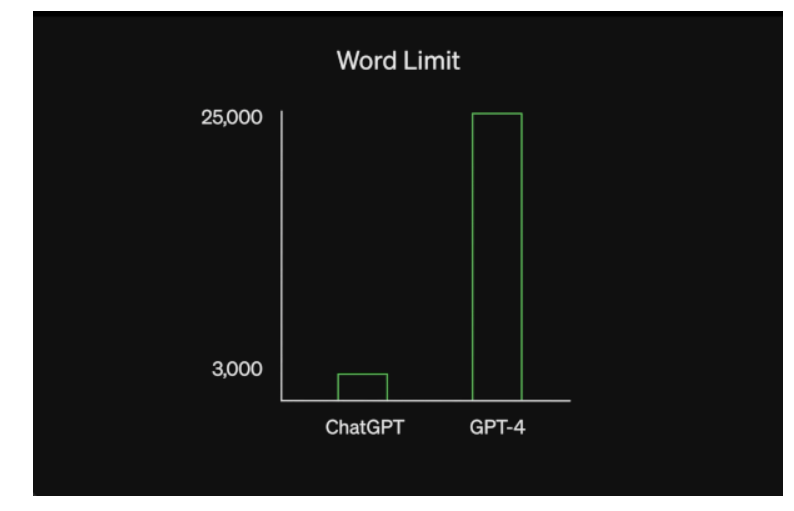

惊喜1、文字输入限制提升至2.5万字

上一个版本,输入的文字不能超过3000字,而GPT-4将这一限制提升到了2.5万字。这个提升,将进一步扩展其应用范围。输入的不再限制于问题,用户可以直接输入文本内容,比如一篇文章甚至一篇报告。

惊喜2、可以输入图片了

上一代产品只能输入文本内容,此次更新升级,可以输入图片内容了。

比如,在此次发布的GPT-4,展示了下面这个例子。

用户:这张图有什么好笑的?

GPT-4:

该图显示了带有三个面板的“Lightning Cable”适配器的包装。

图片1:带有 VGA 连接器(一种大的蓝色 15 针连接器,通常用于计算机显示器)的智能手机已插入其充电端口。

图片 2:“Lightning Cable”适配器的包装,上面有 VGA 连接器的图片。

图片 3:VGA 连接器特写,末端有一个小型闪电连接器(用于为 iPhone 和其他 Apple 设备充电)。

这张图片中的幽默来自将过时的大型 VGA 连接器插入小型现代智能手机充电端口的荒谬做法。

从这个例子可以看出,GPT-4可以可以“理解”图片的特征,而且可以理解多个图片之间的关联关系,并可以依据用户的指令,来将图片的特征描述出来。

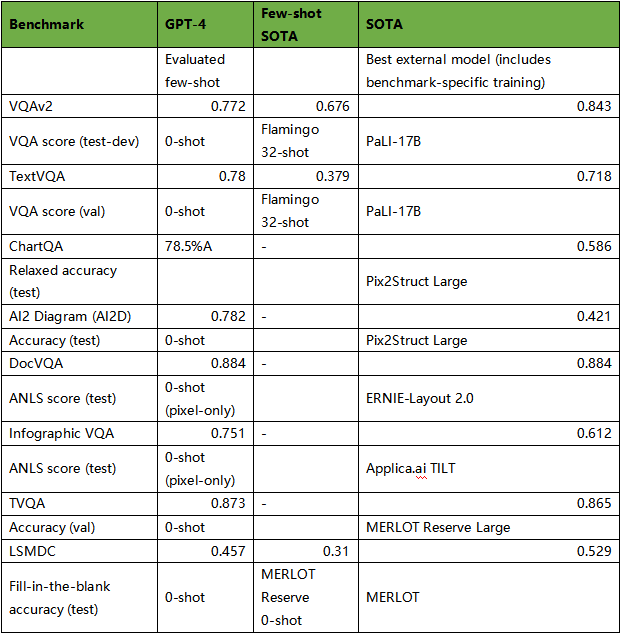

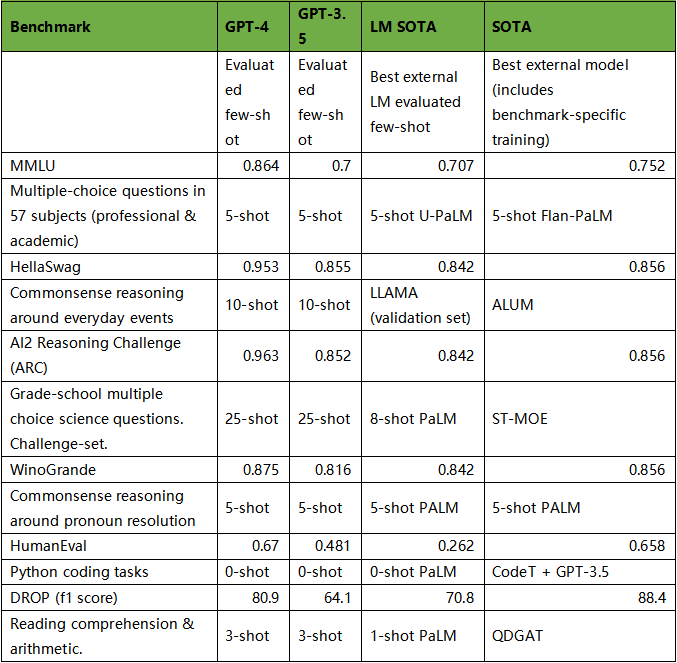

在相关性能参数方面,GPT-4的表现也可圈可点,具体对比如下表:

惊喜3、更聪明、更准确

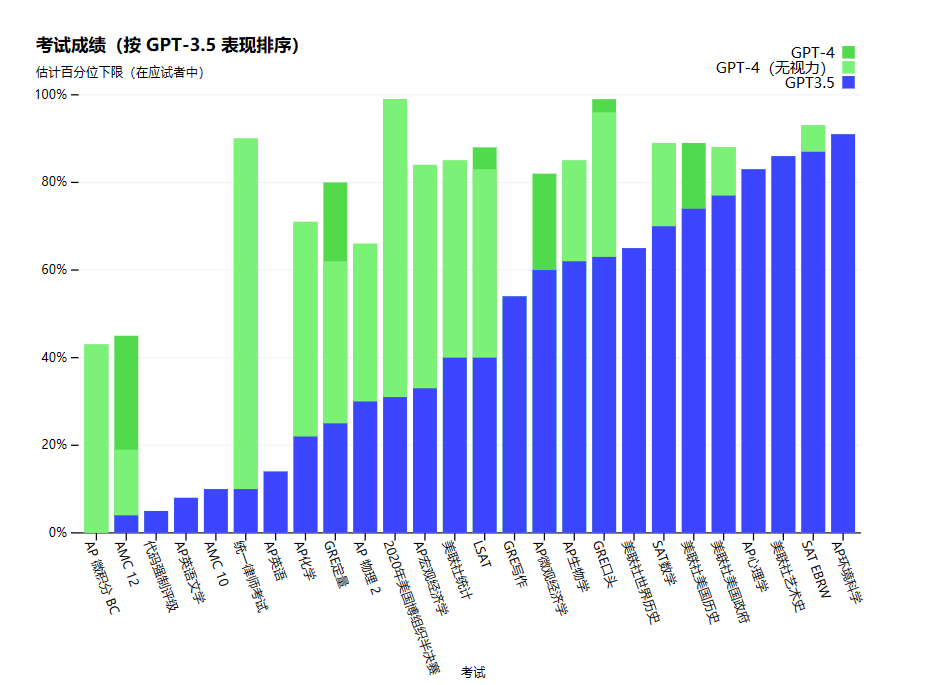

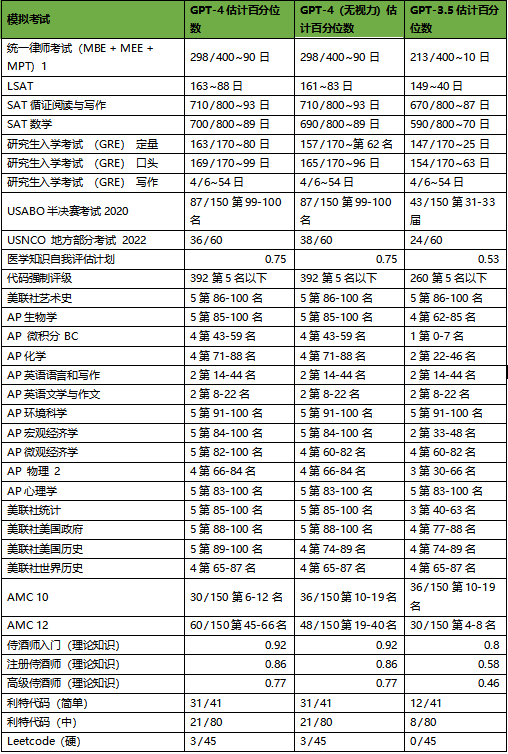

为了了解这两种模型之间的差异,OpenAI在各种基准测试上进行了实验,包括最初为人类设计的模拟考试。OpenAI继续使用最新的公开测试(在奥林匹克和AP免费回答问题的情况下)或购买2022-2023版的模拟考试。

测试结果如下:

可以发现,当任务的复杂性达到足够的阈值时,GPT-4 比 GPT-3.5 更可靠、更有创意,并且能够处理更细微的指令。

惊喜4、深度学习堆栈可预测性的扩展

对于像 GPT-4 这样的大模型,进行广泛的模型调整是不可行的。因此,模型的可扩展性就具有重要的价值。

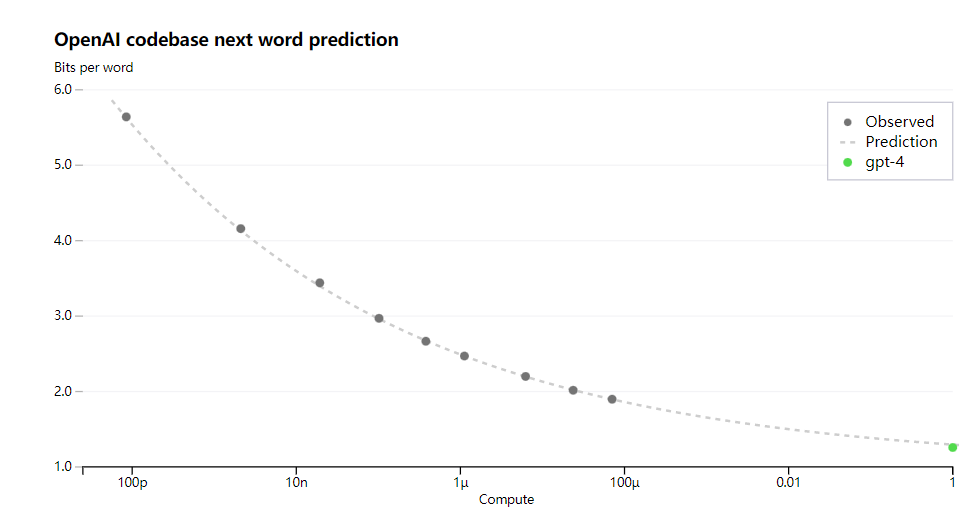

OpenAI在模型的可扩展性方面不断探索,并在GPT-4 有重要的升级。为了验证GPT-4 的可扩展性,OpenAI通过从使用相同方法训练但使用少 10000 倍计算的模型进行推断,准确预测了 GPT-4 在内部代码库的最终损失,结果如下图:

从上述结果可以发现,GPT-4 可以用更少的计算量来实现更准确的预测。

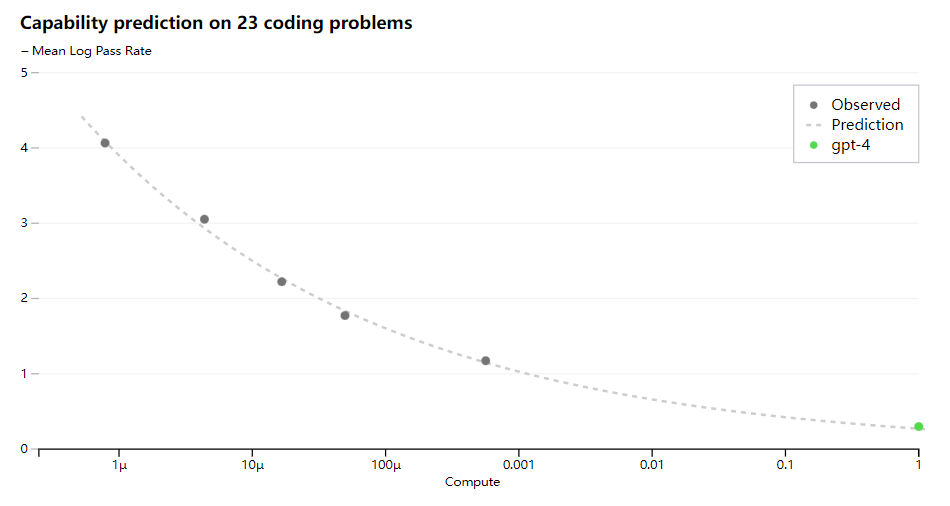

此外,OpenAI成功预测了HumanEval数据集子集的通过率,从计算量减少 1000 倍的模型推断,其结果如下:

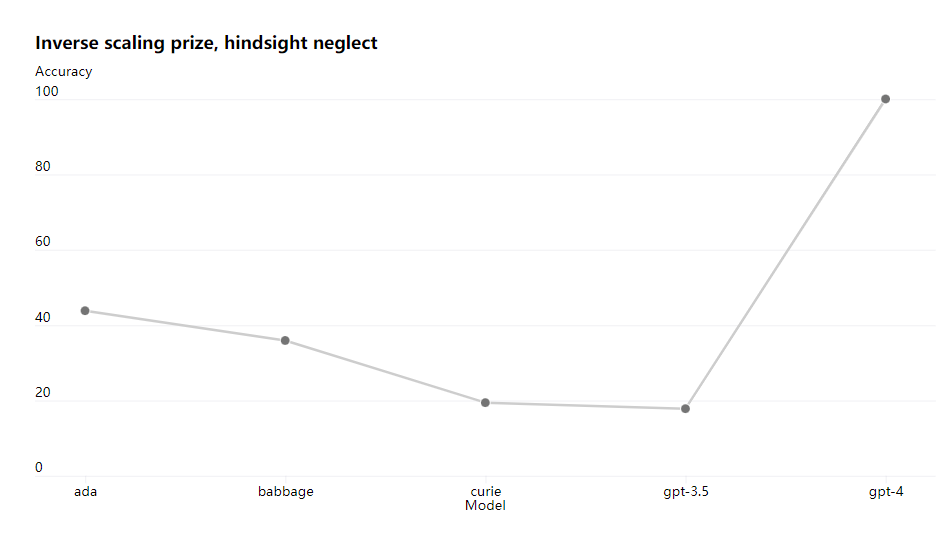

接下来,OpenAI在Inverse Scaling Prize上进行了测试,其结果如下:

可以发现,GPT-4 的表现要比GPT-3.5好很多。

然而,GPT-4并不是完美的,他依然还存在很多待解的问题,或者说是此次发布的遗憾。

遗憾1、参数规模没有大规模提升

GPT-4是一个大规模预训练模型,对于大模型而言,参数规模往往是一个关键指标。一般情况下,更大的参数规模意味着更强的技术能力。

在此前不久,业界就在流传GPT-4将在参数规模上有大幅度提升,甚至传言将达到100万亿级的参数规模,这也拉高了业界的期待。

此次发布的GPT-4,并没有公布准确的参数规模。如果参数规模提升了一个数量级,OpenAI肯定会大肆宣扬一番,并将其作为GPT-4的一个关键突破。既然没说,那大概率就是没有大的改进。

遗憾2、一个假的多模态,不能生成图片、视频

大模型的发展趋势,除了更好的性能表现外,一个关键的突破就是多模态。所谓多模态,就是文字、图片、视频、语音这些不同模态的信息之间的相互转换。比如,输入一段文字内容,AI应用可以依据文字描述来自动生成一幅画甚至是一个视频。

ChatGPT是很强大,但他的强大只表现在文字领域,还不能跨模态。GPT-4的一个关键升级就是多模态,业界最期待的也是这个。然而,此次发布的GPT-4却有点失望,他在多模态上有点突破,可以输入图片内容,但是输出的却还只能是文字。用户最期待的图片、视频生成,他没能实现,这是一个巨大的遗憾。

遗憾3、“发疯”问题有改善,但没彻底解决

ChatGPT在使用过程中,偶尔会遇到“发疯”的情况,变得胡言乱语,这给微软带来了不小的麻烦。那么,GPT-4把这个问题解决了么?

根据测试结果来看,这个问题有改善,但还没能彻底解决。

OpenAI承认,GPT-4 与早期的 GPT 模型具有相似的局限性,它仍然不完全可靠,可能会存在推理错误。

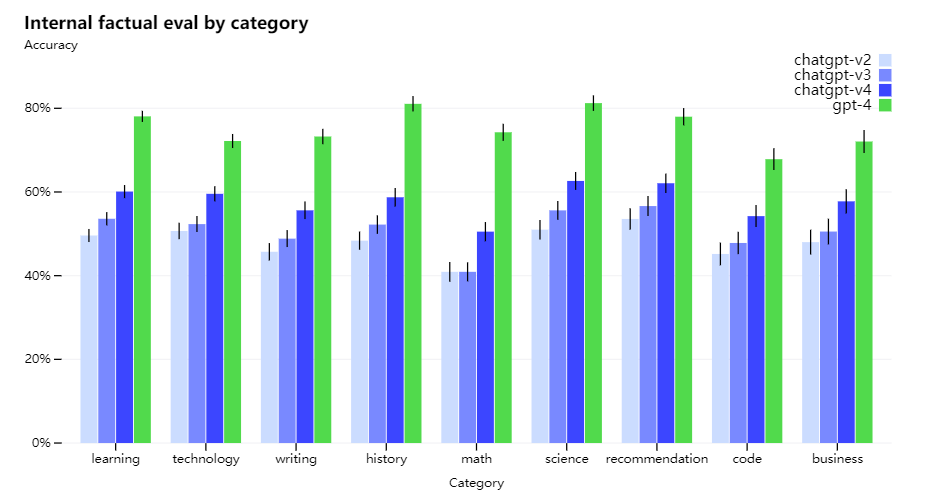

但是,但 GPT-4 相对于以前的模型已经有比较显著的改善了。OpenAI对不同模型进行了内部对抗性真实性测试,具体来看,进行了涵盖学习、技术、写作、历史、数学、可惜等九类测试,准确度为 1.0 意味着模型的答案被判断为与人类理想回答一致。

OpenAI将GPT-4 与ChatGPT-V2、ChatGPT-V3、ChatGPT-V4进行了比较,最终结果如下:

在OpenAI的内部对抗性真实性评估中,GPT-4的得分比我们最新的GPT-3.5高40%。

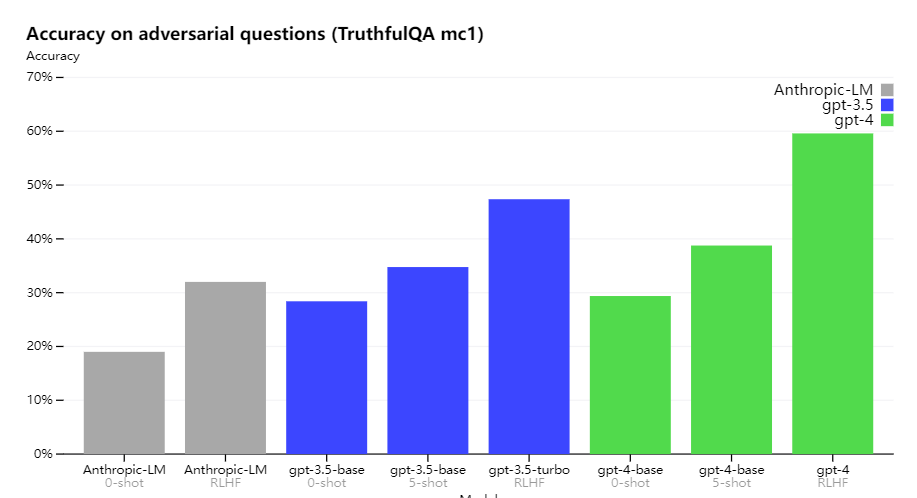

之后,OpenAI在TruthfulQA等外部基准,测试了模型将事实与对抗性选择的一组错误陈述分开的能力。

根据结果来看,GPT-4仅比GPT-3.5好一点点,并没有显著的提升。

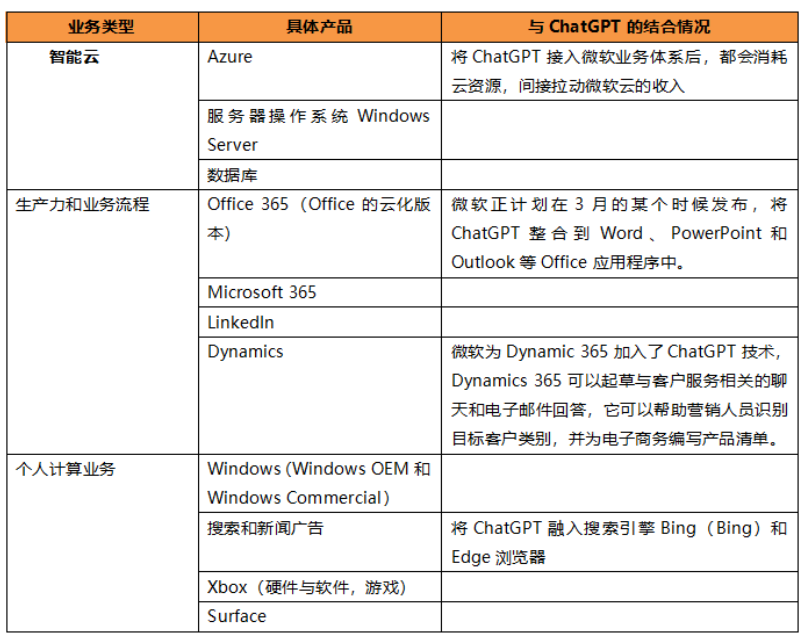

此次发布会,除了GPT-4本身技术性能的提升以外,还有一个很重要的看点,那就是其商业化进展。从微软近期的动作来看,他是准备在GPT-4基础上大干一场。在数据猿先前发布的文章《先用ChatGPT革自己的命,然后干翻所有人!微软要“梭哈”了!》中,整理了微软近期将ChatGPT与其业务体系整合的情况,可以发现,微软的很多业务都已经可以看到ChatGPT的身影。

大规模预训练模型这个赛道异常热闹,尤其是OpenAI可以说已经成为科技界的明星。然而,大模型的竞赛才刚刚开始,鹿死谁手犹未可知。

GPT-4再好,也是别人的东西,我们当然更期待中国自己的大模型。

正好,百度将在明天(3月16日)发布文心一言,让我们小小期待一下吧。

所以,压力给到百度了。

往期精彩文章:

先用ChatGPT革自己的命,然后干翻所有人!微软要“梭哈”了!

★关注数据猿公众号,后台回复“GPT4技术报告”获取最新98页报告原文。

原文链接:https://baijiahao.baidu.com/s?id=1760407673599638291&wfr=spider&for=pc

评论 ( 0 )