1)2017年前:

以深度学习为核心的小模型占据主流:这类模型以LSTM及CNN模型作为典型的特征抽取器,根据特定领域标注数据训练,在一些任务上可以达到接近人类的水准。但是硬件算力不够导致针对其他领域重新训练成本过高,让其通用型任务的完成情况较差。

2)2017年到2020年:

以谷歌Bert为代表的双向预训练+FineTuning(微调)的Transformer模型横空出世成为了人工智能的主流方向。

谷歌研究团队发表的《Attention is all you need》论文(作者:Ashish Vaswani,Noam Shazeer,Niki Parmar等)开创了Transformer模型,重新统一了自然语言模型 (NLP) 的研究范式。

这类模型以预训练的方式学习语言学特征,大幅简化了过去NLP繁琐的研究种类。Transformer作为特征提取器效果好于CNN、LSTM模型等,在信息容纳能力、并行计算等方面明显占优,让AI首次能在语言任务的部分场景中追平人类。

3)2020年到2022年:

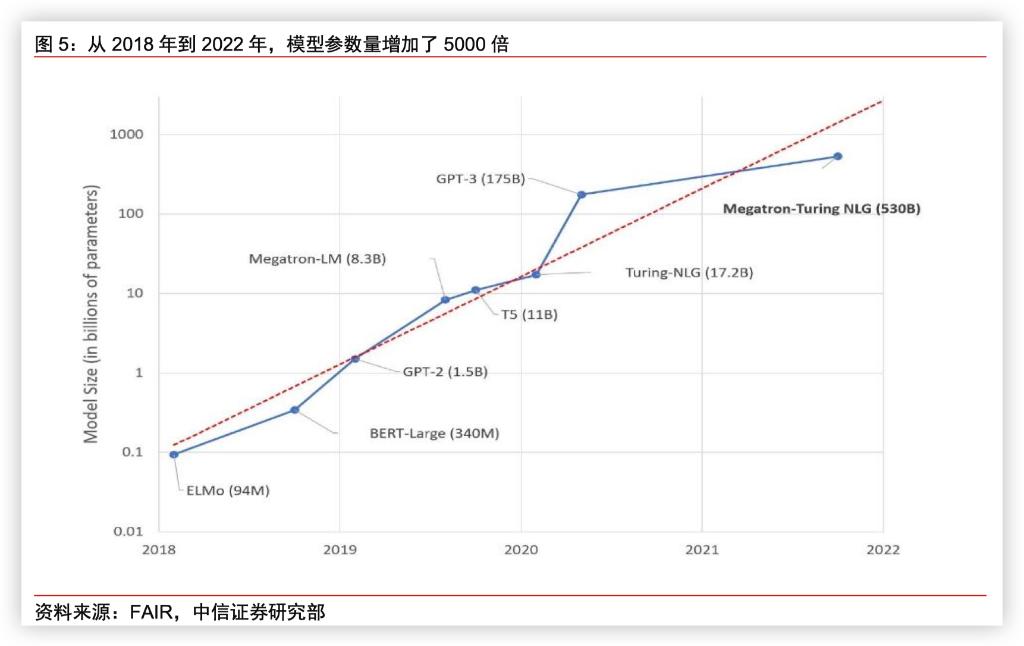

产业界与学术界继续沿着Transformer的道路前景,但开始尝试不同于Bert的其他Transformer架构,通过预训练无监督学习的方法不断增加模型体积成为了这一时段的主流。

以1750亿参数的GPT-3为代表,各大互联网巨头不断尝试增加模型体积以获得更好的效果。

GPT-3为代表的自回归+Prompting的方法开始展现产品化能力的优越性,与Fine-tuning方法的Bert模型成为两条道路。

相比于Bert,GPT-3的自回归+Prompting在产品化能力展现出了两个优点:

- Fine-tuning对于小公司更难部署,从产品化的角度上更加困难;

- Prompting的方法更符合我们对以人类的方式使用AI的愿望,并实现了人、模型之间的自然交互。

谷歌等巨头在这一阶段也意识到了Prompting方法的重要性,逐渐开始转向。

国内AI研究在这一段时间内出现了明显落后,仍然沿着Bert模型的方向继续前进,对GPT-3的研究很少;同时受制于中文优质语料的缺乏,模型大小也较难提升。

4)2022年至今:

ChatGPT的成功证明了GPT模型的Prompting道路的正确性,同时也强调了数据质量的重要性。

ChatGPT最重要的成功是在产品化上更进一步:ChatGPT在模型精度上并没有飞跃性的突破,但从Few Shot prompt(需要输入少量范例示范)转换到Instruct(用人类语言描述想做什么)更加贴合用户的习惯。

原文链接:https://baijiahao.baidu.com/s?id=1762767193297463097&wfr=spider&for=pc

评论 ( 0 )