转载

这几天,谷歌与新模型一起亮相的,还有新版本的TPU芯片TPU v5p,旨在减少训练大语言模型相关的时间投入。TPU是谷歌为神经网络设计的专用芯片,经过优化可加快机器学习模型的训练和推断速度,谷歌于2016年起开始推出第一代TPU。

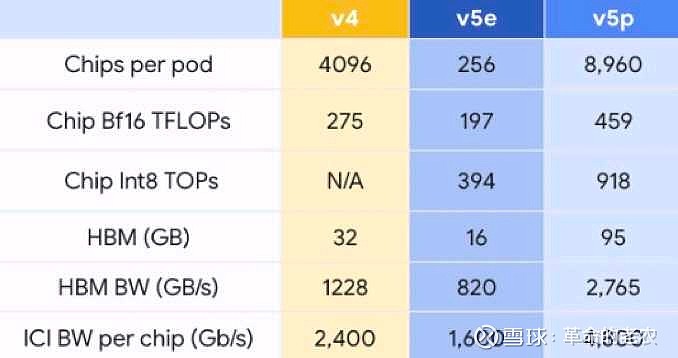

谷歌TPU芯片参数比较。

据谷歌介绍,与TPU v4相比,TPU v5p的浮点运算性能提升了两倍,在高带宽内存方面提高了3倍。使用谷歌的600 GB/s芯片间互连,可以将8960个v5p加速器耦合在一个Pod(通常指一个包含多个芯片的集群或模块)中,从而更快或更高精度地训练模型。作为参考,该值比TPU v5e大35倍,是TPU v4的两倍多。

谷歌称,TPU v5p是其迄今为止最强大的,能够提供459 teraFLOPS(每秒可执行459万亿次浮点运算)的bfloat16(16位浮点数格式)性能或918 teraOPS(每秒可执行918万亿次整数运算)的Int8(执行8位整数)性能,支持95GB的高带宽内存,能够以2.76 TB/s的速度传输数据。

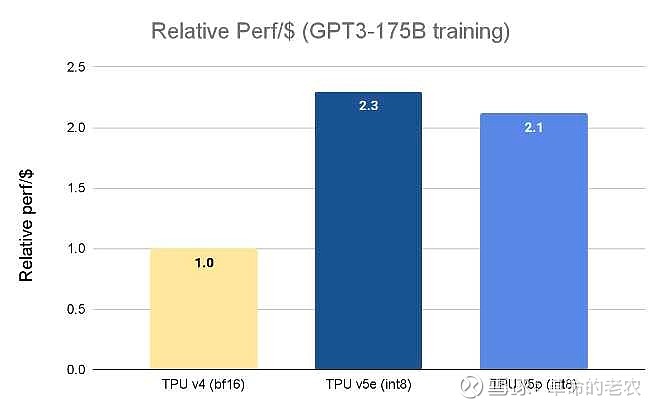

谷歌表示,所有这些意味着TPU v5p可以比TPU v4更快地训练大型语言模型,如训练GPT-3(1750亿参数)这样的大语言模型速度比TPU v4快2.8倍。

不过,这种更高的性能和可扩展性也是有代价的。每个TPU v5p加速器的运行费用为每小时4.2美元,而TPU v4加速器为每小时3.22美元,TPU v5e加速器每小时1.2美元。

谷歌TPU芯片训练大模型的参数比较。

“在我们的早期使用阶段,谷歌DeepMind和谷歌Research观察到,与我们的TPU v4芯片相比,使用TPU v5p芯片的大语言模型(LLM)训练工作负载的速度提高了两倍。”谷歌DeepMind首席科学家杰夫·迪恩(Jeff Dean)写道,“对机器学习框架(JAX、PyTorch、TensorFlow)和编排工具的强大支持使我们能够在v5p上更高效地扩展。通过第二代SparseCores,我们还看到嵌入密集型工作负载的性能有了显着提高。TPU对于我们在Gemini等尖端模型上进行最大规模的研究和工程工作至关重要。”

除了新硬件之外,谷歌还引入了“人工智能超级计算机”的概念。谷歌云将其描述为一种超级计算架构,包括一个集成系统,具有开放软件、性能优化硬件、机器学习框架和灵活的消费模型。

谷歌计算和机器学习基础设施部门副总裁马克·洛迈尔(Mark Lohmeyer)在博客文章中解释道,“传统方法通常通过零碎的组件级增强来解决要求苛刻的人工智能工作负载,这可能会导致效率低下和瓶颈。”“相比之下,人工智能超级计算机采用系统级协同设计来提高人工智能训练、调整和服务的效率和生产力。”这可以理解为,与单独看待每个部分相比,这种合并将提高生产力和效率。换句话说,超级计算机是一个系统,其中任何可能导致性能低下的变量(硬件或软件)都受到控制和优化。

由于美国政府一直在加大对中国企业和组织的AI算力芯片制裁和封锁。无论是英伟达、AMD、谷歌推出的高端AI云端算力芯片都无法进入中国市场。中国企业要想在各种大模型上奋起直追,以免落后美国对手太多,就必须走出自研AI算力芯片的途径。

国内有一家AI芯片研发公司其技术路径和方向与谷歌最为相似。他就是中昊芯英。

1.在产品方面,中昊芯英自2020年成立短短2年时间内,快速实现了核心AI芯片产品的研发、流片以及商业化导入。中昊芯英拥有自研AI训练芯片及推理芯片两大产品线,并已经完成了数十项发明专利的布局。核心AI训练芯片刹那TM算力可达204TFLOPS/396TOPS以上,自主研发的多至1024片的片间互联构架,为大型模型训练提供了支撑。我们通过比较,可以判断,核心AI训练芯片刹那TM算力技术水平介于谷歌TPU v4芯片和TPU v5p芯片之间,相当于TPUv4.5的水平。

2.在团队方面,中昊芯英核心技术团队多数曾就职于谷歌、苹果、甲骨文、三星、亚马逊、等国际头部公司,均拥有芯片设计一线公司十年以上产业化经验。团队成员曾参与十余款顶级芯片的构架、设计、流片、测试到量产,具备熟练实操芯片落地的能力,掌握了世界最先进高性能芯片完整的设计方法论。

人工智能AI计算现在主流使用英伟达的并行计算为特点的显卡核心GPU来训练和推理工作,伴随着全球算力需求成几何式快速增长,未来必定是使用谷歌等提出的TPU类型专门芯片路线。

根据中昊芯英官方视频介绍:中昊芯英构建了通用AI计算平台,未来必将成为中国自主可控,AI超算与大模型的绝对领先者。

芯片数据: 刹那GPTPU——不是GPU,是专门类别TPU,和拿着显卡当AI芯片的英伟达不一样,TPU是张量处理器(英语:tensor processing unit,缩写:TPU)。

一.单芯片算力:训练204tflops,推理396tops

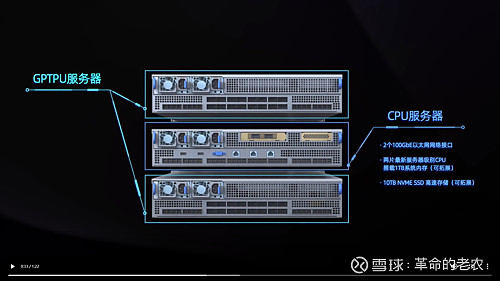

二.4枚芯片安装在一个主板上。

三.2个GPTPU服务器和一个CPU服务器组成1套AI训练服务器(8刹那芯片)。

四.1个训练集群共含有1024个刹那芯片。整个集群训练运算能力高达200PFLOPS。

笔者热谈哥非常看好中昊芯英在中国国内2024~26年高端AI算力云市场超常规的发展前景。如果相关芯片代工产能可以及时供应充足,其竞争力与华为9月推出的昇腾910B芯片也不妨多让。甚至浮点运算峰值算力是其几倍。

笔者热谈哥认为,未来几年,国内 AI云服务器市场将是华为和中昊芯英为代表的优秀AI芯片研发商的逐鹿天下。这些企业的竞争力其中不光有产品的性能,更有及时提供的产能和服务团队的配套的多方面因素。

我们可以高度关注华为和中昊芯英AI算力芯片背后的影子公司,如华为昇腾AI服务器的提供商高新发展、中昊芯英刹那AI服务器的股东科德教育(2026年前可能会以反向收购的方式借壳上市的预期)

$谷歌A(GOOGL)$ $科德教育(SZ300192)$ $英伟达(NVDA)$

作者:革命的老农

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

风险提示:本文所提到的观点仅代表个人的意见,所涉及标的不作推荐,据此买卖,风险自负。

原文链接:https://caifuhao.eastmoney.com/news/20231209124457497729360

评论 ( 0 )