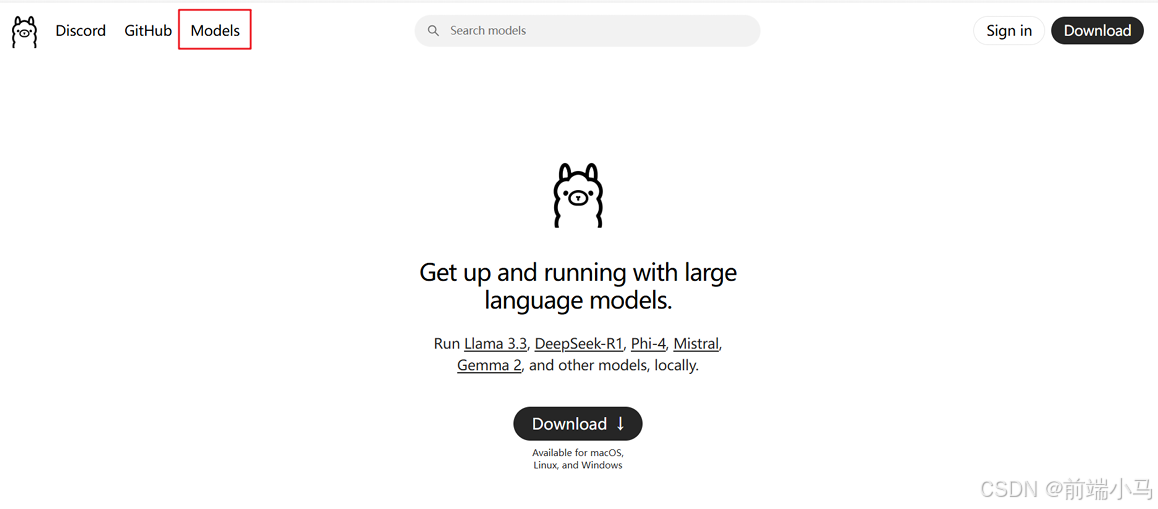

比较流行的是使用ollama:https://ollama.com/

Ollama(https://ollama.com/library,可以理解为替换前面的服务器端,在本地作为服务端,可以是别的平台) +ChatBox、Cherry Studio等(https://chatboxai.app/zh,前端,可以是别的工具如Chrome插件Page Assist或Anything LLM

步骤1:下载Ollama

步骤2:安装Ollama

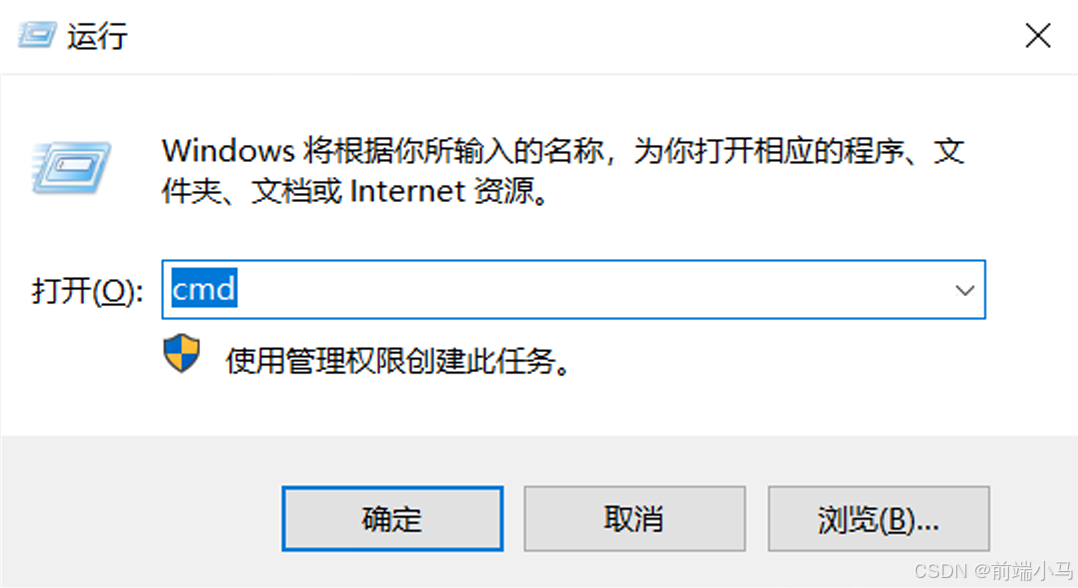

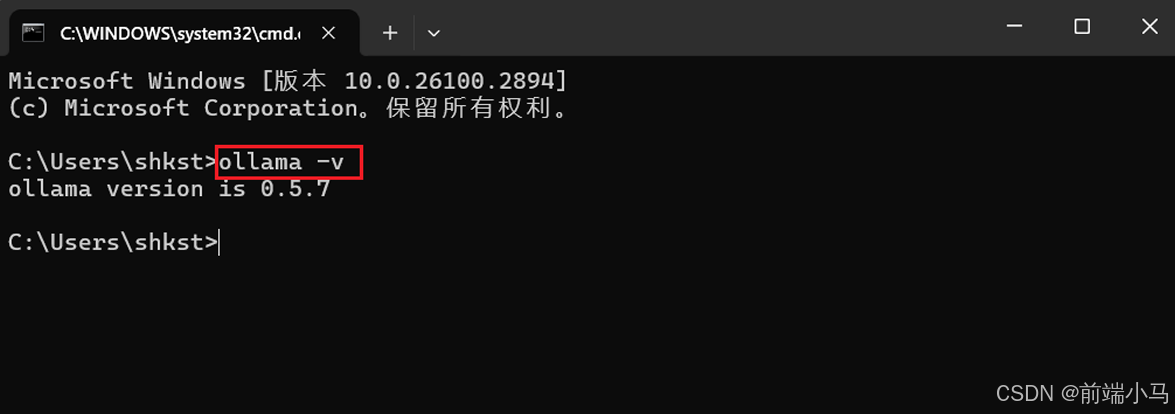

安装完后,验证是否安装成功: ”win+r“输入cmd

命令行输入如下: ollama -v

能显示ollama版本说明安装成功

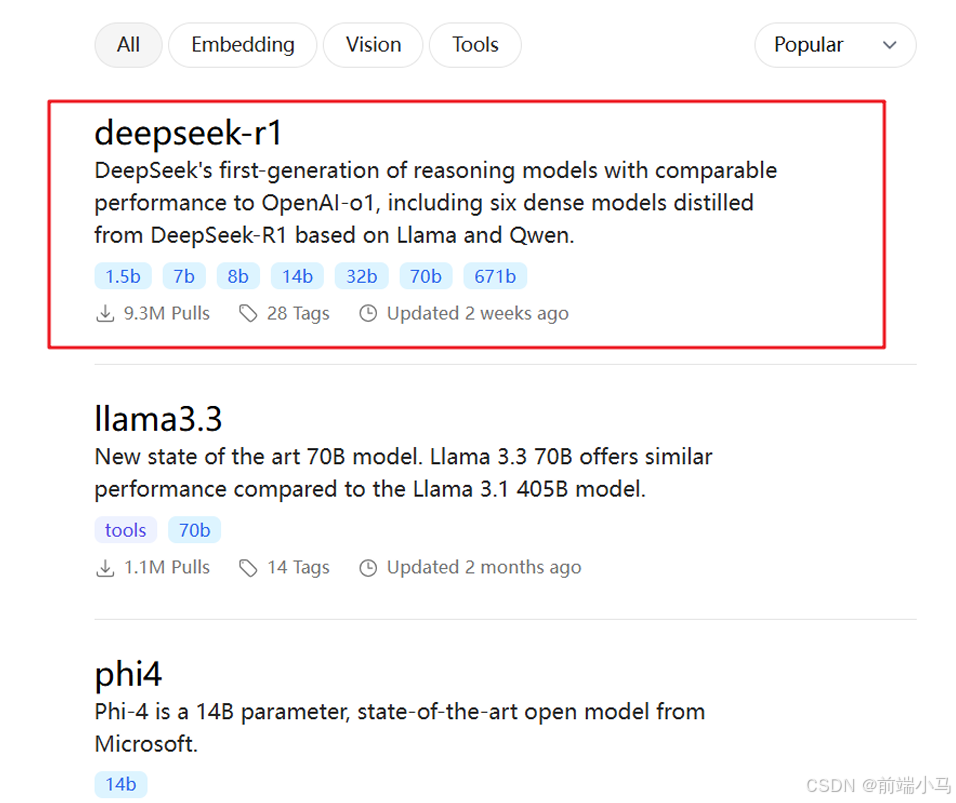

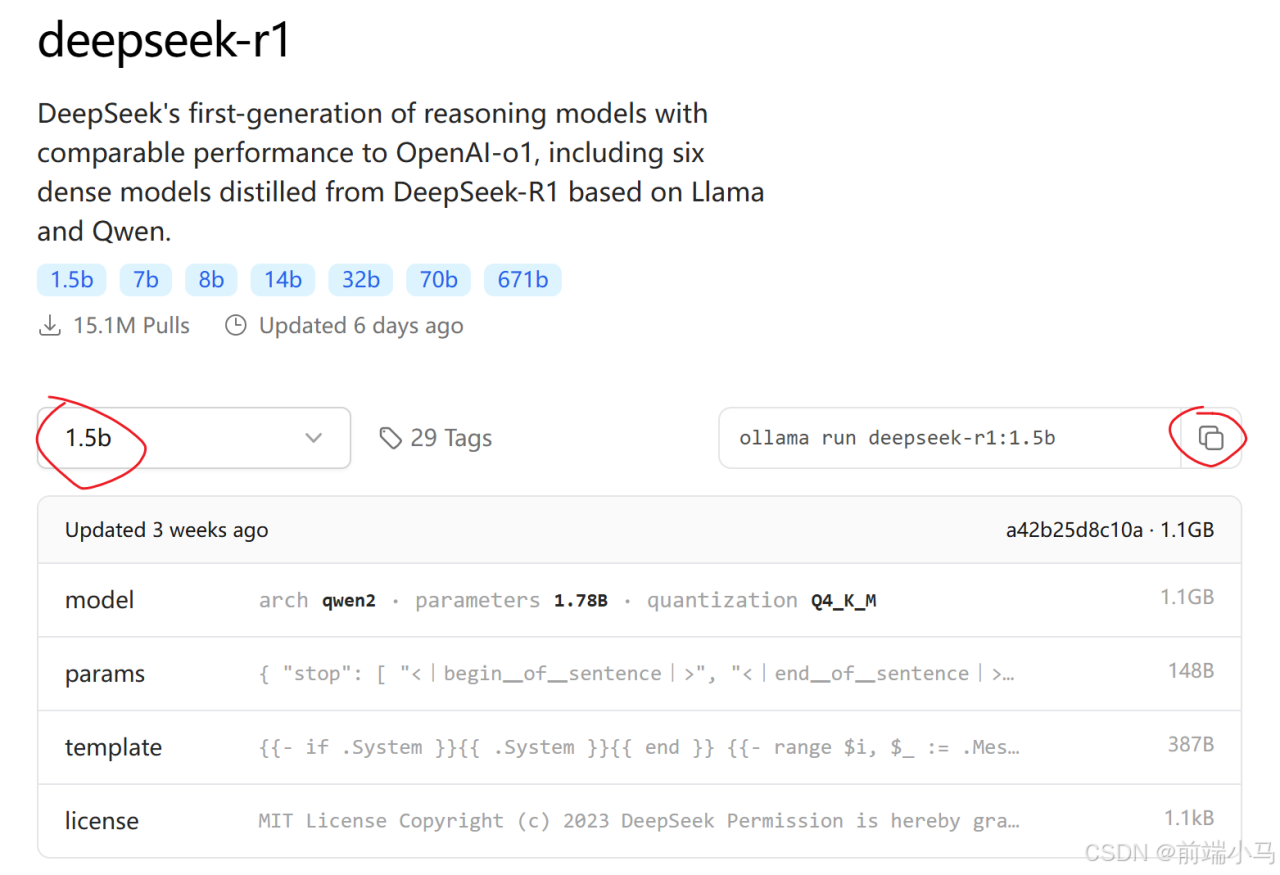

步骤3:选择r1模型

步骤4:选择版本

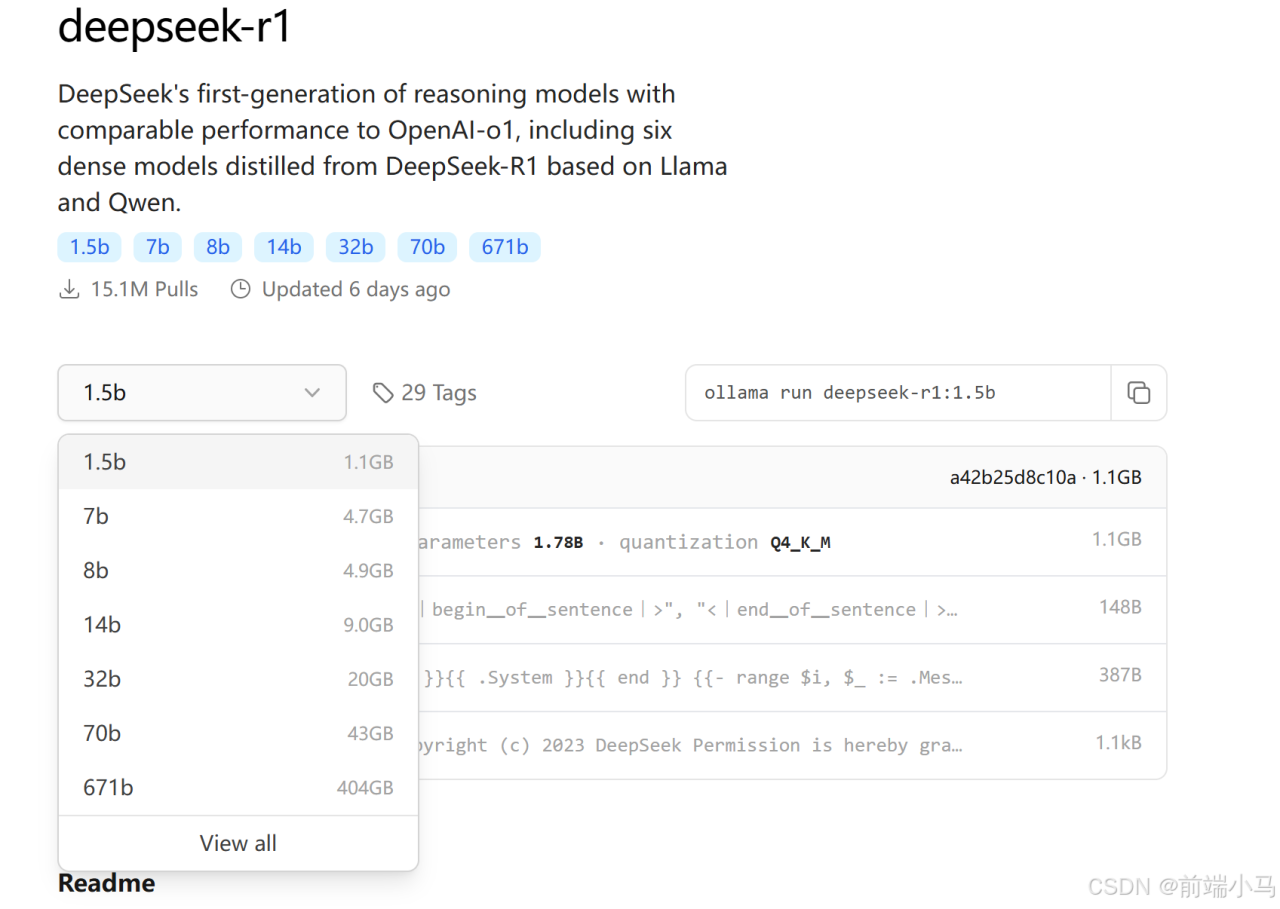

b代表10亿参数量,7b就是70亿参数量。这里的671B是 HuggingFace经过4-bit 标准

量化的,所以大小是404GB。

ollama 支持 CPU 与 GPU 混合推理。将内存与显存之和大致视为系统的 “总内存空

间”

除了模型参数占用的内存+显存空间(比如671B的404GB)以外,实际运行时还需

额外预留一些内存(显存)空间用于上下文缓存。预留的空间越大,支持的上下文

窗口也越大。所以根据你个人电脑的配置,评估你选择部署哪一个版本。如果想运行

404GB的671B,建议你的内存+显存能达到500GB以上

这里我们以1.5B为例,大多数的电脑都能够运行起来

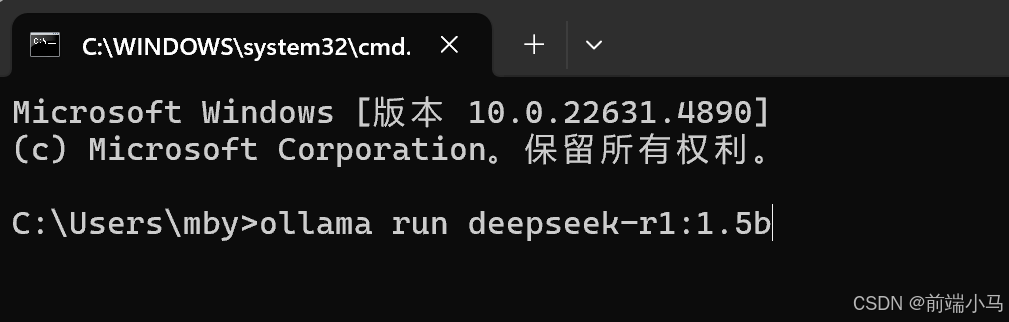

步骤5:本地运行DeepSeek模型

在命令行中,输入如下命令:ollama run deepseek-r1:1.5b

首次运行会下载对应模型文件

下载支持断点续传,如果下载中速度变慢,可以鼠标点击命令行窗口,然后ctrl+c取

消,取消后按方向键“上”,可以找到 上一条命令,即”ollama run deepseek-r1:7b“,

按下回车会重新链接,按照之前进度接着下载。

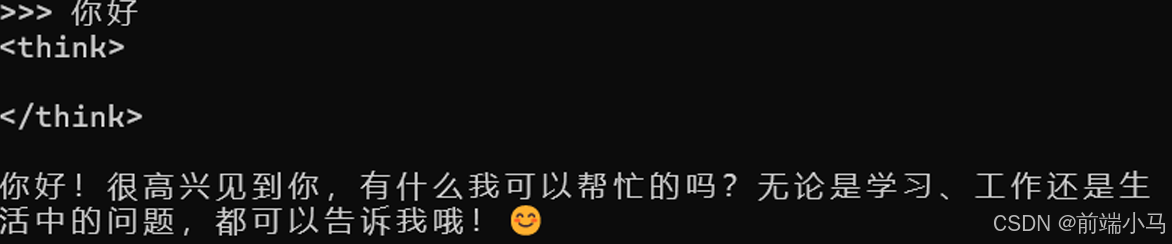

下载完成后,自动进入模型,直接在命令行输入问题,即可得到回复。

比如:打个招呼

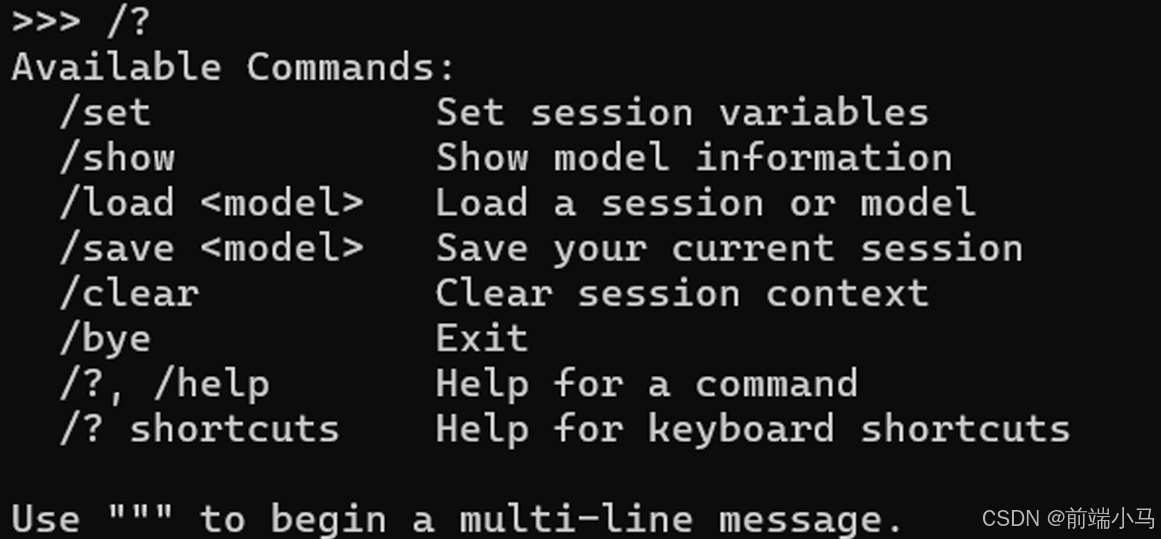

获取帮助:/?

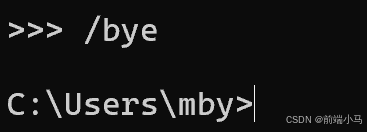

退出对话:/bye

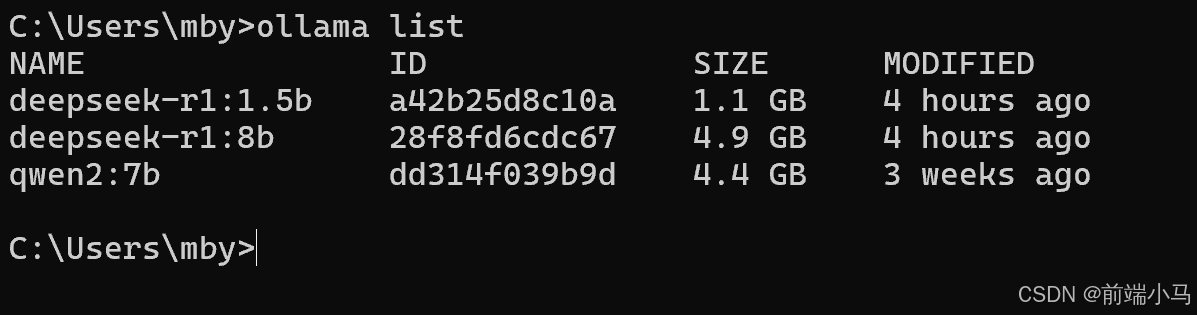

步骤6:查看已有模型

查询已有模型: ollama list

后续要运行模型,仍然使用之前的命令

原文链接:https://blog.csdn.net/qq_56088882/article/details/145607791?ops_request_misc=%257B%2522request%255Fid%2522%253A%252282111677a8bad225fd45ab787913368b%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=82111677a8bad225fd45ab787913368b&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-4-145607791-null-null.nonecase&utm_term=deepseek%E9%83%A8%E7%BD%B2

评论 ( 0 )