DeepSeek本地部署详细指南

随着人工智能技术的飞速发展,本地部署大模型的需求也日益增加。DeepSeek作为一款开源且性能强大的大语言模型,提供了灵活的本地部署方案,让用户能够在本地环境中高效运行模型,同时保护数据隐私。以下是详细的DeepSeek本地部署流程。

一、环境准备

(一)硬件需求

最低配置:CPU(支持AVX2指令集)+ 16GB内存 + 30GB存储。

推荐配置:NVIDIA GPU(RTX 3090或更高)+ 32GB内存 + 50GB存储。

(二)软件依赖

操作系统:Windows、macOS或Linux。

Docker:如果使用Open Web UI,需要安装Docker。

二、安装Ollama

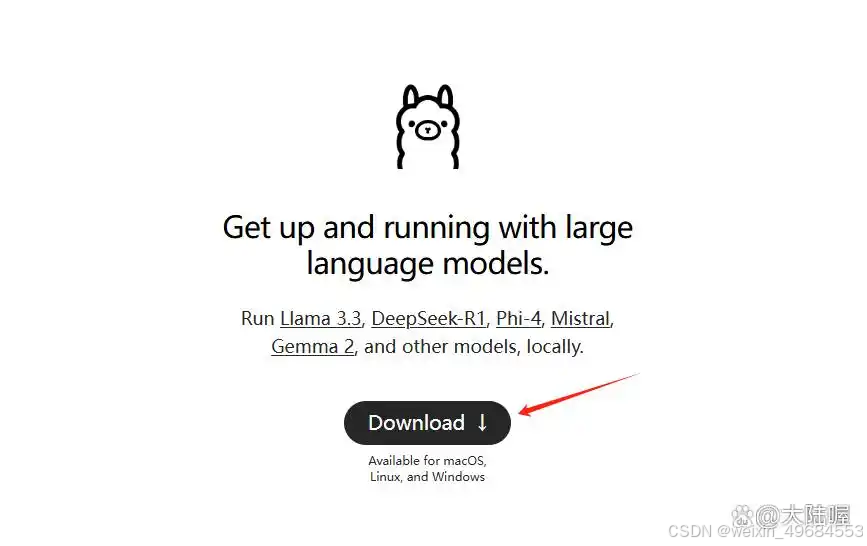

Ollama是一个开源工具,用于在本地轻松运行和部署大型语言模型。以下是安装Ollama的步骤:

访问Ollama官网:前往Ollama官网,点击“Download”按钮。

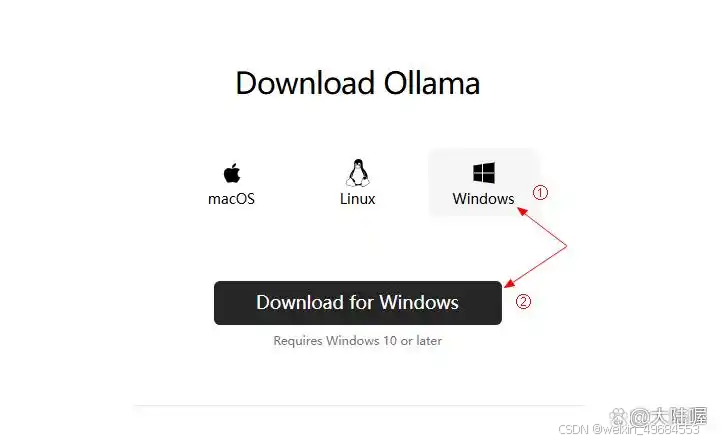

下载安装包:根据你的操作系统选择对应的安装包。下载完成后,直接双击安装文件并按照提示完成安装。

验证安装:安装完成后,在终端输入以下命令,检查Ollama版本:

ollama --version如果输出版本号(例如ollama version is 0.5.6),则说明安装成功。

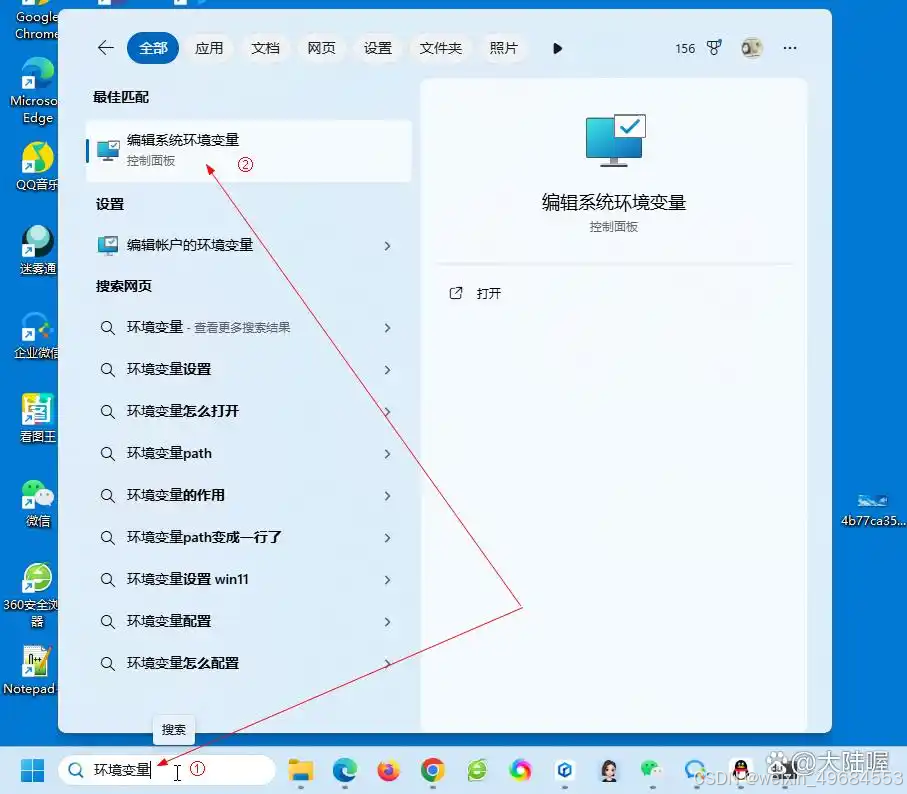

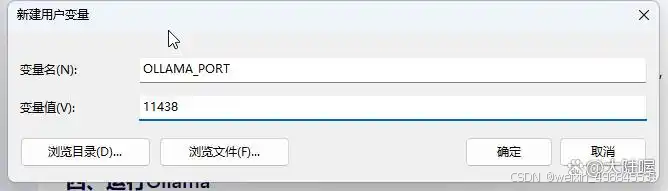

三、ollama配置环境变量

Win10或Win11可以直接搜索“环境变量”,下图搜索,打开“编辑系统环境变量”设置:

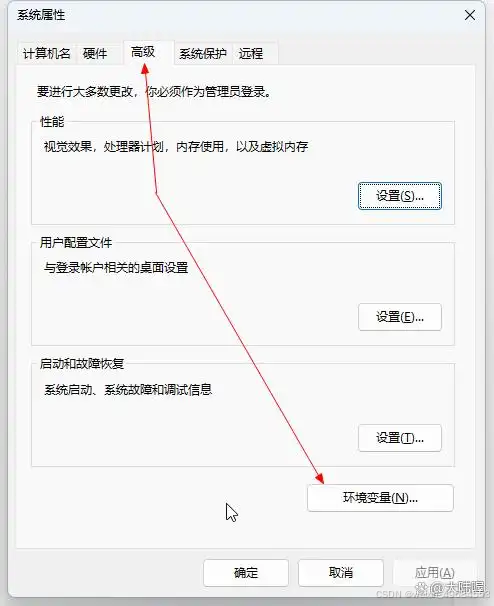

在“高级”下面点“环境变量”,下图所示:

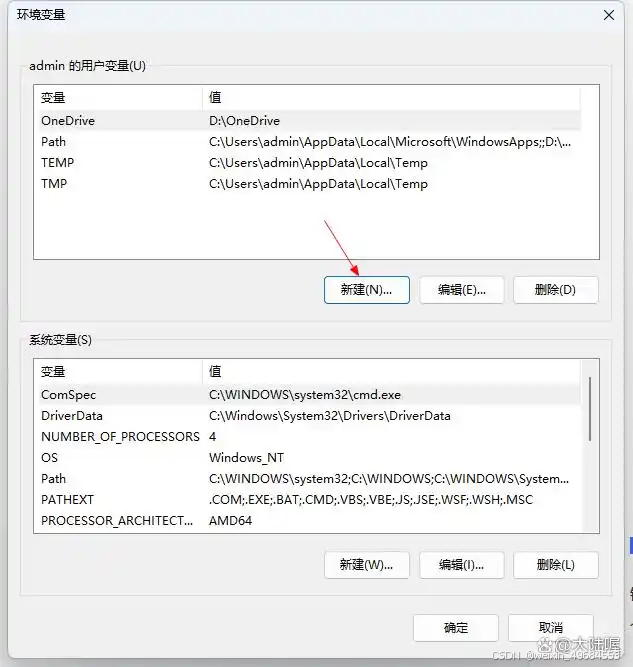

在弹出来的对话框中点下图所示的“新建”:

配置ollama的模型存储路径,默认是C盘,这里我们更改ollama的模型存储为D盘,先打开电脑的D盘创建一个名为“ollama”的文件夹。然后接上面弹出来的对话框中输入变量名和变量值:

变量名:OLLAMA_MODELS

变量值:D:\ollama

填写完成之后点“确定”。这样默认将下载的模型存储到C盘的问题就解决了,需要注意的是该设置需要重启电脑才能生效(我这里先不重启,设置后面的再重启电脑)。

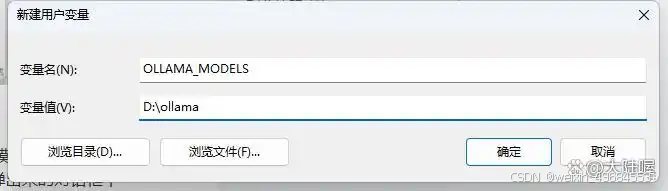

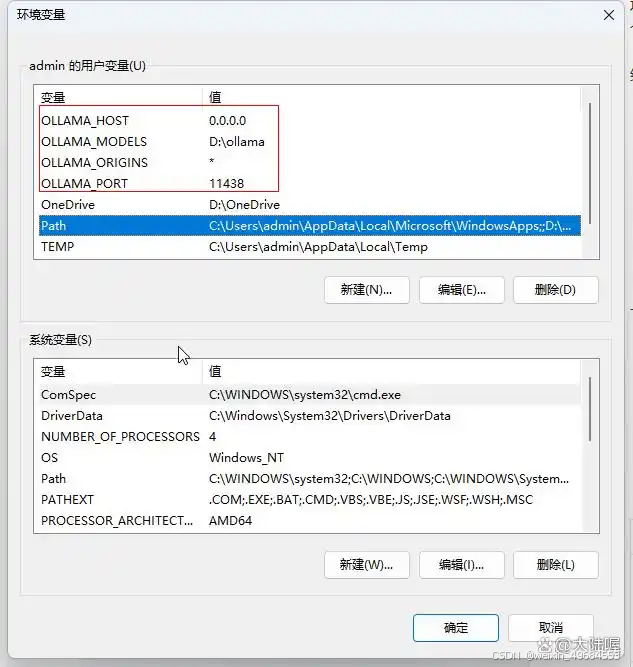

我们继续添加添加环境变量,更改服务监听地址和端口,接上面,我们继续“新建”环境变量,变量名和变量值按以下设置:

变量名:OLLAMA_HOST

变量值:127.0.0.1

监听地址,默认为127.0.0.1(仅限本机访问)。如需远程访问,可设置为0.0.0.0,一般本机访问即可。

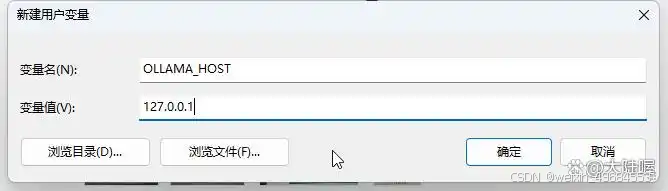

继续“新建”环境变量,修改默认端口号,ollama默认使用11434端口,变量名为“OLLAMA_PORT”,变量值为可以自定义一个5为数字,我这里使用“11438”:

这样就可以解决端口号被占用有冲突的问题,要是这个端口号还不行,那么再更换一个。

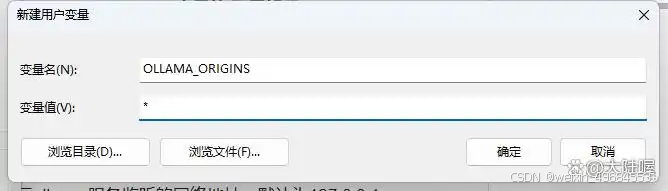

继续再新建变量,为http开放请求,变量名为“OLLAMA_ORIGINS”,变量值填写“*”(星号)即可,下图所示:

下图所示,可以看到,我们连续为ollama添加了4条变量和与之对应的值:

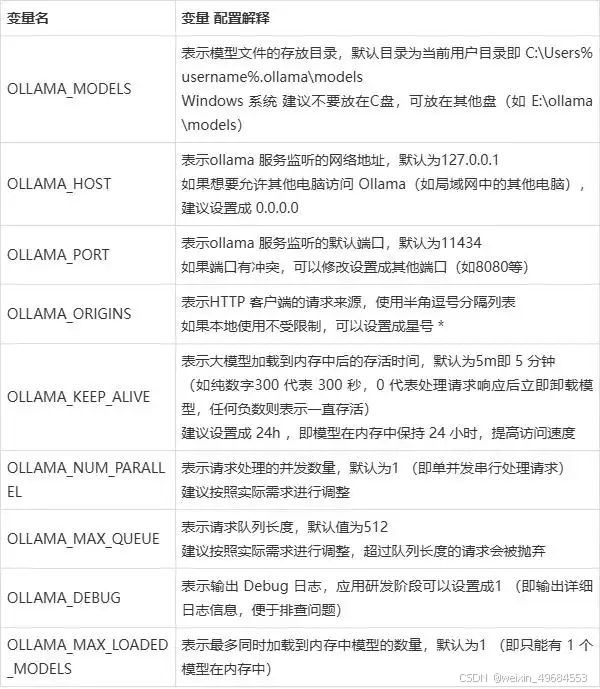

然后点“确定”,完成配置即可,其他的ollama环境变量如下表格所示,可以根据实际情况添加。

注意每次更改环境变量之后,需要重启电脑,配置才会生效,我们这里先不重启,再配置一下防火墙后再重启。

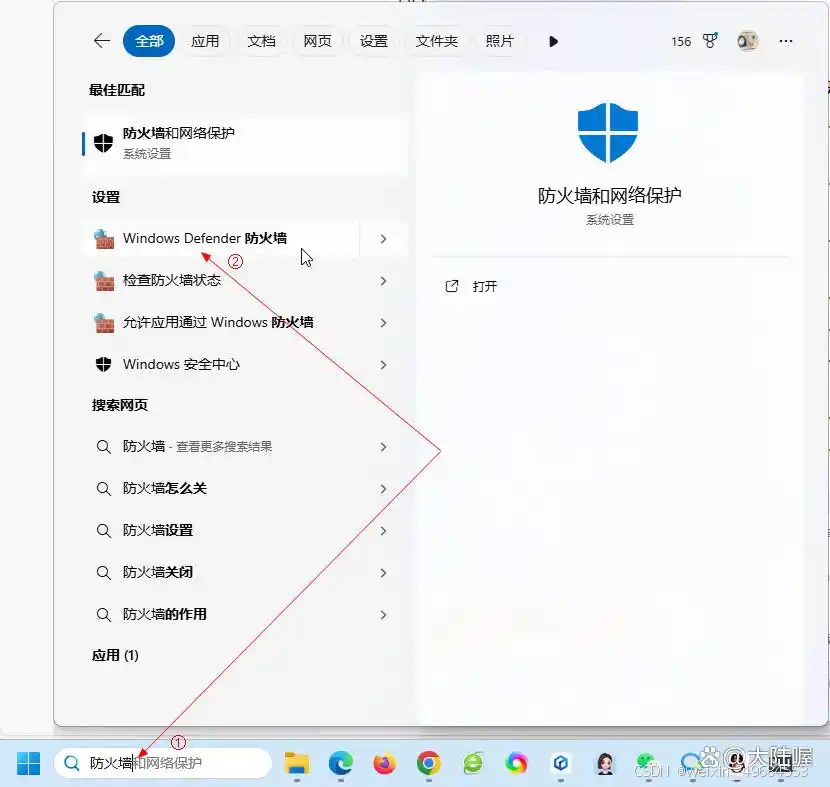

四、防火墙放行新配置的ollama端口

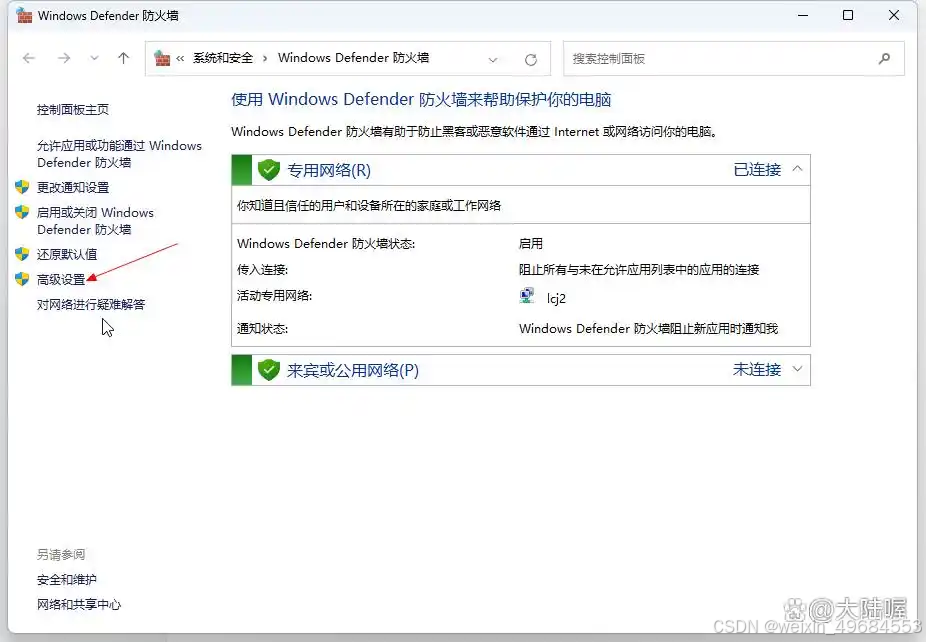

在电脑左下角搜索“防火墙”,下图所示(win10或Win11都有),点“Windows Defender 防火墙”并打开:

然后点下图所示的“高级设置”:

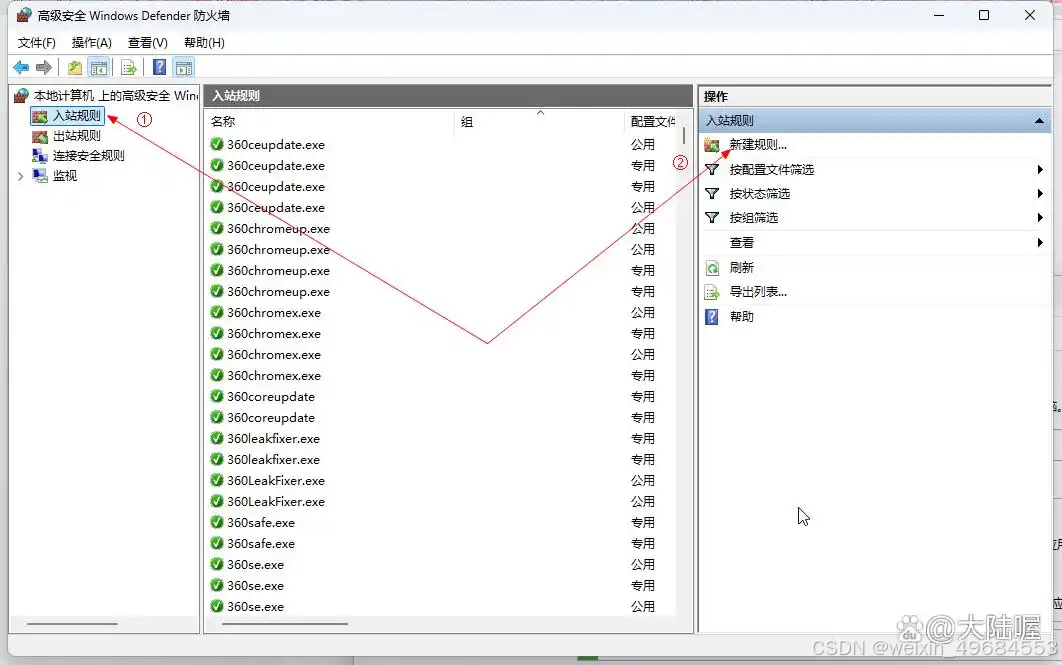

弹出的窗口如下图所示,点左上角“入站规则”,再点右上角“新建规则”:

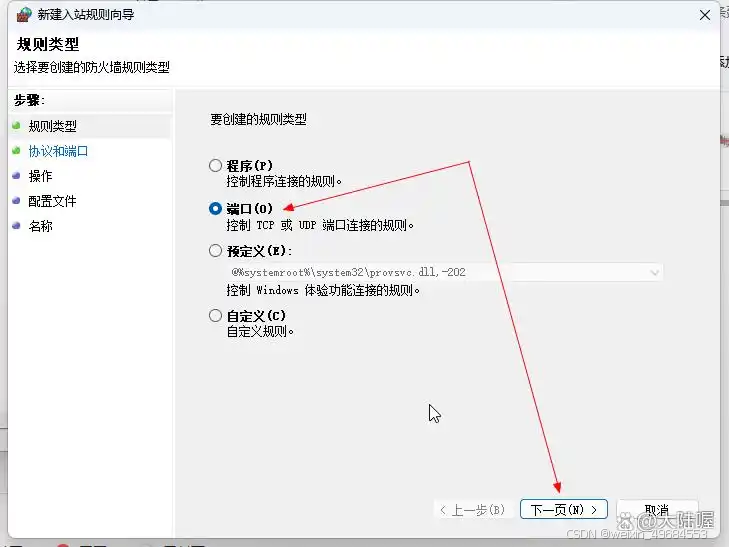

弹出的窗口中选择“端口”后,点“下一页”:

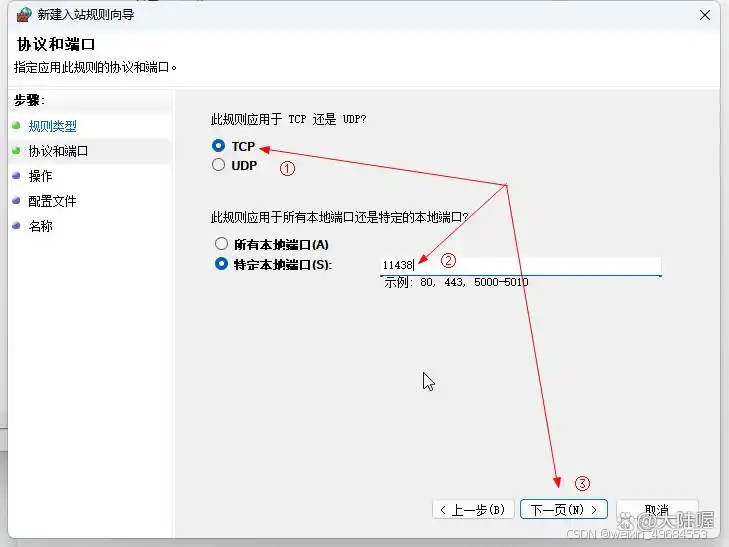

选择“TCP”,再选择“特定本地端口”,并输入前面我们配置环境变量时设置的端口号,如11438,再点“下一页”:

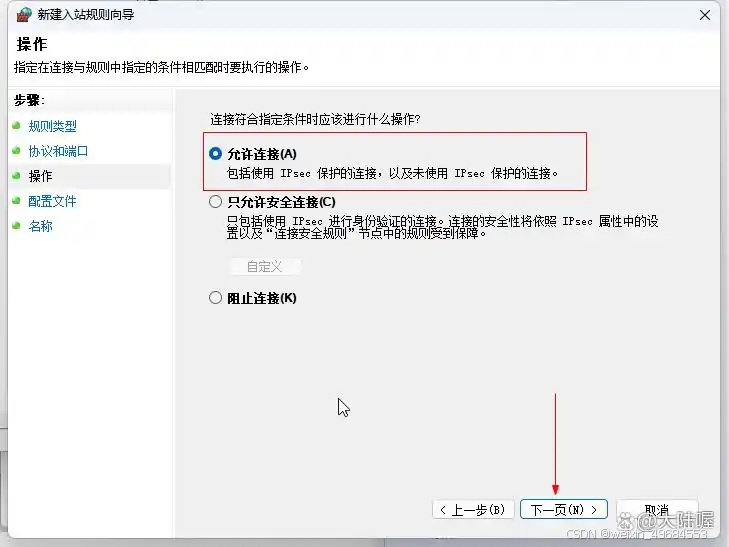

选择“允许链接”,然后点 下一页,下图所示:

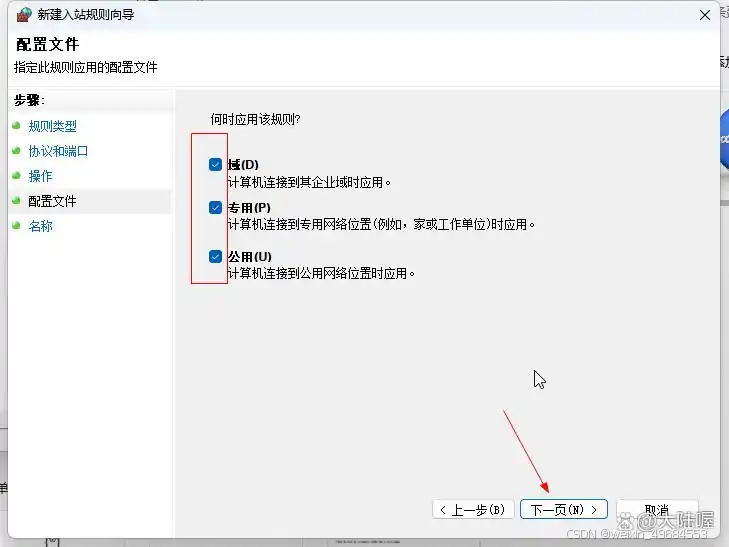

然后弹出来的对话框中把“域、专用、共用”前面的对勾都选上,点“下一页”继续,下图所示:

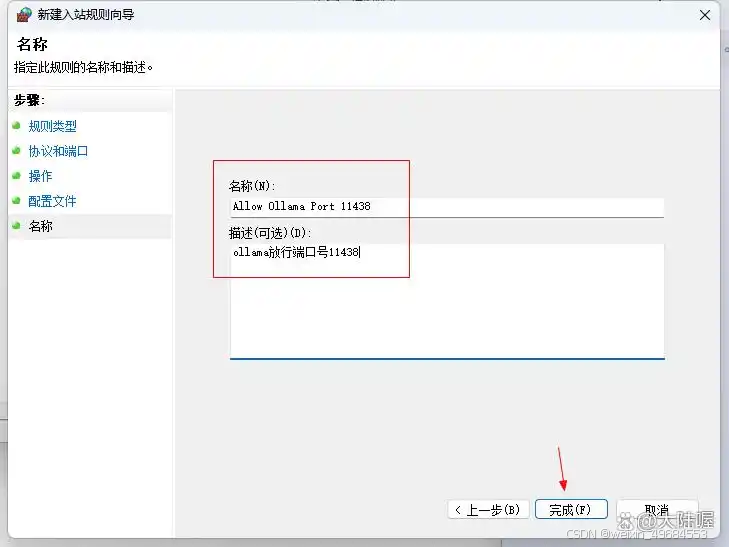

然后在对话框这里的“名称”和“描述”这里,输入一下备注,比如名称为“Allow Ollama Port 11438”,描述为“ollama放行端口号11438”,这里的名称和描述随便填 什么都可以的。填写好之后点“完成”即可。

到此,关于ollama的所有配置就全部完成了,由于前面没有重启电脑,所以先重启电脑使配置的环境变量生效。

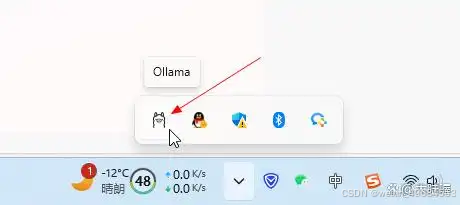

重启电脑之后,默认ollama是跟随系统自动启动的,在电脑的右下角可以看到ollama羊驼小图标,如下图所示,如果没有启动,可以在开始菜单中启动ollama。

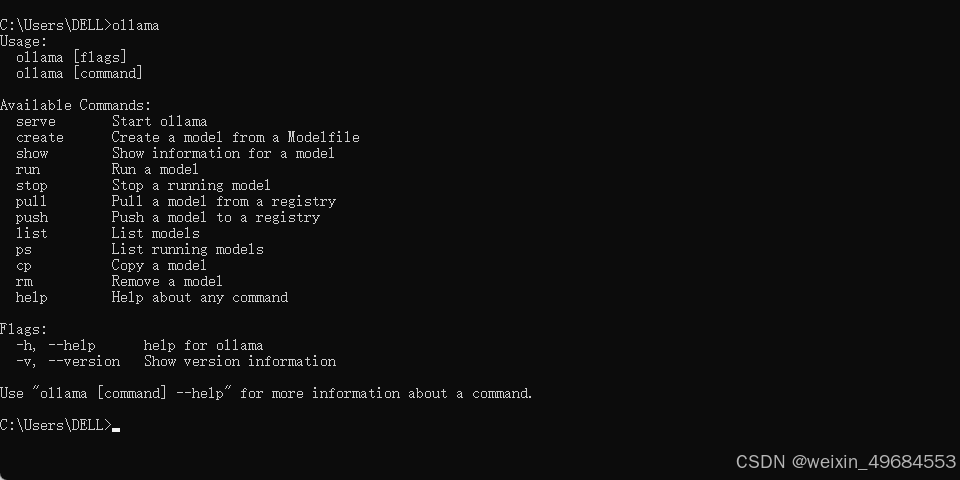

确认ollama已经启动,我们打开命令提示符,使用 win键+R键 输入 “cmd”打开命令提示符,下图所示,输入“ollama”然后回车,如果有下图所示的返回信息,就表示ollama没有问题了。

但是到此,并没有完!我们继续打开浏览,在浏览器的地址栏输入“localhost:11438”或者“127.0.0.1:11438”后回车,看是否能访问,我这里显示不能!提示页面拒绝访问,解决方法是:修改环境变量配置。

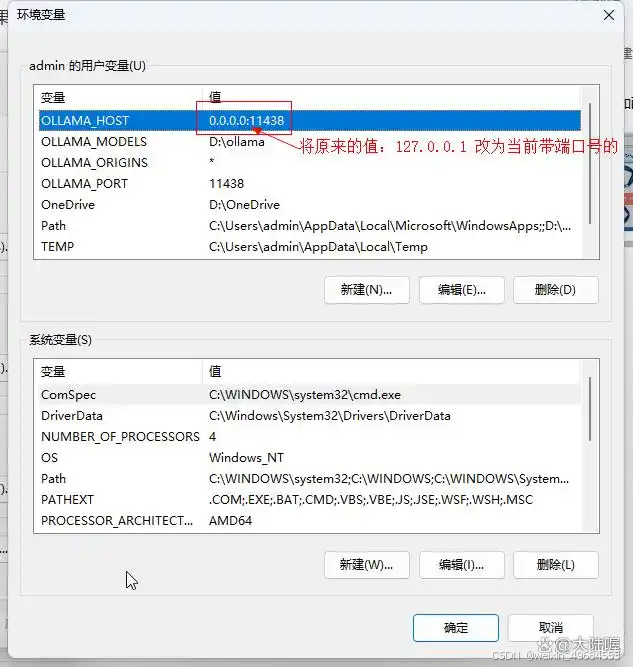

依然打开环境变量设置,修改我们之前添加的变量名为“OLLAMA_HOST”的值,下图所示,找到OLLAMA_HOST这一条,双击打开后将原来的值“127.0.0.1”修改为“0.0.0.0:11438”后保存即可,注意这里的0.0.0.0是任意IP地址的意思,11438是端口号,要和我们放行的端口号保持一致,IP和端口号之间使用英文状态下的冒号隔开。

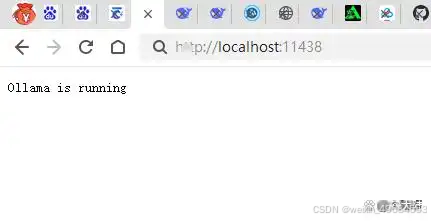

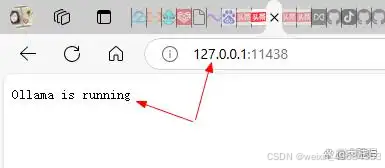

设置好之后点确定。然后电脑右下角在ollama图标上面点鼠标右键点“quit ollama”退出,再从开始菜单中重新打开ollama(也就是重启ollama),然后打开浏览器,在地址栏输入“localhost:11438”或者“127.0.0.1:11438”看是否可以正常访问,如下2张截图所示,我的终于可以成功访问了。

到此,ollama的全部安装配置就完成了。

五、下载并部署DeepSeek模型

Ollama支持多种DeepSeek模型版本,用户可以根据硬件配置选择合适的模型。以下是部署步骤:

选择模型版本:

入门级:1.5B版本,适合初步测试。

中端:7B或8B版本,适合大多数消费级GPU。

高性能:14B、32B或70B版本,适合高端GPU。

下载模型:

启动Ollama服务:

在终端运行以下命令启动Ollama服务:

ollama serve可以通过访问 http://localhost:11434进行查看是否启动成功。

服务启动后,输入以下命令下载并运行DeepSeek模型。例如,下载7B版本的命令为:

ollama pull deepseek-r1:7b如果需要下载其他版本,可以参考以下命令:

ollama pull deepseek-r1:8b # 8B版本 ollama pull deepseek-r1:14b # 14B版本 ollama pull deepseek-r1:32b # 32B版本下载完成后,可以使用以下命令查看已下载的模型列表:

ollama list可以通过以下命令运行模型:

ollama run deepseek-r1:7b这将启动 DeepSeek 7B 模型,并进入交互式命令行界面,可以直接与模型对话。

虽然我们可以在本地正常使用 Deepseek 这个模型了,但是这个 AI 工具的面板是非常简陋的,很多人使用不习惯,这时我们就可以通过 Chatbox 这个可视化图文交互界面来使用它。

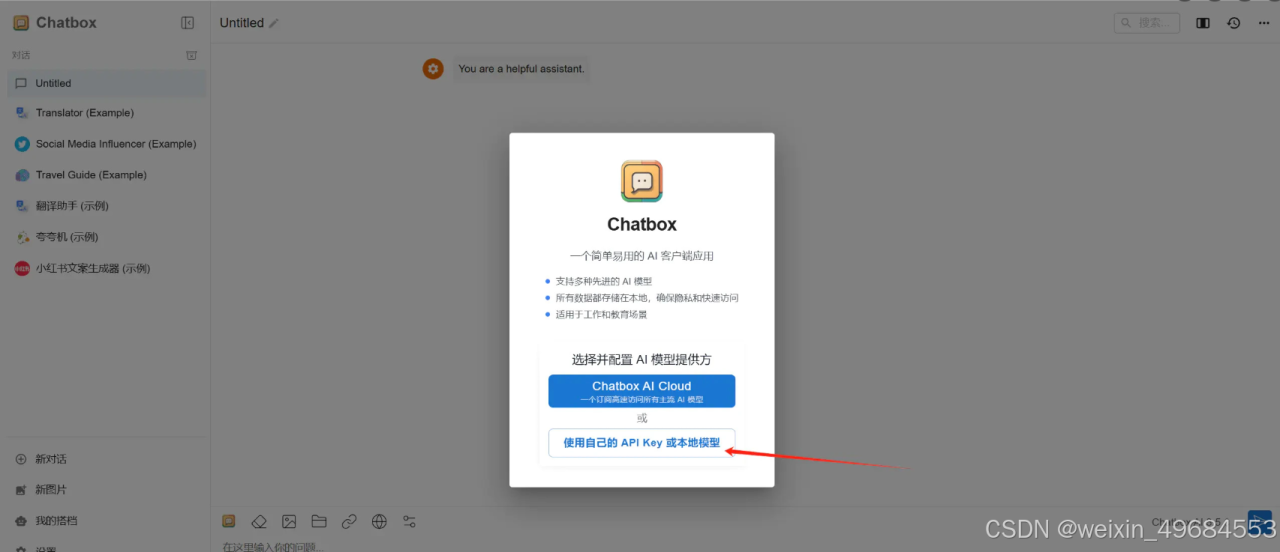

点击 Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载 进入 Chatbox 官网,Chatbox 虽然有本地客户端,但我们也可以直接使用网页版。

进入 Chatbox 网页版本后点击使用自己的 API Key 或本地模型。

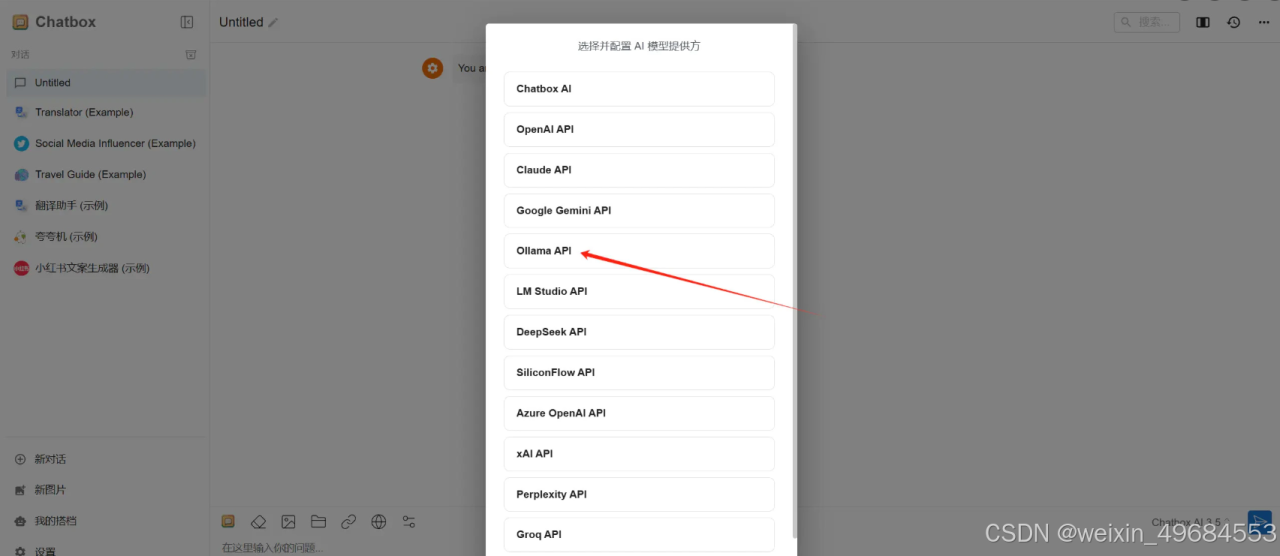

点击后会进入模型提供方选择界面,这里选择 Ollama API 。

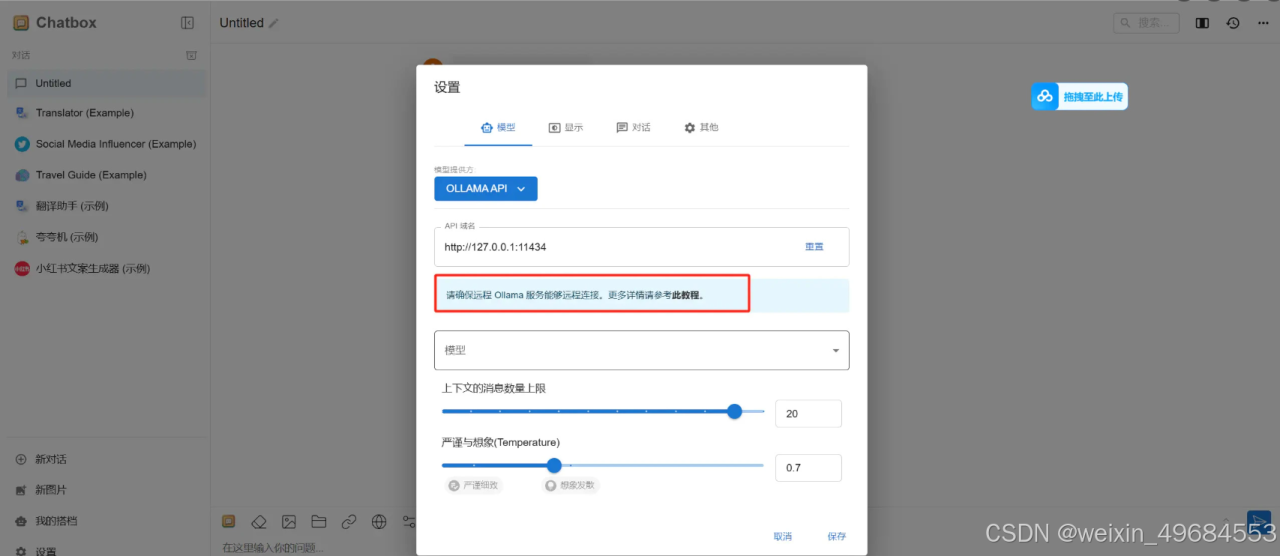

这里需要注意的是,为了能够 Ollama 能远程链接,这里我们最好看一下 Chatbox 提供的教程,根据这个教程操作一下。

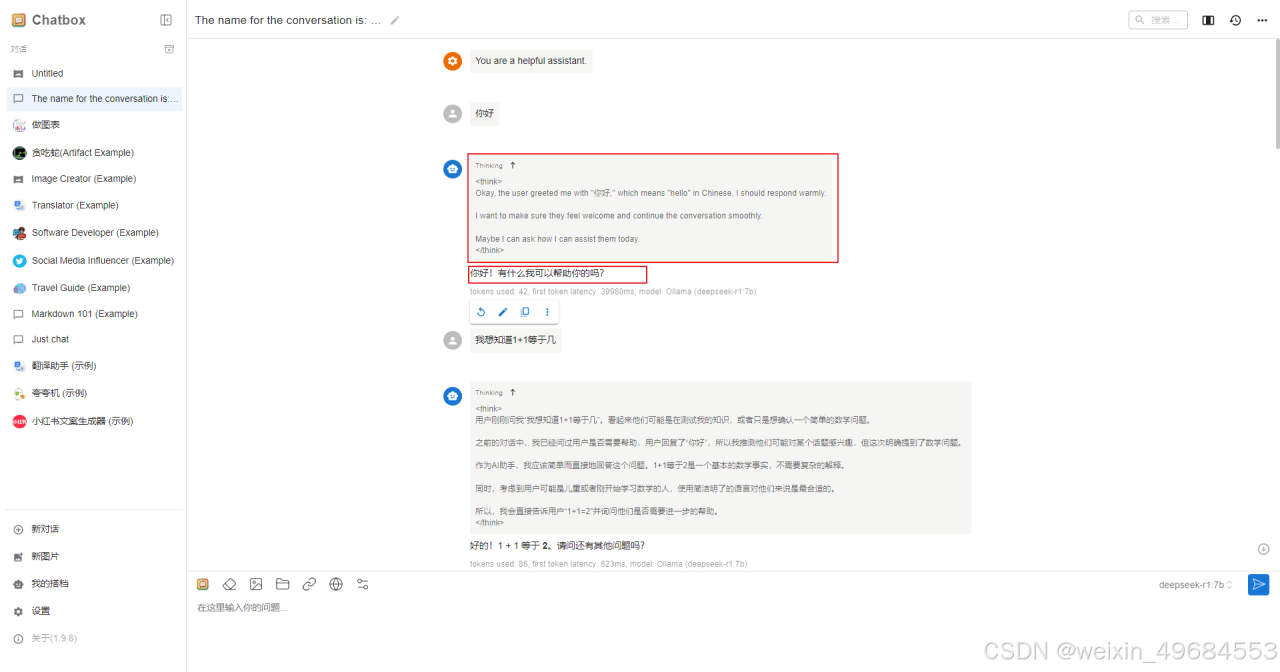

接下来只需要在 Chatbox 中新建对话即可使用 Deepseek 模型了,以下图为例,上方是它的思考过程,下方是它给出的答案。

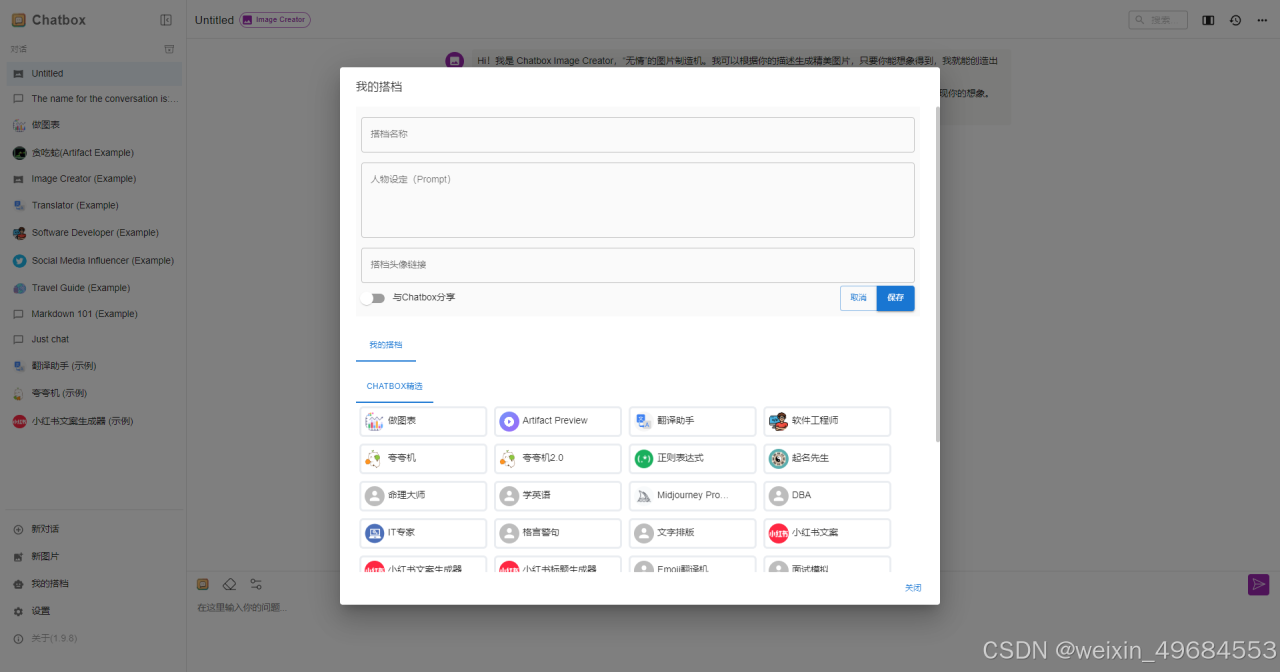

Chatbox 可视化图文交互界面还有一个特点就是可以创建专属智能体,只需点击我的搭档即可创建,此功能是 Deepseek 官方暂时还没有的功能。

到此我们可以使用自己的大模型了。

原文链接:https://blog.csdn.net/weixin_49684553/article/details/145537728?ops_request_misc=%257B%2522request%255Fid%2522%253A%25220ccaa27765db51cfa4a440fd79f08470%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=0ccaa27765db51cfa4a440fd79f08470&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-7-145537728-null-null.nonecase&utm_term=deepseek%E9%83%A8%E7%BD%B2

评论 ( 0 )