部署说明:

1)所用系统:WIN10 专业版

2)电脑硬件:CPU是Intel(R) Core(TM) i7-1165G7,内存 16G,显存4G

3)本文提到的软件不用科学上网也能下载

4)采用的移动宽带500M,部署7b版用时2小时,主要看网络下载速度。

对于新手小白来说,它就是一个成年人的玩具,不用对这个部署模型抱有太大期望,不过嘛,有时候玩具也会给人不少启发。

闲话少叙,上教程:

很多小伙伴不知道自己的电脑能不能跑得动「DeepSeek」模型,目前最新的 DeepSeek-R1 提供了多个蒸馏后的参数模型,包括有:1.5b、7b、8b、14b、32b、70b,以及满血版 671b 大模型。

一、安装deepseek-R1模型

1、先到网站测试下,自己的电脑硬件配置适配哪个版本模型。

参数模型硬件要求

以下是不同参数量模型的本地部署硬件要求和适用场景分析。注:部分数据基于模型通用需求推测,具体以实际部署测试为准。

✅ DeepSeek-R1-1.5B

CPU: 最低 4 核(推荐 Intel/AMD 多核处理器)

内存: 8GB+

硬盘: 3GB+ 存储空间(模型文件约 1.5-2GB)

显卡: 非必需(纯 CPU 推理),若 GPU 加速可选 4GB+ 显存(如 GTX 1650)

场景:低资源设备部署,如树莓派、旧款笔记本、嵌入式系统或物联网设备

✅ DeepSeek-R1-7B

CPU: 8 核以上(推荐现代多核 CPU)

内存: 16GB+

硬盘: 8GB+(模型文件约 4-5GB)

显卡: 推荐 8GB+ 显存(如 RTX 3070/4060)

场景:中小型企业本地开发测试、中等复杂度 NLP 任务,例如文本摘要、翻译、轻量级多轮对话系统

✅ DeepSeek-R1-8B

CPU: 8 核以上(推荐现代多核 CPU)

内存: 16GB+

硬盘: 8GB+(模型文件约 4-5GB)

显卡: 推荐 8GB+ 显存(如 RTX 3070/4060)

场景:需更高精度的轻量级任务(如代码生成、逻辑推理)

✅ DeepSeek-R1-14B

CPU: 12 核以上

内存: 32GB+

硬盘: 15GB+

显卡: 16GB+ 显存(如 RTX 4090 或 A5000)

场景:企业级复杂任务、长文本理解与生成

✅ DeepSeek-R1-32B

CPU: 16 核以上(如 AMD Ryzen 9 或 Intel i9)

内存: 64GB+

硬盘: 30GB+

显卡: 24GB+ 显存(如 A100 40GB 或双卡 RTX 3090)

场景:高精度专业领域任务、多模态任务预处理

✅ DeepSeek-R1-70B

CPU: 32 核以上(服务器级 CPU)

内存: 128GB+

硬盘: 70GB+

显卡: 多卡并行(如 2x A100 80GB 或 4x RTX 4090)

场景:科研机构/大型企业、高复杂度生成任务

✅ DeepSeek-R1-671B

CPU: 64 核以上(服务器集群)

内存: 512GB+

硬盘: 300GB+

显卡: 多节点分布式训练(如 8x A100/H100)

场景:超大规模 AI 研究、通用人工智能(AGI)探索

我的配置,只能用最小的1.5b模型。

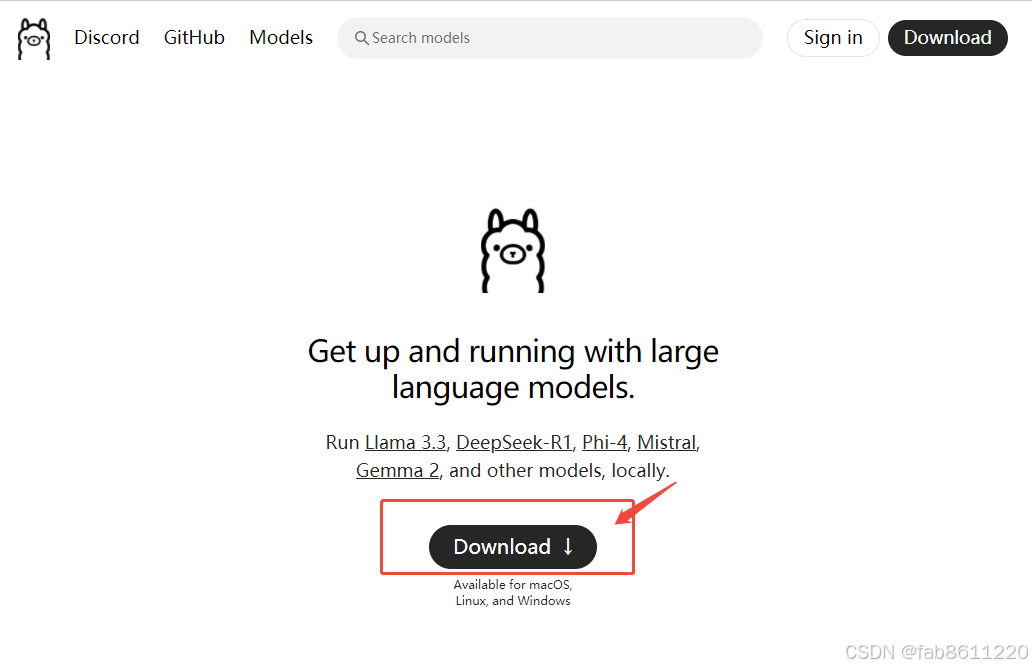

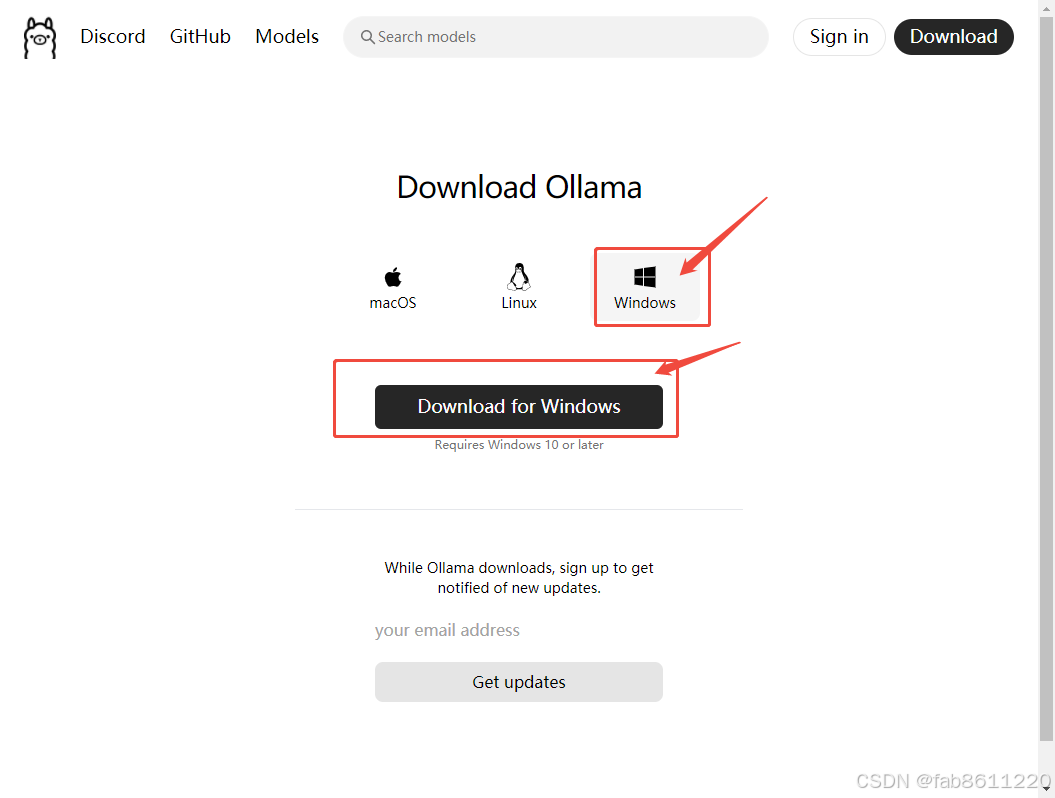

2、下载软件Ollama(官网:https://ollama.com/)

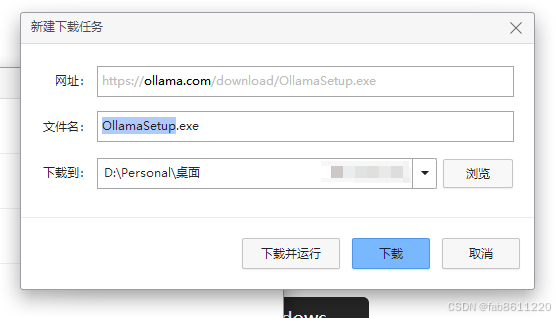

下载完OllamaSetup.exe,windows版的是767MB,默认只能装在C盘上,默认下一步,完成安装后,

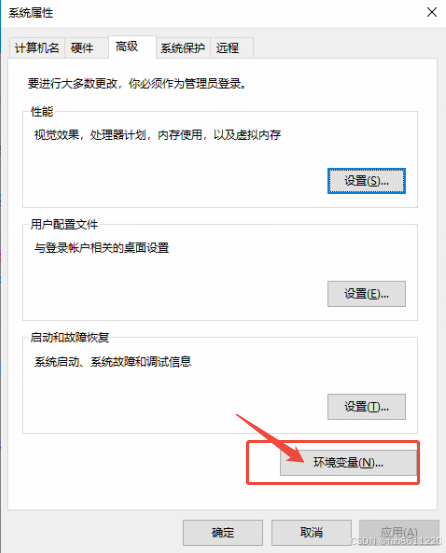

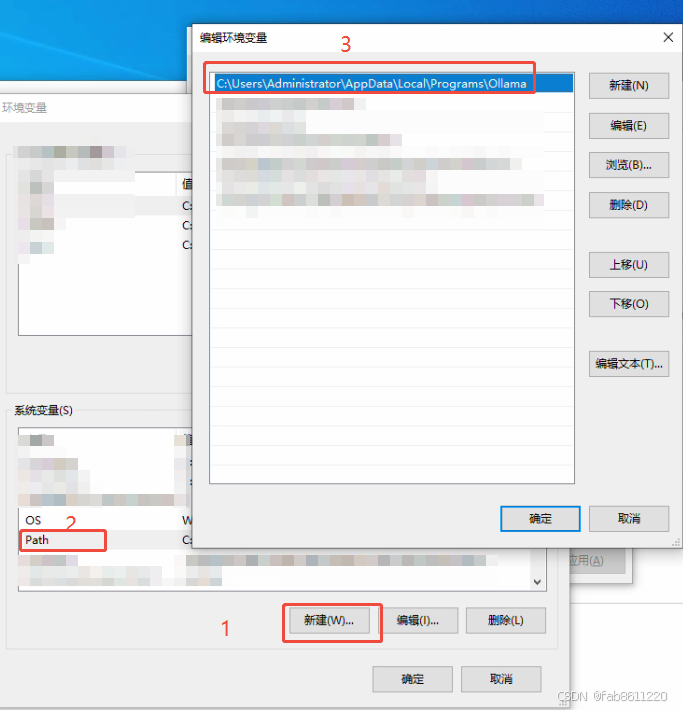

打开系统属性(右键点击我的电脑,选属性,点高级系统设置)设置系统环境变量。新建,名称Path,内容:你的“Ollama”安装路径,如图我默认C盘。

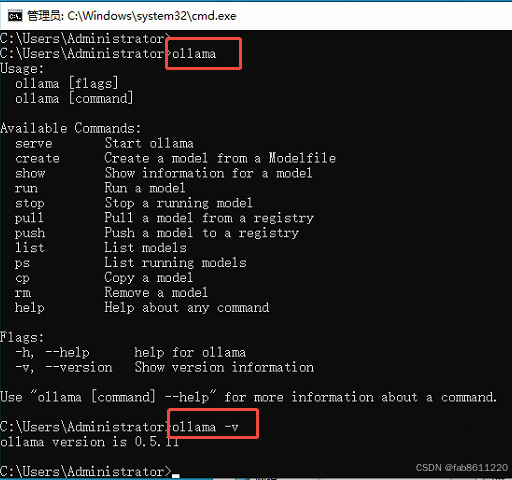

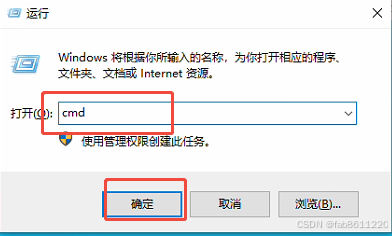

3、安装完后,要验证下Ollama是否安装成功,WIN+R,打开【CMD 命令提示符】或者【终端PowerShell】,输入【ollama】显示如图代码,成功。输入【ollama -v】显示版本号,验证成功。

到这里表示我们的,第一部必要的软件框架安装完毕,接下来就是下载deepseek的模型了。

4、模型下载

通过配置,我的电脑只能够运行1.5B,但是我就想着试试能不能跑7B或8B,后来试了下,还可以,就是速度慢。把7b个模型下载了。操作步骤。

在CMD终端下通过命令下载DeepSeek R1

1.5b

ollama run deepseek-r1:1.5b

7b

ollama run deepseek-r1:7b

8b

ollama run deepseek-r1:8b

14b

ollama run deepseek-r1:14b

32b

ollama run deepseek-r1:32b

70b

ollama run deepseek-r1:70b

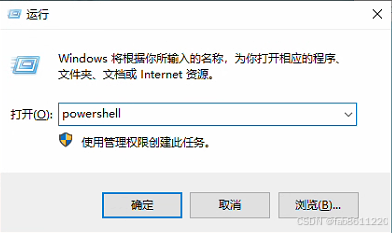

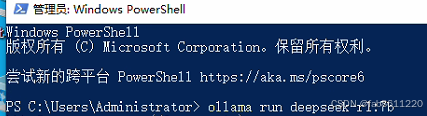

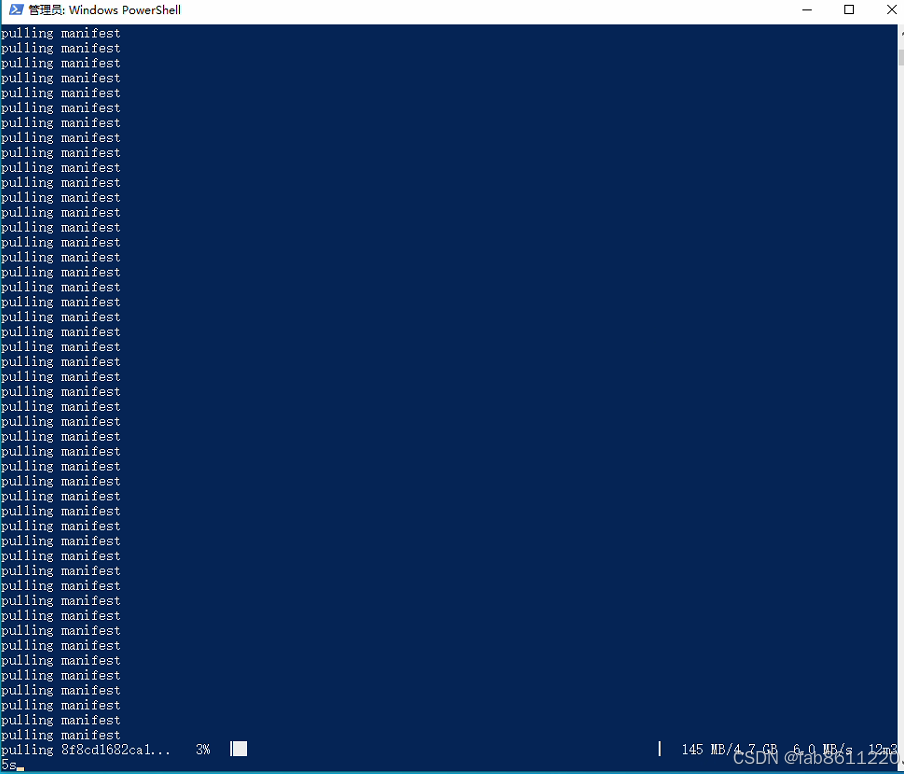

打开WIN+R, 输入PowerShell,打开【终端PowerShell】,

复制【ollama run deepseek-r1:7b】,在【终端PowerShell】,Ctrl+V粘贴,回车即可。

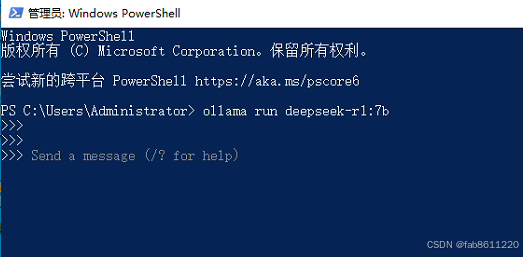

之后会出现各种下载界面,文件大小,下载速度,下载的百分百等,下载完成了则会提示【send a meissage】

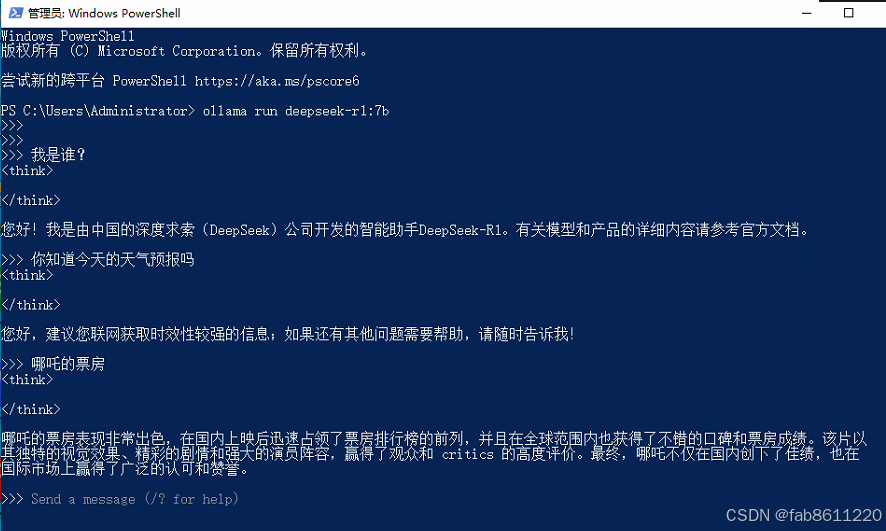

我选择的是7B版本的,因为之前已经下载过了,所以输入口令就直接进入了模型。

随便测试了下,可以正常使用,天气预报,票房等时效性问题,需要联网学习,才会。

二、通过安装浏览器插件调用DeepSeek-R1模型

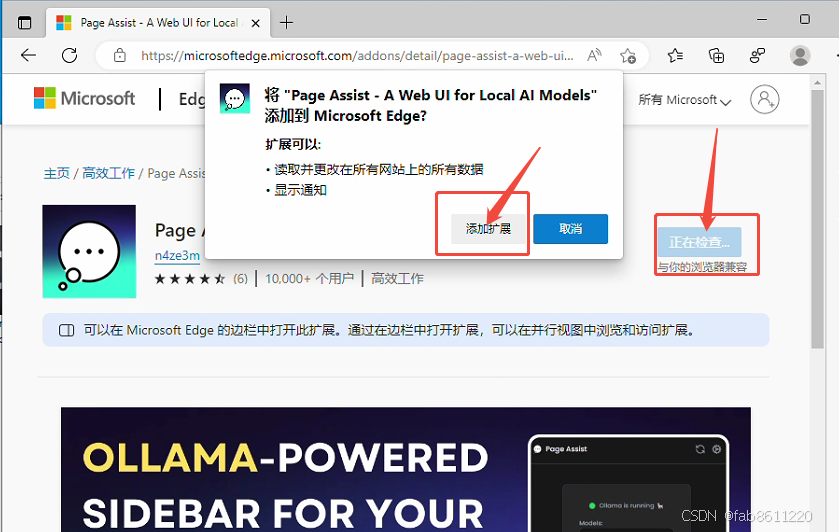

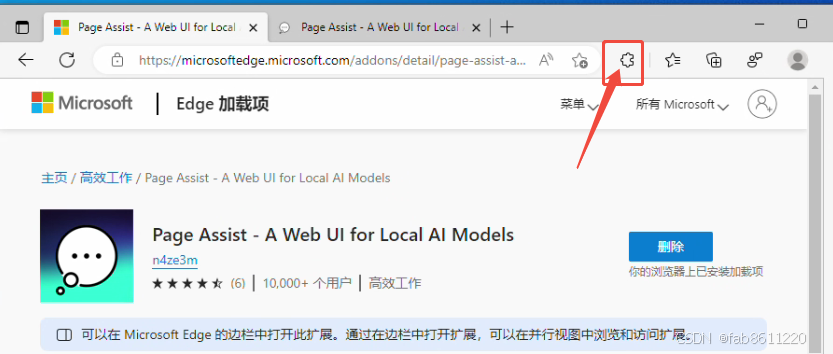

1、插件地址:https://microsoftedge.microsoft.com/addons/detail/page-assist-a-web-ui-fo/ogkogooadflifpmmidmhjedogicnhooa?hl=zh-CN

点击【获取】——【添加扩展】

安装完成后,点开【扩展】

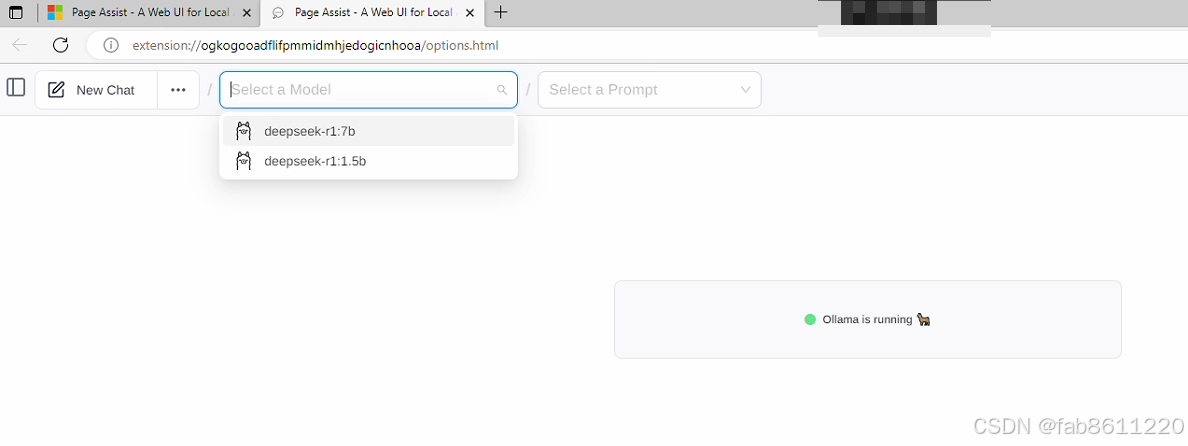

看到这个界面,表示已经成功了99%,下拉选择你已下载好的模型,如这里选中7B的模型

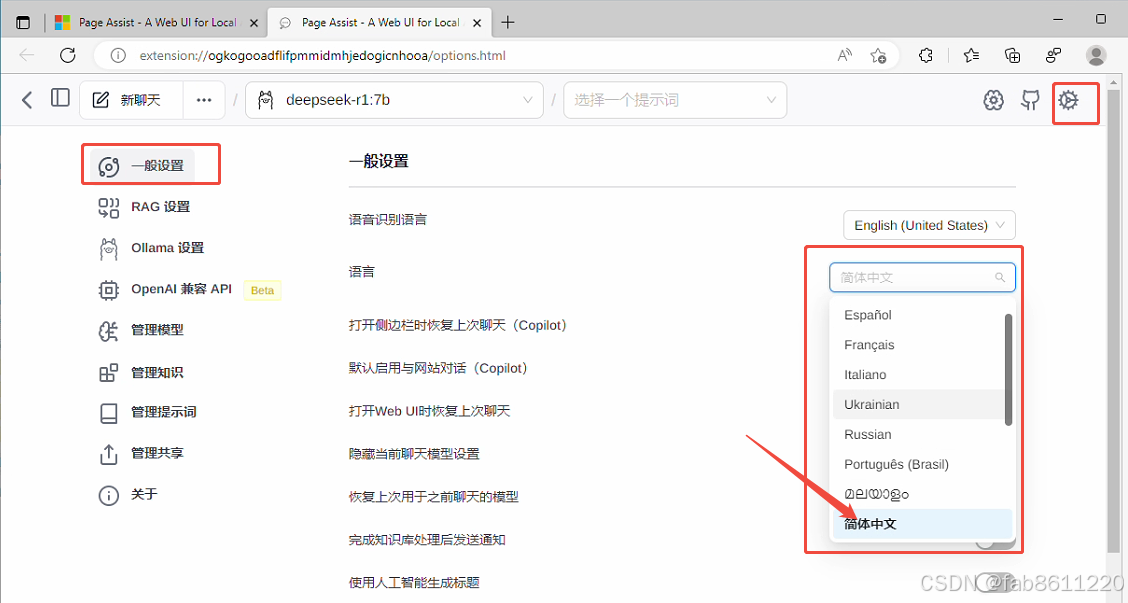

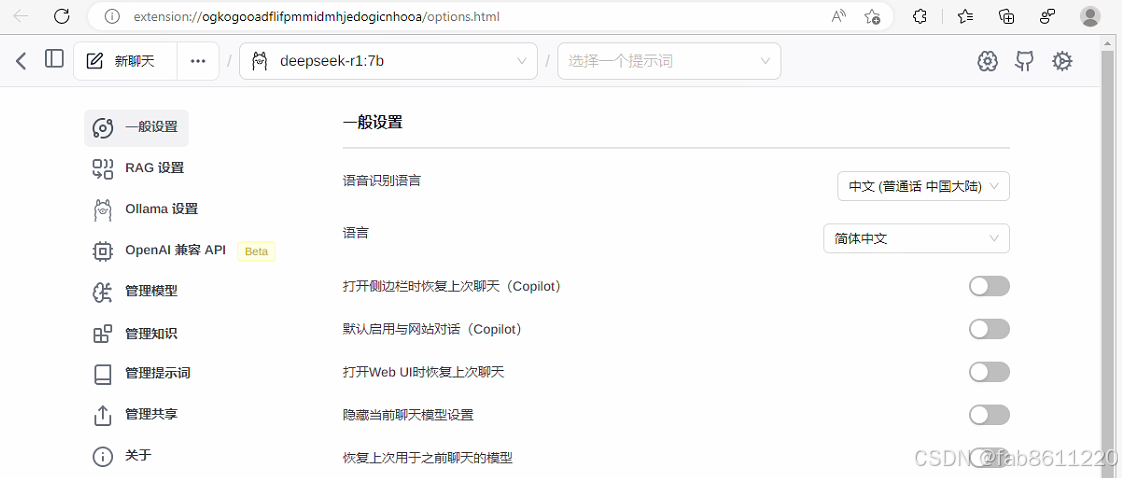

首次打开,界面都是英文的。第一步,将语言 切换成 简体中文。方便后面的操作。点击【齿轮】图标——一般设置——简体中文

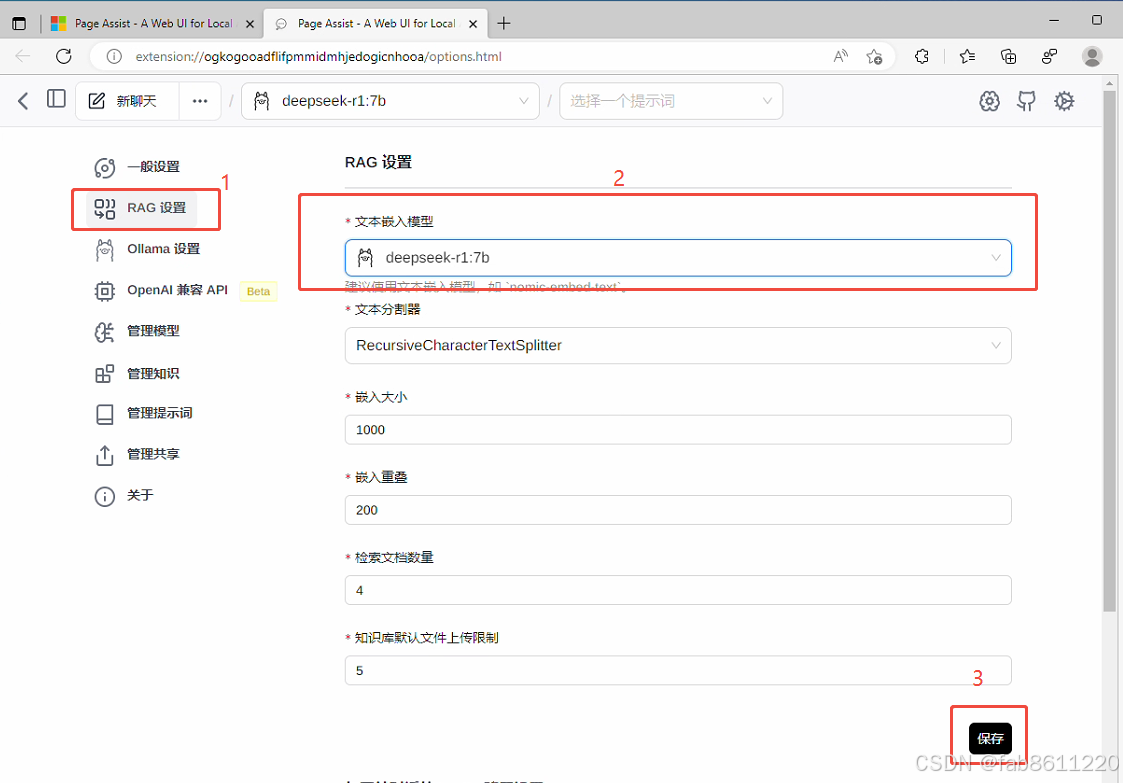

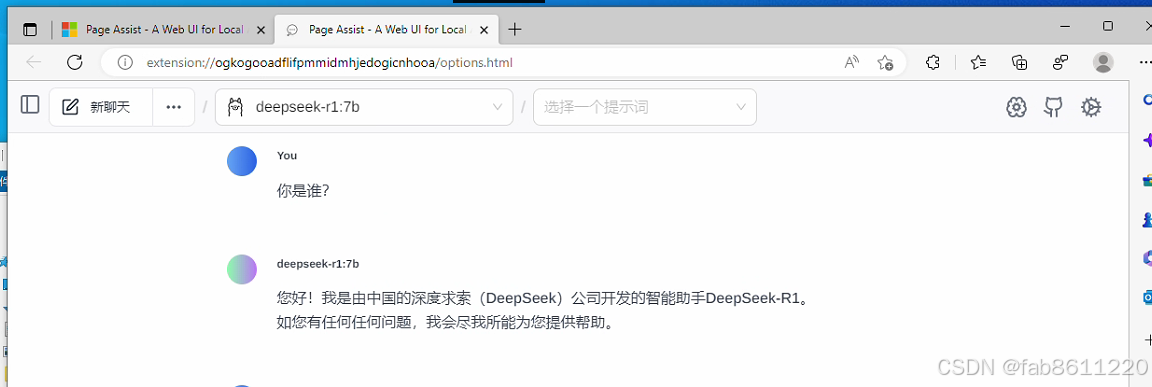

RAG设置,选中7B的模型——保存。 测试对话功能,测试成功,可以回答。

测试对话功能,测试成功,可以回答。

安装成功。

原文链接:https://blog.csdn.net/fab8611220/article/details/145769280

评论 ( 0 )