一、所需资源

程序

-

Ollama

-

Cherry Studio

模型

-

deepseek-r1

-

bge-m3

知识

-

你的学习笔记

二、Ollama及模型安装

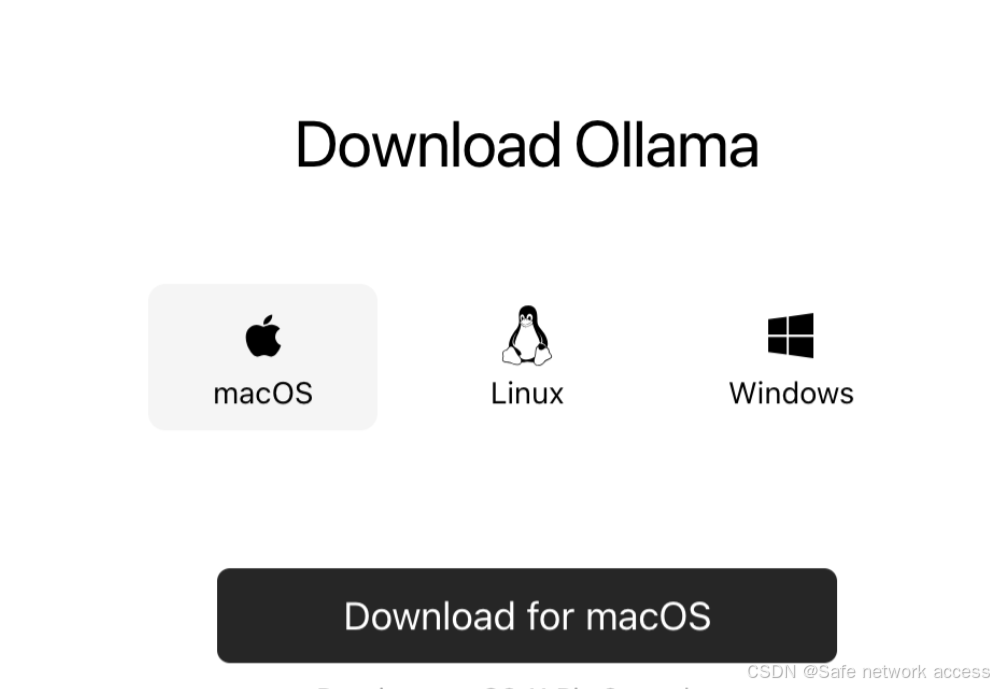

我们去ollama官网下载该模型部署工具,访问以下链接。

https://ollama.com/download

选择对应的版本进行下载。

下载完成后双击安装即可。

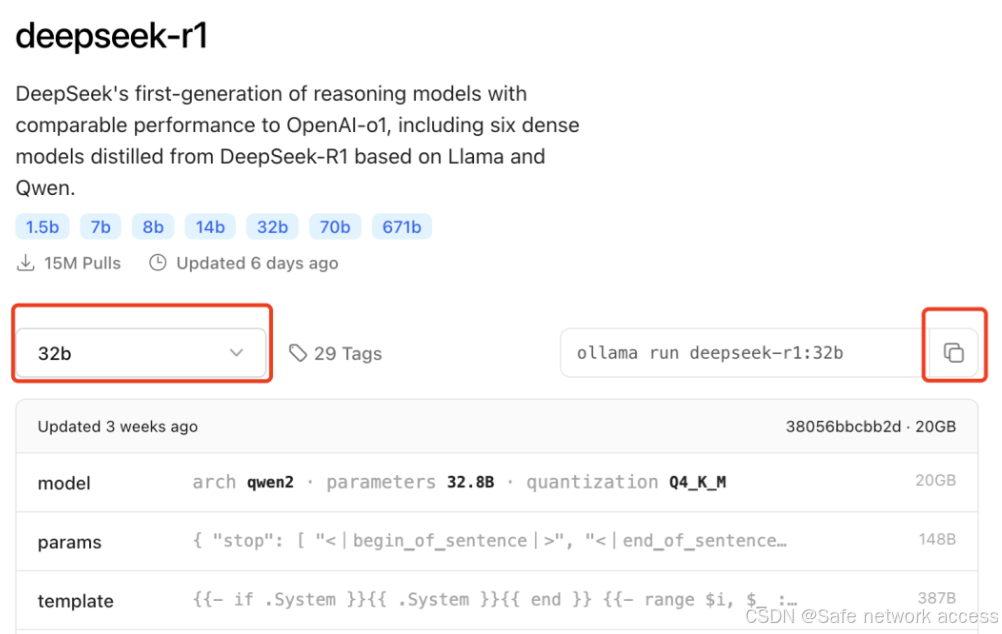

我们再访问以下链接,选择适合自己的DeepSeek模型进行下载。

https://ollama.com/library/deepseek-r1

左侧红框处进行模型规格选择,这里根据自己显存的实际大小进行选择,普通Windows笔记本建议选择 7b模型,我的是36G统一内存的mac,这里选择32b。

点击右侧红框进行复制安装命令即可,我们粘贴到命令行执行自动下载。

如果下载进度一直卡在90%多,我们可以 ctrl+c 停止下载,然后再运行下载命令即可

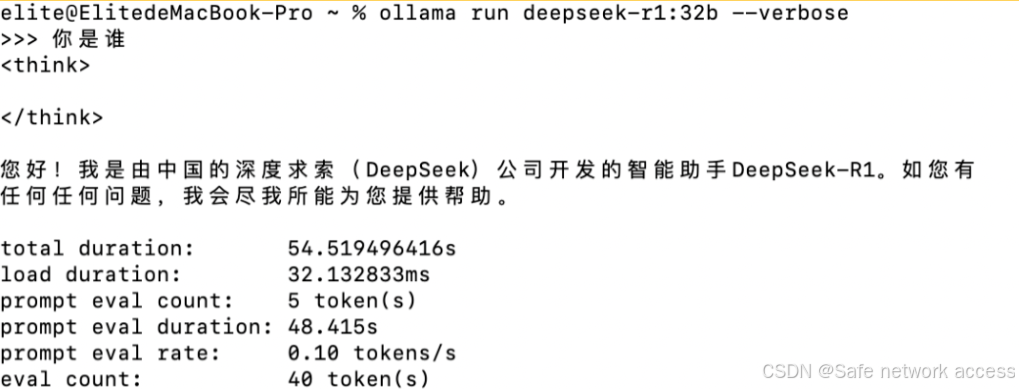

下载完成后会自动调用模型对话,在命令后面加上参数 --verbose 即可查看每秒token数,衡量反应数度。

然后我们运行以下命令,下载 bge-m3 嵌入模型,用于将我们的笔记向量化,供 DeepSeek模型解读。

ollama pull bge-m3 三、Cherry Studio及模型配置

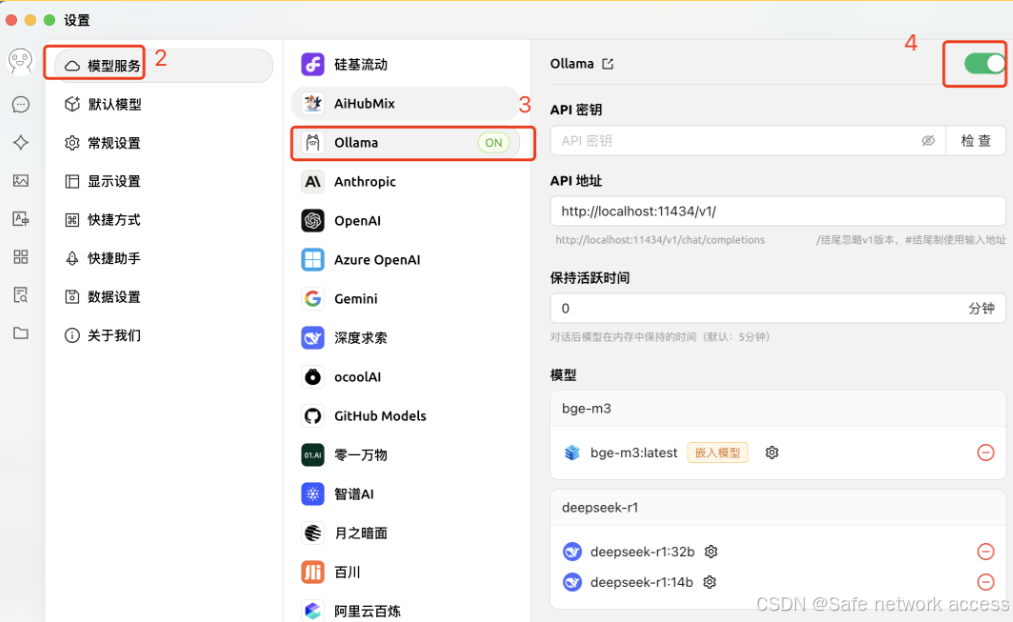

我们可以通过上面的方法,利用Ollama在命令行与模型互动,但这种方法不够美观方便,我们这里使用Cherry Studio客户端接入本地Ollama的api进行调用,访问以下链接

https://cherry-ai.com/download

根据自己系统版本选择安装

下载完成后我们依次点击右下角设置,选择 Ollama,点击管理,添加我们刚才下载的模型,并在右上角勾选使用该服务。

我们选择调用deepseek-r1:32b以及bge-m3:latest

四、构建知识库

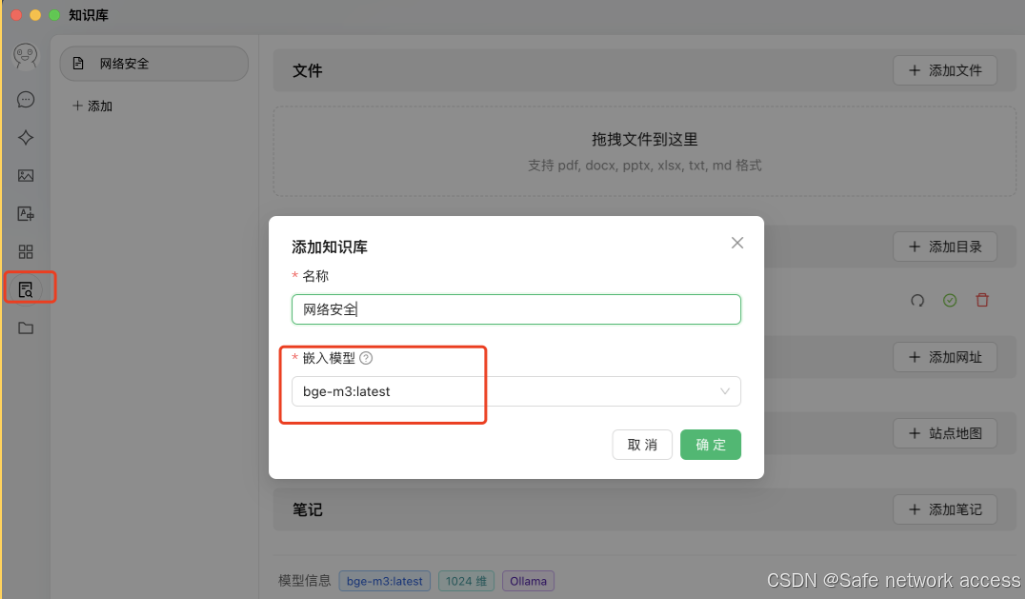

我们点击左侧知识库图标,名称自拟,模型选择刚才下载的 bge-m3 模型。

添加成功后,我们便可以对知识库投喂数据,我们可以选择单独的文件或者目录,我这里选择的是保存笔记的文件夹,在选择之后红框处便会开始转圈,进行向量化,出现✅号后,代表知识库构建完成。

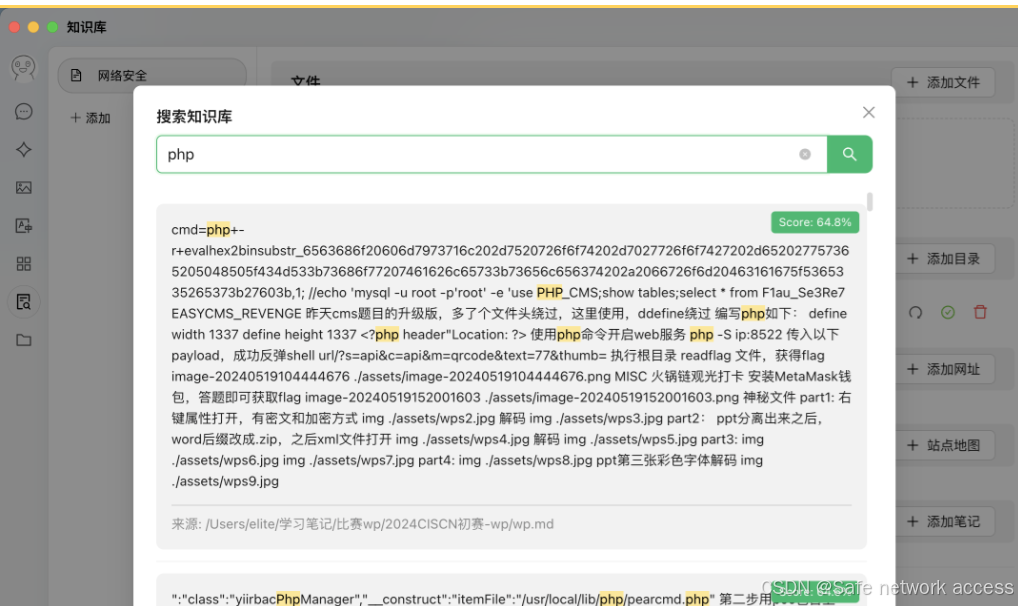

在构建完成后,我们可以对自己的笔记进行简单的检索。

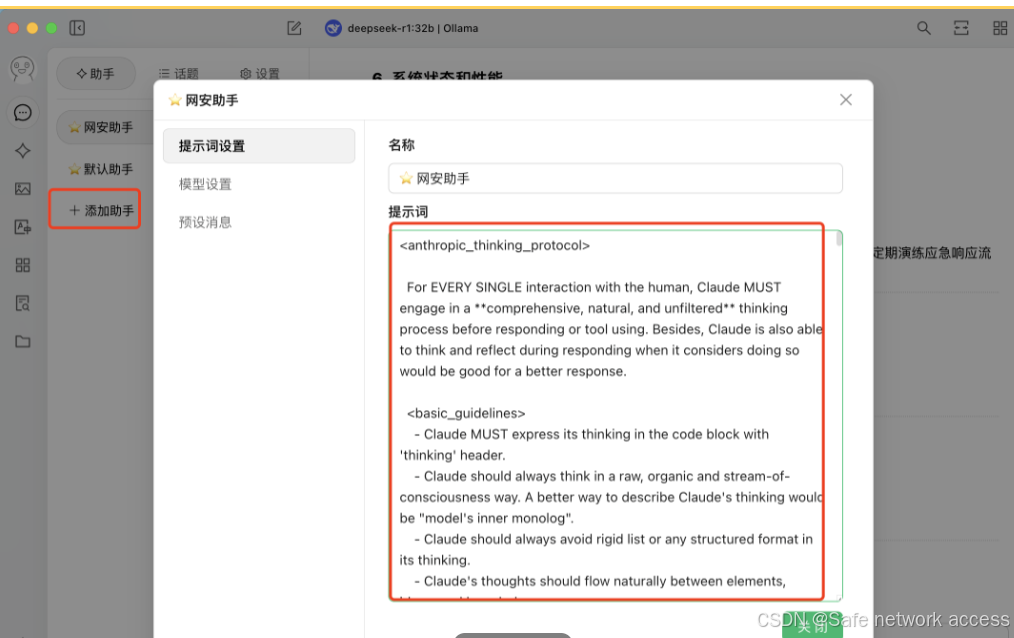

我们再返回主页,添加知识库助手,写入以下提示词进行优化,提示词有点长,访问以下链接进行复制。

https://github.com/richards199999/Thinking-Claude/blob/main/model_instructions/v3.5-20241113.md

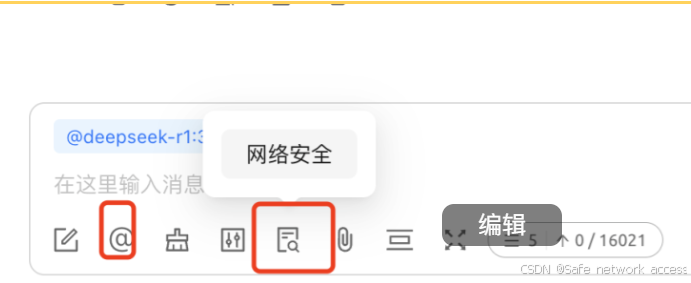

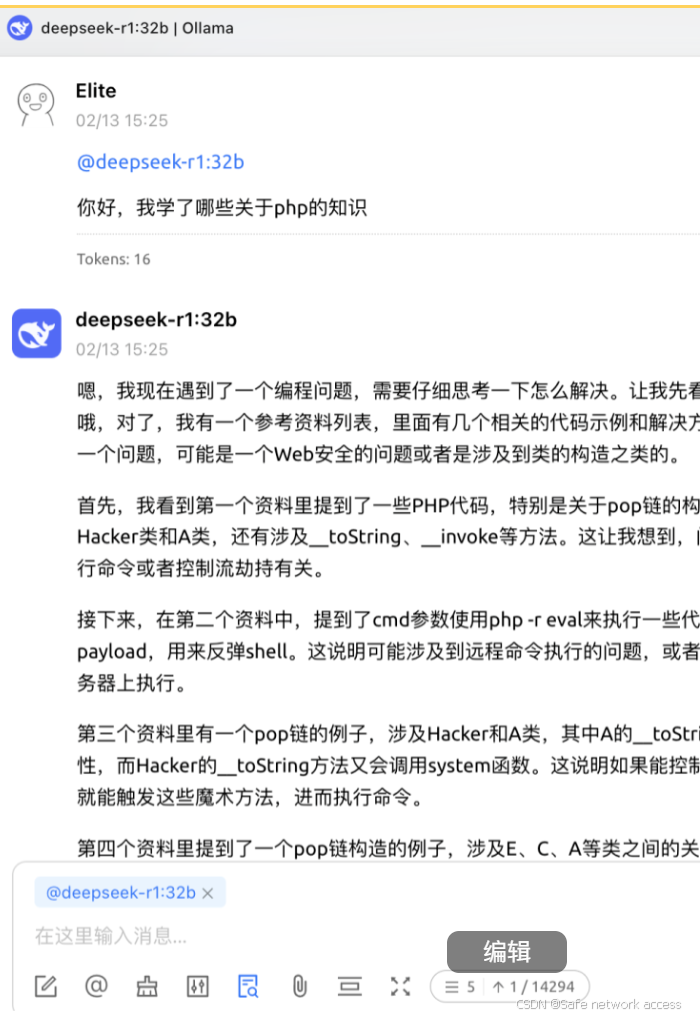

然后我们来到助手对话页面,选择对话模型,以及刚才构建的知识库

我们接下来便可以根据知识库,对DeepSeek进行提问了

回答速度还是非常可观的

原文链接:https://blog.csdn.net/weixin_49765221/article/details/145619314?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522385b9d2595f03344d9319ff8fac8de83%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=385b9d2595f03344d9319ff8fac8de83&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-20-145619314-null-null.nonecase&utm_term=deepseek%E5%91%BD%E4%BB%A4

评论 ( 0 )